深度学习入门笔记:第二章感知机

深度学习入门笔记:第二章感知机

笔记来源书籍:《深度学习入门:基于+Python+的理论与实现》

文章目录

- 深度学习入门笔记:第二章感知机

-

- 前言 为什么学习感知机

- 2.1 感知机是什么

- 2.2 简单逻辑电路

-

- 2.2.1与门

- 2.2.2与非门和或门

- 2.3感知机实现

-

- 2.3.1简单的实现

- 2.3.2导入权重和偏置

- 2.3.3使用权重和偏置的实现

- 2.4感知机的局限性

-

- 2.4.1异或门

- 2.4.2线性和非线性

- 2.5多层感知机

-

- 2.5.1已有门电路的组合

- 2.5.2异或门的实现

- 2.6 从与非门到计算机

前言 为什么学习感知机

感知机是作为神经网络(深度学习)的起源的算法。因此, 学习感知机的构造也就是学习通向神经网络和深度学习的一种重要思想。

感知机是由美国学者Frank Rosenblatt在1957年提出来的。

2.1 感知机是什么

感知机接收多个输入信号,输出一个信号。这里所说的“信号”可以想 象成电流或河流那样具备“流动性”的东西。像电流流过导线,向前方输送电子一样,感知机的信号也会形成流,向前方输送信息。但是,和实际的电流不同的是,感知机的信号只有**“流/不流”(1/0)**两种取值。

如下例子(有两个输入的感知机)

x1、x2是输入信号, y是输出信号,w1、w2是权重(w是weight的首字母)。图中的○称为“神 经元”或者“节点”。输入信号被送往神经元时,会被分别乘以固定的权重(w1x1、w2x2)。神经元会计算传送过来的信号的总和,只有当这个总和超过 了某个界限值时,才会输出1。这也称为“神经元被激活”。这里将这个界 限值称为阈值,用符号θ表示。

数学表达式如下

感知机的权重代表信号的重要性,感知机的权重值越大,通过 的信号就越大。

2.2 简单逻辑电路

2.2.1与门

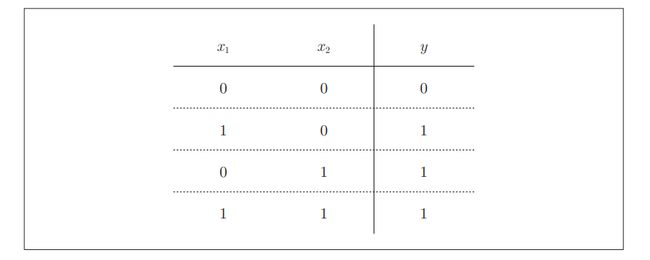

与门是有两个输入和一个输出的门电路。与门仅在两个输入均为1时输出1,其他时候则输出0。

下图为与门真值表

下面考虑用感知机来表示这个与门。需要做的就是确定能满足真值表的w1、w2、θ的值。

比如,当 (w1, w2, θ) = (0.5, 0.5, 0.7) 时,可以满足真值表的条件。输入0和1时,此时(w1x1、w2x2)的值为0.5,不超过阀值0.7,故感知机输出0.其它情况以此类推。设定这样的 参数后,仅当x1和x2同时为1时,信号的加权总和才会超过给定的阈值θ

2.2.2与非门和或门

与非门(NAND gate)。NAND是Not AND的意思,与非门就是颠倒了与门的输出,即仅当x1和x2同时为1时输出0,其他时候则输出1。用真值表表示如下

可以用(w1, w2, θ) = (−0.5, −0.5, −0.7)这样的组合表示与非门,可以看出就与门参数值取反。

或门是“只要有一个输入信号是1,输 出就为1”的逻辑电路。真值表如下

这里决定感知机参数的并不是计算机,而是我们人。我们看着真值 表这种“训练数据”,人工考虑(想到)了参数的值。而机器学习的课 题就是将这个决定参数值的工作交由计算机自动进行。学习是确定合适的参数的过程,而人要做的是思考感知机的构造(模型),并把 训练数据交给计算机

与门、与非门、或门的感知机构造是一样的。 实际上,3个门电路只有参数的值(权重和阈值)不同。即可以适当调整参数的值,就可以把感知机调成与门、与非门、或门。

2.3感知机实现

2.3.1简单的实现

使用Python实现简单实现逻辑电路

def AND(x1, x2):

w1, w2, theta = 0.5, 0.5, 0.7

tmp = x1*w1 + x2*w2

if tmp <= theta:

return 0

elif tmp > theta:

return 1

在函数内初始化参数w1、w2、theta,当输入的加权总和超过阈值时返回1, 否则返回0。即与门。

2.3.2导入权重和偏置

将θ换成−b,可以得到以下表达式

这个式子中b称为偏置,w1和w2称为权重。

下面使用NumPy实现感知机,

import numpy as np

x = np.array([0, 1]) # 输入

w = np.array([0.5, 0.5]) # 权重

b = -0.7 # 偏置

print(np.sum(w*x)+b)#输出-0.19999999999999996,大约为-0.2(由浮点小数造成的运算误差)

np.sum(w*x)为计算相乘后的各个元素的总和。

2.3.3使用权重和偏置的实现

使用权重和偏置,可以如下实现与门

def AND(x1, x2):

x = np.array([x1, x2])

w = np.array([0.5, 0.5])

b = -0.7

tmp = np.sum(w*x) + b

if tmp <= 0:

return 0

else:

return 1

偏置与权重的重要性不同,w1和w2是控制输入信号的重要性的参数,而偏置是调整神经元被激活的容易程度(输出信号为1的程度)的参数。

有时根据上下文,也会将b、w1、w2这些参数统称为权重。

与非门和或门实现同理,只是权重和偏置不同,且与非门权重与与门相反。

与非门

def NAND(x1, x2):

x = np.array([x1, x2])

w = np.array([-0.5, -0.5]) # 仅权重和偏置与AND不同!

b = 0.7

tmp = np.sum(w*x) + b

if tmp <= 0:

return 0

else:

return 1

或门

def OR(x1, x2):

x = np.array([x1, x2])

w = np.array([0.5, 0.5]) # 仅权重和偏置与AND不同!

b = -0.2

tmp = np.sum(w * x) + b

if tmp <= 0:

return 0

else:

return 1

2.4感知机的局限性

2.4.1异或门

异或门也被称为逻辑异或电路。仅当x1或x2中的一方为 1时,才会输出1(“异或”是拒绝其他的意思)。真值表如下

感知机是无法实现异或门的,原因如下

首先,我们试着将或门的动作形象化。或门的情况下,当权重参数 (b, w1, w2) = (−0.5, 1.0, 1.0)时,可满足或门条件,此时感知机满足的数学式为

此表达式表示的感知机会生成由直线−0.5 + x1 + x2 = 0分割开的两个空 间。其中一个空间输出1,另一个空间输出0,如图所示。

如果想制作或门,需要用直线将图中的○和△分开。(即0和1分开)

但是对于异或门来说,它的情况如图

是无法用一条直线将图中的○和△分开的,所以无法使用感知机实现。

2.4.2线性和非线性

上图中的○和△无法用一条直线分开,但是如果将“直线”这个限制条 件去掉,就可以实现了。我们可以使用如图曲线分开○和△。

感知机的局限性就在于它只能表示由一条直线分割的空间。上图图这样弯曲的曲线无法用感知机表示。另外,由上图这样的曲线分割而成的空间称为 非线性空间,由直线分割而成的空间称为线性空间。

2.5多层感知机

2.5.1已有门电路的组合

这里,与门、与非门、或门用图中的符号表示。另外, 图中与非门前端的○表示反转输出的意思。

而异或门的实现可以用与门、与非门、或门代替下图中的各个 “?”,就可以实现异或门。

2.4节讲到的感知机的局限性,严格地讲,应该是“单层感知机无法 表示异或门”或者“单层感知机无法分离非线性空间”。接下来,我们将看到通过组合感知机(叠加层)就可以实现异或门。

异或门可以通过下图所示的配置来实现。这里,x1和x2表示输入信号, y表示输出信号。x1和x2是与非门和或门的输入,而与非门和或门的输出则 是与门的输入。

异或门真值表可以改变为

2.5.2异或门的实现

下面使用python实现异或门,使用之前定义的 AND函数、NAND函数、OR函数,可以像下面这样(轻松地)实现。

def XOR(x1, x2):

s1 = NAND(x1, x2)

s2 = OR(x1, x2)

y = AND(s1, s2)

return y

输出为

XOR(0, 0) # 输出0

XOR(1, 0) # 输出1

XOR(0, 1) # 输出1

XOR(1, 1) # 输出0

下面用感知机表示方法表示异或门

如图所示,异或门是一种多层结构的神经网络。这里,将最左边的 一列称为第0层,中间的一列称为第1层,最右边的一列称为第2层。

如图所示的感知机与前面介绍的与门、或门的感知机形状不同。实际上,与门、或门是单层感知机,而异或门是2层感知机。叠加了多 层的感知机也称为多层感知机(multi-layered perceptron)

图中的感知机总共由 3层构成,但是因为拥有权重的层实质 上只有 2层(第 0层和第 1层之间,第 1层和第 2层之间),所以称 为“2层感知机”。但是存在有的文献称为3层感知机。

在两层感知机中,先在第0层和第1层的神经元之间进行 信号的传送和接收,然后在第1层和第2层之间进行信号的传送和接收。

- 第0层的两个神经元接收输入信号,并将信号发送至第1层的神经元。

- 第1层的神经元将信号发送至第2层的神经元,第2层的神经元输出y。

通过这样的结构(2层结构),感知机得以实现异或门。这可以解释为“单层感知机 无法表示的东西,通过增加一层就可以解决”。通过叠加层(加深层),感知机能进行更加灵活的表示。

结论: 单层感知机只能表示线性空间,而多层感知机可以表示非线性空间。

2.6 从与非门到计算机

计算机是处理信息的机器。向计算机中输入一些信息后,它会按照某种 既定的方法进行处理,然后输出结果。所谓“按照某种既定的方法进行处理” 是指,计算机和感知机一样,也有输入和输出,会按照某个既定的规则进行 计算。

一般会认为计算机内部进行的处理非常复杂,实际上只需要通过与非门的组合,就能再现计算机进行的处理。说明使用感知机也可以表示计算机。

前面也介绍了, 与非门可以使用感知机实现。也就是说,如果通过组合与非门可以实现计算机的话,那么通过组合感知机也可以表示计算机(感知机的组合可以通过叠 加了多层的单层感知机来表示)。

综上,多层感知机能够进行复杂的表示,甚至可以构建计算机。

感知机通过叠加层能够进行非线性的表示,理论上还可以表示计算机进行的处理。

一般会认为计算机内部进行的处理非常复杂,实际上只需要通过与非门的组合,就能再现计算机进行的处理。说明使用感知机也可以表示计算机。

前面也介绍了, 与非门可以使用感知机实现。也就是说,如果通过组合与非门可以实现计算机的话,那么通过组合感知机也可以表示计算机(感知机的组合可以通过叠 加了多层的单层感知机来表示)。

综上,多层感知机能够进行复杂的表示,甚至可以构建计算机。

感知机通过叠加层能够进行非线性的表示,理论上还可以表示计算机进行的处理。