import numpy as np

import pandas as pd

import warnings

warnings.filterwarnings("ignore")

from os import path

d = path.dirname(r"D:\2018_BigData\Python\Python_book\19Case\19_1Bankcredit")

accounts=pd.read_csv("D:/2018_BigData/Python/Python_book/19Case/19_1Bankcredit/accounts.csv",encoding="ANSI")

accounts.head(3)

|

account_id |

district_id |

frequency |

date |

| 0 |

576 |

55 |

月结 |

1993-01-01 |

| 1 |

3818 |

74 |

月结 |

1993-01-01 |

| 2 |

704 |

55 |

月结 |

1993-01-01 |

clients=pd.read_csv("D:/2018_BigData/Python/Python_book/19Case/19_1Bankcredit/clients.csv",encoding="ANSI")

clients.head(3)

|

client_id |

sex |

birth_date |

district_id |

| 0 |

1 |

女 |

1970-12-13 |

18 |

| 1 |

2 |

男 |

1945-02-04 |

1 |

| 2 |

3 |

女 |

1940-10-09 |

1 |

disp=pd.read_csv("D:/2018_BigData/Python/Python_book/19Case/19_1Bankcredit/disp.csv",encoding="ANSI")

disp.head(3)

|

disp_id |

client_id |

account_id |

type |

| 0 |

1 |

1 |

1 |

所有者 |

| 1 |

2 |

2 |

2 |

所有者 |

| 2 |

3 |

3 |

2 |

用户 |

order=pd.read_csv("D:/2018_BigData/Python/Python_book/19Case/19_1Bankcredit/order.csv",encoding="ANSI")

order.head(3)

|

order_id |

account_id |

bank_to |

account_to |

amount |

k_symbol |

| 0 |

29405 |

3 |

CD |

24485939 |

327.0 |

NaN |

| 1 |

29413 |

8 |

IJ |

93210345 |

6712.0 |

NaN |

| 2 |

29430 |

24 |

QR |

46086388 |

7641.0 |

NaN |

trans=pd.read_csv("D:/2018_BigData/Python/Python_book/19Case/19_1Bankcredit/trans.csv",encoding="ANSI")

trans.head(3)

|

trans_id |

account_id |

date |

type |

operation |

amount |

balance |

k_symbol |

bank |

account |

| 0 |

695247 |

2378 |

1993-01-01 |

贷 |

信贷资金 |

$700 |

$700 |

NaN |

NaN |

NaN |

| 1 |

171812 |

576 |

1993-01-01 |

贷 |

信贷资金 |

$900 |

$900 |

NaN |

NaN |

NaN |

| 2 |

207264 |

704 |

1993-01-01 |

贷 |

信贷资金 |

$1,000 |

$1,000 |

NaN |

NaN |

NaN |

loans=pd.read_csv("D:/2018_BigData/Python/Python_book/19Case/19_1Bankcredit/loans.csv",encoding="ANSI")

loans.head(3)

|

loan_id |

account_id |

date |

amount |

duration |

payments |

status |

| 0 |

5314 |

1787 |

1993-07-05 |

96396 |

12 |

8033 |

B |

| 1 |

5316 |

1801 |

1993-07-11 |

165960 |

36 |

4610 |

A |

| 2 |

6863 |

9188 |

1993-07-28 |

127080 |

60 |

2118 |

A |

card=pd.read_csv("D:/2018_BigData/Python/Python_book/19Case/19_1Bankcredit/card.csv",encoding="ANSI")

card.head(3)

|

card_id |

disp_id |

issued |

type |

| 0 |

1005 |

9285 |

1993-11-07 |

普通卡 |

| 1 |

104 |

588 |

1994-01-19 |

普通卡 |

| 2 |

747 |

4915 |

1994-02-05 |

普通卡 |

district=pd.read_csv("D:/2018_BigData/Python/Python_book/19Case/19_1Bankcredit/district.csv",encoding="ANSI")

district.head(3)

|

A1 |

GDP |

A4 |

A10 |

A11 |

A12 |

A13 |

A14 |

A15 |

a16 |

| 0 |

1 |

283894 |

1204953 |

100.0 |

12541 |

0.29 |

0.43 |

167 |

35.6 |

41.1 |

| 1 |

2 |

11655 |

88884 |

46.7 |

8507 |

1.67 |

1.85 |

132 |

12.1 |

15.0 |

| 2 |

3 |

13146 |

75232 |

41.7 |

8980 |

1.95 |

2.21 |

111 |

18.8 |

18.7 |

import pandas as pd

import numpy as np

import os

os.chdir("D:/2018_BigData/Python/Python_book/19Case/19_1Bankcredit")

os.getcwd()

'D:\\2018_BigData\\Python\\Python_book\\19Case\\19_1Bankcredit'

loanfile=os.listdir()

createVar=locals()

for i in loanfile:

if i.endswith("csv"):

createVar[i.split(".")[0]] = pd.read_csv(i,encoding="gbk")

print(i.split(".")[0])

accounts

card

clients

disp

district

loans

order

trans

bad_good = {"B":1,"D":1,"A":0,"C":2}

loans["bad_good"] = loans.status.map(bad_good)

loans.head()

|

loan_id |

account_id |

date |

amount |

duration |

payments |

status |

bad_good |

| 0 |

5314 |

1787 |

1993-07-05 |

96396 |

12 |

8033 |

B |

1 |

| 1 |

5316 |

1801 |

1993-07-11 |

165960 |

36 |

4610 |

A |

0 |

| 2 |

6863 |

9188 |

1993-07-28 |

127080 |

60 |

2118 |

A |

0 |

| 3 |

5325 |

1843 |

1993-08-03 |

105804 |

36 |

2939 |

A |

0 |

| 4 |

7240 |

11013 |

1993-09-06 |

274740 |

60 |

4579 |

A |

0 |

print(disp.columns)

print(clients.columns)

print(loans.columns)

Index(['disp_id', 'client_id', 'account_id', 'type'], dtype='object')

Index(['client_id', 'sex', 'birth_date', 'district_id'], dtype='object')

Index(['loan_id', 'account_id', 'date', 'amount', 'duration', 'payments',

'status', 'bad_good'],

dtype='object')

data2 = pd.merge(loans,disp,on="account_id",how="left")

data2 = pd.merge(data2,clients,on="client_id",how="left")

data2.head()

|

loan_id |

account_id |

date |

amount |

duration |

payments |

status |

bad_good |

disp_id |

client_id |

type |

sex |

birth_date |

district_id |

| 0 |

5314 |

1787 |

1993-07-05 |

96396 |

12 |

8033 |

B |

1 |

2166 |

2166 |

所有者 |

女 |

1947-07-22 |

30 |

| 1 |

5316 |

1801 |

1993-07-11 |

165960 |

36 |

4610 |

A |

0 |

2181 |

2181 |

所有者 |

男 |

1968-07-22 |

46 |

| 2 |

6863 |

9188 |

1993-07-28 |

127080 |

60 |

2118 |

A |

0 |

11006 |

11314 |

所有者 |

男 |

1936-06-02 |

45 |

| 3 |

5325 |

1843 |

1993-08-03 |

105804 |

36 |

2939 |

A |

0 |

2235 |

2235 |

所有者 |

女 |

1940-04-20 |

14 |

| 4 |

7240 |

11013 |

1993-09-06 |

274740 |

60 |

4579 |

A |

0 |

13231 |

13539 |

所有者 |

男 |

1978-09-07 |

63 |

print(district.columns)

Index(['A1', 'GDP', 'A4', 'A10', 'A11', 'A12', 'A13', 'A14', 'A15', 'a16'], dtype='object')

data3 = pd.merge(data2,district,left_on="district_id",right_on="A1",how="left")

data3.head(2)

|

loan_id |

account_id |

date |

amount |

duration |

payments |

status |

bad_good |

disp_id |

client_id |

... |

A1 |

GDP |

A4 |

A10 |

A11 |

A12 |

A13 |

A14 |

A15 |

a16 |

| 0 |

5314 |

1787 |

1993-07-05 |

96396 |

12 |

8033 |

B |

1 |

2166 |

2166 |

... |

30 |

16979 |

94812 |

81.8 |

9650 |

3.38 |

3.67 |

100 |

15.7 |

14.8 |

| 1 |

5316 |

1801 |

1993-07-11 |

165960 |

36 |

4610 |

A |

0 |

2181 |

2181 |

... |

46 |

14111 |

112709 |

73.5 |

8369 |

1.79 |

2.31 |

117 |

12.7 |

11.6 |

2 rows × 24 columns

print(trans.columns)

Index(['trans_id', 'account_id', 'date', 'type', 'operation', 'amount',

'balance', 'k_symbol', 'bank', 'account'],

dtype='object')

data_4temp1 = pd.merge(loans[["account_id","date"]],

trans[["account_id","type","amount","balance","date"]],

on = "account_id")

data_4temp1.columns = ["account_id","date","type","amount","balance","t_date"]

data_4temp1 = data_4temp1.sort_values(by=["account_id","t_date"])

data_4temp1.head(3)

|

account_id |

date |

type |

amount |

balance |

t_date |

| 10020 |

2 |

1994-01-05 |

贷 |

$1,100 |

$1,100 |

1993-02-26 |

| 10021 |

2 |

1994-01-05 |

贷 |

$20236 |

$21336 |

1993-03-12 |

| 10022 |

2 |

1994-01-05 |

贷 |

$3,700 |

$25036 |

1993-03-28 |

data_4temp1["date"] = pd.to_datetime(data_4temp1["date"])

data_4temp1["t_date"] = pd.to_datetime(data_4temp1["t_date"])

data_4temp1["balance2"]=data_4temp1["balance"].map(lambda x: int("".join(x[1:].split(","))))

data_4temp1["amount2"]=data_4temp1["amount"].map(lambda x: int("".join(x[1:].split(","))))

data_4temp1.head(3)

|

account_id |

date |

type |

amount |

balance |

t_date |

balance2 |

amount2 |

| 10020 |

2 |

1994-01-05 |

贷 |

$1,100 |

$1,100 |

1993-02-26 |

1100 |

1100 |

| 10021 |

2 |

1994-01-05 |

贷 |

$20236 |

$21336 |

1993-03-12 |

21336 |

20236 |

| 10022 |

2 |

1994-01-05 |

贷 |

$3,700 |

$25036 |

1993-03-28 |

25036 |

3700 |

import datetime

|

account_id |

date |

type |

amount |

balance |

t_date |

balance2 |

amount2 |

| 10020 |

2 |

1994-01-05 |

贷 |

$1,100 |

$1,100 |

1993-02-26 |

1100 |

1100 |

| 10021 |

2 |

1994-01-05 |

贷 |

$20236 |

$21336 |

1993-03-12 |

21336 |

20236 |

| 10022 |

2 |

1994-01-05 |

贷 |

$3,700 |

$25036 |

1993-03-28 |

25036 |

3700 |

| 10023 |

2 |

1994-01-05 |

贷 |

$14 |

$25050 |

1993-03-31 |

25050 |

14 |

| 10024 |

2 |

1994-01-05 |

贷 |

$20236 |

$45286 |

1993-04-12 |

45286 |

20236 |

data_4temp3 = data_4temp2.groupby("account_id")["balance2"].agg([("avg_balance","mean"),("stdev_balance","std")])

data_4temp3["cv_balance"] = data_4temp3[["avg_balance","stdev_balance"]].apply(lambda x: x[1]/x[0],axis=1)

data_4temp3.head(3)

|

avg_balance |

stdev_balance |

cv_balance |

| account_id |

|

|

|

| 2 |

32590.759259 |

12061.802206 |

0.370099 |

| 19 |

25871.223684 |

15057.521648 |

0.582018 |

| 25 |

56916.984496 |

21058.667949 |

0.369989 |

type_dict = {"借":"out","贷":"income"}

data_4temp2["type1"]=data_4temp2.type.map(type_dict)

data_4temp4=data_4temp2.groupby(["account_id","type1"])[["amount2"]].sum()

data_4temp4.head(3)

|

|

amount2 |

| account_id |

type1 |

|

| 2 |

income |

276514 |

| out |

153020 |

| 19 |

income |

254255 |

data_4temp4=data_4temp4.reset_index()

data_4temp4.head(3)

|

account_id |

type1 |

amount2 |

| 0 |

2 |

income |

276514 |

| 1 |

2 |

out |

153020 |

| 2 |

19 |

income |

254255 |

data_4temp5 = pd.pivot_table(data_4temp4, values = "amount2", index = "account_id", columns = "type1")

data_4temp5.fillna(0,inplace = True)

data_4temp5["r_out_in"] = data_temp5[["out","income"]].apply(lambda x: x[0]/x[1],axis=1)

data_4temp5.head(3)

| type1 |

income |

out |

r_out_in |

| account_id |

|

|

|

| 2 |

276514.0 |

153020.0 |

0.553390 |

| 19 |

254255.0 |

198020.0 |

0.778824 |

| 25 |

726479.0 |

629108.0 |

0.865969 |

data4 = pd.merge(data3,data_4temp3,left_on="account_id",right_index=True,how="left")

data4 = pd.merge(data4,data_4temp5,left_on="account_id",right_index=True,how="left")

data4.head(3)

|

loan_id |

account_id |

date |

amount |

duration |

payments |

status |

bad_good |

disp_id |

client_id |

... |

A13 |

A14 |

A15 |

a16 |

avg_balance |

stdev_balance |

cv_balance |

income |

out |

r_out_in |

| 0 |

5314 |

1787 |

1993-07-05 |

96396 |

12 |

8033 |

B |

1 |

2166 |

2166 |

... |

3.67 |

100 |

15.7 |

14.8 |

12250.000000 |

8330.866301 |

0.680071 |

20100.0 |

0.0 |

0.000000 |

| 1 |

5316 |

1801 |

1993-07-11 |

165960 |

36 |

4610 |

A |

0 |

2181 |

2181 |

... |

2.31 |

117 |

12.7 |

11.6 |

43975.810811 |

25468.748605 |

0.579154 |

243576.0 |

164004.0 |

0.673318 |

| 2 |

6863 |

9188 |

1993-07-28 |

127080 |

60 |

2118 |

A |

0 |

11006 |

11314 |

... |

2.89 |

132 |

13.3 |

13.6 |

30061.041667 |

11520.127013 |

0.383224 |

75146.0 |

54873.0 |

0.730219 |

3 rows × 30 columns

data4["r_lb"] = data4[["amount","avg_balance"]].apply(lambda x: x[0]/x[1],axis=1)

data4["r_lincome"] = data4[["amount","income"]].apply(lambda x: x[0]/x[1],axis=1)

data_model = data4[data4.status != "C"]

for_predict = data4[data4.status == "C"]

train = data_model.sample(frac=0.7,random_state=1235).copy()

test = data_model[~data_model.index.isin(train.index)].copy()

print("训练集样本量:%i\n 测试集样本量:%i"%(len(train),len(test)))

训练集样本量:234

测试集样本量:100

import statsmodels.api as sm

import statsmodels.formula.api as smf

def forward_select(data, response):

import statsmodels.api as sm

import statsmodels.formula.api as smf

remaining = set(data.columns)

remaining.remove(response)

selected = []

current_score, best_new_score = float('inf'), float('inf')

while remaining:

aic_with_candidates=[]

for candidate in remaining:

formula = "{} ~ {}".format(

response,' + '.join(selected + [candidate]))

aic = smf.glm(

formula=formula, data=data,

family=sm.families.Binomial(sm.families.links.logit)

).fit().aic

aic_with_candidates.append((aic, candidate))

aic_with_candidates.sort(reverse=True)

best_new_score, best_candidate=aic_with_candidates.pop()

if current_score > best_new_score:

remaining.remove(best_candidate)

selected.append(best_candidate)

current_score = best_new_score

print ('aic is {},continuing!'.format(current_score))

else:

print ('forward selection over!')

break

formula = "{} ~ {} ".format(response,' + '.join(selected))

print('final formula is {}'.format(formula))

model = smf.glm(

formula=formula, data=data,

family=sm.families.Binomial(sm.families.links.logit)

).fit()

return(model)

data4.columns

Index(['loan_id', 'account_id', 'date', 'amount', 'duration', 'payments',

'status', 'bad_good', 'disp_id', 'client_id', 'type', 'sex',

'birth_date', 'district_id', 'A1', 'GDP', 'A4', 'A10', 'A11', 'A12',

'A13', 'A14', 'A15', 'a16', 'avg_balance', 'stdev_balance',

'cv_balance', 'income', 'out', 'r_out_in', 'r_lb', 'r_lincome'],

dtype='object')

candidates = ["bad_good",'A1', 'GDP', 'A4', 'A10', 'A11', 'A12','amount', 'duration','A13', 'A14', 'A15', 'a16', 'avg_balance', 'stdev_balance',

'cv_balance', 'income', 'out', 'r_out_in', 'r_lb', 'r_lincome']

data_for_select = train[candidates]

lg_ml = forward_select(data=data_for_select,response="bad_good")

lg_ml.summary().tables[1]

aic is 177.8135076281174,continuing!

forward selection over!

final formula is bad_good ~ r_lb

|

coef |

std err |

z |

P>|z| |

[0.025 |

0.975] |

| Intercept |

-3.3598 |

0.390 |

-8.614 |

0.000 |

-4.124 |

-2.595 |

| r_lb |

0.5791 |

0.088 |

6.559 |

0.000 |

0.406 |

0.752 |

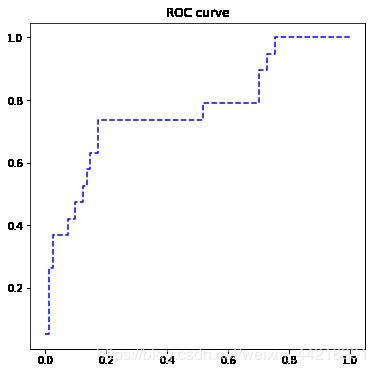

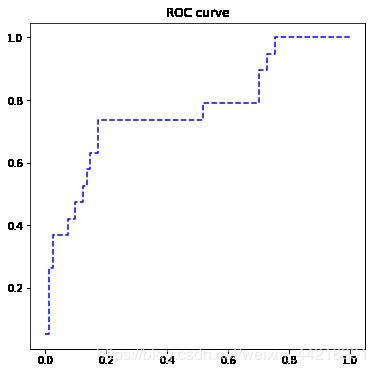

import sklearn.metrics as metrics

import matplotlib.pyplot as plt

fpr, tpr, th = metrics.roc_curve(test.bad_good, lg_ml.predict(test))

plt.figure(figsize=[6,6])

plt.plot(fpr, tpr, "b--")

plt.title("ROC curve")

plt.show()

print('AUC = %.4f' %metrics.auc(fpr, tpr))

AUC = 0.7667

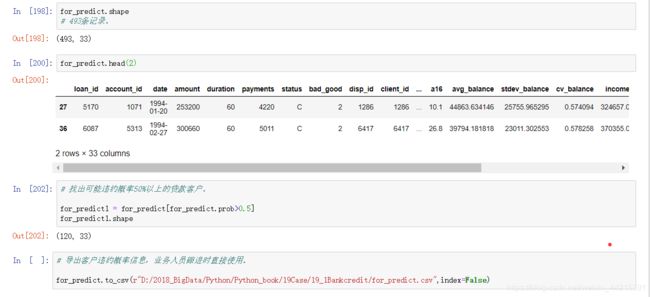

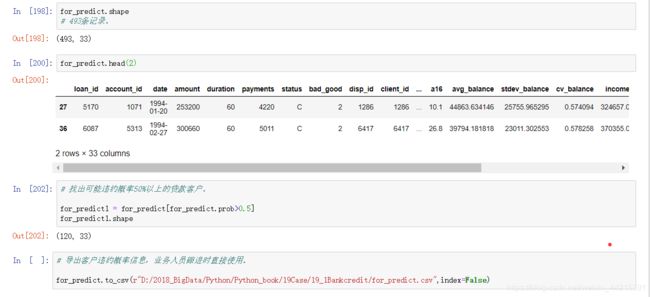

for_predict["prob"] = lg_ml.predict(for_predict)

for_predict[["account_id","prob"]].head()

|

account_id |

prob |

| 27 |

1071 |

0.477101 |

| 36 |

5313 |

0.734056 |

| 47 |

10079 |

0.157970 |

| 48 |

10079 |

0.157970 |

| 49 |

5385 |

0.404954 |

建模分析尾声,直接截图。