ICRA2023 | 通用、自动和无标定目标的Lidar-Camera外参标定工具箱

原文链接:https://arxiv.org/pdf/2302.05094.pdf

本文介绍了一种开源的激光雷达相机标定工具箱,该工具箱适用于激光雷达和相机投影模型,只需要一对激光雷达和相机数据,而无需标定目标,并且是全自动的。对于自动初始猜测估计,本文使用SuperGlue图像匹配pipeline来查找LiDAR和相机数据之间的2D-3D对应关系,并通过RANSAC估计LiDAR相机变换。给定初始猜测,论文基于归一化信息距离(一种基于互信息的跨模态距离度量),使用直接激光雷达相机配准来细化变换估计。为了方便标定过程,论文还提供了几种辅助功能(例如,动态激光雷达数据集成和用于手动进行2D-3D对应的用户界面)。实验结果表明,所提出的工具箱能够对旋转和非重复扫描激光雷达以及针孔和全向相机的任何组合进行标定,并且显示出比最先进的基于边缘对准的标定方法更好的精度和鲁棒性。

领域背景

激光雷达相机外部标定是估计激光雷达和相机坐标系之间的转换任务,它是LiDAR相机传感器融合的必要条件,在许多应用中都需要,包括自动驾驶汽车定位、环境测绘和周围物体识别。尽管在过去十年中,激光雷达相机标定已经得到了积极的研究,但机器人界仍然缺乏一个方便和完整的激光雷达相机标定工具箱。现有的激光雷达相机标定框架需要准备一个有时很难创建的标定目标,拍摄大量激光雷达相机数据,这需要花费大量的精力,或者仔细选择一个几何丰富的环境。此外,它们很少支持各种激光雷达和相机投影模型,例如旋转和非重复扫描激光雷达以及超宽FoV和全向相机。论文认为,缺乏易于使用的激光雷达相机标定方法一直是激光雷达相机传感器融合系统发展的长期障碍!

在此本文介绍了一个全新的完整LiDAR相机标定工具箱,该工具箱具有以下功能:

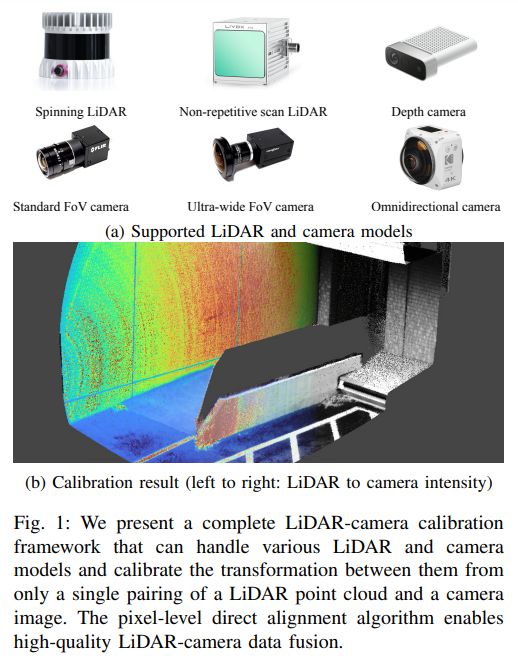

可推广:所提出的工具箱与传感器模型无关,可以处理各种激光雷达和相机投影投影模型,包括旋转和非反射扫描激光雷达以及针孔、鱼眼和全向投影相机,如图1(a)所示。

无目标:建议的标定算法不需要标定目标,而是使用环境结构和纹理进行标定。

single-shot:标定时,至少只需要一对激光雷达点云和相机图像。可选地,可以使用多个LiDAR相机数据对来进一步提高标定精度。

自动:为了使标定过程完全自动化,该系统包括基于SuperGlue的具有跨模态2D-3D对应匹配的初始猜测估计算法。

准确可靠:采用像素级直接激光雷达相机配准算法,在没有丰富几何特征的环境中稳健且准确地执行激光雷达相机标定,只要激光雷达和相机数据之间存在相互信息,现有的基于边缘对准的算法就会失败。

据本文所知,目前还没有具备上述所有功能的开放实现,该工具箱的发布将对机器人社区有益。本文的主要贡献如下:

-

提出了一种基于2D-3D对应估计的鲁棒初始猜测估计算法。为了利用最近的基于图形神经网络的图像匹配,使用虚拟相机生成LiDAR强度图像,并找到LiDAR亮度图像和相机图像之间的对应关系。然后通过RANSAC和重投影误差最小化给出了激光雷达相机变换的估计。

-

为了实现稳健和准确的标定,结合了基于归一化信息距离(NID)的直接激光雷达相机精配准算法、基于互信息(MI)的跨模态距离度量和基于视图的隐藏点去除算法,该算法过滤掉被遮挡的点,并且从相机的角度看不应该是可见的。

-

整个系统经过精心设计,适用于激光雷达和相机投影模型,因此可应用于各种传感器模型。

现有方法

激光雷达相机外部标定方法分为三种:基于目标的、基于运动的、基于场景的!

A. 基于目标的标定

与相机内部标定过程一样,基于目标的方法是LiDAR相机外部标定的最自然的方法。一旦获得了标定目标上的点的三维坐标,可以通过解决pnp问题,估计LiDAR相机变换。这里的主要挑战是,通常很难设计和创建一个标定目标,该目标可以被LiDAR和相机稳健且准确地检测到。几项研究使用了一种3D结构化标定目标,它不像棋盘图案那样容易创建[5],[6]。尽管其他几项工作使用了易于创建的平面图案,但它们需要对LiDAR数据进行手动标注和多次数据采集,这导致了大量工作。

B.基于运动的标定

与手眼标定问题一样,可以根据刚体上的两个帧的运动来估计它们之间的变换。这种方法可以轻松处理异构传感器,并且不需要传感器之间的重叠。然而,它需要准确的时间同步,但当使用价格一般的摄像头时,并不一定可行。此外,还需要尽可能准确地估计每个传感器的运动,以获得更好的标定结果。

C.基于场景的标定

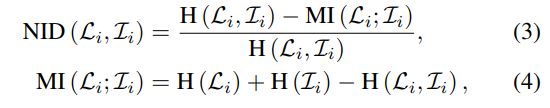

基于场景的方法通过考虑LiDAR点云对和相机图像之间的一致性来估计LiDAR相机变换。LiDAR点被投影到图像空间中,然后基于一些度量用像素值测量它们的一致性。与视觉里程估计问题类似,LiDAR相机数据一致性评估有两种主要方法:间接和直接。间接方法首先从相机和LiDAR数据中提取特征点(例如,边缘点),并计算2D-3D对应点之间的重投影误差[3],[11],[12]。尽管由于具有区分性特征和稳健的对应关系创建,它表现出良好的收敛性,但它要求环境具有丰富的几何结构以提取足够的特征点。由于该方法丢弃了环境中曲面的大部分纹理信息,因此与直接方法相比,该方法的精度较低。后一种方法直接比较像素和点强度。因为激光雷达和相机通常表现出非常不同的强度分布,所以简单地计算它们之间的差异在实践中是行不通的。为了克服模态的差异,基于MI的度量已用于激光雷达相机数据比较[13],[14]。因为它们不使用激光雷达和图像强度之间的差异,而是考虑它们的共现性,所以它们可以稳健地测量激光雷达和相机强度值之间的一致性。在[15],[16]之后,我们使用了从MI导出的NID度量,使得它满足度量空间公理,并且变得比MI更稳健[15]。

论文提出的方法

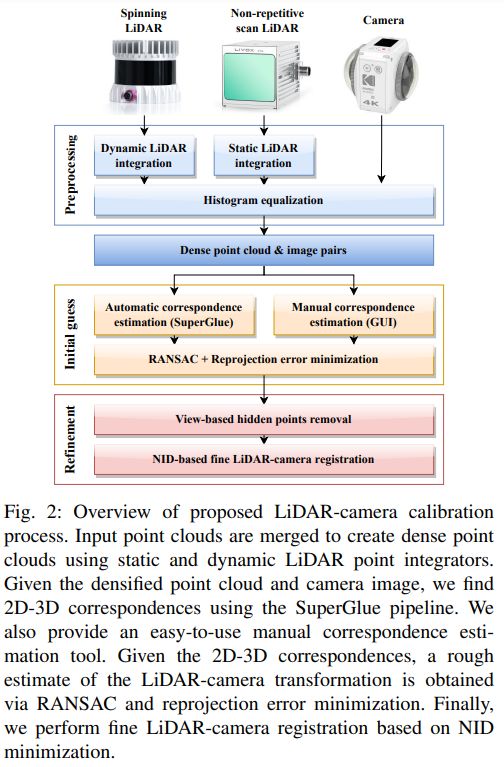

图2显示了拟议的激光雷达相机标定工具箱的概述。为了使用统一的处理pipeline处理各种LiDAR模型,首先通过合并多个LiDAR帧来创建密集点云。对于非重复扫描激光雷达(例如Livox Avia),只需累积点来加密点云。对于自旋激光雷达(例如Velodyne和Ouster激光雷达),使用基于连续时间ICP的动态激光雷达点积分技术。从成对的加密点云和相机图像中,然后基于SuperGlue估计的2D-3D对应关系,获得LiDAR相机变换的粗略估计。我们还提供了一个直观的用户界面,用于创建故障安全手动通信。给定2D-3D对应关系,执行RANSAC和重投影误差最小化,以获得LiDAR相机变换的初始估计!

给定LiDAR相机变换的初始估计,应用基于视图的隐藏点移除来移除从相机视点不应可见的LiDAR点,然后通过基于NID最小化的精细激光雷达相机配准来细化激光雷达相机变换估计。

A. Notation

本文的目标,是将Lidar点转换到图像坐标系中,论文主要使用传统针孔相机模型和全向等矩形相机模型作为投影函数。其它主要相机型号,包括ATAN、鱼眼和统一全向相机型号也已经实现,并在开发的工具箱中得到支持!

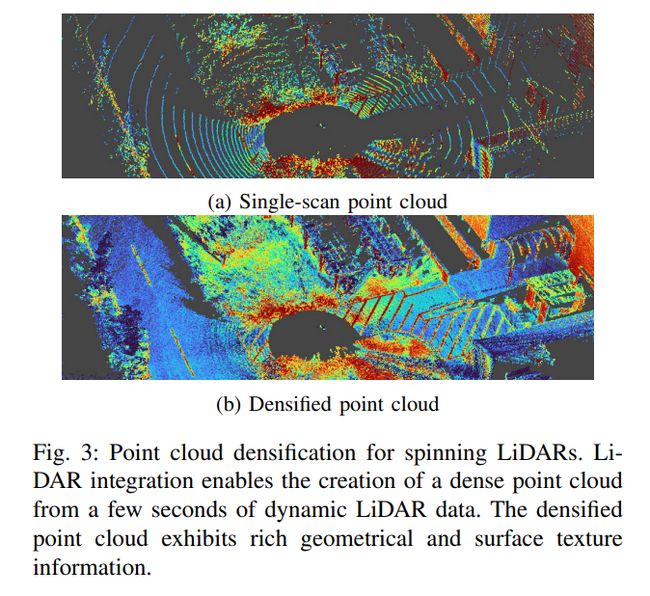

B. Preprocessing

旋转激光雷达(例如Ouster OS1-64)显示出稀疏和重复的扫描模式,并且很难仅从单个扫描中提取有意义的几何和纹理信息(见图3(a))。对于这样的LiDAR,本文在上下方向上移动LiDAR几秒钟并累积点,同时补偿视点变化和点云失真。为了估计LiDAR运动,使用CT-ICP算法,该算法通过最小化当前LiDAR扫描和具有插值LiDAR姿态的模型点云之间的距离,在扫描开始和结束时联合优化LiDAR姿势。为了从过去的观察中有效地创建目标点云,论文使用线性iVox结构,它简单地将每个体素的点保持在线性容器中。基于估计的LiDAR扫描开始和结束姿态,校正输入点云上的运动失真,并通过累积第一次扫描的坐标系中的所有点来创建密集点云。图3(b)显示了应用此动态激光雷达点积分过程后的加密点云。可以看到,加密的点云显示出丰富的几何和纹理信息,这在单扫描点云中很难看到。对于具有非重复扫描机制的LiDAR(例如Livox Avia),简单地将所有扫描累积到一帧中,产生密集的点云,如图1(b)。对于加密的点云和相机图像,论文应用直方图均衡,因为在精细配准步骤中使用的NID度量在均匀强度分布下最有效!

C. 初始猜测估计

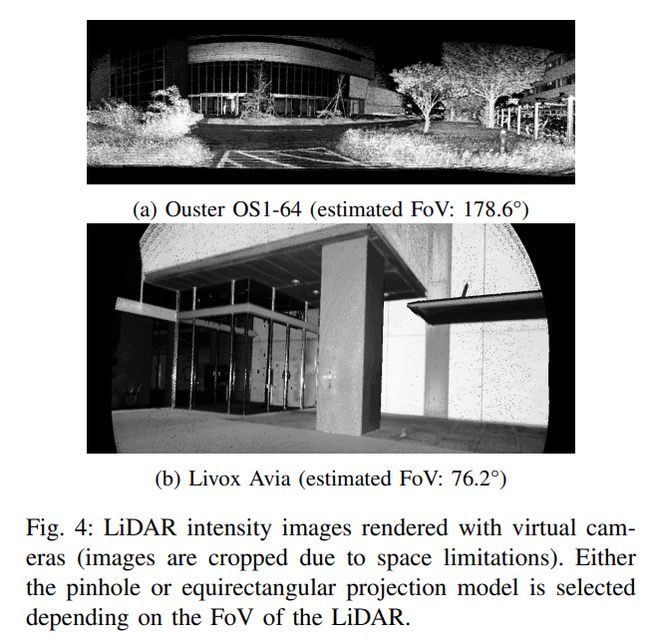

为了获得激光雷达相机变换的粗略估计,首先获得输入图像和点云之间的2D-3D对应关系,然后通过RANSAC和重投影误差最小化来估计激光雷达相机的变换。为了利用基于图形神经网络的图像匹配pipeline,使用虚拟相机模型从密集点云生成LiDAR强度图像。为了选择用于渲染整个点云的最佳投影模型,首先估计LiDAR的FoV。使用quickhull算法提取输入点云的凸包,然后使用蛮力搜索找到凸包中具有最大角度距离的点对。如果LiDAR的估计FoV小于150°,将使用针孔投影模型创建一个虚拟相机,否则将创建一个具有等矩形投影模型的虚拟相机。使用虚拟相机,我们使用强度值渲染点云,以获得LiDAR强度图像,如图4所示。与强度图像一起,还生成点索引图,以在随后的姿势估计步骤中有效地查找像素级3D坐标。请注意,虽然简单地渲染每个点而不进行插值和间隙填充,但由于密集的点云,渲染结果显示出良好的外观质量。

为了找到激光雷达和相机强度图像之间的对应关系,本文使用SuperGlue pipeline,它首先使用SuperPoint检测图像上的关键点,然后使用图形神经网络找到关键点之间的对应关系。在这项工作中使用了MegaDepth数据集上预处理的权重,虽然SuperGlue可以在不同模态的图像之间找到对应关系,但发现需要将匹配阈值设置为非常小的值(例如,0.05)以获得足够数量的对应关系。然而,通过这种设置,观察到许多虚假的对应关系被创建,如图5所示。

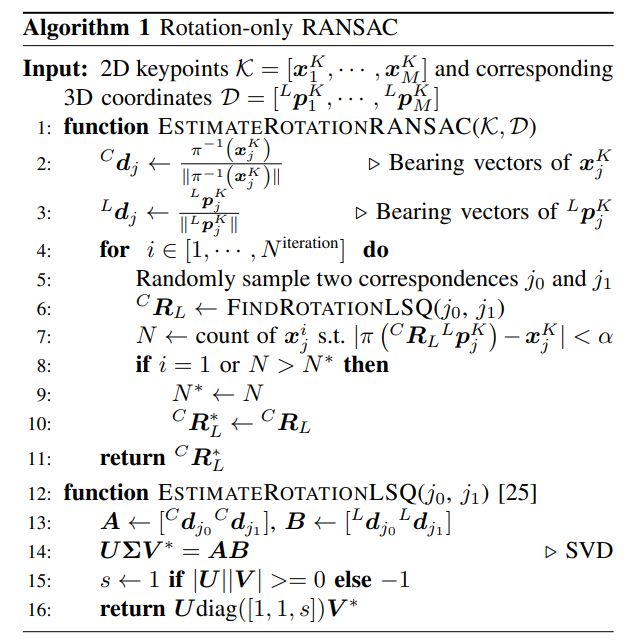

给定2D关键点坐标K=[xK1,··,xKM]和LiDAR帧D=[LpK1,·,LpKM]中的相应3D坐标,首先执行Alg 1中描述的仅旋转RANSAC,以稳健地处理异常值。将估计的旋转作为初始猜测,然后通过使用Levenberg-Marquardt优化器最小化所有关键点的重投影误差,我们获得了6 DoF LiDAR相机变换矩阵:

D.基于NID的直接激光雷达相机配准

由于视点差异,LiDAR点云中的一些点可能会被遮挡,并且在相机中不可见。如果简单地投影所有LiDAR点,这些点可能会导致错误的对应关系并影响标定结果。为了避免这个问题,应用基于视图的有效隐藏点移除来过滤掉从相机的视点看不可见的LiDAR点。使用LiDAR相机变换的当前估计,在图像中投影LiDAR点,并仅保留每个像素具有最小距离的点(即,深度缓冲测试)。从仅保留相机可见点的投影图像中,获得了一个3D点云,并将其用于精细配准!

由于在更新LiDAR相机变换时,相机可见的LiDAR点可能会发生变化,因此迭代基于视图的隐藏点移除和基于NID的LiDAR相机配准,直到变换更新的位移收敛!

实验

论文使用旋转和非重复扫描激光雷达(Ouster OS1-64和Livox Avia)以及针孔和全向相机的所有四种组合评估了拟议的标定工具箱,如图6所示。对于每种组合,在室内和室外环境中记录了15对LiDAR点云和相机图像,并对每对点云运行了建议的标定过程(即单镜头标定)!

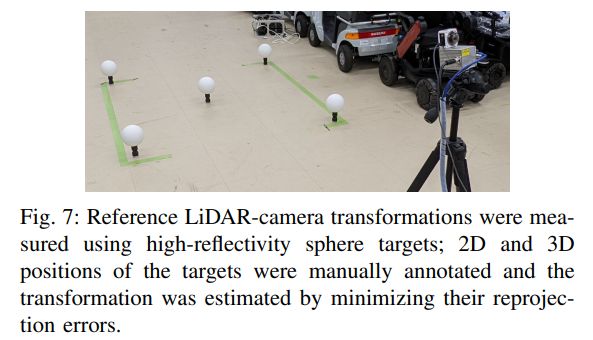

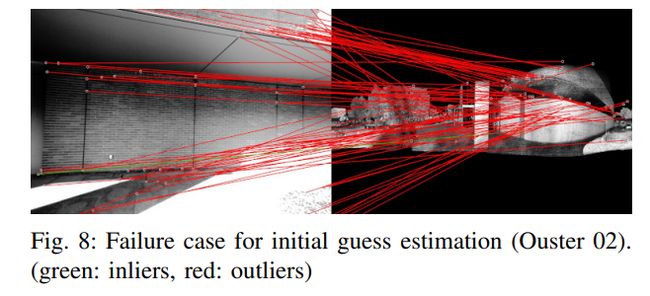

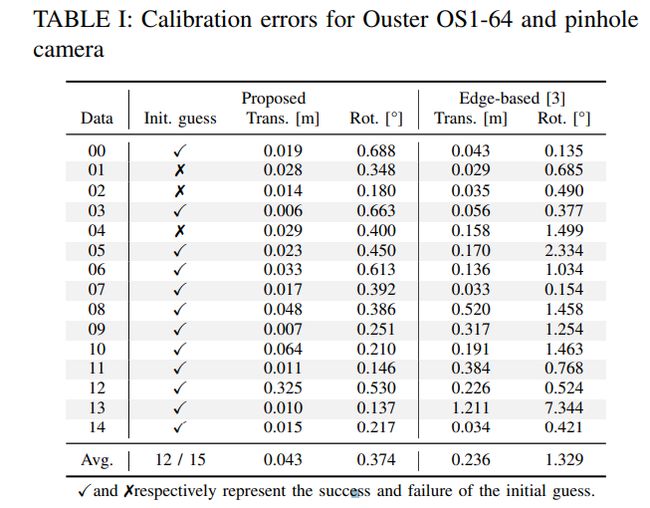

作为参考,使用测量级高反射率球体目标估计了激光雷达相机变换,如图7所示。手动标注了目标的2D和3D位置,以找到最小化目标重投影误差的LiDAR相机变换。通过目视检查,确认了估计的变换紧密地描述了摄像机的投影。使用估计的变换作为“伪”GT,表I总结了Ouster LiDAR和针孔相机组合的标定结果。对于初始猜测估计,如果平移和旋转误差分别小于0.5 m和1.0°,我们认为初始猜测估计是成功的。如表I所示,所提出的算法为15个数据相关性中的12个提供了合理的初始猜测,图8显示了故障案例(数据集02)的对应关系。

可以看到,由于平坦和重复的环境结构,估计对应包含许多虚假对应。注意,这种难以找到正确对应的数据配对可以在多个数据标定中由RANSAC自动过滤掉,并且不会影响估计结果。对于导致初始猜测失败的数据,论文手动注释了2D-3D对应关系,并重新估计了用于评估精细配准算法的转换。

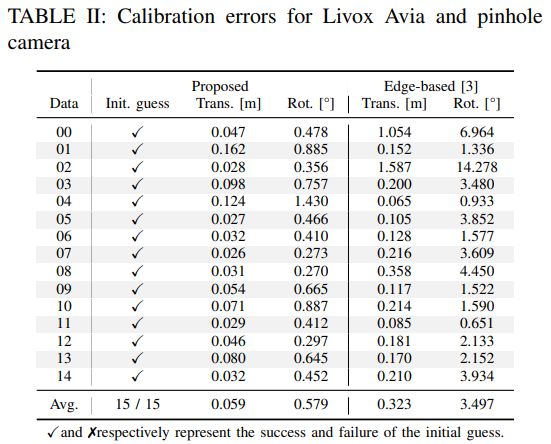

所提出的精细配准算法对所有数据都运行良好,平均实现了0.043 m和0.374°的标定误差。作为基线,作者还应用了最先进的基于边缘对齐的标定方法。对于该方法,使用参考LiDAR相机变换作为初始变换,因此使用几乎理想的初始猜测对其进行评估。然而,如表1所示,它显示了几个数据相关性的较大标定误差,导致了更差的平均标定误差(0.236 m和1.329°)。这是因为[3]中的图像和点云边缘提取对环境变化非常敏感,无法在多个环境中正确提取边缘点。如表II所示,对于Livox LiDAR和针孔相机的组合,初始猜测估计成功地为所有数据对提供了良好的初始LiDAR相机变换,并且精细配准算法实现了0.069 m和0.724°的平均标定误差,这优于基于边缘的标定[3](0.323 m和3.497°)。

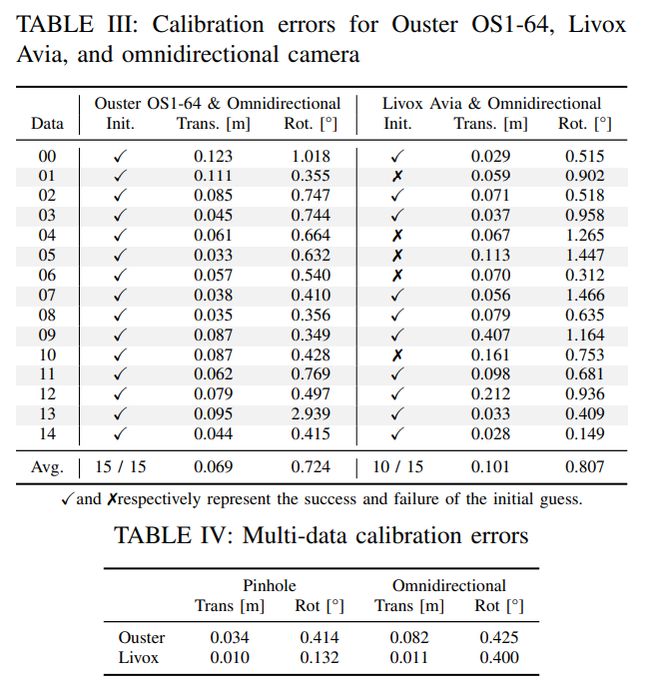

表三总结了全向摄像机的标定结果,尽管Ouster LiDAR显示出良好的初始猜测成功率(15/15)和较低的标定误差(0.069 m和0.724°),但Livox LiDAR和全向相机组合的初始猜测估计和精细的LiDAR相机配准往往会降低(10/15成功率,0.101 m和0.807°)。这是因为由于LiDAR和相机的FoV非常不同,只有一小部分全向相机图像用于标定,并且图像的分辨率不足以代表有限FoV的精细环境细节,论文认为使用高分辨率或多幅图像可以提高标定精度。最后,使用所有数据对进行了多数据标定,并评估了所有LiDAR相机组合的标定误差,表IV总结了标定误差。我们可以看到,即使是Livox和全向相机的组合(0.011m和0.400°),也获得了良好的标定结果。对于Ouster LiDAR和针孔相机的组合,观察到最佳标定精度(0.010 m和0.132°)。这是因为在这种组合中,激光雷达和相机具有相似的FoV,大多数输入数据用于标定,而由于FoV的差异,一些点和图像区域未用于其它组合。

表V显示了每个标定步骤的处理时间,根据激光雷达和相机模型的组合,从15个数据对标定激光雷达相机变换需要74到249秒。虽然Ouster LiDAR和全向摄像机的组合需要更长的时间,因为两个传感器都有360°FoV,并且需要投影大部分点,但认为它处于离线标定的合理水平。

参考

[1] General, Single-shot, Target-less, and Automatic LiDAR-Camera Extrinsic Calibration Toolbox.