ChatGPT的背后原理:大模型、注意力机制、强化学习

介绍ChatGPT机器人背后的原理,带你了解ChatGPT如何工作。

微信搜索关注《Python学研大本营》,加入读者群,分享更多精彩

本文主要介绍为ChatGPT提供动力的机器学习模型,将从大型语言模型的介绍开始,深入探讨使GPT-3得到训练的革命性的自注意机制,然后深入到从人类反馈强化学习,这是使ChatGPT出类拔萃的新技术。

大型语言模型

ChatGPT是一类机器学习自然语言处理进行推断的模型,称为大型语言模型(LLM)。LLM消化了大量的文本数据,并推断出文本中单词之间的关系。在过去的几年里,随着计算能力的进步,这些模型也在不断发展。随着输入数据集和参数空间大小的增加,LLM的能力也在增加。

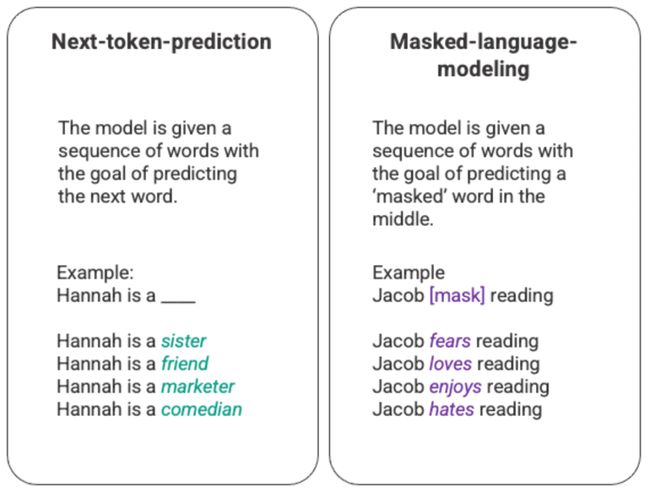

语言模型的最基本的训练涉及到预测一连串词语中的一个词。最常见的是,这被观察为下一个标记预测和屏蔽语言模型。

生成的下一个标记预测和屏蔽语言模型的任意示例

在这种基本的排序技术中,通常是通过长短记忆(LSTM)模型来部署的,模型是在给定环境和上下文的情况下,用统计上最有可能的词来填补空白。这种顺序建模结构有两个主要限制。

-

该模型无法对周围的一些词比其他词更重视。在上面的例子中,虽然“阅读”可能最常与“讨厌”联系在一起,但在数据库中,“雅各布”可能是一个狂热的读者,模型应该更重视“雅各布”而不是“阅读”,并选择“爱”而不是“讨厌”。

-

输入的数据是单独和按顺序处理的,而不是作为一个整体语料库。这意味着当训练LSTM时,上下文的窗口是固定的,只在序列中的几个步骤的单个输入之外延伸。这限制了词与词之间关系的复杂性以及可以得出的含义。

为了应对这个问题,2017年,Google Brain的一个团队引入了转化器。与LSTM不同,转化器可以同时处理所有输入数据。利用自我注意机制,该模型可以相对于语言序列的任何位置为输入数据的不同部分赋予不同的权重。这一特点使得在向LLM注入意义方面有了大规模的改进,并且能够处理更大的数据集。

GPT和Self-Attention

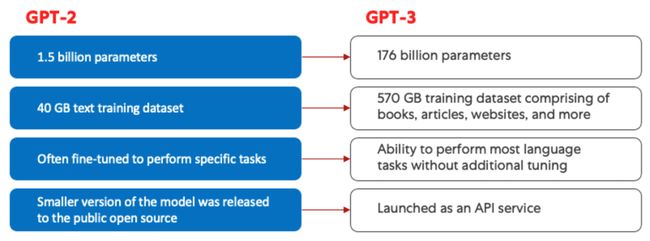

生成式预训练转化器(GPT)模型于2018年首次由OpenAI推出,名为GPT-1。这些模型在2019年的GPT-2、2020年的GPT-3以及最近的2022年的InstructGPT和ChatGPT中继续发展。在将人类反馈整合到系统中之前,GPT模型进化的最大进步是由计算效率方面的成就推动的,这使得GPT-3能够在比GPT-2多得多的数据上进行训练,使其拥有更多样化的知识基础和执行更广泛任务的能力。

GPT-2(左)和GPT-3(右)的比较。

所有的GPT模型都利用了转换器结构,这意味着它们有一个编码器来处理输入序列,一个解码器来生成输出序列。编码器和解码器都具有多头的自我注意机制,允许模型对序列的各个部分进行不同的加权,以推断出意义和背景。此外,编码器利用屏蔽语言模型来理解单词之间的关系,并产生更易于理解的反应。

驱动GPT的自注意机制的工作原理,是通过将标记(文本片段,可以是一个词、一个句子或其他文本分组)转换为代表该标记在输入序列中的重要性的向量。为了做到这一点,该模型:

-

1.为输入序列中的每个标记创建一个

query,key,和value向量。 -

2.通过取两个向量的点积,计算步骤1中的

query向量与其他每个标记的key向量之间的相似性。 -

3.通过将第2步的输出输入一个

softmax函数中来生成归一化的权重。 -

4.通过将步骤3中产生的权重与每个标记的

value向量相乘,产生一个最终向量,代表该序列中标记的重要性。

GPT使用的“multi-head”注意机制是自我注意的一种进化。该模型不是一次性执行第1-4步,而是并行地多次迭代这一机制,每次都会生成一个新的query,key,和value向量的线性投影。通过以这种方式扩展自我注意,该模型能够掌握输入数据中的子含义和更复杂的关系。

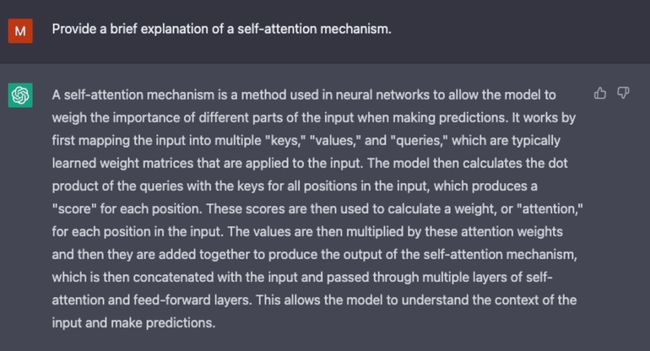

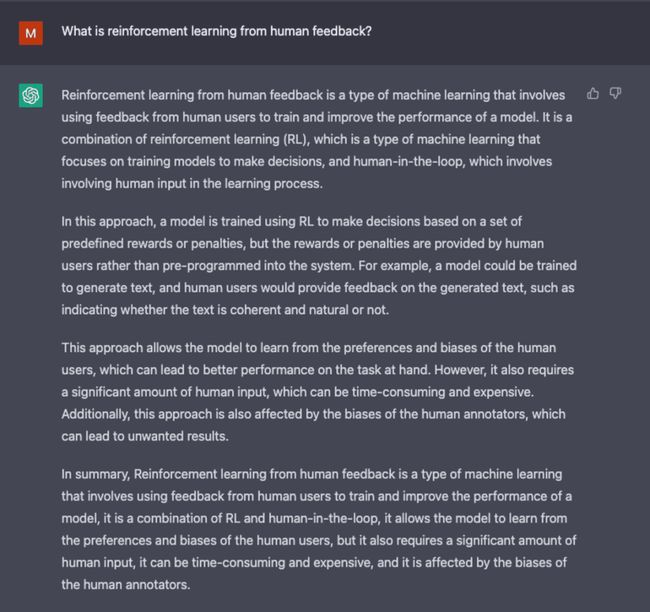

从ChatGPT生成的屏幕截图。

尽管GPT-3在自然语言处理方面引入了显著的进步,但它在与用户意图保持一致的能力方面是有限的。例如,GPT-3可能会产生以下输出结果:

-

缺乏帮助性,意味着它们不遵循用户的明确指示。

-

含有反映不存在的或不正确的事实的幻觉。

-

缺乏可解释性,使人类难以理解模型是如何得出一个特定的决定或预测的。

-

包含有害或有冒犯性的内容以及传播错误信息的有害或偏见内容。

在ChatGPT中引入了创新的训练方法,以抵消标准LLM的一些固有问题。

ChatGPT

ChatGPT是InstructGPT的衍生产品,它引入了一种新颖的方法,将人类反馈纳入训练过程,使模型的输出与用户的意图更好地结合。来自人类反馈的强化学习(RLHF)在openAI的2022年论文《Training language models to follow instructions with human feedback》中得到了深入的描述,并在下面进行了简单讲解。

第1步:监督微调(SFT)模型

第一次开发涉及微调GPT-3模型,雇用40个承包商来创建一个有监督的训练数据集,其中输入有一个已知的输出供模型学习。输入或提示是从开放API的实际用户输入中收集的。然后,标签人员对提示编写适当的响应,从而为每个输入创建一个已知的输出。然后,GPT-3模型使用这个新的、有监督的数据集进行微调,以创建GPT-3.5,也称为SFT模型。

为了最大限度地提高提示信息数据集的多样性,只有200条提示信息可以来自任何给定的用户ID,并且删除了共享长通用前缀的任何提示信息。最后,删除了包含个人身份信息(PII)的所有提示。

在汇总了OpenAI API的提示信息后,还要求标签人员创建提示信息样本,以填补那些只有极少真实样本数据的类别。所关注的类别包括:

-

普通提示:任何任意的询问。

-

少量的提示:包含多个查询/回答对的指令。

-

基于用户的提示:对应于为OpenAI API请求的特定用例。

在生成响应时,要求标签人员尽力推断出用户的指令是什么。该文件描述了提示请求信息的三种主要方式。

-

直接:“告诉我关于......”

-

寥寥数语:给出这两个故事的例子,再写一个关于同一主题的故事。

-

续写:给出一个故事的开头,完成它。

对来自OpenAI API的提示和标签人员手写的提示进行汇编,产生了13,000个输入/输出样本,用于监督模型的使用。

图片(左)插入自“Training language models to follow instructions with human feedback” OpenAI等,2022 https://arxiv.org/pdf/2203.02155.pdf。(右)用红色添加的其他上下文。

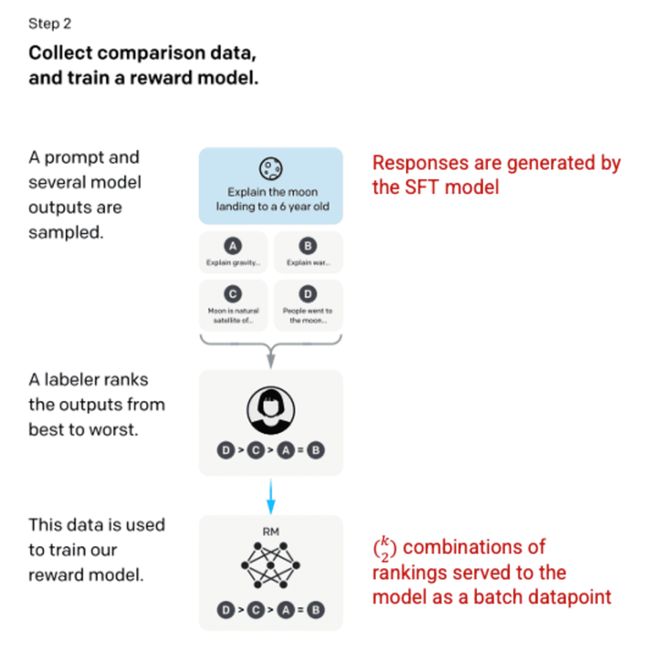

第2步:奖励模型

在步骤1中训练了SFT模型后,该模型对用户的提示产生了更好的、一致的反应。下一个改进是以训练奖励模型的形式出现的,其中模型的输入是一系列的提示和响应,而输出是一个标度值,称为奖励。为了利用强化学习(Reinforcement Learning),奖励模型是必需的,在强化学习中,模型会学习产生输出以最大化其奖励(见步骤3)。

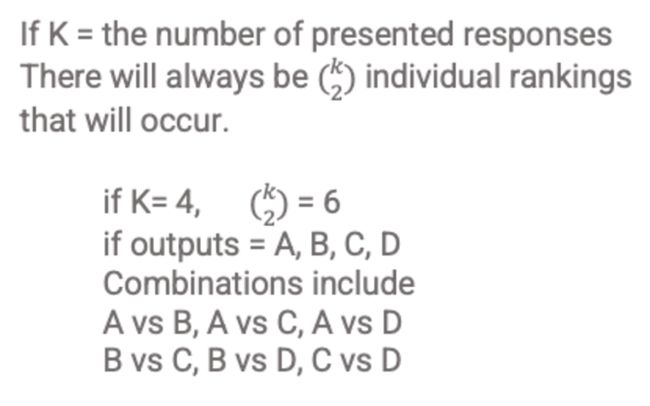

为了训练奖励模型,标签人员对一个单一的输入提示提供4到9个SFT模型输出。他们被要求将这些输出从最好的到最差的进行排序,创建输出排序的组合,如下所示:

响应排序组合的示例。

将每个组合作为一个单独的数据点纳入模型,会导致过度拟合(无法推断出所见数据之外的内容)。为了解决这个问题,模型是利用每组排名作为一个单独的批处理数据点来建立的。

图片(左)插入自“Training language models to follow instructions with human feedback” OpenAI等,2022 https://arxiv.org/pdf/2203.02155.pdf。(右)用红色添加的其他上下文。

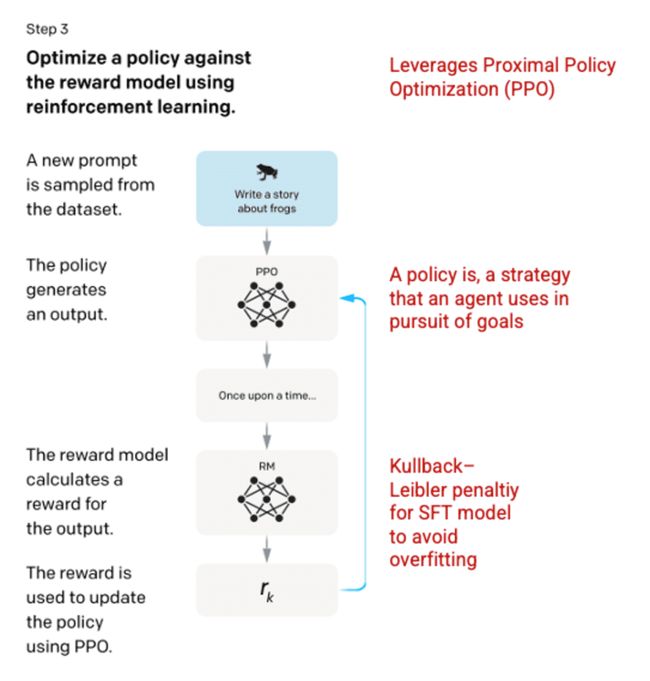

第3步:强化学习模型

在最后阶段,向模型提出一个随机提示并返回一个响应。响应是使用模型在第2步学到的“策略” 产生的。该策略代表机器已经学会用于实现其目标的策略;在这种情况下,就是将其奖励最大化。基于步骤2中开发的奖励模型,然后为提示和响应对确定一个标度奖励值。然后,奖励会反馈到模型中以发展策略。

2017年,Schulman等人引入了近端策略优化(PPO),该方法用于在生成每个响应时更新模型的策略。PPO纳入了SFT模型中的Kullback-Leibler(KL)惩罚。KL散度测量两个分布函数的相似性,并对极远距离进行惩罚。在这种情况下,使用KL惩罚可以减少响应与步骤1中训练的SFT模型输出的距离,以避免过度优化奖励模型并与人类意图数据集发生太大偏差。

图片(左)插入自“Training language models to follow instructions with human feedback” OpenAI等,2022 https://arxiv.org/pdf/2203.02155.pdf。(右)用红色添加的其他上下文。

该过程的第2和第3步可以反复迭代,尽管在实践中还没有广泛地进行。

从ChatGPT生成的屏幕截图。

模型的评估

对模型的评估是通过在训练期间预留一个模型未见过的测试集来进行的。在测试集上,进行一系列的评估,以确定该模型是否比其前身GPT-3表现更好。

有用性:模型推断和遵循用户指令的能力。标签人员在85±3%的时间里更喜欢InstructGPT的输出,而不是GPT-3。

真实性:模型出现幻觉的倾向。在使用TruthfulQA数据集进行评估时,PPO模型产生的输出在真实性和信息量方面都有小幅增加。

无害性:模型避免不适当的、贬低的和诋毁的内容的能力。无害性是使用RealToxicityPrompts数据集来测试的。该测试在三种条件下进行。

-

指示提供尊重的反应:导致有害反应的明显减少。

-

指示提供反应,没有任何关于尊重的设置:有害性没有明显变化。

-

指导提供有害的反应:反应实际上比GPT-3模型的有害性明显增加。

关于创建ChatGPT和InstructGPT所使用方法的更多信息,请阅读OpenAI发表的原始论文 “Training language models to follow instructions with human feedback”,2022 https://arxiv.org/pdf/2203.02155.pdf。

从ChatGPT生成的屏幕截图。

推荐书单

《Python人工智能》

本书系统地介绍了基于Python平台的人工智能的原理及实现过程,全书共7章。第1章“从这里开始认识Python”,介绍人工智能及Python 基础知识;第2章“Python 语法基础”,通过生动有趣的实验实例介绍Python编程语法知识;第3章“Python 程序设计”,以实例为基础,介绍Python 的编程方法;第4 章“数据结构”,通过范例介绍列表、元组、字典、集合、函数等数据结构的使用方法;第5章“数据库及应用”,主要介绍Python数据库应用及Web应用开发技术,通过实例讲解Python数据库应用;第6章“大数据应用”,基于实例,主要介绍网络爬虫、Excel数据爬取及分析处理等技术,了解数据挖掘分析处理等大数据应用技术的一般设计流程;第7 章“人工智能”,以具体实例讲解照片人脸识别、图像识别、视频人脸识别、聊天机器人、微信语音聊天机器人、图文识别、语音识别及花朵识别等人工智能深度学习技术。

本书图文并茂,示例丰富,讲解细致透彻,介绍深入浅出,章后练习精广,具有很强的实用性和可操作性,适合初学或自学Python的学生,可作为中小学STEM 教育或培训机构的人工智能课程教材,也可作为大中专院校人工智能、软件工程、计算机等专业以及相关课程的教材或参考书,还可以当作全国计算机二级(Python)考试的教材使用。

《Python人工智能》(刘伟善)【摘要 书评 试读】- 京东图书京东JD.COM图书频道为您提供《Python人工智能》在线选购,本书作者:,出版社:清华大学出版社。买图书,到京东。网购图书,享受最低优惠折扣!![]() https://item.jd.com/12854912.html

https://item.jd.com/12854912.html

精彩回顾

《大模型技术的根基,解读注意力机制论文《Attention Is All You Need》和代码实现(下)》

《大模型技术的根基,解读注意力机制论文《Attention Is All You Need》和代码实现(上)》

《真实对比,OpenAI ChatGPT与谷歌Bard大比拼》

《深入浅析,一步步用GPT打造你的聊天机器人》

《ChatGPT插件使用攻略,解锁互联网新体验》

《使用ChatGPT API创建Python文档,竟然如此简单》

微信搜索关注《Python学研大本营》,加入读者群

访问【IT今日热榜】,发现每日技术热点