毕业设计:基于python的反爬虫系统

目录

前言

设计思路

一、课题背景与意义

二、算法理论技术

2.1 spark技术

2.2 反爬虫设计

2.3 黑名单设计

三、检测的实现

3.1 数据集

3.2 实验环境

最后

前言

大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

对毕设有任何疑问都可以问学长哦!

选题指导:

最新最全计算机专业毕设选题精选推荐汇总

大家好,这里是海浪学长毕设专题,本次分享的课题是

基于python的反爬虫系统

设计思路

一、课题背景与意义

随着网络信息的日益丰富,爬虫技术被广泛应用于数据抓取和分析。然而,恶意爬虫的存在对网站的安全和稳定性构成了严重威胁。基于Python的反爬虫系统旨在通过一系列技术手段,有效识别和防御恶意爬虫,保护网站的正常运行和数据安全。该系统的研究对于提升网站安全防护能力、维护网络生态平衡具有重要意义,同时也为反爬虫技术的发展提供了新的思路和方法

二、算法理论技术

2.1 spark技术

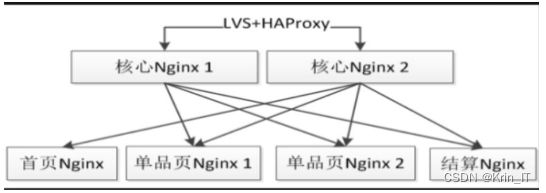

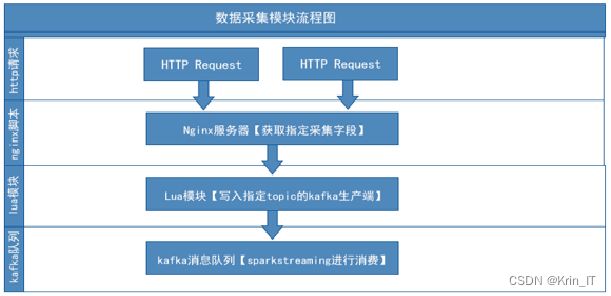

Spark技术在反爬虫系统中的应用包括数据清洗和预处理、分布式爬虫调度、分布式数据存储和分析、分布式机器学习和模型训练,以及分布式任务调度和监控。通过利用Spark的并行处理、分布式计算和机器学习能力,反爬虫系统能够高效处理大量数据,识别恶意行为,提高爬取效率,实现实时监控和优化任务执行,从而有效应对爬虫行为,提升系统性能和准确性。

Kafka在反爬虫系统中的应用和优势主要体现在高吞吐量、可持久化存储、分布式架构、解耦消息发送和接收端、实时数据处理以及可靠的数据传输和复制等方面。它能够处理大规模的消息流,保证数据的可靠性和不丢失,并具备高可扩展性和容错性。通过实时数据处理和灵活的消息处理流程,Kafka帮助反爬虫系统快速响应爬虫行为的变化和威胁,并采取相应的措施来应对。

2.2 反爬虫设计

为了捕获恶意爬虫,通过检测单次IP访问请求中的User-Agent(UA)中是否出现非浏览器字样来判断是否为伪装的爬虫。具体实现方法包括使用Kafka数据流,设定窗口时间和滑动时间进行统计。通过Remoteaddr作为Key,将User-Agent作为Value,统计每个IP在一定时间内使用的UA列表。然后对统计结果进行去重,统计每个IP使用的不同UA的数量,形成(Remoteaddr,UACount)的格式。将统计结果收集到HashMap中,并与预设的阈值进行比较,以确定是否为爬虫。该方法可以提高捕获爬虫的效率和准确度。

def process_request(request):

remote_addr = request[0]

user_agent = request[1]

return remote_addr, user_agent

def detect_crawlers(requests):

ua_threshold = 3 # 阈值,判断为爬虫的UA数量上限

detected_crawlers = []

ua_counts = defaultdict(set)

for request in requests:

remote_addr, user_agent = process_request(request)

ua_counts[remote_addr].add(user_agent)

for remote_addr, ua_set in ua_counts.items():

ua_count = len(ua_set)

if ua_count > ua_threshold:

detected_crawlers.append(remote_addr)

return detected_crawlers

通过统计访问关键页面(如查询、预定页面)的总量来识别爬虫。普通用户不太可能在短时间内频繁访问这些关键页面,而爬虫通常会针对特定页面进行操作。具体实现方法是,系统从Kafka消息中获取请求数据,并与关键页面规则进行匹配。如果匹配成功,记录为(Remoteaddr,1),否则记录为(Remoteaddr,0)。最后,通过对结果进行Map操作统计最终的访问量,并与预设的阈值进行比较,标记为爬虫。

def detect_crawlers(requests):

page_threshold = 10 # 关键页面访问量阈值

detected_crawlers = []

page_counts = requests.map(lambda x: process_request(x)).reduceByKey(lambda x, y: x + y)

for remote_addr, count in page_counts.collect():

if count > page_threshold:

detected_crawlers.append(remote_addr)

return detected_crawlers

if __name__ == "__main__":

conf = SparkConf().setAppName("CrawlerDetection")

sc = SparkContext(conf=conf)

ssc = StreamingContext(sc, 5) # 设置窗口时间为5秒

ssc.checkpoint("checkpoint")

kafka_stream = KafkaUtils.createStream(ssc, "localhost:2181", "crawler-group", {"crawler-topic": 1})

requests = kafka_stream.map(lambda x: x[1]) # 获取Kafka数据流中的请求部分

detected_crawlers = requests.window(300, 60).foreachRDD(lambda rdd: detect_crawlers(rdd.collect()))通过计算查询关键页面的时间差来判断爬虫和普通用户。系统设置一个自定义的时间阈值,比如十秒,然后对每两次关键页面访问的时间差进行计算,如果时间差小于系统预设值,就将次数记录叠加。最后,系统可以查看某个用户对某个关键页面访问时间小于预设值的访问次数,以此来区分爬虫和普通用户。

2.3 黑名单设计

通过Spark Streaming程序对5分钟内的指标进行计算,对每个请求进行评分和判断是否命中爬虫阈值。评分策略基于数据库流程策略、IP和请求匹配,并使用打分权重进行计算。非黑名单数据被剔除,重复的黑名单数据被过滤,并将黑名单数据实时存储到HDFS,用于Redis数据恢复。

三、检测的实现

3.1 数据集

现有的公开数据集并不足以支撑我的研究需求。为了提高系统的识别准确率和防御能力,我决定自己制作一个反爬虫数据集。我通过模拟多种爬虫行为,包括正常的数据抓取和恶意的攻击行为,收集了大量访问日志和行为特征。然后对这些数据进行清洗、标注和分类,构建了一个包含丰富样本的反爬虫数据集。这个数据集不仅包含了各种爬虫行为的特征,还模拟了实际场景中可能出现的复杂情况和攻击手段。通过训练和验证这个自制的数据集,我能够更准确地评估系统的性能,并为后续的研究提供有力支持。

3.2 实验环境

系统支持在Windows和Linux操作系统上运行,要求系统的运行内存为8GB以上。使用MySQL和Redis作为数据库存储数据。开发工具使用IntelliJ IDEA,并通过Maven进行Jar包导入和管理。系统部署需要Tomcat 6.0版本或更高版本作为服务器。用户可以选择使用Firefox浏览器来访问系统。

相关代码示例:

from flask import Flask, request

app = Flask(__name__)

@app.route('/')

def index():

user_agent = request.headers.get('User-Agent')

ip_address = request.remote_addr

if is_spider(user_agent):

return '403 Forbidden: Spider Detected'

if is_ip_limited(ip_address):

return '403 Forbidden: IP Address Limited'

return 'Welcome to the website!'

def is_spider(user_agent):

spider_keywords = ['bot', 'spider', 'crawler']

if any(keyword in user_agent.lower() for keyword in spider_keywords):

return True

return False

def is_ip_limited(ip_address):

ip_blacklist = ['127.0.0.2', '192.168.0.1']

if ip_address in ip_blacklist:

return True

return False

实现效果图样例:

![]()

![]()

![]()

创作不易,欢迎点赞、关注、收藏。

毕设帮助,疑难解答,欢迎打扰!