大模型日报-20240126

「think step by step」还不够,让模型「think more steps」更有用

https://mp.weixin.qq.com/s/3mdDYQI0WYgIpctyK6q2PA

如今,大型语言模型(LLM)及其高级提示策略的出现,标志着对语言模型的研究取得了重大进展,尤其是在经典的 NLP 任务中。这其中一个关键的创新是思维链(CoT)提示技术,该技术因其在多步骤问题解决中的能力而闻名。这项技术遵循了人类的顺序推理,在各种挑战中表现出了优秀的性能,其中包括跨域、长泛化和跨语言的任务。CoT 及其富有逻辑的、循序渐进的推理方法,在复杂的问题解决场景中提供了至关重要的可解释性。来自美国西北大学、利物浦大学和新泽西理工大学等的研究者们,进一步探讨了推理步骤的长度与结论准确性之间的关系,帮助人们加深关于如何有效解决 NLP 问题的理解。下面这篇文章探索了推理步骤是否是促使 CoT 发挥作用的 prompt 中最关键的部分(见图 1)。本文实验中严格的控制变量,特别是在加入新的推理步骤时,研究者会确保不会引入额外的知识。在零样本实验中,研究者将初始 prompt 从「请逐步思考」调整为「请逐步思考,并且尽可能思考出更多的步骤」。对于小样本问题,研究者设计了一个实验,在保持所有其他因素不变的情况下,扩展基础推理步骤。

汤晓鸥弟子带队:免调优长视频生成,可支持512帧!任何扩散模型都能用

https://mp.weixin.qq.com/s/AO6f_-rnUwwkNVEWGq1rag

现在,有人提出了一个效果很不错的免调优方法,直接就能作用于预训练好的视频扩散模型。它最长可支持512帧(假设帧率按30fps算,理论上那就是能生成约17秒长的作品了)。可应用于任何视频生成模型,比如AnimateDiff、LaVie等等。以及还能支持多文本生成,比如可以让骆驼一会跑一会停。这项成果来自腾讯AI Lab、南洋理工大学以及港科大,入选了ICLR 2024。

未来五年AI如何改变各学科?从LLM到AI蛋白设计、医疗保健…

https://mp.weixin.qq.com/s/-saF-4mVE8jdvZei-w2RWQ

五年前(2019 年 1 月),《Nature Machine Intelligence创刊。当然,就人工智能(AI)而言,五年前似乎是一个不同的时代。1 月 24 日,Nature Machine Intelligence 杂志在《Anniversary AI reflections(周年人工智能反思)专题中,再次联系并采访了近期在期刊发表评论和观点文章的作者,请他们从各自所在领域中举例说明人工智能如何改变科学过程。想知道,他们对人工智能领域的哪些其他主题感到兴奋、惊讶或担忧,以及他们对 2024 年以及未来五年的人工智能的希望和期望是什么。一个反复出现的主题是大型语言模型和生成人工智能的持续发展、它们对科学过程的变革性影响以及对伦理影响的担忧。

Hinton、LeCun、Bengio三巨头,马维英、陈海波等华人入选,2023 ACM Fellow公布

https://mp.weixin.qq.com/s/MQLIE06WNYWTm7eqb04u9Q

今天,美国计算机协会 ACM(Association for Computing Machinery)公布了最新一届 Fellow 名单。ACM 创立于 1947 年,是全世界计算机领域影响力最大的专业学术组织之一。ACM Fellow 是由该组织授予资深会员的荣誉,目的为表彰会员中对于计算机相关领域贡献前 1% 的学者,其审查过程十分严格,每年遴选一次,研究员由同行提名,提名由委员会审查。本年度新入选科学家中共有 68 人,他们的贡献涉及网络安全、人机交互、移动计算和推荐系统等领域。令人惊奇的是,曾获得 ACM 图灵奖的深度学习三巨头 Geoffrey Hinton、Yoshua Bengio、Yann LeCun,今年全部入选 ACM Fellow。今年入选者还包括马维英、陈海波等多名华人学者。

全世界机器人共用一个大脑,谷歌DeepMind已经完成了第一步

https://mp.weixin.qq.com/s/qiuvFBoGorFJ3FakjIzfAQ

过去一年,生成式人工智能发展的核心关键词,就是「大」。人们逐渐接受了强化学习先驱 Rich Sutton 充分利用算力「大力出奇迹」的思潮,庞大的数据量是 AI 模型展现出惊人智慧的核心原因。数据规模越大、质量越高、标注越细,模型就能了解到更全面的世界知识,从而拟合出更加智能的结果。那么,为什么人工智能的进展还没有转化成科幻片中那种全能管家机器人呢?能清理桌子、叠衣服、做早餐的机器人在哪里?一个重要的原因是机器人领域很难「大力出奇迹」,生成式 AI 的文字或图片训练数据在网络上就能轻松获取,而机器人的训练数据通常是由研究人员在实验室里根据具体的任务一个一个地创建的。这个过程往往漫长而又乏味。为了得到问题的答案,由谷歌 Deepmind 发起,来自北美、欧洲、亚洲的 34 个机器人实验室共同启动了 RT-X 项目。RT-X 项目的目标是汇集数据、资源和代码,让通用机器人走进现实。该项目的主要参与者加州大学伯克利分校的 Sergey Levine 教授和 Google DeepMind 的资深科学家 Karol Hausman 联合撰写了「THE GLOBAL PROJECT TO MAKE A GENERAL ROBOTIC BRAIN(打造通用机器人大脑的全球合作项目)」一文,总结了 RT-X 项目取得的进展。

【2.1 万字实录】Rabbit 创始人&CEO 吕骋最新对谈|R1 更像是 AI + iPod,而不是 iPhone 杀手

https://mp.weixin.qq.com/s/DdS_KPhGCCt4y7Ak4SY-Eg

这是 Rabbit CEO 吕骋(Jesse Lyu)在 CES 后在《This Week Startup》节目上与硅谷知名天使投资人 Jason Calacanis 最新对话,长达 90 分钟的对谈详细描述了他最新的产品思考。吕骋强调了技术的演进是为了解决相同的问题,但以更直观的方式。他详细介绍了 LAM (Large Action Model)的工作原理, LAM 旨在提高效率、节省时间,这是一个真正的时间节省装置,让用户更多地专注于其他事情,这一理念是公司的核心驱动力。

美国家AI研究资源试点项目上线,NASA、英伟达、OpenAI等捐赠关键基础资源

https://mp.weixin.qq.com/s/oNdAc2N6BYo_Qmy2_DccdQ

美国国家科学基金会(NSF)启动了国家人工智能研究资源试点项目(NAIRR),旨在通过共享国家研究基础设施,确保广泛的研究和教育界能够公平获取AI基础资源和工具。该项目得到了包括NASA、英伟达、OpenAI等在内的多家政府机构和私营企业的资源捐赠。NAIRR将提供数据集、AI模型、软件和培训资源,以支持AI研究,特别是对资源有限的小型机构和代表性不足的群体。项目预算每年8亿美元,为期三年,旨在保持美国在AI技术领域的国际竞争力。

Adept AI分享新模型Fuyu-Heavy:世界上第三强大的多模态模型

https://x.com/AdeptAILabs/status/1750215532597665849?s=20

介绍Fuyu-Heavy,我们的新型多模态模型。Fuyu-Heavy是世界上第三强大的多模态模型,仅次于体量是其10到20倍的GPT4-V和Gemini Ultra。特别是,在MMLU和MMMU两个方面,它都超越了Gemini Pro…

Szegedy分享:我越来越相信检索增强生成是强大通用人工智能最核心的问题

https://x.com/ChrSzegedy/status/1750196565409701979?s=20

在过去几年里(自2016年以来),我越来越相信检索增强生成是强大通用人工智能最核心的问题。尽管在过去7年里已经完成了惊人的工作,但它仍然是最核心的问题。

看看科学是关于什么的:发现越来越多的、在看似越来越不明显的领域之间的隐晦联系。这种“侦探工作”涉及到长的联想链和心智建模,与彻底的信息收集交织在一起。

即便对于人类来说,执行这种任务也不容易,我们需要几十年的训练才能学会做得好。

这个复杂的过程就是真正的RAG,而迄今为止发布的任何东西都还没有接近于好好地解决它。

DeepLearning 新课程《自动化测试LLMOps》by Rob Zuber

https://x.com/AndrewYNg/status/1750200384600309872?s=20

新的短期课程:由CircleCI的首席技术官Rob Zuber开设的《自动化测试LLMOps》!这个课程将教你如何将CI(持续集成)的一些核心理念——它一直是高效软件工程的支柱——适用于构建基于LLM(大型语言模型)的应用。

微调基于LLM的应用程序以改进它——比如通过修改提示语——可能会产生意想不到的副作用。例如,如果一个团队成员更新提示语试图使LLM输出看起来更有趣,但这却导致它产生了更多幻觉怎么办?自动化测试作为你的LLMOps(LLM操作)方法的一部分,有助于避免这些问题,并让你更快且更有信心地发布产品。

在这个课程中,你将学到:

(i)编写LLM评估,以涵盖常见问题,如幻觉、数据偏移,以及有害或冒犯性输出。

(ii)构建CI工作流,以自动评估你的应用程序的每一个变更。

(iii)安排你的CI工作流,在开发的不同阶段运行特定评估。

鉴于AI开发的迭代性质,CI对AI应用来说尤其重要,这意味着我们经常希望进行许多渐进式的变更。

Hannun分享:在Apple Silicon上只需3步使用MLX运行RAG应用

https://x.com/awnihannun/status/1750188633297166842?s=20

在Apple Silicon上使用MLX运行RAG应用,只需3步

python3 -m pip install -r requirements.txt

python3 create_vdb.py --pdf flash_attention.pdf --vdb vdb.npz

python3 query_vdb.py --question “what is flash attention?”

https://github.com/vegaluisjose/mlx-rag/tree/main

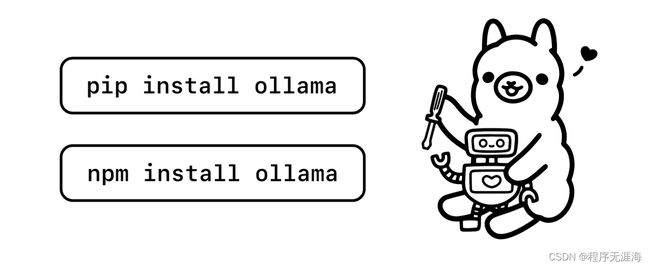

Ollama Python和JavaScript库推出:可以将新的和现有的应用程序与Ollama集成,并共享Ollama REST API的特性和感觉

https://x.com/ollama/status/1750200451205939392?s=20

Ollama Python和JavaScript库现已推出!

这两个库使得仅需几行代码就能将新的和现有的应用程序与Ollama集成,并共享Ollama REST API的特性和感觉。

了解更多:

https://ollama.ai/blog/python-javascript-libraries