【MPI、OpenMP】并行快速排序(C语言)

本文记录了使用MPI与OpenMP两种并行计算方法实现快速排序算法,题目是专业实验课上老师给的,主要分享一下自己的做法,希望大家不吝赐教(使用的语言是C语言,有例子+图阐述原理,代码注释很全)。

目录

- 快速排序算法并行实现

-

- 1. 快速排序算法

- 2. 并行快速排序原理

-

- 2.1 MPI快排并行原理

-

- 2.1.1 进程数为2的整数次方

- 2.1.2 进程数为2的非整数次方

- 2.2 OpenMP快排并行原理

- 3. 完整代码与结果(含注释)

-

- 3.1 MPI

- 3.2 OpenMP

快速排序算法并行实现

1. 快速排序算法

本篇文章主要针对快排算法的并行实现,所以大家如果有忘记快排算法的,可以参考一下这篇文章(快速排序算法原理及实现(单轴快速排序、三向切分快速排序、双轴快速排序)),这篇文章里面有动图,感觉还是挺不错的,有需要的朋友可以看看,其次再贴一个C语言实现串行快速排序算法的程序(快速排序算法(QSort,快排)及C语言实现),并行算法的实现核心还是围绕这个方法进行的。

- 核心功能代码

实现方式有挺多种的,我使用的是把数据data的第一个元素作为基准进行快排的,代码如下:

int Partition(int* data, int start, int end) //划分数据

{

int temp = data[start]; //以第一个元素为基准

while (start < end) {

while (start < end && data[end] >= temp)end--; //找到第一个比基准小的数

data[start] = data[end];

while (start < end && data[start] <= temp)start++; //找到第一个比基准大的数

data[end] = data[start];

}

data[start] = temp; //以基准作为分界线

return start;

}

2. 并行快速排序原理

此处主要讲MPI并行方式的原理,OpenMP的就想办法凑一些可以并行的代码就行。

2.1 MPI快排并行原理

除了快排本身的核心代码,该算法的核心问题是如何处理各个进程之间的通信。

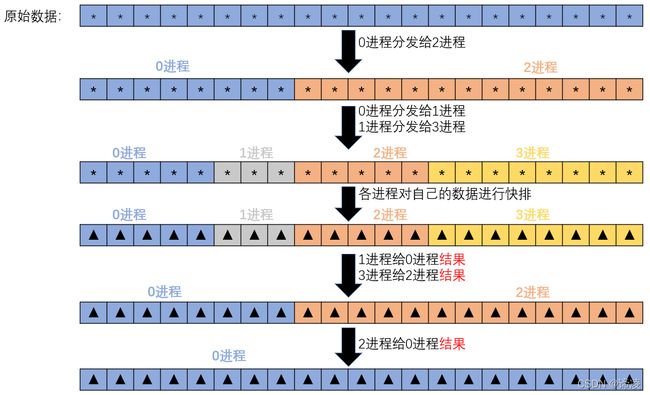

2.1.1 进程数为2的整数次方

下面以四个进程为例,数据(下图中的星号 * 表示未排序的数据,不同颜色表示不同进程)可以被分发m = log24 = 2次,分发原则为:

- 0进程首先分发数据给 0+2(m−1) = 2 进程,令m = m-1 = 1;

- 进而0进程剩余的数据分发给 0+2(m−1) = 1 进程;同理2进程将从进程0接收的数据分发给 2+2(m−1) = 3 进程;

- 无进程可以分配了,则四个进程对各自数据进行快排(排完序的数据用▲表示);

- 最后每个进程将快排的结果传给分配给自己数据的进程(此处:1给0,3给2,2给0,0输出 )。

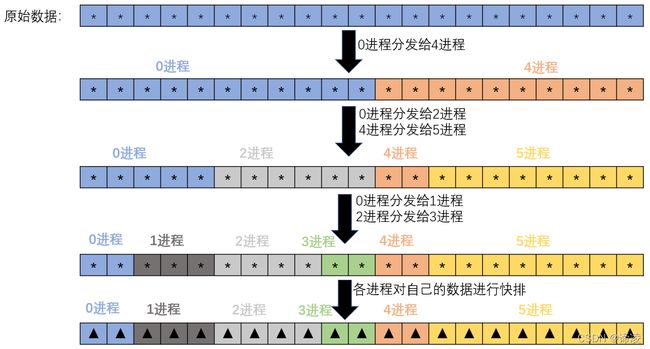

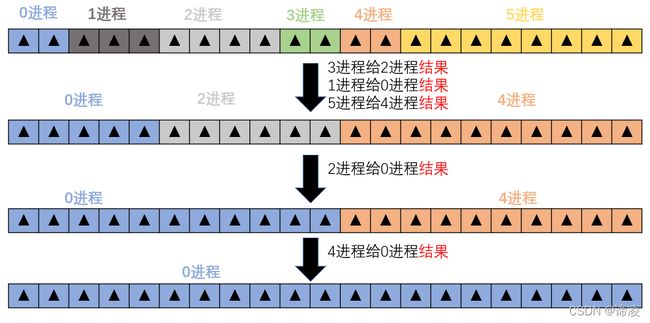

2.1.2 进程数为2的非整数次方

当总进程数不是2的整数次方时,处理逻辑与上面稍有不同。

再以总进程数为6为例,数据可以被分发m = log26 = 3次(向上取整),分发原则为:

- 0进程首先分发数据给 0+2(m−1) = 4 进程,令m=m-1=2;

- 0进程剩余的数据分发给 0+2(m−1) = 2 进程; 4进程将从进程0接收的数据分发给 4+2(m−1) = 6 ,但是6进程不存在,因此在4进程内,使用循环一直令m=m-1,直到 4+2(m−1) 进程是存在的,此处需要将m减到1,才满足 4+2(m−1) = 5,5进程存在,所以4进程将数据分给5进程;

- 而0到3这四个进程的数据分配,和上一个例子仅有四个进程的原则一致;

- 无进程可以分配了,则六个进程对各自数据进行快排;

- 最后每个进程将快排的结果传给分配给自己数据的进程 (此处:1给0,3给2,2给0;5给4,4给0,0输出)。

2.2 OpenMP快排并行原理

omp的原理也不难理解,凑出可并行的区域即可,当然也要分析题目,先从理论上判断是否适合多线程并行。

下面代码的思路就是使用omp的sections设置并行域,需要注意的是,设置sections的时候,如果没有添加parallel,表示sections中的几个section是串行执行的;而加上parallel后表示每个section内部是串行的,而section之间是并行的(可以参考文章:OpenMp之sections用法)。

void quickSort(int* data, int start, int end) //并行快排

{

if (start < end) {

int pos = Partition(data, start, end);

#pragma omp parallel sections //设置并行区域

{

#pragma omp section //该区域对前部分数据进行排序

quickSort(data, start, pos - 1);

#pragma omp section //该区域对后部分数据进行排序

quickSort(data, pos + 1, end);

}

}

}

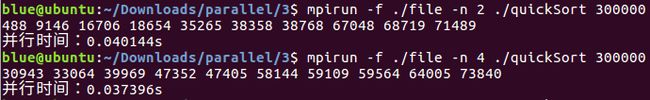

3. 完整代码与结果(含注释)

3.1 MPI

- 代码

#include"mpi.h"

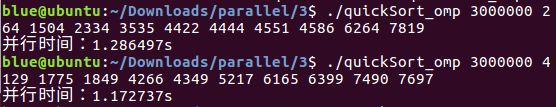

#include3.2 OpenMP

- 代码

#include