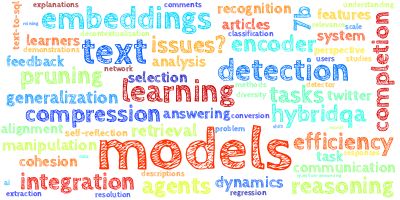

【AI视野·今日NLP 自然语言处理论文速览 第五十二期】Wed, 11 Oct 2023

AI视野·今日CS.NLP 自然语言处理论文速览

Wed, 11 Oct 2023

Totally 81 papers

上期速览✈更多精彩请移步主页

Daily Computation and Language Papers

| LongLLMLingua: Accelerating and Enhancing LLMs in Long Context Scenarios via Prompt Compression Authors Huiqiang Jiang, Qianhui Wu, Xufang Luo, Dongsheng Li, Chin Yew Lin, Yuqing Yang, Lili Qiu 在长上下文场景中,大型语言模型法学硕士面临着三个主要挑战:更高的计算财务成本、更长的延迟和较差的性能。一些研究表明,法学硕士的表现取决于输入提示中相关关键信息问题的密度和位置。受这些发现的启发,我们建议使用 LongLLMLingua 进行快速压缩,以提高法学硕士对关键信息的感知,从而同时应对这三个挑战。我们对各种长上下文场景进行评估,包括单个多文档 QA、少量学习、摘要、合成任务和代码完成。实验结果表明,LongLLMLingua压缩提示可以以更低的成本获得更高的性能。端到端系统的延迟也减少了。例如,在 NaturalQuestions 基准测试中,LongLLMLingua 的性能比原始提示提高了 17.1,并且 GPT 3.5 Turbo 的输入标记数量减少了 4 倍。根据 LongBench 和 ZeroScrolls 基准测试,每 1,000 个样本可分别节省 28.5 和 27.4 的成本。此外,当以 2x 10x 的压缩率压缩 10k token 的提示时,LongLLMLingua 可以将端到端延迟加快 1.4x 3.8x。 |

| Generating and Evaluating Tests for K-12 Students with Language Model Simulations: A Case Study on Sentence Reading Efficiency Authors Eric Zelikman, Wanjing Anya Ma, Jasmine E. Tran, Diyi Yang, Jason D. Yeatman, Nick Haber 开发教育测试可能既昂贵又耗时,因为每个项目都必须由专家编写,然后通过收集数百名学生的回答进行评估。此外,许多测试需要在整个学年中进行多组不同的问题,以密切监控学生的进度,称为并行测试。在这项研究中,我们重点关注无声句子阅读效率的测试,用于评估学生随时间的阅读能力。为了生成高质量的并行测试,我们建议对大型语言模型 LLM 进行微调,以模拟以前的学生对未见过的项目的反应。通过这些模拟响应,我们可以估计每个项目的难度和模糊性。我们首先使用 GPT 4 按照专家制定的规则列表生成新的测试项目,然后应用微调的 LLM 根据心理测量的标准过滤项目。我们还提出了一种用于生成并行测试的最佳传输启发技术,并根据众包响应显示生成的测试与原始测试的难度和可靠性密切对应。 |

| Lemur: Harmonizing Natural Language and Code for Language Agents Authors Yiheng Xu, Hongjin Su, Chen Xing, Boyu Mi, Qian Liu, Weijia Shi, Binyuan Hui, Fan Zhou, Yitao Liu, Tianbao Xie, Zhoujun Cheng, Siheng Zhao, Lingpeng Kong, Bailin Wang, Caiming Xiong, Tao Yu 我们推出了 Lemur 和 Lemur Chat,这是一种针对自然语言和编码功能进行优化的开放访问语言模型,可作为多功能语言代理的支柱。从语言聊天模型到功能性语言代理的演变要求模型不仅要掌握人类交互、推理和规划,还要确保扎根于相关环境。这需要模型中语言和编码能力的和谐结合。 Lemur 和 Lemur Chat 旨在解决这种必要性,展示两个领域的平衡熟练程度,这与现有的倾向于专注于任一领域的开源模型不同。通过使用代码密集型语料库进行细致的预训练以及对文本和代码数据进行指令微调,我们的模型在开源模型中的不同文本和编码基准上实现了最先进的平均性能。全面的实验证明了 Lemur 相对于现有开源模型的优越性,以及它在完全和部分可观察环境下涉及人类通信、工具使用和交互的各种代理任务的熟练程度。 |

| Teaching Language Models to Hallucinate Less with Synthetic Tasks Authors Erik Jones, Hamid Palangi, Clarisse Sim es, Varun Chandrasekaran, Subhabrata Mukherjee, Arindam Mitra, Ahmed Awadallah, Ece Kamar 大型语言模型法学硕士经常对抽象总结任务产生幻觉,例如基于文档的问答、会议总结和临床报告生成,即使所有必要的信息都包含在上下文中。然而,优化法学硕士以减少这些任务中的幻觉具有挑战性,因为幻觉很难在每个优化步骤中有效评估。在这项工作中,我们表明减少合成任务的幻觉也可以减少现实世界下游任务的幻觉。我们的方法 SynTra 首先设计了一个易于引发和测量幻觉的综合任务。接下来,它通过对合成任务进行前缀调整来优化 LLM 的系统消息,最后将系统消息传输到现实的、难以优化的任务。在三个现实的抽象摘要任务中,SynTra 仅使用合成检索任务进行监督,减少了两个 13B 参数 LLM 的幻觉。我们还发现,优化系统消息而不是模型权重可能至关重要,在合成任务上微调整个模型可能会违反直觉地增加幻觉。 |

| Mistral 7B Authors Albert Q. Jiang, Alexandre Sablayrolles, Arthur Mensch, Chris Bamford, Devendra Singh Chaplot, Diego de las Casas, Florian Bressand, Gianna Lengyel, Guillaume Lample, Lucile Saulnier, L lio Renard Lavaud, Marie Anne Lachaux, Pierre Stock, Teven Le Scao, Thibaut Lavril, Thomas Wang, Timoth e Lacroix, William El Sayed 我们推出 Mistral 7B v0.1,这是一个具有 70 亿个参数的语言模型,旨在实现卓越的性能和效率。 Mistral 7B 在所有评估基准中均优于 Llama 2 13B,在推理、数学和代码生成方面优于 Llama 1 34B。我们的模型利用分组查询注意力 GQA 来实现更快的推理,并结合滑动窗口注意力 SWA 来有效处理任意长度的序列,同时降低推理成本。我们还提供了一个经过微调以遵循指令的模型 Mistral 7B Instruct,该模型在人类和自动化基准测试上都超越了 Llama 2 13B Chat 模型。 |

| Text Embeddings Reveal (Almost) As Much As Text Authors John X. Morris, Volodymyr Kuleshov, Vitaly Shmatikov, Alexander M. Rush 文本嵌入揭示了多少关于原始文本的私人信息我们研究了嵌入文本反转的问题,重建以密集文本嵌入表示的全文。我们将问题描述为受控生成生成文本,当重新嵌入时,该文本接近潜在空间中的固定点。我们发现,尽管以嵌入为条件的朴素模型表现不佳,但迭代纠正和重新嵌入文本的多步骤方法能够准确恢复 32 个文本标记文本输入中的 92 个。我们训练我们的模型来解码来自两种最先进的嵌入模型的文本嵌入,并且还表明我们的模型可以从临床笔记数据集中恢复重要的个人信息全名。 |

| Advancing Transformer's Capabilities in Commonsense Reasoning Authors Yu Zhou, Yunqiu Han, Hanyu Zhou, Yulun Wu 通用预训练语言模型的最新进展在常识推理方面显示出了巨大的潜力。然而,当前的工作在包括 Com2Sense 数据集在内的标准常识推理基准上仍然表现不佳。我们认为这是由于与当前最先进的机器学习方法脱节造成的。在这项工作中,我们的目标是通过引入当前基于机器学习的方法来弥补这一差距,以改进常识推理任务中的通用预训练语言模型。具体来说,我们试验并系统地评估了包括知识转移、模型集成和引入额外的成对对比目标在内的方法。 |

| SWE-bench: Can Language Models Resolve Real-World GitHub Issues? Authors Carlos E. Jimenez, John Yang, Alexander Wettig, Shunyu Yao, Kexin Pei, Ofir Press, Karthik Narasimhan 语言模型已经超出了我们有效评估它们的能力,但为了它们未来的发展,研究它们能力的前沿是至关重要的。我们认为现实世界的软件工程是一个丰富的、可持续的、具有挑战性的测试平台,用于评估下一代语言模型。因此,我们引入了 SWE bench,这是一个评估框架,包括来自真实 GitHub 问题的 2,294 个软件工程问题以及跨 12 个流行 Python 存储库的相应拉取请求。给定代码库以及要解决的问题的描述,语言模型的任务是编辑代码库以解决问题。解决 SWE 工作台中的问题通常需要同时理解和协调多个函数、类甚至文件之间的更改,调用模型与执行环境交互,处理极长的上下文并执行远远超出传统代码生成的复杂推理。我们的评估表明,最先进的专有模型和我们的微调模型 SWE Llama 只能解决最简单的问题。即使提供了预言机检索器,Claude 2 和 GPT 4 也分别仅解决了 4.8 和 1.7 个实例。 |

| OmniLingo: Listening- and speaking-based language learning Authors Francis M. Tyers, Nicholas Howell 在这篇演示论文中,我们介绍了 OmniLingo,一种用于为基于听力和口语的语言学习应用程序分发数据的架构,以及使用该架构构建的演示客户端。 |

| TRACE: A Comprehensive Benchmark for Continual Learning in Large Language Models Authors Xiao Wang, Yuansen Zhang, Tianze Chen, Songyang Gao, Senjie Jin, Xianjun Yang, Zhiheng Xi, Rui Zheng, Yicheng Zou, Tao Gui, Qi Zhang, Xuanjing Huang 一致的大语言模型法学硕士在解决任务、遵循指令和确保安全方面表现出卓越的能力。然而,这些一致的法学硕士的持续学习方面在很大程度上被忽视了。现有的持续学习基准缺乏足够的挑战来领导一致的法学硕士,因为它们的简单性和模型在指令调整期间的潜在暴露。在本文中,我们介绍了 TRACE,这是一种旨在评估法学硕士持续学习的新颖基准。 TRACE 由 8 个不同的数据集组成,涵盖具有挑战性的任务,包括特定领域的任务、多语言功能、代码生成和数学推理。所有数据集均标准化为统一格式,可轻松自动评估法学硕士。我们的实验表明,经过 TRACE 培训后,一致的法学硕士在一般能力和指令遵循能力方面都表现出显着下降。例如,在我们的数据集上进行训练后,llama2 chat 13B 在 gsm8k 数据集上的准确率从 28.8 急剧下降到 2。这凸显了在实现特定任务的绩效与保留法学硕士原有实力之间找到适当权衡的挑战。实证研究结果表明,本质上配备推理路径的任务对于保持法学硕士的某些能力免受潜在下降的影响非常重要。受此启发,我们引入了推理增强持续学习 RCL 方法。 |

| Quality Control at Your Fingertips: Quality-Aware Translation Models Authors Christian Tomani, David Vilar, Markus Freitag, Colin Cherry, Subhajit Naskar, Mara Finkelstein, Daniel Cremers 最大后验 MAP 解码是神经机器翻译 NMT 模型中使用最广泛的解码策略。基本假设是模型概率与人类判断密切相关,更好的翻译更有可能。然而,研究表明,这种假设并不总是成立,直接优化效用函数的解码策略(例如最小贝叶斯风险 MBR 或质量感知解码)可以比标准 MAP 解码显着提高翻译质量。这些方法的主要缺点是它们需要额外的模型来预测效用,并且在解码过程中需要额外的步骤,这使得整个过程的计算量要求很高。在本文中,我们建议通过训练 NMT 模型来估计其自身输出的质量,从而使 NMT 模型本身具有质量意识。在解码过程中,我们可以使用模型自身的质量估计来指导生成过程并产生尽可能最高质量的翻译。我们证明该模型可以在翻译过程中自我评估自己的输出,从而无需单独的质量估计模型。此外,我们还表明,在 MAP 解码过程中使用此质量信号作为提示可以显着提高翻译质量。 |

| Temporally Aligning Long Audio Interviews with Questions: A Case Study in Multimodal Data Integration Authors Piyush Singh Pasi, Karthikeya Battepati, Preethi Jyothi, Ganesh Ramakrishnan, Tanmay Mahapatra, Manoj Singh 音频到文本对齐的问题已经在训练期间使用完整的监督进行了大量的研究。然而,这通常不是在长音频记录的情况下,其中被查询的文本不会逐字出现在音频文件中。这项工作是与一个名为 CARE India 的非政府组织合作进行的,该组织收集居住在印度比哈尔邦农村地区的年轻母亲的长音频健康调查。给定从用于指导这些调查的调查问卷中提取的问题,我们的目标是在长录音中找到问题的提出位置。这对于非洲和亚洲组织来说非常有价值,否则它们将不得不费力地通过漫长而嘈杂的录音来找到感兴趣的问题和答案。我们提出的框架 INDENT 使用基于交叉注意力的模型和有关句子时间顺序的先验信息来学习捕获底层口语文本语义的语音嵌入。这些学习到的嵌入用于在推理时根据文本查询检索相应的音频片段。我们凭经验证明,与使用基于文本的启发式方法获得的模型相比,我们的模型的 R avg 的有效性显着提高了约 3 个。我们还展示了使用最先进的印度语言 ASR 模型生成的嘈杂 ASR 在代替语音时如何产生更好的结果。仅接受印地语数据训练的 INDENT 能够满足语义共享文本空间支持的所有语言。 |

| Sheared LLaMA: Accelerating Language Model Pre-training via Structured Pruning Authors Mengzhou Xia, Tianyu Gao, Zhiyuan Zeng, Danqi Chen LLaMA Touvron et al., 2023a b 和其他最近出现的中等规模的大型语言模型 LLM 的流行凸显了构建更小但更强大的 LLM 的潜力。无论如何,在数万亿代币上从头开始训练此类模型的成本仍然很高。在这项工作中,我们研究结构化剪枝作为从预先训练的较大模型开发较小的法学硕士的有效手段。我们的方法采用了两项关键技术:1 有针对性的结构化修剪,通过以端到端的方式删除层、头部以及中间和隐藏维度,将较大的模型修剪为指定的目标形状;2 动态批量加载,动态更新组合每个训练批次中的采样数据基于不同领域的不同损失。我们通过展示剪切 LLaMA 系列、将 LLaMA2 7B 模型修剪至 1.3B 和 2.7B 参数来证明我们方法的有效性。在广泛的下游和指令调优评估中,剪切 LLaMA 模型的性能优于同等大小的最先进的开源模型,例如 Pythia、INCITE 和 OpenLLaMA 模型,而与从头开始训练此类模型相比,仅需要 3 次计算。 |

| Meta-CoT: Generalizable Chain-of-Thought Prompting in Mixed-task Scenarios with Large Language Models Authors Anni Zou, Zhuosheng Zhang, Hai Zhao, Xiangru Tang 大型语言模型法学硕士通过利用思想链 CoT 提示展现了卓越的推理能力,它生成中间推理链作为推导答案的基本原理。然而,当前的 CoT 方法要么简单地采用通用提示,例如“让我们一步一步思考”,要么严重依赖手工制作的特定任务演示来获得更好的性能,从而在性能和泛化之间产生了不可避免的差距。为了弥补这一差距,我们提出了 Meta CoT,这是一种在输入问题类型未知的混合任务场景中通用的 CoT 提示方法。 Meta CoT 首先根据输入问题对场景进行分类,然后以自动模式从相应的数据池中构建各种演示。 Meta CoT在十个公共基准推理任务上同时享有出色的表现和卓越的泛化能力。值得注意的是,Meta CoT 在 SVAMP 93.7 上实现了最先进的结果,无需任何额外的程序辅助方法。 |

| Learning Multiplex Embeddings on Text-rich Networks with One Text Encoder Authors Bowen Jin, Wentao Zhang, Yu Zhang, Yu Meng, Han Zhao, Jiawei Han 在现实场景中,网络中的文本通常通过多种语义关系链接,例如,学术网络中的论文被其他出版物引用,由同一作者撰写,或在同一地点发表,其中文本文档及其关系形成一个语义关系。多路文本丰富网络。主流的文本表示学习方法使用预训练的语言模型 PLM 为每个文本单元生成一个嵌入,期望这些单视图嵌入可以捕获文本之间的所有类型的关系。然而,这种假设在多路文本丰富网络中并不特别成立。另一方面,多重图神经网络 GNN 直接将节点属性初始化为节点表示学习的特征向量,但它们无法完全捕获节点关联文本的语义。为了弥补这些差距,我们提出了 METERN,一个用于在 TExt Rich Networks 上学习多重嵌入的新框架。与现有方法相比,METERN 使用一个文本编码器对跨关系的共享知识进行建模,并利用每个关系的少量参数来派生关系特定的表示。这使得编码器能够有效地捕获网络中的复用结构,同时还保持参数效率。我们对来自学术和电子商务领域的五个网络中的九个下游任务进行了实验,其中 METERN 的表现显着且一致地优于基线。 |

| SEER: A Knapsack approach to Exemplar Selection for In-Context HybridQA Authors Jonathan Tonglet, Manon Reusens, Philipp Borchert, Bart Baesens 在混合上下文中回答问题是一项复杂的任务,需要以各种方式组合从非结构化文本和结构化表格中提取的信息。最近,情境学习展示了推理任务的显着性能进步。在这种范式中,大型语言模型基于一小组支持范例执行预测。上下文学习的性能在很大程度上取决于支持样本的选择过程,特别是在 HybridQA 的情况下,考虑推理链的多样性和混合上下文的大尺寸变得至关重要。在这项工作中,我们提出了混合推理 SEER 的 ExEmplars 选择,这是一种选择一组具有代表性和多样性的示例的新方法。 SEER 的主要新颖之处在于它将样本选择制定为背包整数线性规划。 Knapsack 框架提供了灵活性,可以合并多样性约束(优先考虑具有所需属性的示例)和容量约束(确保即时大小符合所提供的容量预算)。 |

| Making Large Language Models Perform Better in Knowledge Graph Completion Authors Yichi Zhang, Zhuo Chen, Wen Zhang, Huajun Chen 基于LLM的大语言模型知识图补全KGC旨在利用LLM预测知识图谱中缺失的三元组,并丰富知识图谱,使其成为更好的网络基础设施,这可以使许多基于网络的自动化服务受益。然而,基于LLM的KGC研究有限,缺乏对LLM推理能力的有效利用,忽略了KG中的重要结构信息,阻碍了LLM获取准确的事实知识。在本文中,我们讨论如何将有用的知识图谱结构信息融入到法学硕士中,旨在实现法学硕士中的结构感知推理。我们首先将现有的 LLM 范例转移到结构感知设置,并进一步提出一个知识前缀适配器 KoPA 来实现这一既定目标。 KoPA 采用结构嵌入预训练来捕获知识图谱中实体和关系的结构信息。然后,KoPA 通知 LLM 知识前缀适配器,该适配器将结构嵌入投影到文本空间中,并获取虚拟知识标记作为输入提示的前缀。我们对这些基于结构感知的 LLM 的 KGC 方法进行了全面的实验,并提供了深入的分析,比较了结构信息的引入如何更好地提高 LLM 的知识推理能力。 |

| Unlock the Potential of Counterfactually-Augmented Data in Out-Of-Distribution Generalization Authors Caoyun Fan, Wenqing Chen, Jidong Tian, Yitian Li, Hao He, Yaohui Jin 反事实增强数据 CAD 对句子进行最小编辑以翻转相应的标签,有可能提高语言模型的分布外 OOD 泛化能力,因为 CAD 诱导语言模型利用与领域无关的因果特征并排除虚假相关性。然而,CAD OOD 泛化的实证结果并不像预期的那么有效。在本研究中,我们将效率低下归因于CAD语言模型仅关注增强操作中编辑的因果特征而排除其他未编辑的因果特征而导致的近视现象。因此,CAD的潜力没有得到充分发挥。针对这个问题,我们从Fisher线性判别的角度分析特征空间中的近视现象,然后基于CAD的结构属性数据集级别和句子级别引入两个额外的约束,以帮助语言模型提取CAD中更完整的因果特征,从而减轻近视现象并提高OOD泛化能力。 |

| What If the TV Was Off? Examining Counterfactual Reasoning Abilities of Multi-modal Language Models Authors Letian Zhang, Xiaotong Zhai, Zhongkai Zhao, Xin Wen, Yongshuo Zong, Bingchen Zhao 反事实推理能力是人类智力的核心能力之一。这个推理过程涉及对观察到的状态或过去事件的替代方案的处理,这个过程可以提高我们的计划和决策能力。在这项工作中,我们专注于对多模态大语言模型的反事实推理能力进行基准测试。我们从 VQAv2 数据集中获取问题和答案对,并向问题添加一个反事实预设,并对答案进行相应修改。使用 ChatGPT 生成反事实问题和答案后,我们手动检查所有生成的问题和答案以确保正确性。通过这种方式收集了超过 2k 个反事实问题和答案对。我们在新收集的测试数据集上评估了最新的视觉语言模型,发现与在没有反事实预设的问题上测试的结果相比,所有模型都表现出很大的性能下降。这一结果表明视觉语言模型仍然存在发展空间。除了视觉语言模型之外,我们提出的数据集还可以作为评估代码生成LLM能力的基准,结果表明GPT 4与当前开源模型之间存在巨大差距。 |

| Topic-DPR: Topic-based Prompts for Dense Passage Retrieval Authors Qingfa Xiao, Shuangyin Li, Lei Chen 基于提示的学习在众多自然语言处理任务中的功效使其集成到密集段落检索中。先前的研究主要集中在通过优化单个向量作为连续提示来增强预训练语言模型的语义理解。然而,这种方法导致语义空间崩溃,相同的语义信息渗透到所有表示中,导致它们的分布收敛在受限区域中。这阻碍了密集检索期间区分相关和不相关的段落。为了解决这个问题,我们提出了 Topic DPR,这是一种使用基于主题的提示的密集段落检索模型。与单一提示方法不同,多个基于主题的提示是在概率单纯形上建立的,并通过对比学习同时优化。这鼓励表示与其主题分布保持一致,从而提高空间均匀性。此外,我们引入了一种新颖的正负采样策略,利用半结构化数据来提高密集检索效率。 |

| No Pitch Left Behind: Addressing Gender Unbalance in Automatic Speech Recognition through Pitch Manipulation Authors Dennis Fucci, Marco Gaido, Matteo Negri, Mauro Cettolo, Luisa Bentivogli 众所周知,自动语音识别 ASR 系统对语音数据的社会语言变异非常敏感,其中性别起着至关重要的作用。这可能会导致男性和女性说话者之间的识别准确性存在差异,这主要是由于训练数据中后者的代表性不足。虽然在混合 ASR 模型的背景下已经提出了几种解决方案,但性别偏见问题尚未在端到端神经架构中得到明确解决。为了填补这一空白,我们提出了一种数据增强技术来操纵基频 f0 和共振峰。该技术通过模拟代表性不足的女性说话者的声音来减少性别之间的数据不平衡,并增加每个性别组内的变异性。 |

| FTFT: efficient and robust Fine-Tuning by transFerring Training dynamics Authors Yupei Du, Albert Gatt, Dong Nguyen 尽管在各种自然语言处理 NLP 任务上微调大型预训练语言模型 PLM 取得了巨大成功,但它们仍然容易受到分布外 OOD 和对抗性输入的影响。数据映射DM是一种简单而有效的双模型方法,可增强微调PLM的鲁棒性,其中涉及在原始训练集(即参考模型)上微调模型,根据PLM的训练动态选择重要训练示例的指定部分。参考模型,并在这些选定的示例(即主模型)上微调相同的模型。然而,它的缺点是需要对同一模型进行两次微调,这对于大型模型来说计算成本很高。在本文中,我们首先表明 1 训练动态在不同模型大小和不同预训练方法之间具有高度可移植性,并且使用 DM 微调的 2 个主要模型比使用传统经验风险最小化 ERM 学习得更快。基于这些观察,我们提出了一种基于 DM 方法的新颖微调方法,通过 transFerring 训练动态 FTFT 进行微调。与 DM 相比,FTFT 使用更高效的参考模型,然后以更少的步骤微调更强大的主模型。 |

| On Temporal References in Emergent Communication Authors Olaf Lipinski, Adam J. Sobey, Federico Cerutti, Timothy J. Norman 作为人类,我们使用引用时间的语言元素(例如之前或明天)来轻松分享过去的经历和未来的预测。虽然计算语言学已经考虑了语言的时间方面,但在新兴交流领域还没有进行过这样的探索。我们研究了这一差距,提供了新兴传播文献中第一个报道的时间词汇。我们的实验分析表明,不同的代理架构足以实现时间参考的自然出现,并且不需要额外的损失。 |

| Rationale-Enhanced Language Models are Better Continual Relation Learners Authors Weimin Xiong, Yifan Song, Peiyi Wang, Sujian Li 持续关系提取 CRE 旨在解决学习一系列新出现的关系时出现的灾难性遗忘问题。最近的 CRE 研究发现,灾难性遗忘是由于模型缺乏针对未来类似关系的稳健性而产生的。为了解决这个问题,我们将基本原理,即大型语言模型 LLM 生成的关系分类结果的解释引入到 CRE 任务中。具体来说,我们设计了多任务基本原理调整策略来帮助模型稳健地学习当前关系。我们还进行对比原理重播,以进一步区分类似关系。 |

| A Novel Contrastive Learning Method for Clickbait Detection on RoCliCo: A Romanian Clickbait Corpus of News Articles Authors Daria Mihaela Broscoteanu, Radu Tudor Ionescu 为了增加收入,新闻网站经常使用欺骗性的新闻标题,引诱用户点击标题并阅读完整的新闻。点击诱饵检测是旨在自动检测这种形式的虚假广告并避免浪费在线用户的宝贵时间的任务。尽管这项任务很重要,但据我们所知,罗马尼亚语还没有公开的点击诱饵语料库。为此,我们引入了一种新颖的罗马尼亚点击诱饵语料库 RoCliCo,其中包含 8,313 个新闻样本,这些样本均使用点击诱饵和非点击诱饵标签手动注释。此外,我们使用四种机器学习方法进行实验,从手工模型到基于循环和变压器的神经网络,以建立一系列竞争基线。我们还使用加权投票集合进行了实验。在考虑的基线中,我们提出了一种新颖的基于 BERT 的对比学习模型,该模型学习将新闻标题和内容编码到深度度量空间中,使得非点击诱饵新闻的标题和内容具有较高的余弦相似度,而点击诱饵新闻的标题和内容具有较低的余弦相似度。余弦相似度。 |

| EmoTwiCS: A Corpus for Modelling Emotion Trajectories in Dutch Customer Service Dialogues on Twitter Authors Sofie Labat, Thomas Demeester, V ronique Hoste 由于用户生成内容的兴起,社交媒体越来越多地被用作提供客户服务的渠道。鉴于这些在线平台的公共特征,情绪的自动检测形成了监控客户满意度和防止负面口碑的重要应用。本文介绍了 EmoTwiCS,这是 Twitter 上 9,489 条荷兰语客户服务对话的语料库,这些对话带有情绪轨迹注释。在我们面向业务的语料库中,我们将情绪视为客户的动态属性,可以在对话的每句话中发生变化。因此,术语“情绪轨迹”不仅指用 28 个标签和价唤醒优势分数标注的客户体验到的细粒度情绪,而且还指对话之前发生的事件和操作人员做出的反应,均用 8 个类别标注。注释者间对所得数据集的 IAA 评分非常高,并且与相关研究具有可比性,强调了其高质量。考虑到不同层注释信息之间的相互作用,我们进行了多项深入分析,以研究 i 孤立推文中的静态情绪、ii 动态情绪及其轨迹变化,以及 iii 原因和响应策略在情绪轨迹中的作用。最后,我们列出了数据集的优点和局限性,然后我们就不同类型的预测建模任务和可应用 EmoTwiCS 的开放研究问题提出了一些建议。 |

| Evaluation of ChatGPT Feedback on ELL Writers' Coherence and Cohesion Authors Su Youn Yoon, Eva Miszoglad, Lisa R. Pierce 自 2022 年 11 月推出以来,ChatGPT 对教育产生了变革性影响,学生使用它来帮助完成家庭作业,教师也在教学实践中积极使用它。这包括使用 ChatGPT 作为写作工具,教师可以对学生的论文进行评分并生成反馈。在这项研究中,我们评估了 ChatGPT 生成的关于英语语言学习者 ELL 学生所写论文的连贯性和凝聚力的反馈质量。我们选择了 50 篇议论文,并使用 ELLIPSE 标题生成有关连贯性和凝聚力的反馈。在反馈评估过程中,我们首先使用两步法,反馈中的每个句子根据其功能分为子类型,例如积极强化、问题陈述。接下来,我们根据这些类型评估其准确性和可用性。无论是对反馈类型的分析,还是对准确性和可用性的评估,都发现大多数反馈语句高度抽象和笼统,未能提供具体的改进建议。检测主要问题(例如重复的想法和衔接手段的不准确使用)的准确性取决于表面的语言特征,并且常常是错误的。 |

| Revisit Input Perturbation Problems for LLMs: A Unified Robustness Evaluation Framework for Noisy Slot Filling Task Authors Guanting Dong, Jinxu Zhao, Tingfeng Hui, Daichi Guo, Wenlong Wan, Boqi Feng, Yueyan Qiu, Zhuoma Gongque, Keqing He, Zechen Wang, Weiran Xu 随着大型语言模型 LLM 的能力不断增强,这些高性能模型在广泛的自然语言处理 NLP 任务上取得了最先进的结果。然而,当应用于现实世界的噪声数据时,常用基准数据集上的模型性能通常无法准确反映其可靠性和鲁棒性。为了应对这些挑战,我们提出了一个基于槽填充任务的统一鲁棒性评估框架,以系统地评估法学硕士在不同输入扰动场景下的对话理解能力。具体来说,我们构建了一个输入扰动评估数据集Noise LLM,其中包含五种类型的单一扰动数据和四种类型的混合扰动数据。此外,我们利用多级数据增强方法在字符、单词和句子级别构建候选数据池,并精心设计了实例级和实体级两种自动任务演示构建策略以及各种提示模板。我们的目的是评估法学硕士的各种鲁棒性方法在现实世界的噪声场景中的表现如何。实验表明,当前的开源法学硕士通常只能实现有限的扰动鲁棒性性能。 |

| The Limits of ChatGPT in Extracting Aspect-Category-Opinion-Sentiment Quadruples: A Comparative Analysis Authors Xiancai Xu, Jia Dong Zhang, Rongchang Xiao, Lei Xiong 近年来,ChatGPT因其在自然语言理解和生成方面令人惊叹的能力而受到工业界和学术界的高度关注。我们特别好奇它是否能够在基于方面的情感分析中最复杂的任务之一上取得有希望的性能,即从文本中提取方面类别意见情感四倍。为此,在本文中,我们开发了一个专门的提示模板,使 ChatGPT 能够有效地解决这个复杂的四元组提取任务。此外,我们提出了一种针对少数镜头示例的选择方法,以充分利用 ChatGPT 的上下文学习能力,并提高其在这一复杂任务上的有效性。 |

| A New Benchmark and Reverse Validation Method for Passage-level Hallucination Detection Authors Shiping Yang, Renliang Sun, Xiaojun Wan 大型语言模型法学硕士已经证明了他们在现实世界场景中与人类有效协作的能力。然而,法学硕士很容易产生幻觉,即编造不正确的文本和未经验证的信息,这在部署关键任务时可能会造成重大损害。在本文中,我们提出了一种基于反向验证的自检方法,以零资源方式自动检测事实错误。为了促进未来的研究和评估不同的方法,我们构建了一个幻觉检测基准,该基准由 ChatGPT 生成并由人类注释者注释。与之前零资源幻觉检测的研究相比,我们的方法和基准集中于段落级别检测而不是句子级别。我们在不同的基准域上对我们的方法和现有的零资源检测方法进行实证评估,以探索幻觉和训练数据之间的隐含关系。 |

| Multilingual Jailbreak Challenges in Large Language Models Authors Yue Deng, Wenxuan Zhang, Sinno Jialin Pan, Lidong Bing 虽然大型语言模型 LLM 在广泛的任务中表现出卓越的能力,但它们也带来了潜在的安全问题,例如越狱问题,其中恶意指令可以操纵 LLM 表现出不良行为。尽管已经制定了一些预防措施来减轻与法学硕士相关的潜在风险,但它们主要集中在英语数据上。在这项研究中,我们揭示了法学硕士中存在的多语言越狱挑战,并考虑了无意和有意的两种潜在风险场景。无意识场景是用户使用非英文提示查询LLM,无意中绕过了安全机制;而故意场景是恶意用户将恶意指令与多语言提示结合起来故意攻击LLM。实验结果表明,在无意的情况下,不安全内容的比例随着语言可用性的下降而增加。具体来说,在 ChatGPT 和 GPT 4 中,低资源语言遇到有害内容的可能性是高资源语言的三倍。在有意的情况下,多语言提示会加剧恶意指令的负面影响,不安全输出的比率高得惊人ChatGPT 为 80.92,GPT 4 为 40.71。为了应对多语言环境中的此类挑战,我们提出了一种新颖的 textsc 自防御框架,该框架可自动生成多语言训练数据以进行安全微调。实验结果表明,利用此类数据进行微调的 ChatGPT 可以实现不安全内容生成的大幅减少。 |

| Cultural Compass: Predicting Transfer Learning Success in Offensive Language Detection with Cultural Features Authors Li Zhou, Antonia Karamolegkou, Wenyu Chen, Daniel Hershcovich 语言技术的日益普及使得机器学习领域需要转向考虑文化多样性,特别是对于严重依赖文化细微差别的主观任务,例如攻击性语言检测 OLD。目前的理解强调,这些任务在很大程度上受到文化价值观的影响,然而,在确定文化特征是否可以准确预测此类主观任务的跨文化迁移学习的成功方面存在显着的差距。为了解决这个问题,我们的研究深入研究了文化特征和迁移学习有效性的交叉点。研究结果表明,文化价值调查确实具有预测旧任务中跨文化迁移学习成功的能力,并且可以使用攻击性词距离进一步改进。基于这些结果,我们主张将文化信息整合到数据集中。此外,我们建议利用调查等富含文化信息的数据源来增强文化适应性。 |

| Constructive Large Language Models Alignment with Diverse Feedback Authors Tianshu Yu, Ting En Lin, Yuchuan Wu, Min Yang, Fei Huang, Yongbin Li 在最近对大型语言模型法学硕士的研究中,人们越来越重视使这些模型与人类价值观保持一致,以减少有害内容的影响。然而,当前的对齐方法通常仅依赖于单一形式的人类反馈,例如偏好、带注释的标签或自然语言评论,而忽视了组合这些反馈类型的潜在优势。即使有足够的训练数据可用,这种限制也会导致性能不佳。在本文中,受建构主义学习理论的启发,我们引入了建设性和多样化反馈 CDF 作为一种增强 LLM 一致性的新方法。我们的方法涉及收集针对训练数据集中不同难度级别的问题量身定制的三种不同类型的反馈。具体来说,我们利用针对简单问题的批评反馈、针对中等问题的细化反馈以及针对困难问题的偏好反馈。通过使用这种多样化的反馈来训练我们的模型,我们在使用更少的训练数据的同时实现了增强的对齐性能。为了评估 CDF 的有效性,我们在三个下游任务问答、对话生成和文本摘要中对照之前的方法对其进行了评估。 |

| MemSum-DQA: Adapting An Efficient Long Document Extractive Summarizer for Document Question Answering Authors Nianlong Gu, Yingqiang Gao, Richard H. R. Hahnloser 我们引入 MemSum DQA,这是一种用于文档问答 DQA 的高效系统,它利用 MemSum(一种长文档提取摘要器)。通过使用提供的问题和问题类型为解析文档中的每个文本块添加前缀,MemSum DQA 有选择地从文档中提取文本块作为答案。在完整文档回答任务中,与现有技术基线相比,该方法的精确匹配精度提高了 9 倍。 |

| Whispering LLaMA: A Cross-Modal Generative Error Correction Framework for Speech Recognition Authors Srijith Radhakrishnan, Chao Han Huck Yang, Sumeer Ahmad Khan, Rohit Kumar, Narsis A. Kiani, David Gomez Cabrero, Jesper N. Tegner 我们引入了一种新的跨模态融合技术,专为自动语音识别 ASR 中的生成错误校正而设计。我们的方法利用声学信息和外部语言表示来生成准确的语音转录上下文。这标志着在 n 个最佳假设领域内,朝着生成错误校正的新范式迈出了一步。与现有的基于排名的重新评分方法不同,我们的方法巧妙地使用不同的初始化技术和参数有效算法来提高从预训练的语音和文本模型得出的 ASR 性能。通过对不同 ASR 数据集的评估,我们评估了融合技术的稳定性和再现性,证明了与 n 个最佳假设相比,其字错误率相对 WERR 性能提高了 37.66 。 |

| Large Language Models for Propaganda Detection Authors Kilian Sprenkamp, Daniel Gordon Jones, Liudmila Zavolokina 数字社会中宣传的盛行对社会和谐和真理的传播提出了挑战。由于微妙的操纵技术和上下文依赖性,通过 NLP 检测文本中的宣传具有挑战性。为了解决这个问题,我们研究了现代大型语言模型 LLM(例如 GPT 3 和 GPT 4)在宣传检测方面的有效性。我们使用 SemEval 2020 任务 11 数据集进行实验,该数据集以使用 14 种宣传技术标记的新闻文章为多标签分类问题。采用了 GPT 3 和 GPT 4 的五种变体,结合了不同模型的各种即时工程和微调策略。我们通过评估 F1 分数、精度和召回率等指标来评估模型性能,并将结果与使用 RoBERTa 的当前最先进方法进行比较。我们的研究结果表明,GPT 4 取得了与当前最先进技术相当的结果。 |

| Humans and language models diverge when predicting repeating text Authors Aditya R. Vaidya, Javier Turek, Alexander G. Huth 事实证明,针对下一个单词预测任务训练的语言模型可以准确地模拟人类在单词预测和阅读速度方面的行为。与这些发现相反,我们提出了一个场景,其中人类和 LM 的表现存在差异。我们收集了人类对通过重复文本跨度形成的五种刺激的下一个单词预测的数据集。人类和 GPT 2 LM 预测在文本范围的第一次呈现中非常一致,但当记忆或上下文学习开始发挥作用时,它们的性能很快就会出现分歧。我们将这种分歧的原因追溯到中间层的特定注意力头。在这些注意力头中添加幂律新近偏差,产生了一个与人类表现更加相似的模型。 |

| Hexa: Self-Improving for Knowledge-Grounded Dialogue System Authors Daejin Jo, Daniel Wontae Nam, Gunsoo Han, Kyoung Woon On, Taehwan Kwon, Seungeun Rho, Sungwoong Kim 基于知识的对话生成的常见做法是明确利用中间步骤,例如网络搜索、模块化方法的记忆检索。然而,与对话响应的数据相比,此类步骤的数据通常难以访问,因为它们在普通对话中无法观察到。为了填补这些数据的缺失,我们开发了一种自我改进的方法来提高中间步骤的生成性能,而无需地面实况数据。特别是,我们提出了一种新颖的引导方案,具有引导提示和修改后的损失函数,以增强适当的自生成响应的多样性。 |

| P5: Plug-and-Play Persona Prompting for Personalized Response Selection Authors Joosung Lee, Minsik Oh, Donghun Lee 使用基于角色的检索聊天机器人对于个性化对话至关重要,但有几个挑战需要解决。 1 一般来说,收集基于角色的语料库非常昂贵。 2 聊天机器人系统并不总是考虑实际应用中的角色进行响应。为了解决这些挑战,我们提出了一种即插即用的角色提示方法。如果角色信息不可用,我们的系统可以充当标准的开放域聊天机器人。我们证明这种方法在零样本设置中表现良好,这减少了对角色基础训练数据的依赖。这使得将系统扩展到其他语言变得更容易,而无需构建基于角色的语料库。此外,我们的模型可以进行微调以获得更好的性能。在我们的实验中,零样本模型在原始角色和修改后的角色中分别将标准模型提高了 7.71 点和 1.04 点。微调后的模型在原始角色和修改后的角色中分别将之前的最先进系统提高了 1.95 点和 3.39 点。据我们所知,这是使用提示序列解决个性化响应选择问题的首次尝试。 |

| Rethinking Model Selection and Decoding for Keyphrase Generation with Pre-trained Sequence-to-Sequence Models Authors Di Wu, Wasi Uddin Ahmad, Kai Wei Chang 关键词生成 KPG 是 NLP 中一项长期存在的任务,有着广泛的应用。序列到序列 seq2seq 预训练语言模型 PLM 的出现为 KPG 带来了一个变革时代,带来了有希望的性能改进。然而,许多设计决策仍未经过探索,并且常常是任意做出的。本文系统分析了模型选择和解码策略对基于PLM的KPG的影响。我们首先阐明为什么 seq2seq PLM 适合 KPG,以注意力驱动假设为基础。然后,我们确定选择 seq2seq PLM 的传统智慧缺乏深度 1 仅增加模型大小或执行特定于任务的自适应并不是参数有效的 2 尽管将域预训练与任务自适应相结合有利于 KPG,但它确实部分阻碍了泛化。关于解码,我们证明虽然贪婪搜索提供了很强的 F1 分数,但与基于采样的方法相比,它在召回率方面落后。根据我们的见解,我们提出了 DeSel,一种基于可能性的解码选择算法,可在五个数据集上将贪婪搜索平均提高 4.7 语义 F1。 |

| Multi-Modal Knowledge Graph Transformer Framework for Multi-Modal Entity Alignment Authors Qian Li, Cheng Ji, Shu Guo, Zhaoji Liang, Lihong Wang, Jianxin Li 多模态实体对齐 MMEA 是一项关键任务,旨在跨多模态知识图 MMKG 识别等效实体对。然而,由于存在不同类型的信息,包括相邻实体、多模态属性和实体类型,该任务面临挑战。直接合并上述信息(例如串联或注意力)可能会导致信息空间不对齐。为了解决这些挑战,我们提出了一种新颖的 MMEA 转换器,称为 MoAlign,它分层引入邻居特征、多模态属性和实体类型来增强对齐任务。利用 Transformer 更好地集成多个信息的能力,我们在 Transformer 编码器中设计了一个分层的可修改自注意力块,以保留不同信息的独特语义。此外,我们设计了两种实体类型前缀注入方法来使用类型前缀集成实体类型信息,这有助于限制 MMKG 中不存在的实体的全局信息。 |

| InfoCL: Alleviating Catastrophic Forgetting in Continual Text Classification from An Information Theoretic Perspective Authors Yifan Song, Peiyi Wang, Weimin Xiong, Dawei Zhu, Tianyu Liu, Zhifang Sui, Sujian Li 持续学习 CL 的目标是随着时间的推移不断学习新知识,同时避免对旧任务的灾难性遗忘。我们专注于类增量设置下的连续文本分类。最近的 CL 研究发现,类似类别的成绩严重下降是灾难性遗忘的一个关键因素。在本文中,通过对CL中的表示学习过程的深入探索,我们发现信息瓶颈的压缩效应导致了类似类的混乱。为了使模型能够学习更充分的表示,我们提出了一种新颖的基于重播的连续文本分类方法 InfoCL。我们的方法利用快慢和当前过去的对比学习来执行互信息最大化并更好地恢复先前学习的表示。此外,InfoCL还采用了对抗性记忆增强策略来缓解重放的过拟合问题。实验结果表明,InfoCL 有效地减少了遗忘,并在三个文本分类任务上实现了最先进的性能。 |

| Selective Demonstrations for Cross-domain Text-to-SQL Authors Shuaichen Chang, Eric Fosler Lussier 具有上下文学习功能的大型语言模型法学硕士在跨域文本到 SQL 任务中展示了令人印象深刻的泛化能力,而无需使用域内注释。然而,事实证明,纳入领域演示示例可以极大地提高法学硕士的表现。在本文中,我们深入研究了领域示例中有助于改进的关键因素,并探讨了我们是否可以在不依赖领域注释的情况下利用这些好处。根据我们的发现,我们提出了一个演示选择框架 ODIS,它利用域外示例和域内示例综合生成来构建演示。通过从混合来源检索演示,ODIS 充分利用了两者的优势,与依赖单一数据源的基线方法相比,展示了其有效性。 |

| Let Models Speak Ciphers: Multiagent Debate through Embeddings Authors Chau Pham, Boyi Liu, Yingxiang Yang, Zhengyu Chen, Tianyi Liu, Jianbo Yuan, Bryan A. Plummer, Zhaoran Wang, Hongxia Yang 大语言模型法学硕士之间的讨论和辩论因其增强法学硕士推理能力的潜力而受到广泛关注。尽管由于 LLM 的语言理解能力,自然语言是交流的明显选择,但生成自然语言时所需的令牌采样步骤会带来潜在的信息丢失风险,因为它仅使用一个令牌来表示模型对整个词汇表的信念。在本文中,我们引入了一种名为“CIPHER Communicative Inter Model Protocol Through Embedding Representation”的通信机制来解决这个问题。具体来说,我们从 LLM 中删除了令牌采样步骤,并让他们通过原始变压器输出嵌入的期望在词汇表上传达他们的信念。值得注意的是,通过偏离自然语言,CIPHER 提供了编码更广泛信息的优势,而无需对模型权重进行任何修改。虽然使用自然语言的最先进的 LLM 辩论方法比传统推理领先 1.5 8 ,但我们的实验结果表明,CIPHER 辩论在五个推理任务和不同规模的多个开源 LLM 中进一步将这一领先优势扩大了 1 3.5 。 |

| Towards Mitigating Hallucination in Large Language Models via Self-Reflection Authors Ziwei Ji, Tiezheng Yu, Yan Xu, Nayeon Lee, Etsuko Ishii, Pascale Fung 大型语言模型法学硕士已显示出在生成和知识密集型任务(包括问答 QA 任务)方面的前景。然而,实际部署仍然面临挑战,特别是幻觉问题,即模型生成听起来合理但不忠实或无意义的信息。由于专业理念的不共通性和潜在的社会风险,这个问题在医疗领域显得尤为重要。本文使用广泛采用的法学硕士和数据集分析了医学生成问答系统中的幻觉现象。我们的调查重点是识别和理解常见问题答案,特别强调幻觉。为了应对这一挑战,我们提出了一种交互式自我反思方法,其中包含知识获取和答案生成。通过这个反馈过程,我们的方法稳步提高了生成答案的真实性、一致性和内涵。因此,我们利用法学硕士的互动性和多任务处理能力,并逐渐产生更加精确和准确的答案。 |

| Get the gist? Using large language models for few-shot decontextualization Authors Benjamin Kane, Lenhart Schubert 在许多涉及在丰富上下文中解释句子的 NLP 应用中,例如信息检索系统或对话系统,希望能够以无需上下文即可轻松理解的形式保留句子,以便以后重用称为去上下文化的过程。虽然之前的工作表明,生成式 Seq2Seq 模型在对特定数据集进行微调后可以有效地执行去上下文化,但这种方法需要昂贵的人工注释,并且可能无法转移到其他领域。 |

| Model Tuning or Prompt Tuning? A Study of Large Language Models for Clinical Concept and Relation Extraction Authors Cheng Peng, Xi Yang, Kaleb E Smith, Zehao Yu, Aokun Chen, Jiang Bian, Yonghui Wu 目的 为大型语言模型法学硕士开发基于软提示的学习算法,检查提示的形状、使用冻结未冻结法学硕士的提示调整、迁移学习和少量学习能力。方法 我们开发了一个基于软提示的 LLM 模型,并比较了 4 种训练策略,包括 1 无提示微调 2 未冻结 LLM 的硬提示 3 未冻结 LLM 的软提示和 4 冻结 LLM 的软提示。我们在两个基准数据集上使用 4 种临床概念和关系提取训练策略评估了 7 名预训练的法学硕士。我们在跨机构环境中评估了基于提示的学习算法的迁移学习能力。我们还评估了少数镜头的学习能力。结果与结论 当 LLM 解冻时,采用软提示的 GatorTron 3.9B 在概念提取方面实现了最佳严格 F1 分数 0.9118 和 0.8604,分别比基于传统微调和硬提示的模型高出 0.6 3.1 和 1.2 2.9,采用软提示的 GatorTron 345M提示在端到端关系提取方面取得了最佳 F1 分数 0.8332 和 0.7488,分别优于其他两个模型 0.2 2 和 0.6 11.7 。当 LLM 被冻结时,较小的(即 3.45 亿个参数)LLM 与未冻结的模型相比有很大的差距,而将 LLM 扩展到数十亿个参数使得冻结的 LLM 与未冻结的 LLM 具有竞争力。对于跨机构评估,使用冻结的 GatorTron 8.9B 模型进行软提示取得了最佳性能。 |

| Evolution of Natural Language Processing Technology: Not Just Language Processing Towards General Purpose AI Authors Masahiro Yamamoto 自计算机发明以来,通过自然语言、实际的人类语言进行交流一直是一项梦想技术。然而,自然语言很难用数学公式表达,因此在不考虑编程的情况下很难将其实现为算法。尽管技术已经取得了许多进展,但迄今为止还不能说已经取得了任何允许免费使用的成果。就人类的语言学习而言,比如学习母语或外语,我们必须承认,这个过程原则上类似于俗语熟能生巧,尽管学习方法在某种程度上是有意义的。近年来,深度学习在当代人工智能技术中发挥了核心作用。当NLP应用于自然语言处理时,这产生了前所未有的结果。使用深度学习学习大量文本数据的结果显示,取得的成果超出了最初的预测。例如,无需显式学习即可执行四种算术运算,从而能够解释复杂图像并从相应的解释文本生成图像。这是学习者通过使用大量文本数据体现熟能生巧理念的准确例子。本报告对尖端 NLP 如何实现熟能生巧的原则进行了技术解释。此外,还提供了如何将其应用于业务的示例。 |

| GeoLLM: Extracting Geospatial Knowledge from Large Language Models Authors Rohin Manvi, Samar Khanna, Gengchen Mai, Marshall Burke, David Lobell, Stefano Ermon 机器学习 ML 在一系列地理空间任务中的应用越来越普遍,但通常依赖于全球可用的协变量,例如卫星图像,这些协变量要么价格昂贵,要么缺乏预测能力。在这里,我们探讨了这样一个问题:互联网语言语料库中发现的大量知识(现在被压缩在大型语言模型法学硕士中)是否可以用于地理空间预测任务。我们首先证明法学硕士嵌入了有关位置的显着空间信息,但仅使用地理坐标天真地查询法学硕士对于预测人口密度等关键指标是无效的。然后,我们提出了 GeoLLM,这是一种新颖的方法,可以利用 OpenStreetMap 的辅助地图数据从 LLM 中有效地提取地理空间知识。我们展示了我们的方法在国际社会核心利益的多项任务中的实用性,包括人口密度和经济生计的衡量。在这些任务中,我们的方法表明,相对于使用最近邻居或直接使用提示信息的基线,使用 Pearson s r 2 测量的性能提高了 70 倍,并且性能等于或超过文献中基于卫星的基准。通过 GeoLLM,我们观察到 GPT 3.5 的性能分别比 Llama 2 和 RoBERTa 好 19 和 51,这表明我们方法的性能随着模型及其预训练数据集的大小而很好地扩展。我们的实验表明,法学硕士的样本效率非常高,地理空间信息丰富,并且在全球范围内都很稳健。 |

| Estimating Numbers without Regression Authors Avijit Thawani, Jay Pujara, Ashwin Kalyan 尽管最近在语言模型方面取得了成功,但它们表示数字的能力还不够。人类根据数字的大小来概念化数字,有效地将它们投影到数轴上,而子词标记化无法通过将数字分割成任意块来明确捕获大小。为了缓解这一缺点,人们提出了替代方法来修改语言建模流程各个阶段的数字。 |

| GPT-who: An Information Density-based Machine-Generated Text Detector Authors Saranya Venkatraman, Adaku Uchendu, Dongwon Lee 统一信息密度原则假设人类在语言产生过程中更喜欢均匀地传播信息。在这项工作中,我们研究了 UID 原则是否可以帮助捕获大型语言模型法学硕士和人类生成的文本之间的差异。我们提出 GPT who,第一个心理语言学感知的多类领域不可知统计检测器。该检测器采用基于 UID 的功能来对每个法学硕士和人类作者的独特统计签名进行建模,以实现准确的作者归属。我们使用 4 个大型基准数据集评估我们的方法,发现 GPT 在各个领域的性能优于最先进的基于统计非统计的检测器(例如 GLTR、GPTZero、OpenAI 检测器和 ZeroGPT)超过 20 个。除了卓越的性能之外,它的计算成本也很低,并且利用文本文章的可解释表示。我们对超过 40 万篇文章的人类和机器生成的文本的基于 UID 的表示进行了最大的分析,以展示作者如何以不同的方式分发信息,以及如何使用现成的 LM 进行检测,而无需进行任何微调。 |

| Compressing Context to Enhance Inference Efficiency of Large Language Models Authors Yucheng Li, Bo Dong, Chenghua Lin, Frank Guerin 大型语言模型法学硕士在各种任务中取得了卓越的表现。然而,由于内存和推理时间的计算要求显着增加,以及当输入超过法学硕士的固定上下文长度时潜在的上下文截断,他们在管理长文档和扩展对话方面面临挑战。本文提出了一种称为 Selective Context 的方法,通过识别和修剪输入上下文中的冗余以使输入更加紧凑来提高 LLM 的推理效率。我们使用需要长上下文处理 arXiv 论文、新闻文章和长对话的通用数据源来测试我们的方法,以进行摘要、问答和响应生成。实验结果表明,与使用完整上下文时相比,选择性上下文显着降低了内存成本并减少了生成延迟,同时保持了可比的性能。具体来说,我们将上下文成本降低了 50,从而使推理内存使用量减少了 36,推理时间减少了 32,同时在四个下游应用程序中观察到 BERTscore 略有下降 0.023,忠实度仅小幅下降 0.038,这表明 |

| The Importance of Prompt Tuning for Automated Neuron Explanations Authors Justin Lee, Tuomas Oikarinen, Arjun Chantha, Keng Chi Chang, Yilan Chen, Tsui Wei Weng 最近的进展极大地提高了大型语言模型法学硕士的能力,但我们对模型及其安全性的理解却进展缓慢。在本文中,我们的目标是通过研究法学硕士的单个神经元来更深入地了解他们。我们以之前的工作为基础,展示了大型语言模型(例如 GPT 4)对于解释语言模型中每个神经元的作用非常有用。具体来说,我们分析了用于生成解释的提示的效果,并表明以更自然的方式重新格式化解释提示可以显着提高神经元解释质量并大大降低计算成本。 |

| CAW-coref: Conjunction-Aware Word-level Coreference Resolution Authors Karel D Oosterlinck, Semere Kiros Bitew, Brandon Papineau, Christopher Potts, Thomas Demeester, Chris Develder 最先进的共指解析系统依赖于每个文档的多个 LLM 调用,因此对于许多用例(例如使用大型语料库进行信息提取)而言成本高昂。领先的词级共指系统 WL coref 达到了这些 SOTA 系统性能的 96.6,同时效率更高。在这项工作中,我们确定了 WL coref 处理诸如 Tom 和 Mary 之类的联合提及的常规但重要的失败案例。我们提供了一个简单而有效的解决方案,可将 OntoNotes 测试集的性能提高 0.9 F1,将高效的词级共指解析与昂贵的 SOTA 方法之间的差距缩小 34.6 。 |

| BYOC: Personalized Few-Shot Classification with Co-Authored Class Descriptions Authors Arth Bohra, Govert Verkes, Artem Harutyunyan, Pascal Weinberger, Giovanni Campagna 文本分类是许多 NLP 应用程序中经过深入研究的多功能构建块。然而,现有的方法要么需要大型带注释的语料库来训练模型,要么在使用大型语言模型作为基础时,需要仔细制作提示以及使用可以容纳许多示例的长上下文。因此,最终用户不可能为自己构建分类器。为了解决这个问题,我们提出了一种使用法学硕士进行少量文本分类的新方法。法学硕士不是通过几个镜头示例来提示的,而是对每个课程的显着特征进行描述。这些描述由用户和法学硕士交互式地共同撰写,同时用户对每个镜头示例进行注释,法学硕士询问用户回答的相关问题。示例、问题和答案被汇总以形成分类提示。我们的实验表明,我们的方法产生了高精度分类器,其性能与使用更大的数据集训练的模型(仅使用其中 1 个训练集)的性能相差不到 82 倍。此外,在一项有 30 名参与者参加的研究中,我们表明最终用户能够构建分类器来满足他们的特定需求。 |

| Leveraging Multilingual Self-Supervised Pretrained Models for Sequence-to-Sequence End-to-End Spoken Language Understanding Authors Pavel Denisov, Ngoc Thang Vu 人们已经提出了许多使用预训练模型进行端到端口语理解 E2E SLU 的方法,但它们的评估通常缺乏多语言设置和需要预测词汇填充物(例如槽填充)的任务。在这项工作中,我们提出了一种统一的方法,该方法集成了多语言预训练的语音和文本模型,并以生成方式对四种语言的六个数据集执行 E2E SLU,包括词汇填充词的预测。我们研究了如何通过使用多个训练目标对广泛可用的语音识别数据进行预训练来改进所提出的方法。对 7000 小时的多语言数据进行预训练,使我们最终能够在两个 SLU 数据集以及另外两个 SLU 数据集上超越现有技术。 |

| Enhancing Document-level Event Argument Extraction with Contextual Clues and Role Relevance Authors Wanlong Liu, Shaohuan Cheng, Dingyi Zeng, Hong Qu 与句子级事件参数提取相比,文档级事件参数提取对长输入和跨句推理提出了新的挑战。然而,大多数先前的工作都集中于捕获每个事件中候选论点和事件触发器之间的关系,忽略了两个关键点:非论点上下文线索信息和论点角色之间的相关性。在本文中,我们提出了一种基于上下文池和潜在角色指导模型的 SCPRG Span 触发器,其中包含针对上述问题的两个新颖且有效的模块。基于跨度触发器的上下文池 STCP 根据预训练模型中特定参数触发对的上下文注意权重,自适应地选择和聚合非参数线索词的信息。基于角色的潜在信息指导 RLIG 模块构建潜在角色表示,使它们通过角色交互编码进行交互以捕获语义相关性,并将它们合并到候选参数中。与基础模型相比,STCP和RLIG均引入了不超过1个新参数,并且可以轻松应用于其他事件提取模型,且结构紧凑且可移植。对两个公共数据集的实验表明,我们的 SCPRG 优于之前最先进的方法,在 RAMS 和 WikiEvents 上分别提高了 1.13 F1 和 2.64 F1。 |

| Exploring Embeddings for Measuring Text Relatedness: Unveiling Sentiments and Relationships in Online Comments Authors Anthony Olakangil, Cindy Wang, Justin Nguyen, Qunbo Zhou, Kaavya Jethwa, Jason Li, Aryan Narendra, Nishk Patel, Arjun Rajaram 在一场导致互联网使用量增长 70% 的大流行之后,世界各地使用社交媒体的人数有所增加。 Twitter、Meta Threads、YouTube 和 Reddit 等应用程序已变得越来越普遍,几乎没有不表达公众意见的数字空间。本文研究了各种社交媒体平台上评论之间的情感和语义关系,并讨论了这些不同媒体平台上共享观点的重要性,使用词嵌入来分析句子和文档中的组件。它允许研究人员、政治家和企业代表追踪世界各地用户之间的共同情感路径。本研究论文提出了多种方法来衡量从这些流行在线平台上的用户评论中提取的文本的相关性。通过利用嵌入来捕获单词之间的语义关系并帮助分析整个网络的情绪,我们可以发现有关整个公众舆论的联系。该研究利用了来自 YouTube、Reddit、Twitter 等的现有数据集。我们利用流行的自然语言处理模型(例如 Transformers BERT 的双向编码器表示)来分析情绪并探索评论嵌入之间的关系。此外,我们的目标是利用聚类和 Kl 散度来查找各种社交媒体平台上这些评论嵌入中的语义关系。 |

| OpenWebMath: An Open Dataset of High-Quality Mathematical Web Text Authors Keiran Paster, Marco Dos Santos, Zhangir Azerbayev, Jimmy Ba 越来越多的证据表明,对高质量、经过深思熟虑的标记(例如代码或数学)进行预训练在提高大型语言模型的推理能力方面发挥着重要作用。例如,Minerva 是一个 PaLM 模型,它对来自 arXiv 和网络的数十亿个数学文档进行了微调,报告在需要定量推理的问题上显着提高了性能。然而,由于所有已知的开源 Web 数据集所采用的预处理并不能忠实地保留数学符号,因此研究社区无法获得对定量 Web 文档进行大规模训练的好处。我们介绍 OpenWebMath,这是一个开放数据集,其灵感来自于这些作品,其中包含来自 Common Crawl 的数学网页的 14.7B 标记。我们详细描述了提取文本和 LaTeX 内容以及从 HTML 文档中删除样板的方法,以及质量过滤和重复数据删除的方法。此外,我们通过在 OpenWebMath 上训练 1.4B 参数语言模型来进行小规模实验,结果表明,在数据集的 14.7B 标记上训练的模型超过了在超过 20 倍的通用语言数据量上训练的模型的性能。 |

| Uni3D: Exploring Unified 3D Representation at Scale Authors Junsheng Zhou, Jinsheng Wang, Baorui Ma, Yu Shen Liu, Tiejun Huang, Xinlong Wang 在过去的几年里,扩大图像或文本的表示已经得到了广泛的研究,并引发了学习视觉和语言的革命。然而,3D 对象和场景的可扩展表示相对尚未被探索。在这项工作中,我们提出了 Uni3D,这是一个 3D 基础模型,用于探索大规模的统一 3D 表示。 Uni3D 使用 2D 初始化的 ViT 端到端预训练来将 3D 点云特征与图像文本对齐特征对齐。通过简单的架构和借口任务,Uni3D可以利用丰富的2D预训练模型作为初始化,以图像文本对齐模型作为目标,释放2D模型的巨大潜力,并将策略扩展到3D世界。我们有效地将 Uni3D 扩展到 10 亿个参数,并在广泛的 3D 任务上创造了新记录,例如零镜头分类、少镜头分类、开放世界理解和零件分割。我们证明,强大的 Uni3D 表示还可以实现 3D 绘画和野外检索等应用。 |

| Exploring Memorization in Fine-tuned Language Models Authors Shenglai Zeng, Yaxin Li, Jie Ren, Yiding Liu, Han Xu, Pengfei He, Yue Xing, Shuaiqiang Wang, Jiliang Tang, Dawei Yin 法学硕士在各种任务中表现出了强大的能力,但也表现出了对训练数据的记忆,从而引发了巨大的隐私和版权问题。虽然之前的工作研究了预训练期间的记忆,但微调期间记忆的探索相当有限。与预训练相比,微调通常涉及敏感数据和多样化目标,因此可能带来独特的记忆行为和明显的隐私风险。在这项工作中,我们进行了首次全面分析,以探索跨任务微调期间的 LM 记忆。我们对开源和我们自己的微调 LM 在各种任务中的研究表明,微调记忆在任务之间呈现出巨大的差异。我们通过稀疏编码理论提供了对这种任务差异的理解,并揭示了记忆与注意力分数分布之间的强相关性。 |

| Self-Supervised Representation Learning for Online Handwriting Text Classification Authors Pouya Mehralian, Bagher BabaAli, Ashena Gorgan Mohammadi 自监督学习提供了一种从各种类型的未标记数据中提取丰富表示的有效方法,同时避免了注释大规模数据集的成本。这可以通过设计一个借口任务来形成相对于数据的模态和域的伪标签来实现。鉴于在线手写文本的不断发展的应用,在本研究中,我们提出了新颖的“笔画遮蔽 POSM 部分”作为预训练模型的借口任务,以从英语和中文个人的在线手写中提取信息表示,以及两个建议的管道用于微调预训练模型。为了评估提取的表示的质量,我们使用内在和外在评估方法。 |

| Automated clinical coding using off-the-shelf large language models Authors Joseph S. Boyle, Antanas Kascenas, Pat Lok, Maria Liakata, Alison Q. O Neil 为患者入院分配诊断 ICD 代码的任务通常由专家编码员执行。自动化 ICD 编码的努力主要由监督深度学习模型主导。然而,学习预测大量罕见代码的困难仍然是临床实践中采用的障碍。在这项工作中,我们利用现成的预训练生成大语言模型 LLM 来开发适合零样本和少量样本代码分配的实用解决方案。仅无监督预训练并不能保证 ICD 本体和专业临床编码任务的精确知识,因此我们将任务定义为信息提取,提供每个编码概念的描述并要求模型检索相关提及。为了提高效率,我们利用 ICD 本体的分层性质来稀疏地搜索相关代码,而不是迭代所有代码。然后,在第二阶段(我们称之为元细化)中,我们利用 GPT 4 选择相关标签的子集作为预测。我们使用 Llama 2、GPT 3.5 和 GPT 4 在 ICD 编码临床病例文档的 CodiEsp 数据集上验证我们的方法。我们的树搜索方法在稀有类别上实现了最先进的性能,实现了 0.225 的最佳宏 F1,同时实现了略低的 0.157 微观 F1,而 PLM ICD 分别为 0.216 和 0.219。 |

| AutoCycle-VC: Towards Bottleneck-Independent Zero-Shot Cross-Lingual Voice Conversion Authors Haeyun Choi, Jio Gim, Yuho Lee, Youngin Kim, Young Joo Suh 本文提出了一种简单而鲁棒的零样本语音转换系统,具有循环结构和梅尔频谱图预处理。以前的工作由于依赖于精心设计的瓶颈结构而遭受信息丢失和合成质量差的问题。此外,仅依赖自我重建损失的模型很难再现不同说话者的声音。为了解决这些问题,我们提出了循环一致性损失,该损失考虑了目标说话者和源说话者之间的来回转换。此外,在说话人编码器训练期间利用堆叠随机打乱梅尔谱图和标签平滑方法从语音中提取时间无关的全局说话人表示,这是零样本转换的关键。我们的模型在主观和客观评估方面都优于现有的最先进结果。 |

| Toward Semantic Publishing in Non-Invasive Brain Stimulation: A Comprehensive Analysis of rTMS Studies Authors Swathi Anil, Jennifer D Souza 无创脑刺激 NIBS 包括可影响大脑兴奋性的经颅刺激技术。这些技术有可能治疗抑郁、焦虑和慢性疼痛等疾病,并提供对大脑功能的深入了解。然而,缺乏标准化的报告实践限制了其可重复性和充分的临床潜力。 |

| SpikeCLIP: A Contrastive Language-Image Pretrained Spiking Neural Network Authors Tianlong Li, Wenhao Liu, Changze Lv, Jianhan Xu, Cenyuan Zhang, Muling Wu, Xiaoqing Zheng, Xuanjing Huang 尖峰神经网络 SNN 已证明能够在视觉和语言领域实现与深度神经网络 DNN 相当的性能,同时具有提高能源效率和遵守生物学合理性的优势。然而,将这种单模态 SNN 扩展到多模态场景领域仍然是一个尚未探索的领域。受到对比语言图像预训练 CLIP 概念的启发,我们引入了一种名为 SpikeCLIP 的新颖框架,通过涉及对齐预训练双损失微调的两步配方来解决基于尖峰计算的背景下两种模式之间的差距。大量实验表明,SNN 取得了与 DNN 同类产品相当的结果,同时显着降低了常用于多模态模型评估的各种数据集的能耗。 |

| Understanding the Effects of RLHF on LLM Generalisation and Diversity Authors Robert Kirk, Ishita Mediratta, Christoforos Nalmpantis, Jelena Luketina, Eric Hambro, Edward Grefenstette, Roberta Raileanu 通过人类反馈的强化学习进行微调的大型语言模型 LLM RLHF 已用于迄今为止部署最广泛的一些 AI 模型中,例如 OpenAI 的 ChatGPT、Anthropic 的 Claude 或 Meta 的 LLaMA 2。在开发这些方法的过程中,我们对 RLHF 每个阶段的优点和缺点的了解仍然有限。为了填补这一空白,我们对过程的每个阶段(即监督微调 SFT、奖励建模和 RLHF)如何影响分布 OOD 泛化和输出多样性的两个关键属性进行了广泛的分析。考虑到使用这些模型的广泛的现实世界场景,OOD 泛化至关重要,而输出多样性是指模型生成不同输出的能力,对于各种用例都很重要。我们对总结和指令跟踪任务的两个基本模型进行分析,后者与当前的法学硕士用例高度相关。我们发现 RLHF 对新输入的泛化能力比 SFT 更好,特别是当训练和测试之间的分布变化变得更大时。然而,与 SFT 相比,RLHF 在各种措施上显着降低了输出多样性,这意味着当前 LLM 微调方法在泛化和多样性之间进行权衡。 |

| Retromorphic Testing: A New Approach to the Test Oracle Problem Authors Boxi Yu, Qiuyang Mang, Qingshuo Guo, Pinjia He 测试预言机充当评估软件输出与给定输入集的预期行为之间的对应关系的标准或机制。在自动化测试中,黑盒技术以其在测试预言构建中的非侵入性而闻名,被广泛使用,包括著名的方法,如差异测试和变形测试。受反函数数学概念的启发,我们提出了逆向测试,一种新颖的黑盒测试方法。它利用辅助程序与被测程序结合,建立由前向程序和后向程序组成的双程序结构。输入数据首先由前向程序处理,然后使用后向程序将其程序输出反转为其原始输入格式。特别是,辅助程序可以作为前向程序或后向程序运行,从而导致不同的测试模式。该过程通过检查输入域内的初始输入和转换后的输出之间的关系来结束。例如,为了测试正弦函数 sin x 的实现,我们可以使用其反函数 arcsin x ,并验证等式 x sin arcsin x 2k pi , forall k in mathbb Z 。 |

| Improved prompting and process for writing user personas with LLMs, using qualitative interviews: Capturing behaviour and personality traits of users Authors Stefano De Paoli 本草案提出了一个使用大型语言模型创建用户角色的工作流程,使用定性访谈的主题分析结果。与作者之前针对同一任务进行的工作相比,建议的工作流程使用改进的提示和更大的主题池。这是可能的,因为最近发布的 LLM 的功能允许处理 16,000 个代币 GPT3.5 Turbo 16k,并且还因为可以为创建角色提供精致的提示。本文提供了执行主题分析的第 2 阶段和第 3 阶段的详细信息,然后讨论了创建角色的改进工作流程。本文还对拟议流程与现有角色模型(例如数据驱动和定性角色模型)之间的关系进行了一些思考。 |

| Jailbreak and Guard Aligned Language Models with Only Few In-Context Demonstrations Authors Zeming Wei, Yifei Wang, Yisen Wang 大型语言模型法学硕士在各种任务中都取得了显着的成功,但人们对其安全性和生成恶意内容的可能性的担忧已经出现。在本文中,我们探讨了情境学习 ICL 在操纵法学硕士对齐能力方面的力量。我们发现,通过仅提供很少的上下文演示而不进行微调,可以操纵法学硕士来增加或减少越狱的可能性,即回答恶意提示。基于这些观察,我们提出了上下文攻击 ICA 和上下文防御 ICD 方法,用于越狱和保护一致的语言模型。 ICA 精心设计恶意上下文来指导模型生成有害输出,而 ICD 通过拒绝回答有害提示的演示来增强模型的稳健性。我们的实验证明了 ICA 和 ICD 在提高或降低对抗性越狱攻击的成功率方面的有效性。 |

| A Semantic Invariant Robust Watermark for Large Language Models Authors Aiwei Liu, Leyi Pan, Xuming Hu, Shiao Meng, Lijie Wen 大型语言模型法学硕士的水印算法在检测法学硕士生成的文本方面取得了极高的准确性。此类算法通常涉及在每个生成步骤向 LLM 的 logits 添加额外的水印 logits。然而,现有算法面临着攻击鲁棒性和安全鲁棒性之间的权衡。这是因为一个token的水印logits是由一定数量的前面的token决定的,数量少安全鲁棒性低,数量多则攻击鲁棒性不足。在这项工作中,我们提出了一种用于 LLM 的语义不变水印方法,该方法提供攻击鲁棒性和安全鲁棒性。我们工作中的水印逻辑是由所有前面的标记的语义决定的。具体来说,我们利用另一个嵌入 LLM 为所有前面的标记生成语义嵌入,然后通过我们训练的水印模型将这些语义嵌入转换为水印逻辑。随后的分析和实验证明了我们的方法在语义不变设置、同义词替换和文本释义设置中的攻击鲁棒性。最后,我们还表明我们的水印具有足够的安全稳健性。 |

| An experiment on an automated literature survey of data-driven speech enhancement methods Authors Arthur dos Santos, Jayr Pereira, Rodrigo Nogueira, Bruno Masiero, Shiva Sander Tavallaey, Elias Zea 一般来说,声学领域的科学出版物数量不断增加,这给进行传统文献调查带来了困难。这项工作探讨了如何使用生成式预训练 Transformer GPT 模型来自动对 116 篇有关数据驱动语音增强方法的文章进行文献调查。主要目标是评估模型在对从参考人类调查中选出的论文的特定查询提供准确响应方面的能力和局限性。 |

| We are what we repeatedly do: Inducing and deploying habitual schemas in persona-based responses Authors Benjamin Kane, Lenhart Schubert 对话技术的许多实际应用需要根据特定开发人员指定的角色生成响应。虽然可以从最近的大型语言模型中得出各种角色,但这些模型的不透明性和不可预测性使得人们希望能够以显式形式指定角色。在之前的工作中,角色通常被表示为一组一次性的自我知识,这些自我知识由对话系统检索以用于生成。然而,在现实的人类对话中,人物角色通常通过类似故事的叙述来揭示,其中涉及代理经常参与的各种事件的丰富习惯性知识,例如工作活动、爱好、体育活动、最喜欢的娱乐活动等,包括典型目标、子事件、这些事件的前提条件和后置条件。我们使用显式模式表示捕获此类习惯知识,并提出一种对话生成方法,该方法检索相关模式以条件化大型语言模型以生成基于角色的响应。 |

| Tackling Data Bias in MUSIC-AVQA: Crafting a Balanced Dataset for Unbiased Question-Answering Authors Xiulong Liu, Zhikang Dong, Peng Zhang 近年来,人们越来越重视音频、视觉和文本模式的交叉,推动了多模式研究的进步。然而,任何模态中存在的强烈偏差都可能导致模型忽视其他模态。因此,模型有效推理这些不同模式的能力受到损害,阻碍了进一步的发展。在本文中,我们仔细审查原始数据集中的每种问题类型,选择那些具有明显答案偏差的问题类型。为了消除这些偏见,我们收集补充视频和问题,确保没有答案具有明显的偏态分布。特别是,对于二元问题,我们努力确保两个答案几乎均匀地分布在每个问题类别中。因此,我们构建了一个新的数据集,名为 MUSIC AVQA v2.0,该数据集更具挑战性,我们相信可以更好地促进 AVQA 任务的进展。此外,我们提出了一种新颖的基线模型,可以更深入地研究视听文本相互关系。 |

| Take a Step Back: Evoking Reasoning via Abstraction in Large Language Models Authors Huaixiu Steven Zheng, Swaroop Mishra, Xinyun Chen, Heng Tze Cheng, Ed H. Chi, Quoc V Le, Denny Zhou 我们提出了“后退提示”,这是一种简单的提示技术,使法学硕士能够进行抽象,从包含特定细节的实例中导出高级概念和首要原则。使用概念和原则来指导推理步骤,法学硕士可以显着提高他们遵循正确的推理路径获得解决方案的能力。我们使用 PaLM 2L 模型进行了后退提示实验,并观察到在各种具有挑战性的推理密集型任务(包括 STEM、知识 QA 和多跳推理)上都有显着的性能提升。 |

| Auditing Gender Analyzers on Text Data Authors Siddharth D Jaiswal, Ankit Kumar Verma, Animesh Mukherjee 人工智能模型已经变得非常流行并且可供公众使用。然而,由于他们对社会各阶层(如有色人种和非二元人)明显的偏见,他们不断受到扫描。在这项研究中,我们审核了三个现有的性别分析器 uClassify、Readable 和 HackerFactor,以了解对非二元个体的偏见。这些工具旨在仅预测顺性别二元标签,这会导致对社会中非二元成员的歧视。我们策划了两个数据集:Reddit 评论 66 万条,Tumblr 帖子 205 万条,我们的实验评估表明,这些工具非常不准确,所有平台上的总体准确度均为 50。所有平台上对非二元评论的预测大多是女性,从而传播了非二元个体女性化的社会偏见。为了解决这个问题,我们在多个组合的两个数据集上对 BERT 多标签分类器进行了微调,在最实际的可部署设置上观察到整体性能为 77,在非二元类上观察到了令人惊讶的更高性能 90。 |

| LLM for SoC Security: A Paradigm Shift Authors Dipayan Saha, Shams Tarek, Katayoon Yahyaei, Sujan Kumar Saha, Jingbo Zhou, Mark Tehranipoor, Farimah Farahmandi 随着电子设备中片上系统 SoC 设计的普遍性和复杂性的增加,将安全性纳入 SoC 设计流程的任务提出了重大挑战。现有的安全解决方案由于在可扩展性、全面性和适应性方面的局限性,不足以对现代 SoC 设计提供有效的验证。另一方面,大型语言模型法学硕士因其在自然语言理解、高级推理和程序综合任务方面的巨大成功而闻名。认识到这个机会,我们的研究深入研究利用生成式预训练 Transformers GPT 的新兴功能来解决 SoC 安全性方面的现有差距,旨在寻求更高效、可扩展和适应性更强的方法。通过将 LLM 集成到 SoC 安全验证范例中,我们开辟了一个充满可能性和挑战的新领域,以确保日益复杂的 SoC 的安全性。本文对现有作品进行了深入分析,展示了实际案例研究,展示了全面的实验,并提供了有用的推广指南。 |

| An evolutionary model of personality traits related to cooperative behavior using a large language model Authors Reiji Suzuki, Takaya Arita 本文旨在通过将生成模型的丰富表达能力引入基于社会代理的进化模型的特征表达中,阐明多样化和社会群体的进化动态。具体来说,我们关注博弈论关系背景下人格特质的演变,即个体间利益施加强大选择压力的情况。我们构建了一个代理模型,其中与合作行为相关的人格特征的语言描述被用作基因。从大型语言模型法学硕士中提取的基于这些人格特征做出行为决策的确定性策略被用作行为特征。通过要求法学硕士稍微修改父基因以合作或自私,根据基于平均收益和基因突变的选择来进化种群。通过初步的实验和分析,我们阐明这样的模型确实可以展示基于人格特质的多样化和高阶表示的合作行为的演化。 |

| Fingerprint Attack: Client De-Anonymization in Federated Learning Authors Qiongkai Xu, Trevor Cohn, Olga Ohrimenko 联合学习允许在参与者不信任中央服务器和彼此之间的环境中进行协作训练,而无需共享数据。通过将参与者身份与其数据解耦,确保参与者和服务器之间的通信是匿名的,可以进一步提高隐私性。本文试图通过提出一种新颖的针对参与者发送到服务器的梯度的指纹攻击来检验这种防御是否足以保证匿名性。我们在两种语言语料库上学习联合语言模型的实证研究中表明,梯度聚类可以轻松打破匿名化。 |

| Vulnerability Clustering and other Machine Learning Applications of Semantic Vulnerability Embeddings Authors Mark Oliver Stehr, Minyoung Kim 网络安全漏洞通常以简短的自然语言描述的形式发布,例如以 MITRE 的 CVE 列表的形式发布,随着时间的推移,该列表会通过诸如通用漏洞评分系统 CVSS 定义的标签等进一步手动丰富。在漏洞AI分析与情报项目中,我们基于自然语言处理NLP技术研究了不同类型的语义漏洞嵌入,以获得漏洞空间的简明表示。我们还评估了它们作为机器学习应用程序基础的用途,这些应用程序可以支持网络安全研究人员和分析师进行风险评估和其他相关活动。 |

| TILFA: A Unified Framework for Text, Image, and Layout Fusion in Argument Mining Authors Qing Zong, Zhaowei Wang, Baixuan Xu, Tianshi Zheng, Haochen Shi, Weiqi Wang, Yangqiu Song, Ginny Y. Wong, Simon See 论据挖掘 AM 的主要目标是分析作者的立场。与以往仅关注文本的AM数据集不同,第十届论据挖掘研讨会的共享任务引入了包含文本和图像的数据集。重要的是,这些图像既包含视觉元素又包含光学特征。我们的新框架 TILFA A Unified Framework for Text, Image, and Layout Fusion in Argument Mining 旨在处理这种混合数据。它不仅擅长理解文本,还擅长检测光学字符和识别图像中的布局细节。 |

| Chinese Abs From Machine Translation |

Papers from arxiv.org

更多精彩请移步主页

pic from pexels.com