【GRU回归预测】麻雀算法优化注意力机制卷积神经网络结合双向门控循环单元SSA-Attention-CNN-BiGRU数据预测(多输入多输出)【含Matlab源码 3905期】

✅博主简介:热爱科研的Matlab仿真开发者,修心和技术同步精进,Matlab项目合作可私信。

个人主页:海神之光

代码获取方式:

海神之光Matlab王者学习之路—代码获取方式

⛳️座右铭:行百里者,半于九十。

更多Matlab仿真内容点击

Matlab图像处理(进阶版)

路径规划(Matlab)

神经网络预测与分类(Matlab)

优化求解(Matlab)

语音处理(Matlab)

信号处理(Matlab)

车间调度(Matlab)

⛄一、麻雀算法优化注意力机制卷积神经网络结合双向门控循环单元SSA-Attention-CNN-BiGRU回归预测

1 麻雀算法

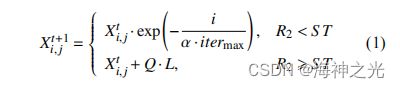

麻雀搜索算法是受麻雀群体的捕食与反捕食行为启发得来. 麻雀的觅食过程遵循发现者-跟随者模型,同时引入麻雀对于捕食者的预警机制. 麻雀群体种有发现者、跟随者、预警者 3 种角色. 种群中适度值较高的麻雀作为发现者, 负责找到食物并且为其他麻雀提供食物的方位. 除去作为发现者的麻雀, 其他个体则为跟随者, 跟随发现者进行觅食. 同时, 跟随者会监视发现者, 并对其进行食物的掠夺提高自己的适应度, 从而成为发现者. 在麻雀群体中, 存在一定数量的预警者,当预警值大于安全值时, 预警者会发出叫声为其他麻雀提供信号, 逃离危险区域, 防止被捕食. 麻雀搜索算法中麻雀角色具体位置更新公式如下:麻雀种群中的发现者的位置更新公式为:

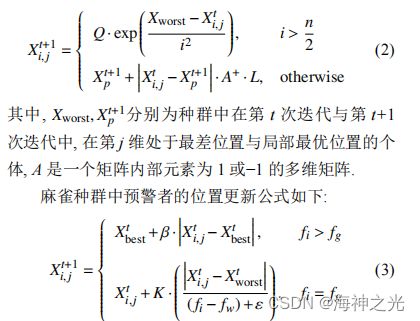

其中, 麻雀种群中发现者所占的比例为 10%–20%, 式 中 t 为当前的迭代数, 为最大迭代数, 为 之间均匀的随机数, , 分别表示预

警值与安全值. Q 为服从正态分布的随机数, L 为的矩阵, 其中每个内部元素都为 1.

麻雀种群中跟随者的位置更新公式为:

其中, 预警者所占的比例为 10%–20%, 为当前麻雀种群的全局最优位置的个体, 为服从正态分布, 均值为 0, 方差为 1 的控制步长的参数, 为一个极小的常数, 用于避免式中分母出现 0 的情况, 一般设为 10E–8.用来控制麻雀的运动方向. 为当前个体 i 的

适应度值, fg, fw为当前麻雀种群的局部最优适度值与最差适度值.

麻雀搜索算法的基本算法步骤如下: 步骤 1. 初始化最大迭代次数, 种群数量 N, 发现这比例 PD, 侦察者比例 SD、警戒阈值 R2. 步骤 2. 计算麻雀种群的适度值并进行排序, 找出当前最差适度个体与最优适度值个体.

步骤 3. 应用式 (1) 对发现者进行位置更新.

步骤 4. 应用式 (2) 对跟随者进行位置更新.

步骤 5. 应用式 (3) 对预警者进行位置更新.

步骤 6. 完成当前迭代, 得到新的位置.

步骤 7. 计算当前麻雀种群的适度值, 如果优于之前位置, 更新麻雀种群位置.

步骤 8. 判断是否满足最大迭代次数或者精度要求, 若是, 结束迭代输出最优结果, 否则返回步骤 3.

2 双向门控循环单元

在学术界已经提出了许多方法来解决这类问题。 其中最早的方法是”长短期记忆”(long-short-term memory,LSTM) (Hochreiter and Schmidhuber, 1997), 我们将在下一次讨论。 门控循环单元(gated recurrent unit,GRU) (Cho et al., 2014) 是一个稍微简化的变体,通常能够提供同等的效果, 并且计算 (Chung et al., 2014)的速度明显更快。 由于门控循环单元更简单,我们从它开始解读。

2.1 门控隐状态

门控循环单元与普通的循环神经网络之间的关键区别在于: 前者支持隐状态的门控。 这意味着模型有专门的机制来确定应该何时更新隐状态, 以及应该何时重置隐状态。 这些机制是可学习的,并且能够解决了上面列出的问题。 例如,如果第一个词元非常重要, 模型将学会在第一次观测之后不更新隐状态。 同样,模型也可以学会跳过不相关的临时观测。 最后,模型还将学会在需要的时候重置隐状态。 下面我们将详细讨论各类门控。

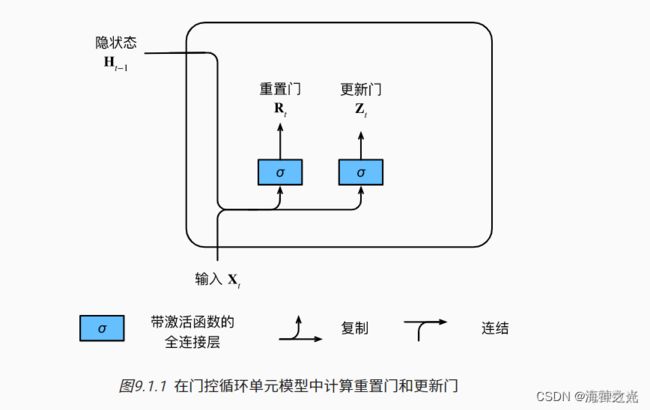

2.1.1重置门和更新门

我们首先介绍重置门(reset gate)和更新门(update gate)。 我们把它们设计成(0,1)区间中的向量, 这样我们就可以进行凸组合。 重置门允许我们控制“可能还想记住”的过去状态的数量; 更新门将允许我们控制新状态中有多少个是旧状态的副本。

我们从构造这些门控开始。 图描述了门控循环单元中的重置门和更新门的输入, 输入是由当前时间步的输入和前一时间步的隐状态给出。 两个门的输出是由使用sigmoid激活函数的两个全连接层给出。

2.1.2 候选隐状态

2.1.3 隐状态

这些设计可以帮助我们处理循环神经网络中的梯度消失问题, 并更好地捕获时间步距离很长的序列的依赖关系。 例如,如果整个子序列的所有时间步的更新门都接近于1, 则无论序列的长度如何,在序列起始时间步的旧隐状态都将很容易保留并传递到序列结束。

总之,门控循环单元具有以下两个显著特征:

重置门有助于捕获序列中的短期依赖关系;

更新门有助于捕获序列中的长期依赖关系。

3 麻雀算法优化注意力机制卷积神经网络结合双向门控循环单元SSA-Attention-CNN-BiGRU

麻雀算法优化注意力机制卷积神经网络结合双向门控循环单元(SSA-Attention-CNN-BiGRU)是一种用于文本分类任务的深度学习模型。该模型结合了卷积神经网络(CNN)、双向门控循环单元(BiGRU)和自注意力机制(SSA-Attention)。

首先,卷积神经网络(CNN)用于提取文本特征。CNN通过使用多个卷积核对输入的文本进行卷积操作,从而捕捉不同尺度的局部特征。然后,通过池化操作将卷积后的特征进行降维,得到更加抽象的特征表示。

接下来,双向门控循环单元(BiGRU)用于对文本序列进行建模。BiGRU由两个方向的门控循环单元组成,分别从前向和后向对文本序列进行处理。这样可以捕捉到文本序列中的上下文信息,并且能够解决长依赖问题。

最后,自注意力机制(SSA-Attention)用于对文本序列中的关键信息进行加权。通过计算每个词与其他词之间的相似度,自注意力机制可以自动学习到每个词的重要性权重。这样,模型可以更加关注对分类任务有帮助的信息。

综上所述,麻雀算法优化注意力机制卷积神经网络结合双向门控循环单元(SSA-Attention-CNN-BiGRU)通过卷积神经网络提取文本特征,双向门控循环单元建模文本序列,自注意力机制加权关键信息,从而实现对文本分类任务的优化。

⛄二、部分源代码

%% 清空环境变量

warning off % 关闭报警信息

close all % 关闭开启的图窗

clear % 清空变量

clc % 清空命令行

tic

% restoredefaultpath

%% 导入数据

res = xlsread(‘data.xlsx’);

%% 数据分析

num_size = 0.7; % 训练集占数据集比例

outdim = 2; % 最后一列为输出

num_samples = size(res, 1); % 样本个数

res = res(randperm(num_samples), ; % 打乱数据集(不希望打乱时,注释该行)

num_train_s = round(num_size * num_samples); % 训练集样本个数

f_ = size(res, 2) - outdim; % 输入特征维度

%% 划分训练集和测试集

P_train = res(1: num_train_s, 1: f_)‘;

T_train = res(1: num_train_s, f_ + 1: end)’;

M = size(P_train, 2);

P_test = res(num_train_s + 1: end, 1: f_)‘;

T_test = res(num_train_s + 1: end, f_ + 1: end)’;

N = size(P_test, 2);

%% 数据归一化

[p_train, ps_input] = mapminmax(P_train, 0, 1);

p_test = mapminmax(‘apply’, P_test, ps_input);

[t_train, ps_output] = mapminmax(T_train, 0, 1);

t_test = mapminmax(‘apply’, T_test, ps_output);

%% 数据平铺

% 将数据平铺成1维数据只是一种处理方式

% 也可以平铺成2维数据,以及3维数据,需要修改对应模型结构

% 但是应该始终和输入层数据结构保持一致

p_train = double(reshape(p_train, f_, 1, 1, M));

p_test = double(reshape(p_test , f_, 1, 1, N));

t_train = double(t_train)‘;

t_test = double(t_test )’;

%% 数据格式转换

for i = 1 : M

Lp_train{i, 1} = p_train(:, :, 1, i);

end

for i = 1 : N

Lp_test{i, 1} = p_test( :, :, 1, i);

end

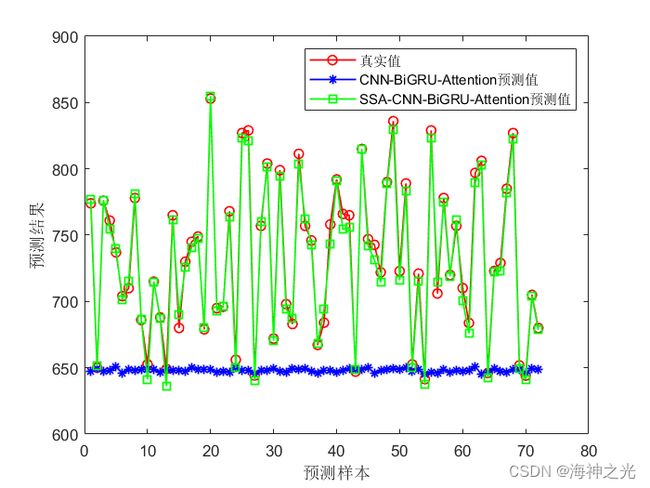

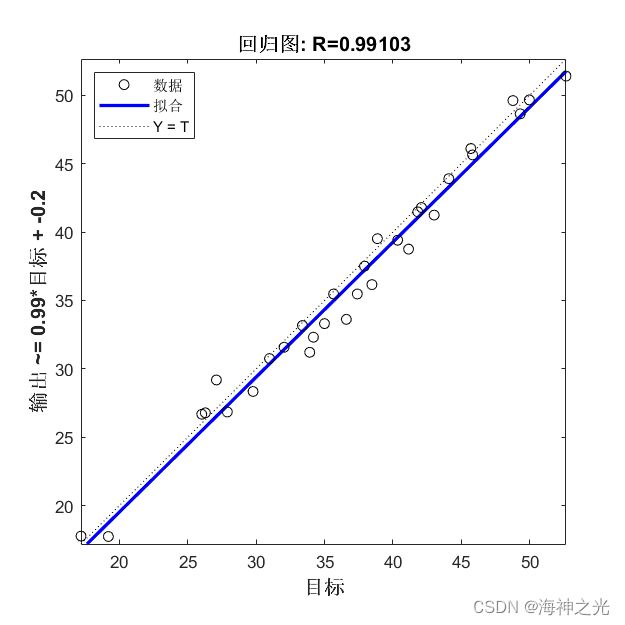

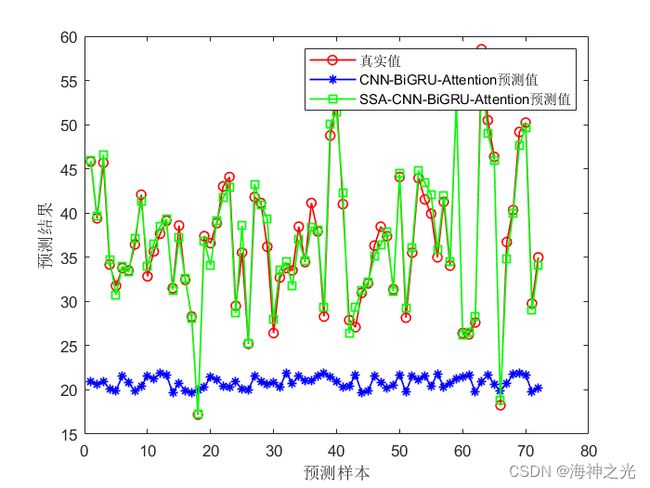

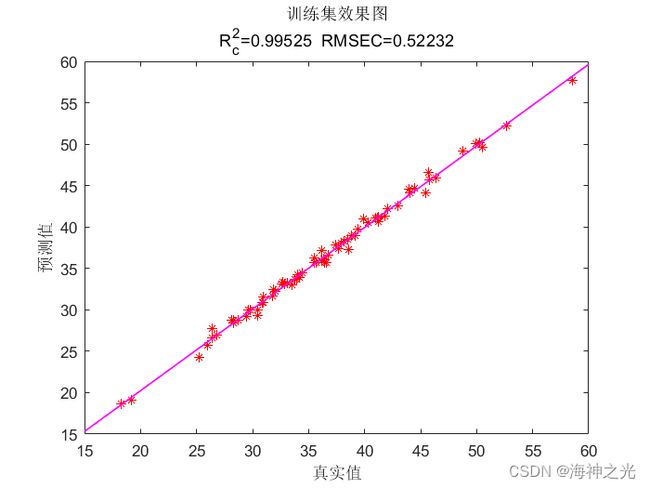

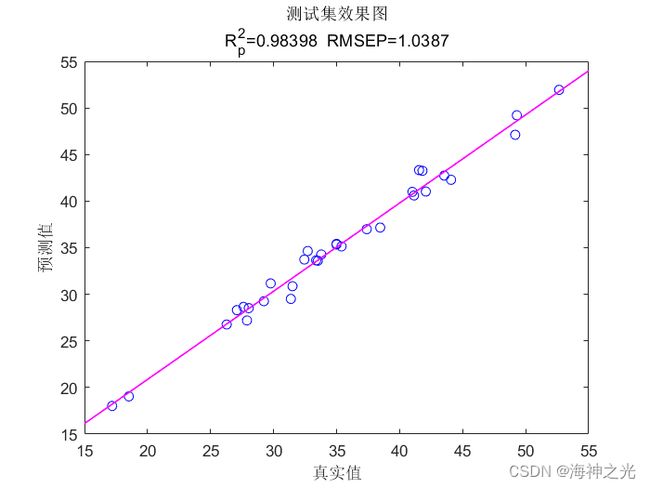

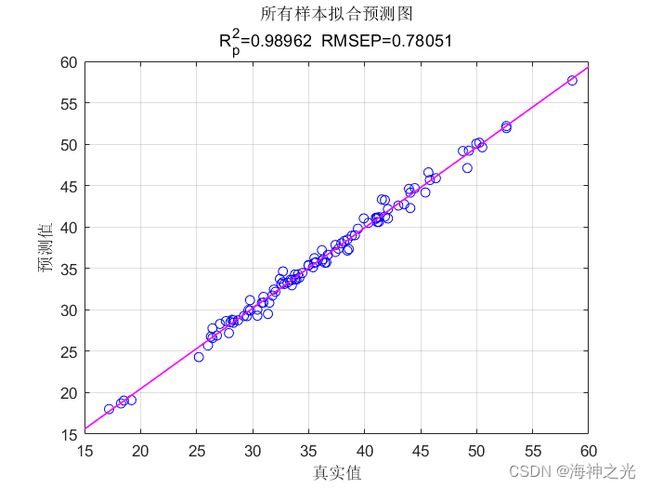

⛄三、运行结果

⛄四、matlab版本及参考文献

1 matlab版本

2014a

2 参考文献

[1]张立峰,刘 旭.基于 CNN-GRU 神经网络的短期负荷预测[J].电力科学与工 程. 2020年11月

3 备注

简介此部分摘自互联网,仅供参考,若侵权,联系删除

仿真咨询

1 各类智能优化算法改进及应用

生产调度、经济调度、装配线调度、充电优化、车间调度、发车优化、水库调度、三维装箱、物流选址、货位优化、公交排班优化、充电桩布局优化、车间布局优化、集装箱船配载优化、水泵组合优化、解医疗资源分配优化、设施布局优化、可视域基站和无人机选址优化

2 机器学习和深度学习方面

卷积神经网络(CNN)、LSTM、支持向量机(SVM)、最小二乘支持向量机(LSSVM)、极限学习机(ELM)、核极限学习机(KELM)、BP、RBF、宽度学习、DBN、RF、RBF、DELM、XGBOOST、TCN实现风电预测、光伏预测、电池寿命预测、辐射源识别、交通流预测、负荷预测、股价预测、PM2.5浓度预测、电池健康状态预测、水体光学参数反演、NLOS信号识别、地铁停车精准预测、变压器故障诊断

3 图像处理方面

图像识别、图像分割、图像检测、图像隐藏、图像配准、图像拼接、图像融合、图像增强、图像压缩感知

4 路径规划方面

旅行商问题(TSP)、车辆路径问题(VRP、MVRP、CVRP、VRPTW等)、无人机三维路径规划、无人机协同、无人机编队、机器人路径规划、栅格地图路径规划、多式联运运输问题、车辆协同无人机路径规划、天线线性阵列分布优化、车间布局优化

5 无人机应用方面

无人机路径规划、无人机控制、无人机编队、无人机协同、无人机任务分配

6 无线传感器定位及布局方面

传感器部署优化、通信协议优化、路由优化、目标定位优化、Dv-Hop定位优化、Leach协议优化、WSN覆盖优化、组播优化、RSSI定位优化

7 信号处理方面

信号识别、信号加密、信号去噪、信号增强、雷达信号处理、信号水印嵌入提取、肌电信号、脑电信号、信号配时优化

8 电力系统方面

微电网优化、无功优化、配电网重构、储能配置

9 元胞自动机方面

交通流 人群疏散 病毒扩散 晶体生长

10 雷达方面

卡尔曼滤波跟踪、航迹关联、航迹融合