【MATLAB】使用随机森林在回归预测任务中进行特征选择(深度学习的数据集处理)

1.随机森林在神经网络的应用

当使用随机森林进行特征选择时,算法能够为每个特征提供一个重要性得分,从而帮助识别对目标变量预测最具影响力的特征。这有助于简化模型并提高其泛化能力,减少过拟合的风险,并且可以加快模型训练和推理速度。通过剔除不重要的特征,模型的复杂度降低,同时保持了较高的预测准确性。

随机森林是一种集成学习算法,利用多棵决策树对特征进行建模。由于其天然的并行化、抗过拟合的特性和对非线性关系的良好适应性,随机森林在特征选择中显示出强大的效果。此外,特征选择可以帮助理解数据,并为进一步的特征工程提供指导,有效地提高模型的预测性能。

通俗点讲就是,用科学、合理的方法去除掉数据集中不需要的特征。常用在回归预测任务的数据集处理中(也就是N个输入特征,一个输出特征)。

2.代码实现

这部分代码旨在准备 MATLAB 环境。它关闭了 MATLAB 的警告信息显示,关闭所有之前打开的图形窗口,清除了 MATLAB 工作区中的所有变量,并清空命令窗口。

warning off % 关闭警告信息显示

close all % 关闭所有图形窗口

clear % 清除工作区变量

clc % 清空命令窗口

这段代码使用 readtable 函数从名为 "01.csv" 的 CSV 文件中读取数据并将其存储在变量 data 中。如果数据文件不包含表头,则需要使用 readmatrix 函数。

data = readtable('01.csv'); % 如果数据文件不包含表头,请使用readmatrix函数

这段代码将数据拆分为特征和目标变量。其中 X 存储假设前 2000 行数据的前 6 列是特征,y 存储假设前 2000 行数据的最后一列是目标变量。

X = data{1:2000, 1:6}; % 假设前6列是特征

y = data{1:2000, 7}; % 假设最后一列是目标变量

这部分使用 TreeBagger 函数构建了一个包含 100 棵树的随机森林回归模型,并计算了袋外预测器的重要性。

ens = TreeBagger(100, X, y, 'Method', 'regression', 'OOBPredictorImportance', 'on');

在这个部分中,计算了特征的重要性得分,并将其进行了归一化处理。然后将其显示出来。

% 计算特征的重要性分数

featureImportance = ens.OOBPermutedVarDeltaError;

disp(featureImportance)

normalizedFeatureImportance = featureImportance / sum(featureImportance);

disp(normalizedFeatureImportance);

这一部分可视化了特征重要性得分,通过绘制条形图展示各个特征的重要性。

% 可视化特征重要性

bar(normalizedFeatureImportance);

xlabel('特征');

ylabel('重要性得分');

title('特征重要性');

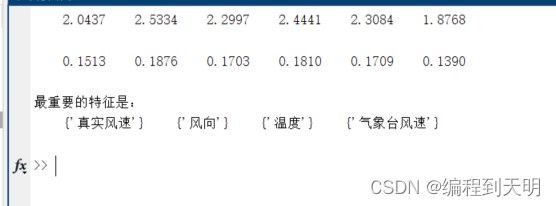

这部分代码对特征的重要性得分进行排序,并选择了最重要的四个特征进行输出。同时,重新设置了图表的横坐标,使其显示最重要的特征名称。(笔者的数据集格式为6个输入一个输出的风力发电机功率数据集)

% 特征排序及输出

[sortedImportance, sortedIdx] = sort(normalizedFeatureImportance, 'descend');

topFeatures = sortedIdx(1:4); % 选择最重要的四个特征

topFeaturesNames = {'湿度', '真实风速', '气象台风速', '风向', '温度', '气压'};

disp('最重要的特征是:');

disp(topFeaturesNames(topFeatures));

xticks(1:length(topFeaturesNames));

xticklabels(topFeaturesNames);

3.运行结果

运行结果如下(以笔者的风力发电机数据集为例):

4.完整代码

%% 清空环境变量

warning off % 关闭警告信息显示

close all % 关闭所有图形窗口

clear % 清除工作区变量

clc % 清空命令窗口

% 读取CSV文件

data = readtable('01.csv'); % 如果数据文件不包含表头,请使用readmatrix函数

% 将数据拆分为特征和目标变量

X = data{1:2000, 1:6}; % 假设前6列是特征

y = data{1:2000, 7}; % 假设最后一列是目标变量

ens = TreeBagger(100, X, y, 'Method', 'regression', 'OOBPredictorImportance', 'on');

% 计算特征的重要性分数

featureImportance = ens.OOBPermutedVarDeltaError;

disp(featureImportance)

normalizedFeatureImportance = featureImportance / sum(featureImportance);

disp(normalizedFeatureImportance);

% 可视化特征重要性

bar(normalizedFeatureImportance);

xlabel('特征');

ylabel('重要性得分');

title('特征重要性');

% 根据得分排序特征

[sortedImportance, sortedIdx] = sort(normalizedFeatureImportance, 'descend');

topFeatures = sortedIdx(1:4); % 选择最重要的四个特征

% 输出最重要的特征

topFeaturesNames = {'湿度', '真实风速', '气象台风速', '风向', '温度', '气压'};

disp('最重要的特征是:');

disp(topFeaturesNames(topFeatures));

% 重新设置图表横坐标

xticklabels(topFeaturesNames);