Benchmarking Large Language Models in Retrieval-Augmented Generation-学习翻译

提检索增强生成中大型语言模型的基准测试文献学习

作者将在https://github.com/chen700564/RGB上发布本文的代码和RGB。

y ˇ \check{y} yˇ

文章目录

- 摘要

- Introduction

- Related work

- Retrieval-Augmented Generation Benchmark

-

- RAG所需能力

- 数据构建

- 评估指标

- Experiments

-

- Settings

- 噪声鲁棒性结果

- 否定拒绝试验台结果(Results on Negative Rejection testbed)

- 信息集成试验台结果

- 反事实鲁棒性试验台结果

- 总结

摘要

提示:这里可以添加本文要记录的大概内容:

检索增强生成(RAG)是一种很有前途的减轻大型语言模型(LLM)幻觉的方法。然而,现有的研究缺乏对检索增强生成对不同大型语言模型的影响的严格评估,这使得识别不同LLM的RAG能力的潜在瓶颈具有挑战性。在本文中,我们系统地研究了检索增强生成对大型语言模型的影响。我们分析了不同大型语言模型在RAG所需的4种基本能力方面的性能,包括噪声鲁棒性、负抑制、信息集成和反事实鲁棒性。为此,我们建立了检索增强生成基准(Retrieval-Augmented Genera-

tion Benchmark RGB),这是一个新的用于中英文RAG评估的语料库。RGB根据上述解决案例所需的基本能力,将基准中的实例划分为4个独立的测试台。然后,我们在RGB上评估6个具有代表性的LLM,以诊断当前LLM在应用RAG时的挑战。评估表明,尽管LLM表现出一定程度的噪声鲁棒性,但它们在负面拒绝、信息整合和处理虚假信息方面仍存在显著困难。上述评估结果表明,要将RAG有效应用于LLM,还有相当长的路要走。

Introduction

最近,在大型语言模型(LLM)方面取得了令人印象深刻的进展,如ChatGPT(OpenAI 2022)、LLaMA-2(Touvron等人,2023)和ChatGLM(THUDM 2023a)。尽管这些模型显示出了非凡的一般能力(Bang等人,2023;郭等人,2022),但它们仍然面临着包括事实幻觉在内的严重挑战(Cao et al. 2020; Raunak, Menezes, and Junczys-Dowmunt 2021; Ji et al. 2023),知识过时(He,Zhang,and Roth 2022),以及缺乏特定领域的专业知识(Li et al.2023c;Shen et al.2023)。

通过信息检索整合外部知识,即检索增强生成(RAG),被认为是解决上述挑战的一种很有前途的方法。(Guu et al. 2020; Lewis et al. 2020; Borgeaud et al.2022; Izacard et al. 2022). 借助外部知识的帮助,LLM可以生成更准确、更可靠的响应。最常见的方法是使用搜索引擎作为检索器,如NewBing。由于互联网上有大量的信息,使用搜索引擎可以提供更多的实时信息。

然而,检索增强生成不仅给LLM带来了积极的影响(刘,张,梁2023;Maynez等人2020)。一方面,互联网上的内容中存在大量的噪音信息,甚至是假新闻,这给搜索引擎准确检索所需知识带来了挑战。另一方面,LLM面临着不可靠的世代挑战。LLM可能会被上下文中包含的不正确信息误导(Bian等人,2023),并且在生成过程中也会产生幻觉(Adlakha等人,2022),导致生成超出外部信息的内容。这些挑战导致LLM无法持续产生可靠和准确的响应。不幸的是,目前缺乏对这些因素如何影响RAG的全面理解,以及每个模型如何从这些缺陷中幸存下来,并通过信息检索提高其性能。因此,迫切需要对LLM进行全面评估,评估其有效利用检索到的信息的能力,以及抵御信息检索中存在的各种缺点的能力。

为此,本文对现有LLM的RAG进行了全面评估。具体来说,我们创建了一个新的检索增强生成基准,即RGB,有英文和中文两种版本。为了确保LLM的内部知识不会在评估结果中引入偏见,RGB选择聚合最新的新闻信息,并基于新闻信息构建查询。然后,基于这些查询,我们使用搜索API获取相关文档,并从内容中选择最相关的片段作为外部检索文档。最后,基于查询和文档集对的不同组成,我们对语料库进行扩展,并将其划分为4个测试平台,根据RAG中常见的挑战来评估LLM的以下基本能力,如图1所示:

- 噪声鲁棒性,这意味着模型可以从噪声文档中提取有用的信息。在本文中,我们将噪声文档定义为与问题相关但不包含任何答案信息的文档。例如,在图1中,与“谁被授予2022年诺贝尔文学奖”问题相关的嘈杂文件包括关于2021年诺贝尔文学奖项的报道。为此,噪声鲁棒性测试台包含外部文档包含基于所需噪声比的一定数量的噪声文档的实例。

- 否定拒绝,这意味着当所需的知识不存在于任何检索到的文档中时,模型应该拒绝回答问题。否定拒绝的测试台包含外部文档仅包含嘈杂文档的实例。LLM应指示“信息不足”或其他拒绝信号。

- 信息集成,评估模型是否能够回答需要集成多个文档信息的复杂问题。对于图1中的实例,对于“适用于iOS的ChatGPT应用程序和ChatGPT api是何时启动的?”这一问题,LLM应提供有关iOS上的ChatGPT应用程序和“ChatGPT api”的启动日期的信息。信息集成的测试台包含只能使用多个外部文档回答的实例。

- 反事实稳健性,评估当LLM通过指令收到关于检索信息中潜在风险的警告时,模型是否能够识别检索文档中已知事实错误的风险。反事实稳健性的试验台包括LLM可以直接回答的实例,但外部文档包含事实错误。

基于RGB,我们对6个最先进的大型语言模型进行了评估,包括ChatGPT(OpenAI 2022)、ChatGLM-6B(THUDM 2023a)、ChatGLM26B(THUDM 2023b)、Vicuna-7b(Chiang et al.2023)、Qwen-7b-Chat(QwenLM 2023)、BELLE-7b(Yunjie Ji 2023)。我们发现,尽管RAG可以提高LLM的响应准确性,但它们仍然面临着上述挑战。具体而言,我们发现,尽管LLM表现出一定程度的噪声稳健性,但当存在相关信息时,它们往往会混淆类似信息,并经常产生不准确的答案。例如,当面临关于2022年诺贝尔文学奖的问题时,如果外部文件中有关于2021年诺贝尔文学奖项的嘈杂文件,LLM可能会变得困惑,并提供不准确的答案。此外,当没有任何外部文件包含相关信息时,LLM经常无法拒绝回答并生成错误答案。此外,LLM缺乏从多个文档进行总结的能力,因此,如果需要多个文档来回答一个问题,LLM往往无法提供准确的答案。最后,我们发现,即使LLM包含所需的知识,并通过指示获得检索信息中潜在风险的警告,他们仍然倾向于信任检索信息,并将其优先于自己现有的知识。上述实验结果强调了进一步解决现有RAG方法中重要问题的必要性。因此,谨慎行事并仔细设计其用法至关重要。

一般来说,本文的贡献有:

- 我们提出评估LLM检索增强生成的四种能力,并创建了中英文检索增强生成基准。据我们所知,这是第一个旨在评估LLM的检索增强生成的这四种能力的基准。

- 我们使用RGB评估了现有的LLM,并发现它们在四种不同能力方面的局限性。

- 我们分析了RGB中LLM的响应,并确定了它们目前的缺点以及建议的改进方向。

Related work

检索增强模型 存储在大型语言模型中的知识通常是过时的(He,Zhang,and Roth 2022),它们有时也会产生幻觉(Cao et al.2020;Raunak,Menezes,and JunczysDowmunt 2021;Ji et al.2023),即它们可能产生不相关或事实上不正确的内容。通过使用外部知识作为指导,检索增强模型可以生成更准确可靠的响应(Guu等人。2020年;Lewis等人2020;Borgeud等人2022;Izacard等人2022;施等人2023;Ren等人2023)。Retrievalaugmented模型在开放域QA等各种任务中取得了显著的效果(Izacard and Grave2021; Trivedi et al. 2023; Li et al. 2023a), 对话(Cai et al.2019a,b;Peng et al.2023)、特定领域问答(Cui et al.20023)和代码生成(Zhou et al.2023b)。近年来,随着大模型的发展,一系列增强检索的工具和产品受到了广泛关注,如ChatGPT检索插件、Langchain、新必应等。然而,在现实世界中,检索到的文本不可避免地包含噪声。因此,本文对LLM中的检索增广生成进行了系统的评价和分析。

LLM的评估 LLM由于其卓越的综合能力而受到极大关注(Chang等人,2023)。它使我们能够更深入地了解LLM的具体能力和局限性,同时也为未来的研究提供了宝贵的指导。过去,GLUE(Wang等人,2019b)和SuperCLUE(Wang et al.,2019a)等基准测试主要侧重于评估NLP任务,特别是在自然语言理解方面。然而,这些评估往往无法完全掌握LLM的能力。MMLU(Hendrycks等人。2021)来测量语言模型在预训练时获得的知识。近年来,随着LLM的发展,出现了一系列通用的评估基准,如AGIEval(Zhong et al.2023)、C-Eval(Huang et al.2021)、AlpacaEval(Li et al.2023b),OpenLLM排行榜(Edward Beeching 2023)等。除了一般能力外,还有专门的基准测试,侧重于评估模型的能力。例如,CValues(Xu et al.2023a)侧重于LLM的安全性和责任性,M3Exam(Zhang et al.2023)侧重于人体检查,ToolBench(Qin et al.2023)评估LLM使用外部工具的情况。最近,Adlakha等人(2023)评估了现有QA数据集中LLM的RAG。与他们的工作不同,我们专注于RAG所需的4种能力,并创建了检索增强生成基准来评估LLM。

Retrieval-Augmented Generation Benchmark

在本节中,我们首先介绍了我们旨在评估LLM中的特定检索增强生成能力。接下来,我们概述了构建用于评估的RAG基准的过程。最后,我们提出了评估指标。

RAG所需能力

外部知识是解决LLM幻觉和过时知识等问题的关键,它可以通过检索增强生成(RAG)使LLM产生更准确可靠的响应。然而,LLM不能总是像RAG预期的那样做出响应。首先,互联网上有许多不相关的文件和虚假信息。将这些外部文件纳入LLM可能会产生不利影响。对Anther来说,LLM面临着不可靠的世代挑战。LLM的生成通常是不可预测的,我们不能保证它们会利用外部文件中包含的有用信息。此外,LLM很容易被文档中的错误信息误导。为此,我们构建了RetrievalAugmented Generation Benchmark(RGB)来评估LLM的检索增强生成,我们关注4种特定能力:

噪声鲁棒性 是LLM在噪声文档中的鲁棒性。由于检索者并不完美,他们检索的外部知识通常包含大量噪声,即与问题相关但不包含任何关于答案的信息的文档。为了有效地回答用户的问题,LLM必须能够从文档中提取必要的信息,尽管文档中存在嘈杂的文档。

否定拒绝 是一种衡量LLM是否可以在没有任何上下文提供有用信息的情况下拒绝回答问题的指标。在现实世界中,搜索引擎经常无法检索包含答案的文档。在这些情况下,模型必须具有拒绝识别和避免生成误导性内容的能力。

信息集成是一种集成来自多个文档的答案的能力。在许多情况下,一个问题的答案可能包含在多个文档中。例如,对于“谁是2022年美国网球公开赛男单和女单的冠军?”这个问题,这两位冠军可能在不同的文件中被提及。为了更好地回答复杂的问题,LLM必须具备整合信息的能力。

反事实稳健性 是指处理外部知识错误的能力。在现实世界中,互联网上有大量的虚假信息。请注意,我们只评估LLM通过指示在检索到的信息中收到潜在风险警告的情况。

在现实世界中,不可能获得具有所有必要外部知识的完美文档。因此,为了测量LLM的RAG,评估模型的这四种能力变得至关重要。

数据构建

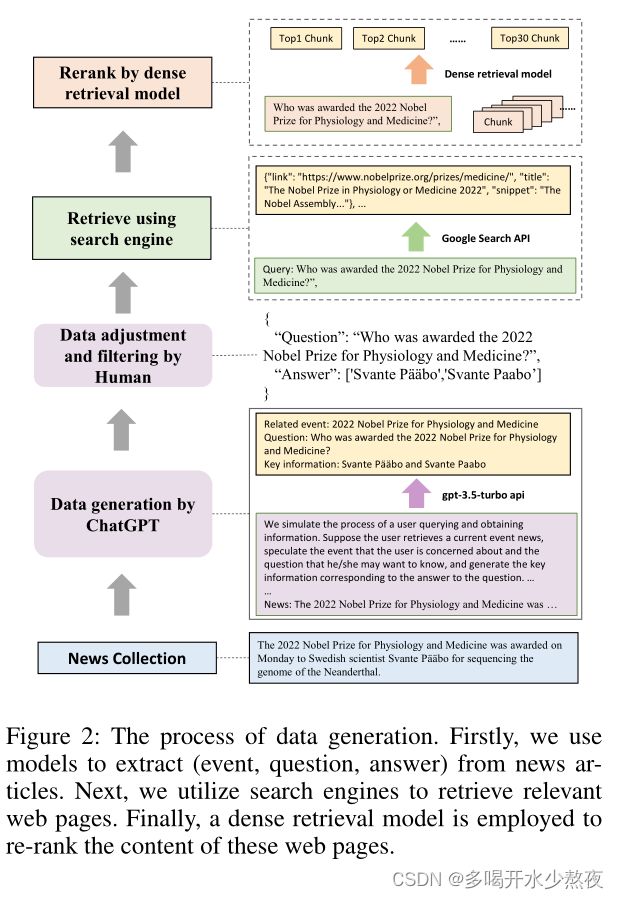

受先前LLM基准测试的启发,RGB使用问答格式进行评估。我们通过判断LLM对问题的检索增强反应来评估LLM。为了模拟真实世界的场景,我们使用实际的新闻文章构建问答数据。由于LLM中包含丰富的知识,在测量前三种能力时可能存在偏差。为了缓解这种情况,RGB的实例由最新的新闻文章构建。此外,我们通过搜索引擎从互联网上检索外部文档。最后,我们对语料库进行扩展,并将其划分为4个测试台,以评估LLM的上述基本能力。我们的数据构建的总体过程如图2所示。

QA实例生成 我们首先收集最新的新闻文章,并使用提示让ChatGPT为每篇文章生成事件、问题和答案。例如,如图2所示,对于一篇关于“2022年诺贝尔奖”的报道,ChatGPT将生成相应的事件、问题并提供回答它的关键信息。通过生成事件,该模型能够初步筛选出不包含任何事件的新闻文章。生成后,我们手动检查答案,并过滤掉难以通过搜索引擎检索的数据。

使用搜索引擎检索 对于每个查询,我们使用Google的API获取10个相关网页,并从中提取相应的文本片段。同时,我们阅读这些网页,并将其文本内容转换为最大长度为300个标记的文本块。使用现有的密集检索模型(ttps://huggingface.co/sentence-transformers/all-mpnet-base-v2 for English; https://huggingface.co/moka-ai/m3e-base for

Chinese.),我们选择与查询最有效匹配的前30个文本块。这些检索到的文本块,以及搜索API提供的片段,将用作我们的外部文档。这些文件将根据是否包含答案而分为肯定文件和否定文件。

为每种能力建造试验台 我们扩展了语料库,并将其划分为4个测试台,以评估LLM的上述基本能力。为了评估噪声鲁棒性,我们根据期望的噪声比率对不同数量的负面文档进行采样。对于阴性拒收,所有外部文件都是从阴性文件中取样的。对于信息集成能力,我们在上述问题的基础上进一步构建数据。这涉及到扩展或重写这些问题,使它们的答案包含多个方面。例如,“谁获得了2023年超级碗的MVP?”这个问题可以改写为“谁赢得了2022年和2023年的超级碗MVP。因此,回答这样的问题需要利用来自各种文件的信息。与前三种能力不同,反事实稳健性数据完全基于模型的内部知识构建。基于上述生成的问题,我们采用ChatGPT自动生成其已知知识。具体来说,我们使用提示来允许模型生成已知的问题和答案。例如,基于“谁获得了2022年诺贝尔生理学和医学奖?”的问题,该模型将生成已知的问题“谁获得2021年诺贝尔文学奖?”,并回答“Abdulrazak Gurnah”。然后,我们手动验证生成的答案,并如上所述检索相关文档。为了使文档包含事实错误,我们手动修改答案并替换文档中的相应部分。

最后,我们收集了总共600个RGB基本问题,以及200个关于信息集成能力的附加问题和200个关于反事实稳健性能力的附加问题。其中一半是英文,另一半是中文。

评估指标

该基准的核心是评估LLM是否能够利用提供的外部文件来获取知识并生成合理的答案。我们评估LLM的反应,以衡量他们的上述四种能力。

准确性用于测量噪声稳健性和信息集成。我们采用精确匹配方法,如果生成的文本包含与答案的精确匹配,则将其视为正确答案。

拒绝率用于测量负面拒绝。当只提供嘈杂的文档时,LLM应输出具体内容——“由于文档中的信息不足,我无法回答问题。”(我们使用说明告知模型。)。如果模型生成此内容,则表示拒绝成功。

错误检测率衡量模型是否能够检测到文档中的事实错误,以获得反事实稳健性。当提供的文件包含事实错误时,模型应输出具体内容——“提供的文件中存在事实错误。”(我们使用说明来通知模型。)如果模型生成此内容,则表明模型在文档中检测到错误信息。

纠错率衡量模型在识别错误后是否能提供正确答案,以实现反事实稳健性。模型被要求在识别事实错误后生成正确的答案。如果该模型生成正确的答案,则表明该模型能够更正文档中的错误。

度量的公式为

A C C = # t t # n u m s ACC = \frac{\#tt}{\#nums} ACC=#nums#tt

其中#tt是正确响应的数量,#nums是要评估的实例的数量。

考虑到该模型可能无法完全遵守指令,对于拒绝率和错误检测率,我们还使用ChatGPT对答案进行额外评估。具体而言,我们通过使用说明和演示来评估模型的响应,以确定它们是否能够反映文档中没有的信息或识别任何事实错误。

Experiments

在本节中,我们评估了各种LLM的性能,分析和讨论了结果,总结了现有LLM在使用外部知识时遇到的主要挑战。

Settings

任务格式 由于上下文限制,我们为每个问题提供5个外部文档。在我们关于噪声鲁棒性的实验中,我们评估了噪声比在0到0.8之间的场景。为了全面评估整体能力,我们对每种语言都采用了统一的指导,如图3所示。实验是使用NVIDIA GeForce RTX 3090进行的。

模型 我们对6个最先进的既能生成英语又能生成中文的大型语言模型进行了评估,包括ChatGPT3, ChatGPT (OpenAI 2022),

ChatGLM-6B (THUDM 2023a), ChatGLM2-6B (THUDM

2023b), Vicuna-7b-v1.3 (Chiang et al. 2023), Qwen-7B-

Chat (QwenLM 2023), BELLE-7B-2M (Y unjie Ji 2023).。

噪声鲁棒性结果

我们根据外部文件中不同的噪声比评估了准确性,结果如表1所示。我们可以看到:

(1) RAG可以有效改善LLM的反应。

LLM即使在存在噪声的情况下也表现出了强大的性能,这表明RAG是LLM生成准确可靠响应的一种很有前途的方法。

(2) 不断增加的噪声率对LLM中的RAG提出了挑战。

具体地,当噪声比超过80%时,模型的精度显著降低。例如,ChatGPT的性能从96.33%下降到76.00%,而ChatGLM26B的性能从91.33%下降到57.33%。

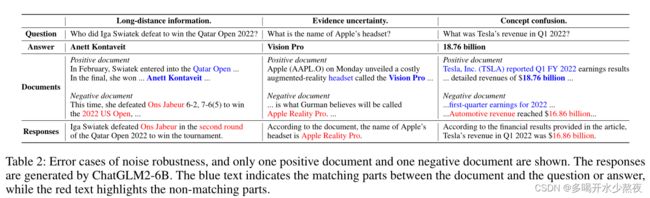

错误分析 为了更好地理解噪声对模型生成的负面影响,我们检查了不正确的答案,发现这些错误通常源于三个原因,如表2所示。

(1) 远程信息(Long-distance information) 在处理外部文档时,当与问题相关的信息与与答案相关的信息相距甚远时,模型通常难以识别正确答案。这种情况很常见,因为在互联网上经常会遇到较长的文本。在这种情况下,问题的信息通常在文档开头出现,然后使用代词提及。在表2中,问题信息(“2022年卡塔尔公开赛”)一开始只提到过一次,与答案文本“Anett Kontaveit”出现的地方相距甚远。这种情况可能会导致LLM依赖其他文档中的信息,并产生虚假印象,即幻觉。

(2) 证据不确定性 在备受期待的活动之前,比如苹果新产品的发布或奥斯卡颁奖典礼的宣布,互联网上经常会流传大量的猜测信息。尽管相关文件明确指出这是不确定或推测性的内容,但它们仍然会影响LLM的检索增强生成。在表2中,当噪声比增加时,错误文档的内容都是关于一些人对耳机(“Apple Reality Pro”)名称的预测。即使相关文件中有正确的答案(“Vision Pro”),模型仍可能被不确定的证据误导。

(3) 概念混淆 外部文件中的概念可能与问题中的概念相似,但不同。这可能会导致LLM混淆,并使LLM生成错误的答案。在表2中,模型答案集中在文件中的“汽车收入”概念上,而不是问题中的“收入”。

基于以上分析,我们已经确定了LLM在检索增强生成方面的某些局限性。为了有效地处理互联网上存在的大量噪声,需要对模型进行进一步的详细增强,如长文档建模和精确的概念理解。

否定拒绝试验台结果(Results on Negative Rejection testbed)

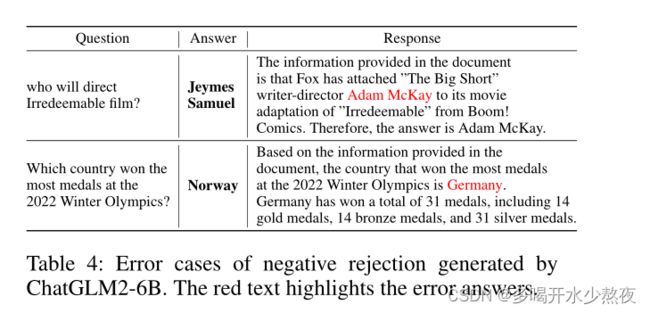

当只提供噪声文件时,我们评估了拒绝率。结果如表3所示。除了通过精确匹配评估拒绝率(表3中的Rej)外,我们还利用ChatGPT来确定LLM的响应是否包含任何拒绝信息(表3的Rej*)。我们可以看到:否定拒绝对LLM中的RAG提出了挑战。LLMs在英语和汉语中的最高拒绝率分别仅为45%和43.33%。这表明LLM很容易被嘈杂的文档误导,从而导致错误的答案。

此外,通过比较Rej和Rej*,我们发现LLM不能严格遵循指令,并且它们经常产生不可预测的响应,这使得它们很难用作状态触发器(例如用于识别拒绝)。

我们在表4中进行了案例研究。第一个错误是由于证据的不确定性。尽管文件中只提到了与“亚当·麦凯”的联系,并没有明确表示他是这部电影的导演,但模特仍然得出结论,他担任这个角色。第一个错误是由于概念混淆。答案中提供的信息与“2018年冬奥会”有关,而不是问题中提到的“2022年奥运会”。与直接回答相比,检索增强生成带来了更大的负面拒绝挑战,因为它提供了可能误导LLM并导致错误回答的相关文档。在未来的发展中,LLM提高其将问题与适当文档准确匹配的能力将是至关重要的。

信息集成试验台结果

我们根据外部文件中不同的噪声比评估了准确性,结果如表5所示。当将该模型与表1进行比较时,我们观察到它的信息集成能力较弱,这反过来又影响了它的噪声鲁棒性。我们可以看到:

(1) 信息集成对LLM中的RAG提出了挑战 即使没有噪声,LLM在英语和汉语中的最高准确率也只能分别达到60%和67%。添加噪声后,最高精度分别降至43%和55%。这些结果表明,LLM难以有效地整合信息,不太适合直接回答复杂的问题。

(2) 对于文档嘈杂的RAG来说,复杂的问题更具挑战性 当噪声比为0.4时,性能下降变得显著,但对于简单问题,只有在噪声比为0.8时才会出现显著下降。这表明复杂的问题更容易受到噪声的干扰。我们推测,这是因为解决复杂问题需要整合来自多个文档的信息,而这些信息可以被视为彼此的噪声,使模型更难从文档中提取相关信息。

错误分析 我们对ChatGLM2-6B(噪声比为0)进行了误差分析。除了在噪声鲁棒性实验中发现的类似误差(占总数的38%)之外,还有三种类型的独特误差。我们在表6中介绍了这些案例。

(1) 合并错误(占总数的28%) 该模型有时会合并两个子问题的答案,从而导致错误。它错误地使用了一个问题的答案来同时解决两个问题。此时,模型将忽略与一个子问题相关的任何文档。例如,在表6中,它错误地指出D组是法国和德国的世界杯小组,而事实上德国实际上被分到了E组。

(2) 忽略错误(占总数的28%) 有时,模型可能会忽略其中一个子问题,而只回答另一个子问题。当模型对问题缺乏完整的理解,并且未能认识到它由多个子问题组成时,就会出现这种错误。因此,该模型只考虑一个子问题的相关文件以生成答案,而忽略另一个子问题提出的问题。例如,在表6中,该模型只提供了2022年超级碗MVP的答案,而没有考虑2023年。

(3) 错位误差(占总数的6%) 有时,模型会错误地将一个子问题的文档识别为另一个子问题,导致答案不一致。例如,在表6中,第三个答案有两个错误:忽略错误和未对准错误。首先,这位模特只提到了2023年(第95届)奥斯卡最佳影片奖,完全无视2022年的奖项。此外,它错误地宣称《CODA》是2023年的最佳影片,而实际上它被评为2022年的最佳电影。

上述错误主要是由于对复杂问题的理解有限,阻碍了有效利用不同子问题信息的能力。关键在于提高模型的推理能力。一种可能的解决方案是使用思维链方法来分解复杂的问题(Zhou等人,2023a;Xu等人,2023b;Drozdov等人,2023)。然而,这些方法减慢了推理速度,并且不能提供及时的响应。

反事实鲁棒性试验台结果

为了确保LLM拥有相关知识,我们通过直接向他们提问来评估他们的表现。我们只考虑准确率超过70%的LLM。结果如表7所示。我们提出了以下指标:没有任何文档的准确性,有反事实文档的准确性、错误检测率和纠错率。我们可以看到,LLM很难识别和纠正文件中的事实错误。这表明模型很容易被包含错误事实的文件误导。

需要注意的是,检索增强生成并不是为了在给定的上下文中自动解决事实错误而设计的,因为这与模型缺乏知识并依赖于检索到的文档来获取额外信息的基本假设相矛盾。然而,由于互联网上有大量的假新闻,这个问题在实际应用中至关重要。现有的LLM没有处理错误信息引起的不准确回复的保障措施。事实上,他们在很大程度上依赖于他们检索到的信息。即使LLM包含有关问题的内部知识,它们也经常信任检索到的虚假信息。这对LLM中RAG的未来发展提出了重大挑战。

总结

在本文中,我们评估了LLM中检索增强生成的四种能力:噪声鲁棒性、负抑制、信息集成和反事实鲁棒性。为了进行评估,我们建立了RetrievalAugmentedGenerationBenchmark(RGB)。RGB的实例是从最新的新闻文章和从搜索引擎获得的外部文档中生成的。实验结果表明,当前LLM在这4种能力方面存在局限性。这表明,要有效地将RAG应用于LLM,仍需要大量的工作。为了确保LLM做出准确可靠的响应,谨慎行事并仔细设计RAG至关重要。