知识图谱de构建与应用(五):知识推理

目录

5.1 知识推理概述

5.1.1 知识推理的作用

5.1.2 专家系统与知识推理

5.1.3 神经网络与知识推理

5.2 基于符号逻辑的知识推理

5.2.1 基于本体的知识推理方法

5.2.2 基于规则的知识推理方法

5.2.3 基于规则学习的知识图谱推理

5.3 基于表示学习的知识推理

5.3.1 基于分布式表示的知识推理

5.3.2 基于神经网络的知识推理

5.4 基于图数据库的商品知识推理引擎工程实践

5.4.1 技术框架简介

5.4.2 与传统规则推理引擎的对比

5.5 可解释的商品知识图谱推理应用实践

5.5.1 电商应用背景

5.5.2 技术实践方案

5.5.3 实验结果及案例分析

5.6 基于强化学习的商品规则学习与推理应用实践

5.6.1 电商应用背景

5.6.2 技术实践方案

5.6.3 实验结果及案例分析

5.7 本章小结

本章系统介绍知识推理技术的方法,包括基于符号的知识推理和基于表示学习的知识推理等技术。同时,也介绍知识推理技术在阿里巴巴商品域上的一系列工程实践,包括在商品域上构建知识推理引擎、基于强化学习的规则学习与推理在商品域的实践等。

5.1 知识推理概述

5.1.1 知识推理的作用

知识图谱在应用层面上,从最初的知识化搜索——比如搜索一个人,同时返回其社交关系、历史成就和身份信息等相关知识,逐渐发展和应用到更广泛的领域,如网络分析、反欺诈和精准营销等。而支撑这些应用的基础就是知识推理。知识推理一方面可以用于推理缺失的或暗含的知识来丰富知识图谱;另一方面可以用来检查知识库的不一致信息,进行知识清洗。

1.知识丰富

虽然知识图谱中包含大量的结构化知识,但是这些知识往往是不完备的,例如:知识图谱里面可能包含血统关系(黄帝—玄嚣—蟜极—帝喾—挚/尧),尧是黄帝玄孙;舜是黄帝的七世孙(黄帝—昌意—颛顼—穷蝉—敬康—句望—桥牛—瞽叟—虞舜),禹是黄帝玄孙(黄帝—昌意—颛顼—鲧—禹),但是图谱里面尧和禹之间可能没有直接的关系。通过知识推理,我们可以推出尧和禹是远房兄弟,而舜则是他们的玄孙,进一步地,可以推理出他们之间不管是谁当天子,都是家族内天子位的传承,不存在传给“家外人”的“禅让”。形式化地,对于具有r(h,t)形式三元组的知识图谱,将使用推理方法预测表示实体和实体之间关系的新的三元组称为链接预测任务。链接预测是知识丰富的重要手段。除此之外,三元组判定也是常用的知识补全手段。形式化地,三元组分类可判断给定三元组r(e1,e2)是否正确。例如:“首都(美国,华盛顿)”是正确的,而“首都(美国,纽约)”是错误的。因此,从本质上来说,三元组分类是一个二分类问题。使用三元组分类进行知识丰富一般可以采用“选择-判定”的模式。首先,对于缺失的关系或实体,选择一个关系或实体来进行补全;其次,对补全的三元组进行二分判定,判断组建的三元组是否成立。

2.知识清洗

在过去的几年中,有越来越多的大型知识图谱以RDF三元组(对象,谓词,对象)形式存储事实知识,并具有数百万个相关事实,包括DBPedia、YAGO、NELL、Knowledge-Vault等。

但是,知识图谱的构建过程远非完美,因此这些知识图谱可能包含许多不正确的事实。

明确知识图谱的准确性对于改善其构造过程(例如,更好地了解各个处理步骤中提取的数据质量和缺陷),以及告知下游应用程序并帮助它们应对数据质量中的不确定性至关重要。

以前多依靠人工对三元组进行正确性的判断,然而,对现代的知识图谱而言,人工评估的时间代价和花销过高。因此,最常用的做法是在一个相对较小的三元组样本上手动标注,并根据这些样本对相关的三元组准确性进行推断。

基本的方法是从知识图谱中随机抽取三元组进行手动标注。虽然少量样本集可以降低人工标注成本,但有可能偏离实际准确性。为了获得统计上有意义的估计,必须对大量“足够”的三元组进行采样,因此标注成本也提高了。另一个实际挑战是知识图谱随着时间的推移而发展:随着提取新事实并将其添加到知识图谱中,其准确性也会随之变化。假设已经评估了旧版本的知识图谱,那么不希望从头开始逐步评估新知识图谱的准确性。

5.1.2 专家系统与知识推理

专家系统是人工智能领域中发展最为迅速、应用最为广泛的一个技术方向。

研究人员将社会专家的专业领域知识进行充分的整理和浓缩,使专家系统成为人工智能在产品实际应用中最具实用价值的人工智能技术之一。

专家系统主要处理的是行业专家或书本上的知识,正像在数据处理中数据是处理对象一样,所以专家系统又称知识处理学。其内容主要包括三大方面:

- 知识的获取、

- 知识的表示

- 知识的运用和处理

但是传统专家系统在实际应用中存在推理效率比较低、知识规则少、开发比较困难等缺点,影响了其应用的普及。

绝大部分专家系统都是介绍如何在各行业内对特有需求进行分析与决策。从人类的观点来看,所有这些领域内的需求都具有相同的抽象描述,即一般需求的分析与决策。

1.知识表示和管理缺陷

(1)人员要求缺陷。专家系统一般采用产生式知识表示方法进行描述。虽然大多数专家系统的开发可以采用性能优良的专家系统开发工具,但仍然要求系统开发者具备较强的人工智能理论水平和计算机开发应用水平,熟悉人工智能语言,如Lisp、Prolog语言。系统的开发也离不开知识工程师,从而极大地限制了专家系统的应用。

(2)知识库管理缺陷。使用这些人工智能开发语言也不利于知识的管理。系统开发者必须仔细地构建知识库,维护知识库的一致性,减少知识之间的冲突。虽然目前已有许多系统采用数据库系统管理知识,但大部分仍然仅用于简单存储规则知识,不能有效发挥数据库的功能。从应用的效果来看,专家系统的规则数量不宜太多。

(3)知识关系缺陷。一般情况下是不区分问题的现象与因果关系之间的差别的,它们都被统一称为知识库中的规则或知识。但事实上,问题的因果关系才是真正影响问题的产生和变化的主要因素,而现象只是问题的表现,只有抓住了因果关系,才可以正确、有效、高速地解决问题。

2.推理缺陷

(1)过分强调计算机的能力。在推理过程中,知识的匹配和冲突消解是专家系统中推理的根本问题,直接影响了推理的效率,这也是目前专家系统不容易解决较大问题的一个重要原因。这个问题是专家系统的固有问题,也是人工智能固有的问题,因为推理本身就是知识的搜索、匹配过程,容易出现组合爆炸。在目前的人工智能水平上,完全的机器推理仍然是一个难以实现的目标。

(2)不支持思维过程的反复性、跳跃性。将推理过程分为正向推理和反向推理和混合推理,过分强调推理的形式,不区分问题的现象和原因,从而增加了用户的使用要求,提高了系统的开发难度。而事实上,人类的思维过程是一个不断反复的过程,强调的是问题之间的因果联系而不是推理形式。

(3)缺乏强有力的解释功能。一般来说,推理的运行是一种黑箱操作过程,用户完全在计算机的引导下操作,不明白系统究竟是如何运行的,只有在推理结束后才能通过解释机制获得问题的解答。对许多用户来说,这样进行推理的很多步骤是没有必要的,既增加了系统开发难度,又浪费了用户的宝贵时间。

例如,这就像做数学应用题。结果是答案,推理是计算过程,解释就是对计算方法的说明。一道题可以有多种计算方案,或者说计算方法,但结果可能是一样的。

5.1.3 神经网络与知识推理

传统的知识推理可以分为演绎推理、归纳推理和默认推理。

- 演绎推理是从一般到个别的推理,其发展历史悠久,涵盖自然演绎、归结原理、表演算等方法。早在1935年,Gentzen就提出自然演绎推理,将推理形式化为引入经典逻辑的推理规则的数学证明过程。Robinson于1965年提出归结原理,它是一种采用反证法的推理方法。它将证明原逻辑表达式(由给定子句推出目标子句)为永真,转换为证明给定子句与目标子句取非的合取式存在矛盾的问题,然后进行归结。如果转换的逻辑表达式不可满足,推出矛盾,则原表达式为永真。表演算于1991年由Schmidt-Schauß和Smolka首次引入。该算法首先构建一个规则的完全森林,由带标签的有向图组成,每个节点用概念集标记,每条边用规则名标记,表示节点之间存在的规则关系,然后利用扩展规则,给节点标签添加概念或新的节点,进而基于完全森林进行演算推理。

- 归纳推理则可以追溯到1964年Solomonof创立的普遍归纳推理理论,是一个基于观察的预测理论。概括地说,归纳推理是从足够多的事例中归纳出一般性结论的推理过程。

- 默认推理是在1980年由Reiter正式提出的,是在知识不完全的情况下,通过假设某些条件已经具备进行的推理。

基于传统规则推理的方法在知识图谱上运用简单规则或统计特征推理。

NELL知识图谱内部的推理组件采用一阶关系学习算法推理。推理组件学习概率规则,经过人工筛选过滤后,带入具体的实体将规则实例化,从已经学习到的其他关系实例推理新的关系实例。YAGO知识图谱采用了一个推理机——Spass-YAGO。Spass-YAGO将YAGO中的三元组抽象化到等价的规则类,采用链式叠加计算关系的传递性,叠加过程可以任意地迭代,通过这些规则完成YAGO的扩充。Wang等人提出了一阶概率语言模型ProPPR(Programming with Personalized PageRank)进行知识图谱的知识推理。ProPPR构建有向证明图,节点对应“关系(头实体变量,尾实体变量)”形式的子句的连接或推理目标,其中起始节点为查询子句,边对应规则,即一个推理步,从一个子句归约到另一个子句。边的权重与特征向量相关联,当引入一个特征模板时,边的权重可以依赖于模板的部分实例化结果,如依赖于子句中某个变量的具体取值。同时,在图中添加从每个目标尾节点指向自己的自环,以及每个节点到起始节点的自启动边。自环用于增大目标尾节点的权重,自启动边使得遍历偏向于增大推理步数少的推理权重。最后,ProPPR中的推理基于图上的个性化评分实现。

总的来说,面向知识图谱的知识推理可以借鉴传统的知识推理方法。当规则、统计特征、本体频繁模式、本体约束/路径有效时,传统的推理方法准确率高。

现有的典型知识图谱内部由于要求高准确率,大多采用传统的推理方法。但无论是规则还是抽象层面的本体约束,都需要实例化,可计算性比较差,对于实例数量很大的知识图谱而言,代价很高。同时,有效并且覆盖率广的规则和本体约束难以获得,导致推理结果的召回率通常比较低。

而统计特征过分依赖已有数据,不易迁移,难以处理样本稀疏的情况;并且,当数据存在噪声时,抽取的特征甚至会误导推理。因此,面向知识图谱的知识推理逐渐发展出独有的具体推理方法,也就是基于分布式表示和神经网络的推理。

5.2 基于符号逻辑的知识推理

基于符号逻辑的知识推理方法按照知识图谱表现形式的不同,主要分为:

- 基于本体语言的知识推理方法

- 基于规则的知识推理方法

5.2.1 基于本体的知识推理方法

1.本体构建

随着互联网的飞速发展,科学家们逐渐意识到需要寻求新的方法和工具,来研究并管理爆炸式增长的网络信息和网络知识,而“语义网”就是这样一种能够满足人们对未来设想的智能化网络。语义网的概念由万维网联盟的Tim Berners-Lee在1998年提出,最早可以追溯到20世纪60年代末期的理论研究成果。作为一个高度智能化的网络,语义网不仅可以理解词语和概念,而且还能够理解它们之间的逻辑关系,可以使交流变得更有效率和价值,从而使整个互联网成为一个通用的信息交换媒介。

当前互联网体系是以“人”为核心构建的,互联网上的内容对于计算机来说只是一堆文字和图像,没有办法对其内容和背后的含义进行识别判断。而在语义网的设计理念中,推动互联网智能化的核心在于如何让机器“理解和处理”真实世界中的事务和概念,也就是如何将互联网上的数据转化为计算机能够识别和理解的语义“元数据”(meta-data),所以语义网是面向“机器”构建的。为此,研究者们将“本体”(Ontology)作为计算机科学领域新的知识表达形式,用于描述特定领域之中某种概念及其相互之间关系的形式化表达。

本体是一种特殊类型的术语集,具有结构化的特点,且更加适合在计算机系统中描述特定领域中存在着的对象类型、概念及其属性和相互关系,常见的本体构建要素包括领域、术语、属性、关系、约束与规则和事实数据等。以电商领域中的本体构建流程为例,将本体构建工作大致分为五个步骤。

第一步,确定领域范围,如当前为电商领域。接着需要确定该领域中的重要概念,即本体理论中的“术语”(Term)。图5-1中的每个节点(如商品、产品、场景、类目等)都是整个电商本体体系中的重要组成部分,它们刻画出该领域中的基础元素。

第二步,定义不同术语之间的关系,例如场景“适用于”商品、买家“买了”商品。如果将本体的属于类比于分类系统中“类”的概念,那么不同术语之间的关系就是类之间的特定关系。

第三步,因为目前计算机还不能分辨出每个类之间的区别,所以还需要为这些类定义各自的属性,例如“商品”有属性{商品名称、价格、颜色、款式…}。

第四步,一些规则(约束条件)也会被用来描述概念,例如商品名称与商品价格等属性有且仅有一个确定值。

第五步,在将电商领域内的本体体系描述出来后,需要做的就是根据本体定义导入真实数据,也就是将商品库、类目体系中的每一条数据按照其对应术语的定义构建图谱的事实层。这样一来,数据库中原本对于计算机来说不可理解的文档数据都能对号入座了。

2.基于本体描述语言的推理

由本体构建流程可以知道,本体在理论上是一种以新的数据定义和组织方式来管理知识的工具,从而使人和机器都能理解网络信息和知识。在构建知识图谱的过程中,需要定义一种标准的本体描述语言承载图谱的Schema和事实数据。

为了更直接地理解本体描述语言究竟是什么,可以将它和Java编程语言进行类比。

- 知识图谱中的基础术语和术语之间的关系就是定义好的类,每个类都有其各自的属性和一些必要的约束条件,

- 而客观数据导入的过程就是“实例化”的过程,包括实例化事实节点及节点之间的关系。

下面主要介绍三种本体描述语言,分别是RDF、RDFS和OWL,它们之间是继承和发展的关系。

(1)RDF。资源描述框架(Resource Description Framework,RDF)是W3C提倡的一个数据模型,用来描述万维网上的资源及其相互间的关系,其组成部分为资源(Resource)、属性(Property)和属性值(Value)。资源可以描述图谱中的任何对象,属性描述资源之间的关系或者资源本身的属性,属性值可以是资源或者具体的值,由资源-属性-属性值构成的三元组叫作“陈述”(Statement),例如卖家-卖-商品、用户-买-商品,而众多属性值就构成了一个完整的图谱(Graph)。目前,RDF序列化的方式主要有RDF/XML、Turtle、RDFa和JSON-LD等几种,下面给出一个Turtle语法实例,其描述了一条购买记录。

RDF的表达能力是有限的,它不支持图谱中术语的定义,缺乏对一类相同资源进行抽象的能力,只能对具体事务进行描述。无论是在图谱构建的过程中,还是在推理的需求中,RDF对事实数据进行抽象归纳的能力是非常重要的。另外,RDF无法表达层次关系结构。

(2)RDFS。RDFS(Resource Description Framework Schema)在RDF的基础上,通过新增Class、subClassOf、type、Property、subPropertyOf、domain、range等词汇,将模型语言中“类”的概念引入序列化方法中,同时能够更好地表达相关性。在表达形式上,RDFS和RDF没什么差别,结合概念层的层级关系和事实层数据就可以进行一些简单的推理。如图5-2所示,定义人、学生及导师之间的关系,其中Frank和Jeen分别是学生类和研究员类的实例化节点,而从概念层中存在“导师-有导师-研究员”的关系,所以对于该元组中头尾实体类的实例,可以推出研究员Jeen是Frank的导师。

图5-2 RDFS数据建模示例

这个推理过程的序列化表达为:

从这个例子可以看出,RDFS的优势在于对图谱的Schema进行了表达,而基于RDFS描述语言的推理过程从本质上来说是根据概念层类之间的层次化关系对事实层进行实例化关系补充,并没有做到真正的深层次“推理”。另外,RDFS的形式化表达能力有限,只能有类的层次、属性的层次及domain和range的定义,而且没有区分类和实例的属性。

(3)OWL。OWL(Web Ontology Language)是目前最规范、最严谨、表达能力最强的知识图谱表示语言。它使用扩充词汇库的基本思想在RDFS进行扩展,能够提供快速、灵活的数据建模能力和高效的自动推理能力。OWL语言对数据建模能力的提升主要表现在可以更加清晰地区分定义类属性和实例类属性,分别用ObjectProperty和DatatypeProperty词汇表示。

另外,OWL增加了描述属性特征的词汇,这些属性对于自动推理过程是非常有用的:

● TransitiveProperty表示该属性具有传递特性,例如“是老板”就是带有传递特性的属性:A是B的老板,B是C的老板,那么A肯定是C的老板。

● SymmetricProperty表示该属性具有对称特性,例如“一年级同班同学”属性具有对称特性,小红是小明的一年级同班同学,小明也是小红的一年级同班同学。

● FunctionalProperty表示该属性取值的唯一性,例如“年龄”属性的取值一定是唯一的。

● inverseOf表明当前属性与其他属性之间互为相反关系,例如“父子”和“子女”就可定义为对方的相反属性。

可以看到,这些属性特征本身就是一种很明确的推理逻辑,下面以TransitiveProperty词汇为例建立推理过程。

所以,增加这些词汇大大增强了自动推理能力。除了属性特征词汇,OWL还扩展了映射词汇表明类、实例和属性的相同情况,主要用在知识融合的过程中,这里不再展开。

总体来说,RDFS和OWL都是在RDF序列化表达的基础上扩展了词汇库,不仅将模式(Schema)和实例化数据融合进数据建模过程中,而且使本体语言有了一定的知识推理能力。通常将图谱中的概念术语知识,包括类本身的属性以及类之间的关系称为“公理集”,也叫TBox术语集,而事实数据层中的知识称为ABox断言集。

5.2.2 基于规则的知识推理方法

无论是RDFS还是OWL语言,都是在预定义好的词汇集合上根据公理术语推理,并不支持用户自定义的词汇,也不支持用户自定义推理规程。而实际的推理需求要复杂得多,比如需要对一个实例节点的多个属性联合约束,这是本体描述语言做不到的。于是,在知识图谱构建的过程中,允许用户在特定场景下自定义规则以满足灵活多变的推理需求。

1.规则的定义

规则是知识图谱数据中规律的抽象表现形式,包含条件和结论,根据规则所用知识场景的不同,可以将规则分为“TBox规则”和“ABox规则”。

TBox规则的条件和结论都只针对图谱概念层数据,不涉及实例数据,例如:

ABox规则的条件和结论中的对象都是图谱实例数据,例如:

2.基于规则表示语言的推理

规则表示语言是基于知识图谱的设计模型,将图谱中本身包含的逻辑规则和用户自定义规则表示为机器可识别的形式,目前常用的规则表示语言有SWRL、Notation 3(N3)logic、Datalog等。

(1)基于Datalog表示语言的推理。以Datalog表示语言为例,规则一般包含三部分,分别是规则头、逻辑关系符号及规则体,而规则头和规则体则可由更细粒度的原子单元组成,例如hasWife(x,y)。一个完整的规则表示为。

![]()

在使用规则表示语言推理时,除了规则,还需要图谱中的事实数据,而事实数据可以表示为没有变量且没有结论的规则,例如:

结合规则和事实数据就可以完成知识推理过程,得到推理结果。

![]()

(2)商品域基于规则表示的推理实践。因为推理过程会产生新的知识,所以知识推理一般设计为基于产生式规则的前向推理流程。而产生式规则与一般规则的主要区别在于规则结论中除了新的知识,还包含将新知识更新到知识图谱中的操作,这样在下一轮推理时使用的事实数据就是上一轮的推理结果,以此循环迭代,直到不再产生新的知识。在很多实际场景中,为了满足一些特定的需求,研究员们经常会开发一套规则语言满足定制化的需求。接下来,以商品域为例设计阐述规则的表示方式与推理流程。

1)总览。首先选择JSON格式对规则进行解析和保存,一条规则为一个JSON对象,它的一级属性主要有规则的name、body、tags,分别表示规则的名称、主体内容和键值对(KV)标签。标签主要用于给规则打上一些元数据信息,用于规则集的分流等。除了这三个,其余一级属性均视为附加属性,且可扩展。

2)规则的主体(body)。规则的主体内容都在body子对象中,涵盖了对事实的条件匹配逻辑与推理事实生成的逻辑。逻辑表达的设计是面向属性图的事实表达的,属性图是图的一种类型,具体由三部分组成:元素定义(definitions)、模式匹配条件(patterns)和结论(inferences)。

3)元素定义(definitions)。definitions子对象中存在此条规则内出现的每一个元素的定义。元素定义类似于定义变量的概念,具体定义的内容有变量名、变量类型、本体类型和属性约束条件,分别由id、type、class和constraints表示。假设需要描述“一个人汇报给他的上级”这种关系,本质上是要匹配“人-汇报给-人”这种事实元组,那么该规则至少需要3个元素,即变量类型为2个节点和1条边,节点的本体类型为“人”,边的本体类型为“汇报给”。

元素中含有属性约束字段constraints,用于进一步过滤元素指代的数据集合。每一个约束包含一个属性名(property)、类型名(type)和参数列表(args)。其中,属性名即对该元素的属性做约束;类型名是类似一个bool返回值的函数名称,如eq(相等)、gt(大于)、lt(小于)等;参数列表是一个列表,其中含有该约束类型对应所需的参数,例如gt(大于)是二目比较运算的约束,那么参数列表里就需要提供一个参数,用于表示元素属性值要比较的目标值。

4)模式匹配条件(patterns)。patterns定义的是元素之间的拓扑关系,用于匹配知识库中的一些模式。patterns的每一个基本单元是一个三元组,即起点-边-终点的形式,分别由src、relation、dst表示,这三个值分别对应元素定义(definitions)中的某些元素的id。注意,这里的src和dst指向的元素类型一定是点(在definitions中,type为Entity),relation指向的元素类型一定是边(在definitions中type为Relation)。如果patterns中任何一个值指向一个不存在的元素或类型不匹配的元素,那么此JSON格式文件不是一个合法的推理规则。例如,“两个员工汇报给同一个上级”,在该例子中,假设元素employee1、employee2、manager1、report1、report2都已定义好。

5)推理结论。推理结论实质是修改、增加、融合事实元素,因此一个推理结论对象有一个type字段,取值modify(修改已有元素)、merge(推理出新事实元素并与现有融合)和create(推理出新事实元素)。

5.2.3 基于规则学习的知识图谱推理

规则挖掘是知识图谱构建和应用中的一个重要任务,在知识图谱补全和纠错中都有应用。知识图谱中的规则的形式主要为霍恩子句规则(Horn Rule)、闭式路径规则(Clothed Path Rule)和语义关联规则(Semantic Association Rule)等。例如通过观察图谱中大量的样本,可以总结出“爸爸的爸爸是爷爷”这样的闭式路径规则,实际就是两个实体间如果通过一个中间实体由两个“父亲”的边连接,那么它们之间可以用一个“爷爷”的边直接连接。这就可以用来补全缺失的边。同理,如果已经有了这样的一条规则,还可以用于知识图谱的纠错。

目前,规则挖掘的主要方法有:

- 归纳逻辑编程(Inductive Logic Programming,ILP)、

- 基于关联规则挖掘、

- 基于图遍历的方法

- 基于表示学习的方法。

归纳逻辑编程和关联规则挖掘是通过基于统计的方法不断往规则体中增加约束实现的。

虽然基于图遍历的方法的可解释性强,可以直观地推理,但是在大规模知识图谱上会遇到性能瓶颈。

基于表示学习的方法在大规模图谱中比较有优势,但是可解释性不强,且在稀疏实体上由于无法充分学习到好的表示,效果较差。

1.归纳逻辑编程

通过已知规则在已有事实推理得到新的知识是演绎推理,与之相对的通过观察大量的事实,学习到背后的规则则称为归纳推理。归纳逻辑编程是人工智能领域一个较为传统的研究领域,它归纳出来的规则可以用逻辑程序的形式表示出来。归纳逻辑编程学习规则的方式是不断地为规则体中增加条件,如果增加条件后,覆盖的事实正例增加而负例减少,那么增加该条件就是可行的。

归纳逻辑编程最典型的算法是FOIL[80](First Order Inductive Learner),它通过序贯覆盖的方法逐条学习规则,在描述一个关系时,可能一条规则是不够的。在学习每一条规则时,目标关系作为规则头,而规则体一开始是空的。FOIL尝试向规则体中增加每一种关系作为一个条件,并计算增加该条件后知识图谱中符合该规则的正例数和不符合该规则的负例数,并从中选择增加正例比例最大的关系作为这一轮迭代最终添加的条件。当增加任何条件而正例比例都没有达到事先设定的阈值时,则该条规则学习结束。在学习下一条规则之前,从知识图谱中移除所有符合当前规则的正例。

使用ILP的方法在知识图谱中学习规则存在一些问题,这是因为ILP提出时所应用的知识库和现在的知识图谱是有区别的。首先,ILP在学习规则时需要正例和负例,但是在知识图谱中一般只有正例。然后,ILP方法存在一个封闭世界假设,即不存在于知识库中的知识都是错误的、不存在的,但现在的知识图谱中不存在的三元组只能说是未知的,不能确定一定是错误的。其次,ILP方法假定已经存在的知识一定是正确的,但现在的知识图谱中数据往往存在很多噪声。最后,当ILP方法提出时,知识库的规模还比较小,但现在的知识图谱量级都非常大,ILP方法在大数据量上性能非常低。

2.基于关联规则挖掘

基于关联规则挖掘的方法主要是针对ILP方法在知识图谱的应用中存在的效率低、知识不完备等问题做出改进而提出的,最典型的系统是AMIE[81]。

针对ILP方法挖掘规则效率较低的问题,AMIE首先对需要挖掘的规则的形式做了更强的约束,只挖掘闭式路径规则,即规则中所有的变量可以互相连接形成一个环。在向规则体中增加约束条件时,AMIE定义了三种原子操作。

● 添加悬挂边。边的一端是规则体中已有的变量,而另一端是一个在规则体中没有的变量。

● 添加实例边。边的一端是规则体中已有的变量,而另一端是一个在规则体中没有的常量,也就是实体。

● 添加闭合边。闭合边则是连接两个已经存在于规则中的元素(变量或常量)的边。

每一步从这三种类型的候选边中选择一条边。其次,为了进行剪枝,要求加入候选边之后,规则覆盖的实体的数量必须减少。通过这两个约束,提高了AMIE在解空间中搜索的效率,相比ILP,性能得到了极大的提升。

其次,由于ILP的封闭世界假设,使得其在知识图谱上评价规则时效果不好。AMIE更改了评价的方式,没有使用封闭世界假设,此时不存在于知识图谱中的知识不能算作负例。但是在评价规则时,需要计算一个规则覆盖的正例和负例。为了构造负例,AMIE使用了部分完整假设(Partial Completeness Assumption,PCA),即在知识图谱中,如果存在一个实体e的某个属性r,那么就认为它存在这个e的全部属性r。这个假设更改了AMIE计算规则的置信度的方式,使其能更准确地评估规则。

在AMIE之后,AMIE的作者又发布其改进版AMIE+[82]。AMIE+对AMIE的多个计算流程进行了优化,进一步提高了效率。

3.基于图遍历的方法

在基于图遍历的方法中,最典型的是路径排序算法[83][84](Path Ranking Algorithm,PRA)。PRA的目标是给定一个关系R,判断图中哪些关系路径可以推理出R。其做法是通过随机游走,找出大量由R连接的两个实体间的其他间接路径,并用这些路径作为特征,训练一个二分类器。给定一对新实体E1、E2,找出连接二者之间的路径,就可以用分类器预测它们之间是否存在关系R来做链接预测。同时,根据分类器特征的重要性,就可以找出与R强相关的路径,作为候选的规则。

PRA的学习阶段分为特征选择、特征计算和训练分类模型三步。

● 特征选择。PRA通过随机游走找出连接E1和E2的路径,并通过准确率(precision)和覆盖率(coverage)筛选,保留和关系R最相关的路径。准确率指给定路径π,通过随机游走,从E1到达E2的概率。覆盖率指路径π在多少个对由R连接的实体对间成立的概率。

● 特征计算。给每个路径计算特征值,除了常见的随机游走概率,还包括路径出现或不出现的二值特征,出现频次等。

● 训练分类模型。为每一个关系训练一个二分类器,可以是逻辑斯蒂回归和SVM等。

PRA算法的优点是发现的规则解释性强,缺点是存在严重的数据稀缺问题,在低连通的知识图谱上很难抽取到有效的特征路径,特征路径的抽取过程十分耗时且消耗内存,在大规模图谱上难以使用。

针对PRA的一些缺点,研究者们做出了一些改进。例如,在低连通的知识图谱上,人们提出了二元路径特征(Path bigram features)[85]、单边路径特征(One-sided Path features)[86]和向量空间相似度特征(Vector space similarity features)[87]等。针对随机游走的复杂性,随着路径长度呈指数级增长,提出了双向随机游走。针对PRA为每个关系单独训练一个分类器,忽视了关系互相之间的关联,提出了CPRA[88](Coupled Path Ranking Algorithm)。针对PRA只利用了目标实体对之间的路径作为特征,提出了Context-aware PRA[89],还利用了实体对之间的上下文特征。

近年来,随着知识图谱表示学习在很多任务中取得了较好的效果,也有将表示学习和PRA结合起来的尝试。第一种方法是特征融合,方法比较简单,就是把TransE模型的预测分数和PRA的预测分数作为特征重新训练分类器,取得了不错的效果。第二种方法是Path-based TransE,即除了TransE中原本的实体、关系的向量表示,还增加了路径的向量表示。最后打分函数也包含两个部分,一部分是TransE的三元组得分,另一部分是路径总贡献的得分。这些方法在链接预测的任务上都取得了不错的效果。

5.3 基于表示学习的知识推理

5.3.1 基于分布式表示的知识推理

基于分布式表示的知识推理的核心思想是利用事实元组的底层符号特性学习图谱的结构化特征表示。先通过表示模型学习知识图谱中事实数据的结构化信息,得到知识图谱的低维向量表示,再将推理过程转化为低维向量表示的简单操作。根据表示学习过程中对图谱中元组信息建模方式的不同,可以将这些方法分为基于转移的表示推理和基于矩阵分解的推理两大类。

1.基于转移的表示推理

基于转移的表示推理利用基于转移假设的评分函数,通过计算元素之间的距离对元组的合理性进行度量,评分函数得分越高,元组是事实数据的可能性就越大。通过尽可能拟合图谱中事实元组数据,得到实体和关系的向量表示。一种简单直接的假设认为事实元组中的关系本质上是该元组中头尾实体在空间中的转移规则,即头实体按照关系向量的转化规则就能得到(无限接近)目标实体。基于这个假设,Border等人[118]提出了TransE模型。受到Mikolov等人提出的词向量空间平移不变现象的启发[119],TransE将知识库中的关系看作同一个向量空间中实体间的某种平移向量,如图5-3(a)所示,对于事实元组(h,r,t)有h+r≈t,即头实体向量h和关系向量r进行平移,就能得到尾实体向量t。当训练模型时,使用L1或L2范数衡量头尾实体的距离,通过最小化

得分函数拟合图谱事实数据。为了防止头实体在转移过程中偏向于其他实体(非目标实体),一般的做法为随机替换元组中的头尾实体或者关系得到负样本。在推理阶段,通过得分函数对预测列表中的元素逐一计算,得分超过阈值的元素就可认为是合理的事实关系。

图5-3 TransE、TransH和TransR的简要说明

TransE模型的参数规模小,计算复杂度低,虽然其简单直接的平移假设能够很好地处理一对一的实体关系类型,但处理多属性映射的复杂关系能力尚显不足。以人物知识图谱中的两个事实元组(周杰伦,创作,听妈妈的话)和(周杰伦,创作,以父之名)为例,在训练模型时,实体“周杰伦”的向量表示经过关系“创作”的向量平移后,到达的点能同时无限靠近“听妈妈的话”和“以父之名”两个歌曲实体。因为实际上这两个歌曲实体本身还有其他不同的属性关系,它们之间的空间分布是不同的,这类冲突表明了TransE在处理一对多等复杂关系时是不够严谨的。

为了解决TransE模型在处理复杂关系时的局限性,Wang等人[120]提出了TransH模型,如图5-3(b)所示。在TransE的基础上为每一个关系都定义一个超平面Wr,然后模型会将元组中的头实体向量h和尾实体向量t按照法线wr投影到该超平面上,分别得到投影向量h⊥和t⊥,最后将得到的投影向量根据关系向量r平移。还是以上文中一对多的复杂关系为例,若知识图谱中已有事实元组(周杰伦,创作,听妈妈的话),而同时要让(周杰伦,创作,以父之名)也存在的话,TransE的处理方法是使得t听妈妈的话=t以父之名,而TransH将约束放宽,只要t听妈妈的话和t以父之名各自在关系r创作定义的超平面上投影相同即可,而在原向量空间中,这两个歌曲节点的距离可能非常远。另外,TransH使不同的实体在不同的关系下拥有了不同的表示形式,但由于实体向量被投影到了关系的语义空间中,故它们具有相同的维度。

Lin等人[121]在TransE的基础上提出了TransR模型,他们认为虽然TransH模型使每个实体在不同关系下拥有了不同的表示,但它仍然假设实体和关系处于相同的语义空间中,而每个实体由多个属性构成,不同的关系关注的实体语义特征是不同的,所以在对不同关系建模时,应该考虑其丰富的语义信息来调整向量的空间分布。如图5-3(c)所示,TransR的核心思想是每个关系都有其独立的语义空间,对于元组(h,r,t),空间映射矩阵Mr首先将实体向量h和t映射到当前关系r的空间下,得到新的实体向量h⊥和t⊥,然后使得h⊥+r≈t⊥。

相关实验表明,TransR模型通过空间映射的方法,能够显著提升推理性能,但它的设计理念在逻辑上仍然存在不合理之处。因为映射过程不仅与关系有关,同样也与实体本身有关,头尾实体本身的差异、和关系交互的过程都会给映射结果带来影响。为了优化这些问题,Ji等人[122]提出了更细粒度的TransD模型,即为实体和关系都设置了两个向量,向量组(h,r,t)用于表示实体与关系本身的含义,(hp,rp,tp)用于动态地构建映射矩阵。通过将映射矩阵简化为实体和关系向量的积,即Mrh=rphp+Im∗n和Mrt=rptp+Im*n,这样能够在TransR模型的基础上有效地降低模型的计算复杂度。

在上述方法的建模过程中都忽略了两个实际的数据问题。

● 异质性(heterogeneous):有的实体关系十分复杂,连接许多不同的实体,而有些关系又非常简单;

● 不均衡性(unbalanced):很多关系连接的头实体和尾实体数目很不对等。

针对异质性问题,Ji等人[123]基于TransR提出了TranSparse模型。其中,TranSparse(share)模型通过使用可变的稀疏矩阵代替TransR的稠密映射矩阵表征:关系连接的实体数量越多,关系越复杂,矩阵越稠密;关系连接的实体数量越少,关系越简单,矩阵越稀疏,从而防止对复杂关系欠拟合或者对简单关系过拟合。每个关系r都有对应的稀疏矩阵Mr(θr),其稀疏程度由模型参数

表示,也可以理解为关系r的复杂程度。其中,r*是连接实体数量最多的关系,即“最复杂”的关系,是它关联的实体对数量,以此关系为标准刻画其余关系的复杂度。在映射过程中,头尾实体共享映射矩阵Mr(θr)。而TranSparse(separate)模型为每个关系设置两个不同的映射(稀疏)矩阵和,用于反映关系连接的头尾实体数目不对等问题。在知识图谱数据中,异质性和不均衡性问题是同时存在的,但该模型的研究者们并没有将这两个模型融合,所以相较于TransD,TranSparse并没有在链接预测等多个推理预测类任务中取得显著的效果提升。

以上这些方法都是使用不同的映射规则改造TransE的简单平移假设,从而提升模型处理复杂类别关系的能力,但同时也大大增加了计算成本。与这些模型的改造思路不用,TransM[124]模型认为复杂度不同的关系对于模型训练的贡献度也是不同的,通过为图谱中的每一个事实元组设定权重表示映射的程度,而在一对一、一对多、多对一、多对多四种类型的关系中,只有一对一的实时元组不会发生冲突,应该拥有较高的训练权重,而且不同关系的权重不同。一种简单的度量三元组(h,r,t)权重的方式是统计尾实体在关系r的情况下平均连接头实体数hrptr=#(Δr)/#(distinct(tr)),以及和头实体在关系r的情况下平均连接尾实体数trphr=#(Δr)/#(distinct(hr)),其中Δr表示所有包含关系r的事实元组,然后得到训练样本(h,r,t)的训练权重wr=1/log(hrptr+trphr)。这种假设的优势在于能够在训练前根据事实数据预先计算出每个样本的权重,训练时的计算开销与TransE大致相等。

从本质上讲,TransE采用了欧式距离作为相似度量方式,而这种各向的同性度量方法将各个维度的特征都等同看待,无法体现出各个维度的重要性,所以很难表示知识库中实体或关系的多样性和复杂性,而且上述基于TransE的改进模型都只使用L1或L2范数作为评分函数,不够灵活。基于上述考虑,Xiao等人[125]提出了TransA模型,为每一个关系r都设定一个对称非负权值矩阵Wr,也就是为实体向量的每一个维度都配置了一个可学习的权重参数,并采用自适应的马氏距离定义评分函数,将TransE的一般式

修改为(h+r-t)TWr(h+r-t),对权重矩阵进行矩阵分解,对角元素的值就是不同向量维度的权值。如图5-4(a)所示,如果采用欧氏距离,会误预测为最近的实体;而如图5-4(b)所示,通过调节y轴方向维度的权重,这三个实例都能预测到正确结果。

图5-4 传统模型和TransA模型比较

目前,绝大多数基于转移的表示学习方法都是使用知识图谱中的三元组来学习结构化特征的,事实上知识图谱中除了三元组,实体之间还包含了大量的层级结构。如图5-5所示,以Freebase中的实体层次结构为例,拥有多种类型的实体在不同场景下表达的含义是不同的,并且是由它的实体层次结构决定的。Xie等人认为不同类型的实体应该有不同的表示,他们将层级类型作为实体的映射矩阵,通过组合实体层级结构上一级一级的内部节点的映射矩阵得到最终的实体表示,并且提出了用两种层次类型编码对层次结构建模。除此之外,类型信息也可以作为约束条件使用,分别用于训练时的负采样和预测时候选实体的过滤阶段。在训练时,和以相同概率选取负样例不同,他们提出基于软类型约束负采样方法,倾向于选择在特定类型下相同类型约束的实体,从而增加相似实体间的距离。而在预测过程中,移除不属于特定实体类型的候选实体。

图5-5 Freebase中实体层次类型举例

此外,还有许多研究工作除了对知识图谱中的事实元组进行建模,还加入一些其他形式的信息增强表示学习,例如Guo等人[126]通过引入实体类别信息,使得向量表示空间在语义上是平滑的,使得属于相同类别的实体在语义向量空间中相互靠近,从而学习到更准确的实体表示。而Wang等人[127]使用远程监督的方法,首先使用实体回标描述文本获得该实体的上下文信息,然后以此训练实体词与上下文中其他重要单词的共现网络,最后通过共现网络将实体上下文融入知识图谱,并基于转移模型和事实元组联合建模。

Xiao等人[128]认为很多表示学习方法在建模时都将实体映射到了一个精确的点,虽然有些方法已经通过平面和空间映射处理复杂关系类型,但映射后的结果本质上还是一个点。ManifoldE模型通过将三元组中的尾实体位置从一个点扩展到一个流形(球体),即元组中头实体向量与关系向量相加后得到的是基于轨道的流形函数,这种扩展方法在链接预测任务中取得了很好的效果。

He等人[129]认为,知识库中的关系和实体的语义本身具有不确定性,而过去模型中都忽略了这个因素。因此,He等人提出KG2E,使用高斯分布表示实体和关系。其中,高斯分布的均值表示的是实体或关系在语义空间中的中心位置,而高斯分布的协方差则表示该实体或关系的不确定度。

图5-6为KG2E模型,每个圆圈代表不同实体与关系的表示,它们分别与“Bill Clinton”构成三元组,其中圆圈大小表示的是不同实体或关系的不确定度,可以看到“Nationality”的不确定度远远大于其他关系。

图5-6 KG2E模型

KG2E模型将实体和关系表示为从多变量高斯分布中抽取的随机向量:

h~N(μh,Σh)

t~N(μt,Σt)

r~N(μr,Σr)

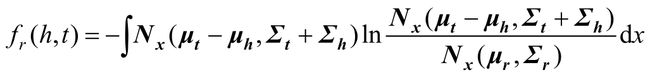

式中,μh、μt、μr是均值向量;Σh、Σt、Σr代表协方差矩阵。然后,受到平移假设的启发,KG2E模型通过测量t-h和r两个向量之间的距离为一个事实评分。主要通过两种方法测量,一种是通过KL散度(KL距离):

另一种是计算概率的内积,即:

fr(h,t)=-∫Nx(μt-μh,Σt+Σh)Nx(μr,Σr)dx

式中,μ=μh+μr-μt,Σ=Σh+Σr+Σt利用高斯向量表示。KG2E可以有效地对知识图谱中实体和关系的不确定性进行建模。

在解决关系多语义问题时,TransG模型[130]首先对高斯分布的实体进行建模:

式中,σh和σt分别表示头实体和尾实体分布的方差;I为实体向量集合。

然后,针对关系的每一个语义学习一个高斯分布表示,并且使用高斯混合模型自动发现关系的隐性语义:

式中,

是混合因子,表示关系r中第i个组件的权重。

最后利用向量中包含不同隐性语义的头尾实体对建模三元组。传统模型与TransG模型的对比如图5-7所示。其中三角形表示正确的尾实体,圆形表示错误的尾实体。图5-7(a)中为传统模型示例,由于将关系r的所有语义混为一谈,导致正确的和错误的实体无法被区分开。如图5-7(b)所示,TransG模型通过考虑关系r的不同语义,形成多个高斯分布,就能够区分出正确实体和错误实体。

图5-7 传统模型和TransG模型比较

2.基于矩阵分解的推理

矩阵分解的基本思想是将整个知识图谱看作一个三阶矩阵,把事实元组中的实体表示为向量,将关系表示为矩阵,最终通过矩阵分解的方法进行表示学习。RESCAL[131]是典型的矩阵分解模型,如图5-8所示,对于知识图谱中的第k个关系,所有实体对在关系下的潜在成对交互结果可以表示为Σk=ARkAT,其中矩阵A是知识图谱中所有实体的向量表示,矩阵Rk为该关系的非对称矩阵表示,而计算结果χk量中的每个元素都代表了对应元组对在当前知识图谱中的客观概率。若当前元组是事实元组,则当前元素为1,否则为0。通过最小化误差函数

![]()

学习实体和关系的表示,其中ai和aj分别表示元组中的头尾实体。相比于基于转移的模型,基于三阶矩阵分解的方法大大增加了学习成本,训练速度更慢。

为了加快计算过程,DistMult[132]模型将RESCAL中的关系矩阵简化为关系向量,而在矩阵分解时,将关系向量扩展为对角矩阵:Gr(h,t)=hMrt,其中Mr=dialog(r),这种简化使得源元组中的头尾实体向量按照对应维度交互计算。根据向量元素相乘法则,模型在学习元组(h,r,t)的特征时,默认将(t,r,h)也作为正样本,而在实际情况中这种假设是不合理的。为了结合上述两种方法各自的优势,HolE模型[133]将元组中的元素都表示为维度相同的向量,然后通过形式化操作,将元组中的头尾实体向量组合为一个维度不变的向量,用于表示该实体对的交互结果。具体地,[h*t]i表示元组中头尾实体的形式化操作结果,其本质为头尾实体向量按照维度循环对应的方法进行元素相乘:

式中,d表示向量维度。

图5-8 RESCAL模型矩阵分解示例

可以发现该循环操作是不可逆的,这也就解决了DistMult模型的缺陷,而且整个训练计算过程都是元素级别的对应维度相乘,计算成本远低于RESCAL模型,如图5-9所示。最后,由形式化操作得到的向量表示和指定关系向量,得到计算该元组的得分:

图5-9 RESCAL、DistMult和HolE模型的简单图解

除了通过循环操作使实体交互不可逆,ComplEx模型[134]利用复数向量表示的不可交换特性解决秩分解操作不适用于非对称关系的问题,从而对DistMult模型进行扩展。具体做法是以复数向量表示实体和关系,元组的评分函数定义为:

式中,Re(·)表示取复数的实部;Im(·)表示取复数的虚部,最终以计算结果的实数部分作为预测结果,从该评分函数可知,在训练过程中每个元组的交互过程并不可逆。

3.基于表示学习的方法

知识图谱的表示学习通常用在实例级别的链接预测等任务中,但是近年来也有一些工作将其用于本体层面的规则学习,这是因为通过表示学习,可以避免图遍历算法学习规则时搜索空间太大,导致效率极其低下的问题。同时,将规则用向量表示的方式结合到知识图谱实体和关系的表示学习过程中,也能提高后者的学习效果。

(1)EmbedRule模型[90]。由于知识图谱中的规则多为通过路径进行推理,因此通过关系的向量表示挖掘出路径规则是最直观的做法。在目前众多的基于关系映射的知识图谱表示学习的方法中,加法模型和乘法模型是最常见的两种,即假设知识图谱中存在一条三元组(e1,r,e2),那么它们的向量表示满足:

(1)加法模型:e1+Vr≈e2

(2)乘法模型:e1*Mr≈e2

在加法模型中,关系的向量表示通常是一个向量,和实体的向量表示一样。而在乘法模型中,关系的模型是一个矩阵。考虑一个长度为2的路径规则:

R1(a,b)∧R2(b,c)⇒R3(a,c)

即关系R1+关系R2=关系R3。记实体a、b、c的向量表示分别为ea、eb、ec,在加法模型中,关系R1、R2、R3的向量表示分别为V1、V2、V3,在乘法模型中,关系R1、R2、R3的向量表示分别为M1、M2、M3。对于加法模型:

ea+V1≈eb, eb+V2≈ec, ea+V3≈ec

由此可以推出:

V1+V2≈V3

即在加法模型中,如果关系R1+关系R2=关系R3,那么R1的向量表示与R2的向量表示之和约等于R3的向量表示。同理,在乘法模型中:

eaM1≈eb,ebM2≈ec,eaM3≈ec

由此可以推出:

M1 M2≈M3

即在加法模型中,如果关系R1+关系R2=关系R3,那么R1的向量表示与R2的向量表示做矩阵乘法,约等于R3的向量表示。对于长度为n的路径规则,有:

V1+V2+…+Vn=V或M1M2…Mn=M

这样,在通过任一加法或乘法的知识图谱表示学习方法学习出每种关系的向量表示之后,就可以通过寻找满足上述两种等式的关系来发现它们之间的规则。当知识图谱中的关系种类较多时,寻找满足上述等式的关系的空间将变得较大,此时可以利用知识图谱中关系的域(Domain)和范围(Range)过滤掉那些明显不可能的关系组合。在实验中,EmbedRule可以以更快的速度挖掘出比AMIE系统更准确的规则。

4. IterE模型[91]

在IterE模型中,作者进一步扩展了用关系的向量表示可以学习出的规则的种类。在EmbedRule模型中,通过等式

V1+V2≈V3或M1M2≈M3

学习出来的规则是路径规则,或者称为链式规则。实际上,通过关系的向量表示之间的运算关系,还可以学习出其他类型的规则。在这里,论文作者选取了表达能力更强的乘法模型,并且定义了表5-1所示的规则类型。

表5-1 规则类型

除了链式关系,还包括反身性、对称性、传递性、等价、子关系和相反等其他关系之间的关系。通过这些关系的性质,可以更好地做知识图谱三元组的补全和纠错。

此外,通过关系向量学习规则的好处在于,规则的学习可以反过来更好地学习实体向量和关系向量。在知识图谱的表示学习中,一个难点在于稀疏实体和关系无法充分的学习,因为样本太少。通过规则学习,可以利用规则补充这些稀疏实体的三元组,之后再重新训练表示学习模型,得到更好的实体向量和关系向量,然后又可以重新做规则学习,发现更多的规则,如此迭代,让整个系统的效果越来越好。IterE在稀疏实体的链接预测等任务上表现出了非常好的效果,同时也以更快的速度学习出了比AMIE+系统更好的规则。

5.3.2 基于神经网络的知识推理

近年来,深度学习在人工智能的各个领域中均取得了突破性的成功,基于神经网络的知识推理也应运而生,取得了一些令人兴奋的成绩,成了知识推理不可或缺的技术模块。本节将主要从循环神经网络(RNN)、图神经网络(GNN)和预训练模型介绍基于神经网络的知识推理。

1.基于循环神经网络的知识推理

使用神经网络可以进行更复杂的推理,用于补全知识图谱。

由于篇幅有限,这里仅介绍一篇代表性论文Chains of Reasoning over Entities,Relations,and Text using Recurrent Neural Networks。

该论文基于RNN在大规模知识图谱中进行知识推理,改善了精度和可操作性。

● 之前的工作仅推理了关系,没有推理组成路径上节点的实体,该论文对关系类型、实体和实体类型进行了联合学习和推理。

● 使用了注意力机制对多条路径进行推理。

●之前方法的最大问题是要为每一个需要预测的关系类型单独训练模型。而该论文只训练一个RNN来预测所有的关系类型。另外,由于训练的多任务特性,共享了RNN参数,精度也得到了显著提高。

首先介绍Path-RNN结构,该论文的改进正是基于此。其输入是两个实体之间的路径,输出是推理出来的二者之间的新关系。通过将关系之间的连接用RNN表示进行推理。路径表示则在处理完路径中所有关系之后,由RNN中最后的隐含层状态给出,如图5-10所示。

从图5-10中可以看到,知识图谱中连接两个实体Melinda和Seattle的关系可以有多条路径,从中可以推理出两个实体间可能存在lives in的关系。

如图5-11所示,在RNN每一个时间步里,输入的是路径上实体和关系的向量,实体的向量表示可以从它的类型中获得,路径向量为最后的隐含层输出,最终的Query关系类型和输出的路径向量内积即为该关系类型的置信度。置信度越高,表示这两个实体的关系的可能性越大。

这个模型的缺点是对每一个关系类型都要训练一个新的模型,变量无法共享,造成模型参数量过大。除此之外,只选择相似度最高的一条路径可能会忽略掉其他路径隐含的信息,造成计算浪费。

针对上述问题,该论文作者对模型做出了以下改进。

● 共享关系类型的表示以及RNN的权值矩阵,大大减少模型参数。训练模型的损失函数用的是负对数似然。

●分别用Top-k、average和LogSumExp方法为每一条路径的相似度评分加上权重,综合考虑了每一条路径包含的信息,而不仅仅是得分最高的那条路径。

该文提出的模型使用单个RNN就可以在多种关系类型之间推理,且综合利用了多条可能路径以及路径间所有实体和关系的信息,提高了精度。然而,由于数据的稀疏性,在处理较长的文本特征时,性能会减弱。

2.基于图神经网络的知识推理

真实世界中的很多数据集都具有图或网络的形式,比如社交网络、知识图谱和互联网等。直到近几年,针对图结构数据的神经网络模型(图神经网络)才逐渐成了研究的热门领域。

在过去的几年中,将神经网络泛化到任意结构的图结构引起了人们的注意,产生了很多相关的学术研究[137-143]。之前由核方法、基于图的正则化等方法主导的领域逐渐被这些新兴的技术替代。接下来简单介绍近年来图神经网络的一些进展以及各种方法的优缺点。

谈到图神经网络,文献[144,145]堪称开山之作。

(1)GCN。将广泛使用的RNN或者CNN之类的神经网络模型用于任意图结构的数据是一个巨大的挑战。近年来,一些论文采用特定问题引入特定结构的方法,另一些利用光谱图理论定义参数化的过滤器,用在多层神经网络模型中,类似于经典的CNN模型。在Kipf&Welling(ICLR,2017)中,作者采用了一个近似的方法简化,并且在很多情况下有了更高的训练速度和更高的精度,取得了当时图数据集上最佳的分类效果。

目前,大部分图神经网络大体上都具有一些共性的结构,一般称为图卷积网络(Graph Convolutional Network,GCN),卷积的名字是由于参数在图中的所有位置是共享的。

对这些模型来说,目标是在输入特征以及图上拟合一个函数。

输入有以下几部分:每个节点i均有一个特征向量x,由此得到特征矩阵X,维度是N×D,N是节点数量,D是输入特征维度;图结构的一个描述,通常以邻接矩阵A的形式表示。

输出是一个节点级别的矩阵Z(N*F),F是输出节点的特征维度。

每一层的神经网络有如下形式:

H( l +1)=f (H(l), A)

式中,H(0)是初始化的X矩阵;l是层数。不同的模型区别是f的选取及如何参数化。

举一个简单的例子,考虑下面一个简单的每一层的传播形式:

f (H(l), A)=σ(AH(l)W(l))

式中,W(l)是每一层的权值矩阵;σ(·)是非线性激活函数,比如ReLU函数。

首先阐述简单模型的两个局限性,矩阵A左乘意味着将某个节点周围所有的节点特征向量求和,但是没有包含自身(除非图中有自循环结构)。可以通过简单地增加单位矩阵的方式解决。

第二个主要限制是A没有归一化,这样会导致的问题是乘A之后,向量的大小数量级会发生变化。通过归一化的方式使A所有的行加起来为1可以解决这个问题。通过以上两个对策,可以得到Kipf&Welling(ICLR,2017)引入的传播法则:

式中,

,其中I是单位矩阵;是的节点度数的对角矩阵。

在GCN提出之后,基于GCN的研究成了图表示学习领域一个十分热门的研究方向。很多GCN的变体相继问世,接下来将着重介绍几个最新的模型结构,包括R-GCN、N-GCN及MixHop。

(2)R-GCN。众所周知,知识图谱在工业界中有着广泛的应用,尤其是问答和信息检索领域。知识图谱的构建和维护需要花费巨大的人力,尽管如此,大部分的知识图谱还是不完整的。不完整意味着节点信息缺失或者节点间缺少关系边等。不完整性直接影响下游任务的准确性。这就引入了两类标准的知识图谱补全任务,一个是链接预测(Link Prediction),另一个是实体分类(Entity Classification)。现实中,知识图谱的关系是多元的,普通的GCN缺乏对该类数据的建模能力。R-GCN的提出正是为了解决该问题,在实体分类和链接预测上取得了当时最佳的效果。

如图5-12所示,节点是实体(具有属性),边是关系(具有类型),橙色部分是缺失的信息,需要通过已有图谱信息推断补全。

图5-12 知识推理实体关系示意图

在用神经网络关系建模之前,首先需要理解什么是关系型图(Relational Graph),关系型图就是有向的带标签的多元图。

有向带标签的图:

G=(V, E, R)

式中,节点(实体)νi∈V带标签的边(关系)(νi,r,νj)∈E;r∈R是关系类型。引入如下单层网络结构:

式中,

表示节点i在关系r∈R下的邻近节点集合;ci,r是问题特定的归一化常量,可以通过学习或者事先给定(比如采用邻近节点数量)来确定。

直观上来说,上述公式将变换后的所有邻近节点特征向量以归一化的形式求和,和普通GCN不同的是,R-GCN引入了特定关系的变换(权值矩阵与关系的类型和方向有关)。上述公式可以如图5-13所示。

整个R-GCN模型通过堆叠L层上述网络实现,每一层的输出作为下一层的输入,第一层的输入如果没有额外的信息可以由每个节点的独热向量表示。实体分类时计算每个节点的损失,链接预测时加上一个解码器,最简单地可以用DistMult将一条边上两个节点的输出向量映射到一个得分函数,以表示这条边的置信度,来计算损失,如图5-14所示。

图5-13 R-GCN模型单层网络结构

图5-14 R-GCN模型整体网络结构

(3)N-GCN。GCN已经证明在结构化图数据上能有效提升半监督学习的效果。与此同时,随机游走在图向量表示(Graph Embedding)的半监督学习上已有明显效果。因此,一个自然而然的想法是能否结合两者的优势,N-GCN(2019)正是基于此。通过训练多个GCN实例,组合成一个网络提升表达能力。

基于图的半监督学习在现实世界中应用广泛,以实体分类为例,其目标是给定一部分带标签的实体,获得其他剩余实体的标签。例如社交网络,希望预测用户的兴趣标签。在多数情况下,收集节点的标签信息是非常困难的,然而节点之间的边是容易获取的(通过直接的关联或者间接的计算相似度关联)。

传统的GCN虽然可以通过堆叠GCN层实现多步的信息流动,类似于多层CNN感知域扩大的道理。

模型结构如图5-15所示。考虑如下K个GCN实例:

每一个GCN输出一个矩阵,每一行代表每个特定的GCN某个节点的向量表示。

图5-15 N-GCN模型结构

可以将K个GCN输出拼接起来用于分类器子网络。这种联合训练的方式可以让分类器学习到不同的GCN表示,类似于随机游走的效果。

分类器子网络有如下两种方式,一种是全连接,另一种是采用注意力机制。这两种组合方式在机器学习中也十分常见,一般来说,基于注意力机制的效果会略微好一些,考虑到不同的子网络结构对于最终结果的影响权重是不同的,则有

(4)MixHop。传统的GCN模型传播示意图如图5-16所示,缺乏对邻近关系的一般化表示。

MixHop模型对此进行了改进,如图5-17所示。

图5-16 传统GCN模型传播示意图

图5-17 MixHop模型传播示意图

MixHop在本质上是通过邻接矩阵的幂表示一跳邻近节点关系之外的多跳关系。类似CNN,传统的GCN相当于卷积核大小为3,虽然也可以通过堆叠层数的方式扩大感受野,但这种方式不够直接。最直接的是在CNN网络中采用多种不同大小的卷积核,这种思想在GCN中应用就是MixHop模型。可以看到,上述结构即使是一层也能看到周围更多的邻居节点,特征向量表达更丰富。

3.基于预训练模型的知识推理

近年来,预训练语言模型在NLP领域中大放异彩,比如ELMo、GPT、BERT和XLNet等。

这些方法通过大量的语料来学习词向量的上下文语境关系。其中最具代表性的是BERT模型,通过Masked语言模型和下一句预测作为损失函数,在预训练的权重中可以捕获很丰富的语言学特征。

在以往的知识图谱向量表示模型中,往往只包含三元组信息,具有稀疏性,缺乏大规模的其他文本语料信息。

因此,能不能将预训练模型用来学习知识图谱的向量表示呢?答案是可以的。

KG-BERT将两者融合了起来,在链接预测、三元组分类、关系分类等任务上取得了当时最佳的效果,证明了模型的有效性。具体来说:

- 首先将实体关系三元组当作文本句子,将知识图谱补全任务转化成序列分类任务。

- 用微调后的预训练模型预测三元组或某个关系的概率。

预测三元组置信度的KG-BERT模型如图5-18所示。

预测实体关系的KG-BERT模型如图5-19所示。

5.4 基于图数据库的商品知识推理引擎工程实践

本小节介绍一种基于图数据库的推理引擎的实现方法,以及在商品领域的应用工程实践。

5.4.1 技术框架简介

推理引擎基于知识图谱,其处理的任何数据都需要通过知识建模能力预先定义并管理,以此为规范进行规则管理和规则执行。通过这种建模方式可以保证底层数据结构稳定,避免业务数据结构的变动影响底层数据结构,同时推理引擎的输入表和输出表结构一致,利于多次推理迭代。

如图5-20所示,推算引擎技术框架主要分为三层。

1.规则层

规则层负责处理相关规则的定义、校验、存储、加载和转换等操作,重点介绍规则的定义和转换,如图5-21所示。

(1)规则定义。模型设计采用组件化的思想,将页面表达和逻辑实现分开,以达到解耦合、复用的目的,主要包含以下五个核心概念。

● 组件(Component):代表一个前端渲染的组件,可以是简单的文本框,也可以是复杂的自定义控件,组件同时会定义好渲染和数据提交的格式。

图5-21 推理引擎规则类图

● 组件实例(ComponentIns):代表了一个业务化之后的组件。比如组件定义的是一个下拉框,那么组件实例就会补充下拉框有哪些可选项,同时还可以有一些样式方面的调整。

● 条件(Condition):当保存规则时,用户输入的具体数据,格式参照组件中定义好的数据提交的格式。

● 条件组(ConditionGroup):若干条件的集合,一个条件组中的条件为AND关系。

● 规则(Rule):若干个条件组以及若干个条件(也称动作或推理结论)的集合。

规则管理原型图如图5-22所示。

图5-22 规则管理原型图

(2)规则转换。为了更好地支持规则在多平台上执行,采用类AST+Visitor模式,以便将规则转换为Gremlin、HIVE等语言,以及JSON等数据格式。采用Visitor模式对于未来增加新的目标语言或数据格式非常友好,规则本身以及AST都不需要变化,只需要增加新的Visitor即可。

● AstTree:代表了一个类AST的实例,在规则比较简单的情况下,该树设计为三层即可,如图5-23所示。当然,如果扩展性较好,可根据业务需要增加层。在转换过程中,会以后续遍历的方式遍历所有的节点,最终在根节点合并成最终的结果。

图5-23 推理引擎AstTree结构图

● GroupTreeNode:AstTree的子类,表示AST的一个非叶子节点,多个叶子节点的集合。

● AttrTreeNode/RelationTreeNode:AstTree的子类,表示AST的叶子节点,同组件有一一对应的关系,分别表示属性、关系节点。

● GremlinVisitor:Visitor的一个实例,负责将AST转换为正确的Gremlin表达式;OdpsVisitor/JsonVisitor,顾名思义,分别将AST转换为hiveSQL和JSON数据格式。

● Evaluator:对AstTree使用指定的Visitor执行转换。

● AstTreeFactory:将一个具体的规则构建成一棵AstTree,再通过不同的Visitor转换为不同格式的数据,在新增组件时,只需修改这个类即可。

2.拓扑层

建立推理拓扑网络是整个推理流程最重要的部分。基于频率统计最大化复用中间结果构建计算任务执行图(TaskFlow),它借鉴了Rete算法,类似其中的α网络和β网络。Rete算法的一个重要思想是以规则中最细粒度的模式匹配为基础构建整个推理网络。当规则较多时,同一个模式匹配会在多个规则中出现,可以通过复用模式匹配结果的方式降低匹配次数,从而提升整体的匹配效率。如图5-24所示为频率统计最大化示例。

图5-24 频率统计最大化示例

如果一条规则的条件包含多个关联关系的声明,那么执行匹配的过程其实就是根据每个最细粒度条件组的数据融合成完整条件组的匹配结果。如果规则按照从左至右的方式融合,会产生很多的中间临时数据,当规则量大时,会产生很大的开销。若事先统计每种条件出现的频率,按照频率优先的方式融合匹配数据,中间结果数量就会大大减少,因为越细粒度的匹配数据,越有可能被其他规则提及,产生的数据结果就可以直接拿来使用。如图5-25所示,中间结果只有2种,而每条规则都按照从左至右的顺序执行,会产生4种中间结果。当规则集大小以万计时,这两者的差距就会非常的明显。

如果实体或关系数据集数量过亿、规则数据集数量过万,则还需要增加一个步骤——拓扑优化,根据阿里巴巴的实际业务场景,我们尝试过以下几种重要的优化手段。

(1)建立条件决策树。对规则中涉及的条件进行分组拆分,并整体构建出一棵决策树,引入预处理,找出可能会命中的条件组再匹配,大大提升条件过滤的效率。

(2)合并过滤节点。对同一个节点下游的多个过滤条件节点进行合并,能减少总任务的个数。在规则数过万的场景下,可将执行图中的几万个节点合并成为十几个节点。

图5-25 拓扑结构示例

(3)条件组冒泡前移。执行图的上游是拓扑匹配和融合的节点,中游是属性条件组过滤的节点,下游是推理事实生成的节点。上游在合并数据的过程中,在极端情况下可能会产生数据爆炸,导致流程执行失败。可以尽可能地把中游的条件过滤提前在上游节点中执行,从而大大减少了下游的节点处理的数据量,在避免数据爆炸的同时,极大地提升了整体效率。

3.执行层

执行层分为在线推理和离线推理两种执行流程。

在线推理流程主要针对单一规则,转换为Gremlin语句在图数据库上进行实时查询,并实时返回结果。也可以通过设置查询条件,缩小数据集,进行复杂规则的样本预跑,以验证规则的正确性。

离线推理流程则主要针对复杂规则,通过底层分布式计算引擎进行全量推理迭代。拓扑层最终生成的执行图(TaskFlow)是一个有向无环图(DAG)。执行层会调用分布式计算引擎,根据TaskFlow中任务的先后顺序执行推理任务,全部完成后进行事实融合,如果有需要,则进行新一轮迭代推理,否则将产出结果并结束推理。

5.4.2 与传统规则推理引擎的对比

推理引擎的规则采用弱化的一阶逻辑语言,出于效率的考虑,不支持逻辑非(NOT)和或(OR),其中或逻辑可以通过拆分成多条规则的方式实现。规则主要有两部分——规则体和规则结论。其中,规则体的描述可以抽象成定义本体和关系,如商品-类目是-类目;定义本体和关系边上的属性约束,如类目的名称是教育普及。规则结论可以抽象成两种:增加关系,在满足规则体条件的指定本体之间添加一条关系边;设置本体属性值,在满足规则体条件的指定本体上增加一个或修改某个属性的值。

这样设计到底有什么好处?与传统规则引擎又有什么差异呢?规则引擎相对很好理解,有多少条规则,就都执行一遍,得到结果即可;推理引擎也可以执行相同的规则,同时它还支持逻辑的抽象表达,并且具备连续推导能力。

1.抽象能力——拓扑抽象

先看两个规则:

规则1:如果商品x的类目是“教育普及”,那么它就适用于“幼教”场景。

规则2:对于任意商品x,它的类目假设是y,如果已知类目y能够关联场景z,那么商品x适用于场景z。

规则1是规则引擎能够执行的一个典型规则,可以明显看出它是关于“教育普及”和“幼教”的,对于不是“教育普及”的商品,这条规则与它没有关系;而在规则2中,不存在任何具体的商品、类目或场景,而仅仅是描述本体间的一个关联关系,只要存在任何本体满足这种关系,就可以推出相应的结论。

正如前文所述,类似规则1这样的称为实体(ABox)规则,规则2称为本体(TBox)规则。实体规则往往靠数量取胜,每条规则仅针对某些特定的情况生效;本体规则往往数量少、概括性高,单条规则可能会推导出很多的事实,它是一种描述普适的公理的知识。从实践层面讲,一个成熟的推理系统往往会沉淀足够多的(几十条的量级)、纯手写的本体规则,再结合大量的(千万级及以上)、可能是算法生成的实体规则。

2.抽象能力——概念抽象

这是一种利用图谱的本体建模信息,实现抽象本体类别的推理能力。例如,“人”是一种本体,“警察”是“人”的子类,即任何警察都是人。那么,当有一条本体规则“如果人x和人y是朋友关系AND人y和人z也是朋友关系,那么x和z也是朋友关系”,这时系统会把包括警察和其他人在内的所有实体都列入搜索的范围,即规则中隐含了“警察与人是朋友”“人与人是朋友”“警察与警察是朋友”等所有的关系形式。

3.推导能力

推导能力是指引擎能够自动根据现有事实推理得出的结论,结合规则中所有的逻辑断言,持续不断地推理事实的能力。如图5-26所示,有这样三条探案相关的规则:

● 如果x和y坐过同一辆火车A,且乘坐时间相同,那么x和y是同行关系。

● 如果x和y同行过,那么他俩认识。

● 如果x与案件B有涉嫌,x与y相互认识,那么y与案件也有涉嫌。

推理引擎可以根据现实数据中坐同一辆火车、人与案件的涉嫌关系,自动推导出全量的涉案可疑人员。重要的是,推理引擎的规则库内的规则是无序的,每条都是独立的知识,引擎有能力自主寻找逻辑的前后依赖顺序,保证在最终产出的推理数据中,所有满足规则集内条件的实体都产生了规则对应声明的结论。

综上所述,推理引擎和规则引擎的对比如表5-2所示。

5.5 可解释的商品知识图谱推理应用实践

5.5.1 电商应用背景

在真实的电商知识图谱推理应用中,不同于通用领域的知识图谱推理和补全,真实业务有鲜明的特点:

- 首先,真实业务不会追求大而全的知识图谱补全,而会根据业务设定不同的补全目标;

- 其次,真实应用往往是人机协作解决问题的,一方面算法专家开发了推理算法模型进行推理,另一方面业务人员把握针对业务的数据透出以及筛选,但他们通常不是算法专家,很难理解黑盒模型算法预测的结果,因此可解释性的挑战在实际应用中尤为明显;

- 最后,在电商知识图谱中,规则是重要的一部分,规则具有良好的可解释性、可迁移性及可编辑性,是沉淀业务逻辑和知识的重要方式。

我们在这项研究中强调了真实应用的三种需求:有偏推理、可解释性及规则学习,并提出了一体化解决方案。

目前,阿里巴巴的商品知识图谱尽管规模巨大,与其他的知识图谱类似,商品知识图谱中依然有大量的数据缺失,因此知识图谱补全是一个重要的任务。

但在补全的过程中,发现电商领域应用中的知识图谱补全与通用的知识图谱补全具有显著的不同:在实际应用中往往不会进行大而全的补全,而是在特定时间进行针对特定任务的补全。

如图5-27所示,对于一个特定的业务任务,例如品牌补全和商品推荐,会重点补全任务相关的目标关系。

补全的结果是与目标关系相关的三元组和规则,这些新的三元组会由业务人员检查其正确性,新增的规则会被添加进现有的规则池中,沉淀为业务知识。

从以上的分析可以看出,电商知识图谱应用具有明显的任务特点及人机协作特点,为了避免繁重的模型设计任务,同时促进人机有效协作,在电商知识图谱补全中有三个对算法的期望。

● 有偏推理:算法能够针对一个或多个指定的目标关系进行定向的补全。

● 可解释性:算法能够为预测结果提供解释,以辅助终端用户或业务人员理解预测结果。

● 规则学习:算法能产生可以推理出包含目标关系三元组的规则,以支持在其他场景上的快速重用或迁移。

近些年,许多有效的、可微的知识图谱向量表示学习方法被提出,并且在许多知识图谱任务上得到了广泛的应用,在商品知识图谱补全中,也打算应用可微的知识图谱推理方法对其进行补全;但是经过分析,现有的方法很难满足前面提出的三个需求。

第一,目前的知识图谱向量表示学习模型研究将知识图谱中的所有关系均作为目标关系,并以综合所有关系的链接预测效果评估其补全能力,对于有偏链接预测任务,这样做不仅会在非目标关系上耗费训练时间,且无法保证目标关系上的预测结果,尤其是当目标关系是样本较少的关系时,因此不符合前文提出的第一个期望;

第二,多数知识图谱向量表示学习模型通常以单个三元组作为输入,其计算过程无法建模不同三元组之间的推理关系,较难提供有价值的解释,是典型的黑盒模型,因此不符合第二个期望;

第三,规则也是商品知识图谱中重要的一部分,它有助于描述业务逻辑、沉淀业务知识,促进商品知识图谱的完善和应用,但多数知识图谱向量表示学习模型仅能完成三元组补全任务,不具有补全规则的能力,因此不符合第三个期望。

为了适应有偏推理任务,一种简单直接的方法是采用已有的知识图谱向量表示学习方法并仅对包含目标关系的三元组进行训练,可是这样就损失了目标关系与非目标关系之间的连接信息。因此,理想的方法应该自动地选择当前预测所需要的信息,以保证较好的预测效果。

为此,我们提出了满足这三个期望的一体化解决方案,将预测的解释视为多个三元组的组合,为了方便提供解释,算法应该建模目标三元组与其他三元组之间的相关性,并作为生成解释的基础。由于任意一个解释,都可以看作某条规则的一个实例。基于解释,我们提出了一种新颖的逆实例化过程,能够从解释中生成规则。

5.5.2 技术实践方案

1.基本网络架构设计

如前文分析,设计满足电商应用期望的模型的核心是在预测过程中构建三元组之间的关联关系,因此提出三元组的(h,r,t)的得分函数计算应该不仅基于h、r、t的向量表示h、r、t,同时还应取决于其邻居三元组的相关表示。本书提出的推理框架借鉴了图神经网络(Graph Neural Networks,GNN)的思想。图神经网络是一种在非欧几何空间表示图的方式,最早由Franco提出,其是为图中的每个节点学习一个向量表示,并通过信息传播机制使这些向量表示包含当前节点的邻居节点信息。

在这个工作中,定义(e1,r,e2)的一阶邻居三元组为(e',r',e1),其中一阶邻居三元组的尾实体为e1,将e1称为“共享实体”。同理,三元组(e″,r″,e′)是(e′,r′,e1)以e′为共享实体的一阶邻居三元组,同时是(e1,r,e2)的二阶邻居三元组,更高阶的邻居三元组定义依此类推。在模型中,首先设计一个基本网络层(Basic layer),如图5-28(a)所示。

对于目标三元组(h,r,t),基本网络层首先根据(h,r,t)的一阶邻居三元组中包含的实体和关系计算出共享实体h的向量表示,并且假设在聚合共享实体的向量表示过程中,每个邻居三元组的权重揭示了其对于目标三元组的重要性。为了提升模型对于高阶邻居三元组的敏感性,可以叠加多层基本网络层。

图5-28 三元组模型

图5-28(b)展示了一个两层的三元组模型,先将目标三元组的二阶邻居三元组的信息聚合到它的一阶邻居三元组中,然后再将一阶邻居三元组的信息聚合到目标三元组中,这样最终h的向量表示能够同时汲取其一阶邻居和二阶邻居的三元组信息。

给定一个目标三元组(h,r,t)和它的邻居三元组集合N,生成四个矩阵H、R、T和A,其中H ∈ R|N|×d、R∈ R|N|×d及T∈ R|N|×d分别表示当前输入邻接子图中所有三元组的头实体向量表示、关系向量表示及尾实体向量表示,其中H|N|=h、R|N|=r、T|N|=t。A∈ R|N|×|N|表示当前输入子图的邻接矩阵,并且如果在当前子图中Nj是Ni的一阶邻居三元组,那么Aij=1,否则Aij=0。

由于每个三元组Ni∈N都有可能是其他三元组的以ti为共享实体的一阶邻居,因此为每个三元组Ni∈N计算其潜在共享实体的向量表示:

St=H+R

式中,St∈ R|N|×d,

是Ni的共享尾实体的向量表示,当Ni是其他三元组Nj的以ti为共享实体的一阶邻居三元组时,可以理解为这个向量包含了Ni能够传递给Nj的信息。

类似地,每个三元组Ni∈N都可能在N中拥有以hi为共享实体的一阶邻居三元组,因此为每个三元组Ni∈N计算其潜在的共享实体的向量表示:

Sh=T-R

式中,Sh∈ R|N|×d,

是Ni的共享头实体的向量表示,当其他三元组Nj是Ni的以hi为共享实体的一阶邻居三元组时,可理解为这个向量包含了Ni期望其他三元组传递给它的信息。

有了Sh和St以后,通过向量点积计算每个向量表示对之间的相似度:

C=Sh(St)T

式中,C∈ R|N|×|N|是一个表示不同三元组之间的相似度矩阵;Cij是Ni和Nj之间的相似度,Cij值越大,Nj对Ni的重要程度越高,因为它们具有相似的共享实体表示。

C中包含了输入子图N中所有可能的三元组对之间的相似度,但并不是所有子图中的三元组对都是一阶邻居三元组,将C和邻接矩阵A∈ R|N|×|N|按位相乘:

C′=A◦C

经过计算之后,如果在子图中,Nj如果不是Ni的一阶邻居,那么Cij=0。

然后对C′中的每一行进行归一化,具体操作为:

式中,exp(x)=ex,且对于所有

,可以解释为一个当从Nj向Ni聚合信息时,Ni对于Nj的注意力权重。

有了Cn和St后,对于Ni∈N中的共享实体向量表示聚合:

S+=CnSt

式中,

。

通过一个基本网络层,可以通过一阶邻居三元组获得(h,r,t)的共享头实体的向量表示。

正如前面介绍的,来自一个基本网络层的S+聚合了三元组的一阶邻居三元组信息,为了让模型能够感知到更高阶的邻居,基本网络层被设计为可叠加的。在叠加多层基本网络层的过程中,将上一层基本网络层的输出S+代替H输入新的网络层中,即

S1=layer(A,H,R,T,N)

S2=layer(A,S1,R,T,N)

…

Sm=layer(A,Sm-1,R,T,N)

式中,Si∈ R|N|×d表示第i层中经过聚合的共享头实体向量表示S+。

有了来自不同层的对于目标头实体的聚合表示

,通过以下方式对它们进行聚合:

![]()

式中,wk是一个超参数,表示来自第k层表示的重要性;bh∈R1×d是最终的h的向量入表示。

计算目标三元组的得分:

S( h , r , t )=‖bh+r-t‖

这个函数评估了经过平行翻译后的头实体向量表示与尾实体向量表示的近似程度。

采用基于间隔的损失函数作为最小化的优化目标:

式中,T是训练集;(h′,r′,t′)∉T表示(h,r,t)的一个负样本,是通过随机替换头实体或尾实体得到的。

采用基于梯度的优化方法对损失函数进行优化求解,直至模型收敛。

2.生成解释

将解释以类似规则的形式展示:

explanation→prediction

式中,prediction表示目标三元组;explanation由一个或多个三元组组成,因此一条解释可以展开为如下形式:

(h1,r1,t1)∧(h2,r2,t2)…∧(hl,rl,tl)→(h,r,t)

这个解释表示的意思是因为知识图谱中存在(h1,r1,t1)、(h2,r2,t2)和(hl,rl,tl)等三元组,所以模型预测(h,r,t)是正确的,其中l表示解释的长度。由于解释中包含的三元组本身是无序的,为了保证解释表示的唯一性,增加了两个限制,即ti=hi+1和tl=h,这样解释中包含的三元组构成一条路径,如果h1=t,那么整条解释会构成一个闭环。

为每条解释生成一个置信度值 α∈[0,1],值越高则说明解释越可信。解释的置信度可以从模型本身包含的l个基本网络层生成。解释中的三元组(hi,ri,ti)的信息是在第i层被表示的,并且它和下一层的三元组的相关性是包含在Ci中的,即第i层的Cn。因此通过如下方式计算α:

式中,

是矩阵Ck第i行第j列元素对应的值,表示了在第k层Nj对于Ni的贡献度;wl是第l层的权重,对于一个包含l层的模型,一共有n+n2+…+nl种可能的解释,在解释生成的过程中,为每种可能的解释都计算一个置信度并选择置信度排序前k的解释作为最终的解释。

3.生成规则

从解释中生成规则,因为解释和规则具有相似的表示形式,唯一的区别是解释中全部是知识图谱中包含的三元组,而规则中包含了实体变量,因此解释也可以看作规则的实例。由于通过将规则中的变量替换为具体的实体可以得到规则的实例,那么反过来,通过替换解释中的实体为变量也就可以得到规则。因为规则中的变量应该是不同原子之间共享的,因此通过将解释中的共享实体替换为变量生成规则,生成规则具体可分为两种类型,具体形式如下:

(V1,r,t)←(Vl-1,rl,Vl)∧(Vl,rl-1,Vl)∧…∧(V1,r2,V2)∧(h1,r1,V1)如果h=h1

(V1,r,Vl+1)←(Vl-1,rl,Vl)∧(Vl,rl-1,Vl)∧…∧(V1,r2,V2)∧(Vl+1,r1,V1)如果h≠h1

式中,Vi表示变量,每一条解释可以生成对应的唯一一条规则,同时不同的解释可能生成相同的解释。为了控制生成规则的质量,将从至少m条解释中生成的规则作为高质量规则,因为如果一条规则可以频繁地从解释中生成,那么这条规则一定是在数据中普遍存在的。

以上提出的方法满足了真实应用中对有偏推理、可解释性以及规则学习的重要需求。

5.5.3 实验结果及案例分析

1.有偏推理

为了验证提出的方法是否有满足前文提出的电商应用中的三个期望,首先进行了有偏的链接预测(Partial Link Prediction,PLP)实验和两个只包含一个目标实体的有偏链接预测特例的实验,然后对生成解释的质量进行了评估,评估的方式采用了统计评估和人工评估两种方式,最后对规则的质量进行了评估,从生成的规则数量、高质量规则数量和比例来分析。

整个商品知识图谱是非常大的,在实际应用中,很少对整个商品知识图谱进行补全,通常都是对某个特定的领域补全。我们进行了两个特殊的有偏链接预测方面的实验,它们在电商应用中是非常常见的任务,在这两个案例中,目标关系都只有一个,两个任务具体如下。

(1)场景推荐。在商品知识图谱中,有一类特殊的实体叫作“场景”,例如“度假”和“宅在家”等,用于描述和定义人们使用商品的情形,它能在一定程度上反映用户的喜好。给用户推荐属于同一个场景的商品可以极大地提升所推荐商品的多样性,避免同质化的推荐,提升用户体验。在商品知识图谱中,在场景和商品之间构建了一个特殊的关系——“适合于”,场景推荐任务就是为给定的商品推荐其适合的场景,即预测(商品x,适合于,?),这个任务对应的数据集是PLP[life.]。

(2)自动分类。在商品知识图谱中,为了更好地组织包罗万象的商品,我们构建了一个商品类目体系,每个商品都会挂载到至少一个类目中。在日常业务中,商品类目有助于快速召回目标商品,因此补全商品和类目之间的关系具有重大的业务价值,这个任务对应的数据集是PLP[cate.]。

这两个任务的数据如表5-3所示。

表5-3 两个任务的数据

在实验过程中,我们采用了2层的模型,分别在PLP[life.]和PLP[cate.]数据集上训练。对比模型在PLP[all.]数据集上训练,因此数据对的对比模型都是可用的。表5-3中展示了两个任务的实验结果,从中可以看出,我们的方法在场景推荐任务上实现了略优的效果,在自动分类任务上实现了与对比模型差不多的效果。但很明显,我们的方法的数据利用效率更高,在两个任务中的模型分别只使用了2.23%及0.25%的三元组作为训练目标,而对比模型使用了100%。这说明我们的方法在预测时可以充分利用局部的邻居三元组信息。

2.解释评估

我们采用了两种方式对解释进行评估,一种是基于统计的评估,用Recall和AvgSupport作为评估指标;另一种是人工评估,主要评估算法提供的解释能否帮助人们更快地判断一个预测为正确的三元组的合理性。

对于我们的方法,根据1层并使用TransE作为初始化的模型,为每个测试三元组生成排序前3的解释。作为对比,采用了同样的方式为TransE模型生成了解释。为了形成公平的比较,使用了一阶邻居三元组为TransE生成解释。

图5-29展示了依据统计分析的评估结果,从Recall来看,两种方法都可以为95%以上的测试三元组提供解释,相比于TransE,我们的方法能够实现略好的效果,当k值变大时,Recall也会进一步增加。从AvgSupport来看,我们的结果明显优于TransE,平均能为每个三元组的解释提供600多个支持样例。当k由1增加到3时,我们的方法的AvgSupport持续增加,而TransE稍有下降,说明我们提供的前3的解释具有同等的解释效果;而在TransE中,排序第二、第三的解释质量明显比排序第一的质量差,这说明我们提供的解释整体质量比TransE要好。

图5-29 依据统计分析的评估结果

(a)模型能给出解释的预测结果占比

图5-29 依据统计分析的评估结果(续)

(b)模型能给出解释的预测结果的平均支持个数

在商品知识图谱应用中,为算法提供预测解释的初衷是让业务人员更快地审核算法预测结果是否合理,因此我们对解释进行了人工评估,以衡量解释能否帮助人们更快、更准地判断三元组的正确性,从而提升人机协作的效率。

在这个实验中,我们将一定数目的预测三元组展示给电商业务人员,并让他们判断给定的预测三元组是否正确。这里有两个设定,一种是给他们提供算法生成的解释,另一种是不提供任何解释。然后统计在不同设定下,它们判断的准确率以及判断使用的时间,表5-4展示了基于人工的解释评估结果。

表5-4 基于人工的解释质量评估结果

从判断准确率来看,在提供了来自TransE的解释后,人工判断的准确率相比于不提供解释稍有下降,而在提供了本方法的解释后,人工判断的准确率和不提供解释相近,这说明提供解释的质量好坏会影响人工判断的准确率。从效率角度来看,在提供了解释之后,人工判断的速度明显提升了许多,基于TransE的解释业务人员只需要原来时间的91.28%即可完成判断任务,而基于本方法的解释则平均只需要原来时间的56.9%就能完成相同的任务,这说明了提供解释后能够显著提升人工审核的效率,能够在业务应用中提供巨大的价值。

3.规则解析

我们从三元组的解释中生成规则,这里将有效的规则定义为至少从5个不同的解释中生成的规则,高质量的规则设定为头覆盖度(HC)大于0.7的规则。对比模型选取了最常用的规则挖掘方法AMIE+。在实验过程中,我们约束规则长度不超过3,同时也与从TransE中生成的规则做了对比,如表5-5所示。

表5-5 规则质量评估结果

在AMIE+中,没有挖掘出有效规则,因为AMIE+最擅长的是挖掘路径式的规则,而这类规则在目前的电商知识图谱中并不常见。两种从解释中生成规则的方法都有不错的效果,分别学习到八九千的有效规则以及一两千的高质量规则。

综合所有的评估指标,本方法的效果明显优于TransE,学习到的有效规则和高质量规则分别比TransE多589和593条,高质量规则占比也比TransE高15.36%。

为了证明规则的用处,还展示了这些高质量三元组在实验数据集上推理出的新三元组个数,其中根据TransE的规则可以推理出50948个三元组,根据本方法可以推理出163452个新三元组,这两个数字都比测试数据集中包含的三元组多,其中本方法推出的新三元组个数更是与训练集中包含的三元组个数不相上下,这说明商品知识图谱确实是不全的,并且规则在补全知识图谱任务中可以发挥巨大的作用。

5.6 基于强化学习的商品规则学习与推理应用实践

5.6.1 电商应用背景

在电商实际应用中,每个商品都会被挂载到若干个场景中,以图结构中的节点形式存在。商品由结构化信息表示,以键值对(PV)形式存在。场景(LifeStyle)的价值则在于打通商品实体之间的联通,提供跨域的实体搭配,因此新的商品必须通过规则库中的规则挂载到特定的场景才能进入电商的运营体系。商品场景的样例如图5-30所示。

图5-30 商品场景的样例

规则的作用则包括挂载新的商品以及为已有的商品新增挂载场景,目前规则库中的规则主要由人工构造,通过审核之后才能进入规则库。商品场景挂载的规则特点是规则体部分只由PV组成,规则头部分只包含单个场景。规则的形式如下:

LifeStyle←(P1,V1),…,(Pn,Vn)

人工构造规则的方法效率低、成本高,因此商品场景挂载规则学习任务就是利用算法从现有的商品场景数据中生成规则,提高规则生成的效率,降低人工成本。现有规则库中的规则样例如表5-6所示。

表5-6 现有规则库中的规则样例

业界常用的规则学习baseline是关联规则挖掘,用于发现数据集中项与项之间的关系,通过挖掘数据集中存在的频繁项集来生成规则。这种方法适合数据项之间没有差异的数据集,比如著名的购物篮分析应用中,不同的商品都可以看作同种item。而在实际应用中,常常需要挖掘不同类型数据项之间的规则,由于数据集中的元素项之间存在差异,不能简单地将所有数据项都看作同种item。分析商品场景挂载数据可以看出,商品的PV对与场景之间存在差异,若将其视为同种数据项,用通用的规则挖掘算法学习,就舍弃了商品PV对与场景之间的挂载关系信息以及差异。

因为关联规则挖掘是通用的规则生成算法,在频繁项挖掘阶段需要耗费大量的时间挖掘无关的频繁项,无法针对特定的规则优化,所以关联规则挖掘算法无论是效率还是产出结果的指标都偏低。因此,针对商品场景挂载数据生成规则,需要用到task-specific算法,算法需要考虑商品PV对与场景之间的差异以及挂载关系信息,且生成的规则应满足规则体部分为PV对,规则头部分为单个场景的要求。

5.6.2 技术实践方案

1.分析数据

首先分析数据,商品由20~50个PV对组成,每个商品会挂载到若干个场景,而输出的规则体部分为1~5个PV对,规则头部分为单个场景。因此可以认为,对一个商品的PV对赋予不同的权重就可以让这个商品挂载到不同的场景,输出那些权重超过阈值的PV对作为规则体部分就可以得到一条规则,从而得到一个算法。就是用一个神经网络赋予PV对权重,在训练完毕后将高权重的PV输出作为规则体部分。

因此,要解决的第一个问题是如何设计一个神经网络模型为PV对赋予权重,PV对的权重是离散值0或1,0表示舍弃当前PV对,1表示选择当前PV对作为规则体部分。把商品包含的PV对看作序列,赋予权重的过程就是一个经典的序列决策过程,因为这个序列决策过程是没有标注数据的,所以无法用监督学习训练;如果整个序列是有标注的,则赋予权重后的PV对序列能否挂载到当前场景。因此,可以把整个问题建模成一个强化学习问题,训练一个智能体完成赋予权重的过程。

然后,要解决的第二个问题是如何为这个智能体返回奖励,即如何判断智能体输出的PV对子序列可以让商品挂载到特定场景,且这个子序列的长度不超过5。判断挂载是否正确可以看作一个分类问题,预训练一个FastText网络作为分类器,输入为PV对序列,输出为PV对序列对应的类(即场景),判断当前PV子序列能否分类到对应场景。同时,在奖励函数中加入子序列长度项,让智能体尽可能选择较短的子序列。

2.模型简介

模型包括两部分,一部分用于对PV输出动作(Action)的智能体(Agent),一部分用于返回奖励的FastText模型,如图5-31所示。Agent由三个模块组成:输入模块、记忆模块和动作模块。输入模块包括属性向量、值向量以及场景向量,属性向量和值向量拼接起来当作当前PV的向量,作为记忆模块的输入;记忆模块则由一个双向LSTM组成,利用LSTM网络的记忆功能,让每个时间步输出的隐状态都能包含上下文的信息;动作模块则包含一个单向LSTM和一个全连接层,网络输入包含记忆模块在当前时间步的输出,智能体在上一次输出的动作以及当前商品所对应的场景向量。

图5-31 模型结构

在智能体对所有PV做完决策之后,将动作输出为“1”的PV作为FastText的输入,FastText会输出当前输入的分类结果(也就是场景挂载),若分类正确,则给智能体返回一个奖励更新参数。

3.模型训练

首先需要预训练一个FastText模型为智能体返回奖励。要先把商品挂载场景构造成一个分类任务,因为一个商品可能会挂载到多个场景,对应到文本分类任务,就是一个样本会有多个标签,所以这里把挂载数据构造成了一个多标签分类任务,用的目标函数也是文本分类任务里常用的交叉熵损失函数。具体来说,单个样本的损失函数为:

式中,n表示标签的个数;yi表示样本是否属于当前类;pi表示当前标签对应的概率值,由Sigmoid函数计算后得到。

而智能体的参数更新方式是策略梯度,在监督学习中,本文通常用交叉熵损失作为简化版的KL散度衡量两个分布的差异,单个样本的交叉熵损失函数如下:

式中,t表示样本的长度;yi表示当前标签;pi表示当前标签对应的概率值,由Softmax函数计算后得到。

而强化学习则是没有标签的,用当前动作得到的奖励代替,单个样本的损失函数如下:

式中,ai表示当前时间步智能体输出的动作,这时损失函数的作用就不是衡量两个分布的差异,而是最大化得到正奖励动作的概率。

5.6.3 实验结果及案例分析

实验所用商品挂载数据集来自某电商网站的一个类目,在实验开始前对实验数据做了一些必要的预处理。对实验数据的预处理包括:

● 对标题进行分词,去掉停用词、无关的标点符号及单个字。

● 对包含多项的属性值进行切分,切分成k个部分就形成k个PV。

● 去掉一些没有信息量的属性项及其对应的属性值。

● 增加了属性项:拥有属性,对应属性值为该商品拥有的属性项。

预处理后的数据集统计信息如表5-7所示。

表5-7 预处理后的数据集统计信息

在规则输出阶段,智能体不再是从动作空间中按概率采样一个动作,而是直接选择概率最大的动作,得到所有预测正确的PV序列后,计算每条raw规则的HC和Conf,将满足要求的作为备选规则。最后生成的备选规则的规则体平均长度也较短,这十分符合规则的要求。模型输出的规则样例如表5-8所示。

表5-8 模型输出的规则样例

从样例中可以看出,智能体确实可以找到一个到两个与某场景关联度极高的PV,这证明了奖励函数中对输出PV序列长度的惩罚的有效性;且规则从直观上看就很具有可行性,说明本模型确实找到了商品PV与场景之间存在的模式,并以规则的形式输出。最终模型生成了845条备选规则。

5.7 本章小结

随着知识图谱近年来的飞速发展,知识推理作为知识图谱补全和去噪的重要手段得到了广泛的关注。补全和去噪是知识图谱中的两个基础任务,当知识推理应用于知识图谱补全时,主要是指通过知识图谱中已有的信息推理出缺失的三元组。例如,小明的毕业院校信息可能缺失,但通过分析发现小明的同学大部分毕业于某个学校,那么可以推理出小明很可能也毕业于该学校。去噪是指识别出知识图谱中的错误或矛盾的知识,这是一个非常重要的任务,因为错误的知识会影响知识图谱中的其他信息,造成错误放大,这对知识图谱来说是非常致命的。在小型知识图谱上可以通过人工运营平台的方式完成去噪,但在大型知识图谱上,人工标注的成本非常高,因此需将自动化的知识推理方法应用其中。

在应用上,知识推理已经在垂直搜索、智能问答、机器翻译、医疗、金融反欺诈和异常数据等多个领域发挥了重要作用。

参考文献

[1] 袁鼎荣,钟宁,张师超.文本信息处理研究述评[J].计算机科学,2011(2):15-19.

[2] 赵琦,刘建华,刘建华.从ACE会议看信息抽取技术的发展趋势[J].现代图书情报技术,2008(3):18-23.

[3] RABINER L R. A tutorial on hidden Markov models and selected applications in speech recognition[J]. Proceedings of the IEEE, 1989, 77(2): 257-286.

[4] LAFFERTY J, MCCALLUM A, PEREIRA F C N. Conditional random fields: Probabilistic models for segmenting and labeling sequence data[J]. 2001.

[5] MIKOLOV T, SUTSKEVER I, CHEN K, et al. Distributed representations of words and phrases and their compositionality[C]//Advances in neural information processing systems, 2013: 3111-3119.

[6] HUANG Z, XU W, YU K. Bidirectional LSTM-CRF models for sequence tagging[J]. arXiv preprint arXiv:1508.01991, 2015.

[7] LAMPLE G, BALLESTEROS M, SUBRAMANLAN S, et al. Neural Architectures for Named Entity Recognition[C]//Proceedings of NAACL-HLT, 2016: 260-270.

[8] MA X, HOVY E. End-to-end Sequence Labeling via Bi-directional LSTM-CNNs-CRF[C]//Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics (Volume 1:Long Papers), 2016: 1064-1074.

[9] PENNINGTON J, SOCHER R, MANNING C D.Glove: Global vectors for word representation[C]//Proceedings of the 2014 conference on empirical methods in natural language processing (EMNLP), 2014: 1532-1543.

[10] PETERS M E,NEUMANN M, LYYER M, et al. Deep contextualized word representations[C]//Proceedings of NAACL-HLT, 2018: 2227-2237.

[11] HOWARD J, RUDER S. Universal Language Model Fine-tuning for Text Classification[C]//Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics (Volume 1:Long Papers), 2018: 328-339.

[12] DEVLIN J, CHANG M W, LEE K, et al. BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding[C]//Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long and Short Papers), 2019: 4171-4186.

[13] KOLITSAS N, GANEA O E, HOFMANN T. End-to-end neural entity linking[J]. arXiv preprint arXiv:1808.07699, 2018.

[14] RATINOV L, ROTH D, DOWNEY D, et al. Local and global algorithms for disambiguation to wikipedia[C]//Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics: Human Language Technologies-Volume 1. Association for Computational Linguistics, 2011: 1375-1384.

[15] TANEVA B, CHENG T, CHAKRABARTI K, et al. Mining acronym expansions and their meanings using query click log[C]//Proceedings of the 22nd international conference on World Wide Web, 2013: 1261-1272.

[16] YAMADA I, SHINDO H, TAKEDA H, et al. Learning distributed representations of texts and entities from knowledge base[J]. Transactions of the Association for Computational Linguistics, 2017, 5: 397-411.

[17] LE P, TITOV I. Boosting entity linking performance by leveraging unlabeled documents[J]. arXiv preprint arXiv:1906.01250, 2019.

[18] LOGESWARAN L, CHANG M W, LEE K, et al. Zero-Shot Entity Linking by Reading Entity Descriptions[J]. arXiv preprint arXiv:1906.07348, 2019.

[19] LE P, TITOV I. Distant Learning for Entity Linking with Automatic Noise Detection[J]. arXiv preprint arXiv:1905.07189, 2019.

[20] CUCERZAN S. Large-scale named entity disambiguation based on Wikipedia data[C]//Proceedings of the 2007 Joint Conference on Empirical Methods in Natural Language Processing and Computational Natural Language Learning (EMNLP-CoNLL), 2007: 708-716.

[21] CHEN Z, TAMANG S, LEE A, et al. CUNY-BLENDER TAC-KBP2010 Entity Linking and Slot Filling System Description[C]//TAC, 2010.

[22] IKUYA Y, HIROYUK S, HIDEAKI T, et al. Learning distributed representations of texts and entities from knowledge base. TACL, 2017, 5: 397-411.

[23] BROSCHEIT S. Investigating Entity Knowledge in BERT with Simple Neural End-To-End Entity Linking[C]//Proceedings of the 23rd Conference on Computational Natural Language Learning (CoNLL), 2019: 677-685.

[24] GOTTIPATI S, JIANG J. Linking entities to a knowledge base with query expansion. In EMNLP, 2011:804-813.

[25] RAIMAN J R, RAIMAN O M. Deeptype:multilingual entity linking by neural type system evolution[C]//Thirty-Second AAAI Conference on Artificial Intelligence, 2018.

[26] SHEN L, JOSHI A K. Ranking and reranking with perceptron[J]. Machine Learning, 2005, 60(1-3): 73-96.

[27] CAO Z, QIN T, LIU T Y, et al. Learning to rank:from pairwise approach to listwise approach[C]//Proceedings of the 24th international conference on Machine learning, 2007: 129-136.

[28] HOFFART J, SEUFERT S,NGUYEN D B, et al. KORE:keyphrase overlap relatedness for entity disambiguation[C]//Proceedings of the 21st ACM international conference on Information and knowledge management, 2012: 545-554.

[29] FRANCIS-LANDAU M, DURRETTT G, KLEIN D. Capturing semantic similarity for entity linking with convolutional neural networks[J]. arXiv preprint arXiv:1604.00734, 2016.

[30] CAO Y, HUANG L, JI H, et al. Bridge Text and Knowledge by Learning Multi-Prototype Entity Mention Embedding[C]//Meeting of the Association for Computational Linguistics, 2017: 1623-1633.

[31] GANEA O E, HOFMANN T. Deep joint entity disambiguation with local neural attention[J]. arXiv preprint arXiv:1704.04920, 2017.

[32] HE Z, LIU S, LI M, et al. Learning entity representation for entity disambiguation[C]//Proceedings of the 51st Annual Meeting of the Association for Computational Linguistics (Volume 2:Short Papers), 2013: 30-34.

[33] LE P, TITOV I. Improving entity linking by modeling latent relations between mentions[J]. arXiv preprint arXiv:1804.10637, 2018.

[34] MULANG I O, SINGH K,VYAS A, et al. Context-aware Entity Linking with Attentive Neural Networks on Wikidata Knowledge Graph[J]. arXiv preprint arXiv:1912.06214, 2019.

[35] DURRETT G, KLEIN D. A joint model for entity analysis: Coreference, typing, and linking[J]. Transactions of the association for computational linguistics, 2014, 2: 477-490.

[36] KOLITSAS N, GANEA O E, HOFMANN T. End-to-end neural entity linking[J]. arXiv preprint arXiv:1808.07699, 2018.

[37] MARTINS P H, MARINHO Z, MARTINS A F T.Joint learning of named entity recognition and entity linking[J]. arXiv preprint arXiv:1907.08243, 2019.

[38] KAMBHATLA N.[Association for Computational Linguistics the ACL 2004-Barcelona, Spain (2004.07.21-2004.07.26)] Proceedings of the ACL 2004 on Interactive poster and demonstration sessions, Combining lexical, syntactic, and semantic features with maximum entropy models for extracting relations[J]. 2004: 22.

[39] ZHOU G, SU J, ZHANG J, et al. Exploring Various Knowledge in Relation Extraction[C]//ACL 2005, 43rd Annual Meeting of the Association for Computational Linguistics, 2005.

[40] ZELENKO D, AONE C, RICHARDELLA A. Kernel Methods for Relation Extraction[J].Journal of Machine Learning Research, 2003, 3(3): 1083-1106.

[41] CULOTTA A, SORENSEN J S. Dependency Tree Kernels for Relation Extraction[C]//Proceedings of the 42nd Annual Meeting of the Association for Computational Linguistics, 2004.

[42] BUNESCU R, MOONEY R. A shortest path dependency kernel for relation extraction[C]//Conference on Human Language Technology&Empirical Methods in Natural Language Processing. Association for Computational Linguistics, 2005.

[43] ZHANG M, ZHANG J, SU J, et al. A Composite Kernel to Extract Relations between Entities with Both Flat and Structured Features[C]//ACL 2006, 21st International Conference on Computational Linguistics and 44th Annual Meeting of the Association for Computational Linguistics, 2006.

[44] ZHOU G D, ZHANG M, JI D H, et al. Tree kernel-based relation extraction with context-sensitive structured parse tree information. EMNLP-CoNLL'2007, 2007: 728-736.

[45] ZENG D J, LIU K, LAI S W, et al. Relation classification via convolutional deep neural network. The 25th International Conference on Computational Linguistics: Technical Papers. 2335-2344.

[46] CICERO NOGUEIRA DOS S, XIANG B, ZHOU B W. Classifying relations by ranking with convolutional neural networks. ACL, 2015.

[47] ZHOU P, SHI W, TIAN J, et al. Attention-based bidirectional long short-term memory networks for relation classification. In: The 54th Annual Meeting of the Association for Computational Linguistics, 2016: 207.

[48] ZHENG S, HAO Y, LU D, et al. Joint entity and relation extraction based on a hybrid neural network[J]. Neurocomputing, 2017, 257: 1-8.

[49] MIWA M, BANSAL M. End-to-end Relation Extraction using LSTMs on Sequences and Tree Structures[J]. 2016.

[50] ZHENG S, WANG F, BAO H, et al. Joint Extraction of Entities and Relations Based on a Novel Tagging Scheme[J]. 2017.

[51] MIKE M, STEVEN B, RION S, et al. Distant supervision for relation extraction without labeled data[C]//ACL 2009, Proceedings of the 47th Annual Meeting of the Association for Computational Linguistics and the 4th International Joint Conference on Natural Language Processing of the AFNLP, 2009.

[52] DIETTERICH T G, LATHROP R H, LOZANO-PÉREZ T.Solving the multiple instance problem with axis-parallel rectangles[J]. Artificial intelligence, 1997, 89(1-2): 31-71.

[53] ZENG D, LIU K, CHEN Y, et al. Distant Supervision for Relation Extraction via Piecewise Convolutional Neural Networks[C]//Empirical methods in natural language processing, 2015: 1753-1762.

[54] LIN Y, SHEN S, LIU Z, et al. Neural Relation Extraction with Selective Attention over Instances[C]. Meeting of the association for computational linguistics, 2016: 2124-2133.

[55] FENG J, HUANG M, ZHAO L, et al. Reinforcement Learning for Relation Classification from Noisy Data[C]. National conference on artificial intelligence, 2018: 5779-5786.

[56] BRIN S. Extracting Patterns and relations fromthe World Wide Web[J]. Lecture notes in computerScience, 1998,1590: 172-183.

[57] 漆桂林,高桓,吴天星.知识图谱研究进展[J].情报工程,2017,3(1):004-025.

[58] AGICHTEIN E, GRAVANO L. Snowball: Extractingrelations from large Plain-text collections[C]//acMConference on Digital Libraries. ACM, 2000:85-94.

[59] CARLSON A, BETTERIDGE J, KISIEL B, et al. Toward anarchitecture for never-Ending language learning.[C]//AAAI 2010, 2010: 529-573.

[60] MITCHELL T,FREDKIN E. Never-ending Languagelearning[M]//Never-Ending language learning. Alphascript Publishing, 2014.

[61] BOLLEGALA D T, MATSUO Y,ISHIZUKA M. Measuringthe similarity between implicit semantic relationsfrom the Web[J]. Www Madrid!track semantic/dataWeb, 2009: 651-660.

[62] BOLLEGALA D T, MATSUO Y,ISHIZUKA M. RelationalDuality:Unsupervised Extraction of semantic relations between Entities on the Web[C]//International Conference on World Wide Web, WWW 2010, 2010: 151-160.

[63] BANKO M, CAFARELLA M, SODERLAND S, et al. Open information extraction from the web[C]. International joint conference on artificial intelligence, 2007: 2670-2676.

[64] NIKLAUS C, CETTO M,FREITAS A, et al. A Survey on Open Information Extraction[C]. International conference on computational linguistics, 2018: 3866-3878.

[65] WU F, WELD D S. Open Information Extraction Using Wikipedia[C]. Meeting of the association for computational linguistics, 2010: 118-127.

[66] SCHMITZ M, SODERLAND S, BART R, et al. Open Language Learning for Information Extraction[C]. Empirical methods in natural language processing, 2012: 523-534.

[67] YAHYA M, WHANG S E, GUPTA R, et al. ReNoun: Fact Extraction for Nominal Attributes[C]. empirical methods in natural language processing, 2014: 325-335.

[68] FADER A, SODERLAND S,ETZIONI O, et al. Identifying Relations for Open Information Extraction[C]. empirical methods in natural language processing, 2011: 1535-1545.

[69] ALAN A, ALEXANDER L. Chapter KrakeN:N-ary Facts in Open Infor-mation Extraction, Proceedings of the Joint Workshop on Automatic Knowledge Base Construction and Web-scale Knowledge Extraction (AKBC-WEKEX) Association for Computational Linguistics, 2012: 52-56.

[70] MESQUITA F, SCHMIDEK J, BARBOSA D, et al. Effectiveness and Efficiency of Open Relation Extraction[C]. empirical methods in natural language processing, 2013: 447-457.

[71] STANOVSKY G, DAGAN I. Creating a Large Benchmark for Open Information Extraction[C]. empirical methods in natural language processing, 2016: 2300-2305.

[72] WHITE A S, REISINGER D, SAKAGUCHI K, et al. Universal Decompositional Semantics on Universal Dependencies.[C]. Empirical methods in natural language processing, 2016: 1713-1723.

[73] CORRO L D, GEMULLA R. ClausIE: clause-based open information extraction[J]. the web conference, 2013: 355-366.

[74] ANGELI G, PREMKUMAR M J, MANNING C D, et al. Leveraging Linguistic Structure For Open Domain Information Extraction[C].international joint conference on natural language processing, 2015: 344-354.

[75] MAUSAM M. Open information extraction systems and downstream applications[C].international joint conference on artificial intelligence, 2016: 4074-4077.

[76] SAHA S, PAL H.Bootstrapping for Numerical Open IE[C]. Meeting of the association for computational linguistics, 2017: 317-323.

[77] BAST H, HAUSSMANN E. Open Information Extraction via Contextual Sentence Decomposition[C].ieee international conference semantic computing, 2013: 154-159.

[78] GASHTEOVSKI K, GEMULLA R, Corro L D, et al. MinIE: Minimizing Facts in Open Information Extraction[C]. Empirical methods in natural language processing, 2017: 2620-2630.

[79] DIAN Y, HENG J.Unsupervised Person Slot Filling based on Graph Mining[C]. Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics, 2016: 44-53.

[80] JR Q. Logic Definitions from Relations[J]. Machine Learning, 1990, 5(3): 239-266.

[81] LUIS A G, CHRISTINA T, KATJA H, et. al. Association Rule Mining Under Incomplte Evidence in Ontological Knowledge Base. Proceedings of the 22nd International Conference on World Wide Web, 2013: 413-422.

[82] LUIS G, CHRISTINA T, KATJA H, et al. Fast Rule Mining in Ontological Knowledge Bases with Amie+. The VLDB Journal, 2015: 1-24.

[83] NI L, TOM M, WILLIAM W C. Random Walk Inference and Learning in A Large Scale Knowledge Base. Proceedings of the Conference on Empirical Methods in Natural Language Processing, 2011: 529-539.

[84] NI L, WILLIAM W C. Relational Retrieval Using a Combination of Path-Constrained Random Walks. Machining Learing, 2010,81(1): 53-67.

[85] ARVIND N, BENJAMIN R, ANDREW M. Compositional Vector Space Models for Knowledge Base Completion. Meeting of the association for computational linguistics, 2015.

[86] MATT G, TOM M. Efficient and Expressive Knowledge Base Completion Using Subgraph Feature Extraction. Meeting of the association for computational linguistics, 2015.

[87] MATT G, PARTHA T, JAYANT K, et al. Incorporating Vector Space Similarity in Random Walk Inference over Knowledge Bases. Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing (EMNLP), 2014: 397-406.

[88] WANG Q, LIU J, LUO Y F, et al. Knowledge Base Completion via Coupled Path Ranking. Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics, 2016: 1308-1318.

[89] SAHISNU M, BING L. Context-aware Path Ranking for Knowledge Base Completion. Proceedings of the Twenty-Sixth International Joint Conference on Artificial Intelligence, 2017.

[90] YANG B SH, YIH W, HE X D, et al. Embedding Entities and Relations for Learning and Inference in Knowledge Bases. Proceedings of ICLR, 2015.

[91] ZHANG W, PAUDEL B, WANG L, et al. Iteratively learning embeddings and rules for knowledge graph reasoning. In The World Wide Web Conference, 2019b, 2366-2377. ACM.

[92] ZHANG N, DENG S, SUN Z, et al. Long-tail relation extraction via knowledge graph embeddings and graph convolution networks[J]. NAACL, 2019.

[93] ZHANG N, DENG S, SUN Z, et al. Relation Adversarial Network for Low Resource Knowledge Graph Completion[C]//Proceedings of The Web Conference 2020. 2020: 1-12.

[94] GAO T, HAN X, LIU Z, et al. Hybrid attention-based prototypical networks for noisy few-shot relation classification[C]//Proceedings of the AAAI Conference on Artificial Intelligence, 2019, 33: 6407-6414.

[95] YU H, ZHANG N, DENG S, et al. Bridging Text and Knowledge with Multi-Prototype Embedding for Few-Shot Relational Triple Extraction[J]. COLING, 2020.

[96] DENG S, ZhANG N, KANG J, et al. Meta-Learning with Dynamic-Memory-Based Prototypical Network for Few-Shot Event Detection[C]//Proceedings of the 13th International Conference on Web Search and Data Mining, 2020: 151-159.

[97] SOARES L B,FITZGERALD N, LING J, et al. Matching the blanks: Distributional similarity for relation learning[J]. ACL, 2019.

[98] YANG S,FENG D, QIAO L, et al. Exploring pre-trained language models for event extraction and generation[C]//Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics, 2019: 5284-5294.

[99] LU Y, LIN H, HAN X, et al. Distilling Discrimination and Generalization Knowledge for Event Detection via Delta-Representation Learning[C]//Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics, 2019: 4366-4376.

[100] TONG M, XU B, WANG S, et al. Improving event detection via open-domain trigger knowledge[C]//Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics, 2020: 5887-5897.

[101] LI J, WANG R, ZHANG N, et al. Logic-guided Semantic Representation Learning for Zero-Shot Relation Classification[J]. COLING, 2020.

[102] DU X, CARDIE C. Event Extraction by Answering (Almost) Natural Questions[J]. EMNLP, 2020.

[103] LIU J, CHEN Y, LIU K, et al. Event Extraction as Machine Reading Comprehension[C]//Proceed-ings of the 2020 Conference on Empirical Methods in Natural Language Processing (EMNLP), 2020: 1641-1651.

[104] LI M, ZENG Q, LIN Y, et al. Connecting the dots: Event graph schema induction with path language modeling[C]//Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing (EMNLP), 2020: 684-695.

[105] WANG L, CAO Z, DE MELO G, et al. Relation Classification via Multi-Level Attention CNNs[C].meeting of the association for computational linguistics, 2016: 1298-1307.

[106] YANG Y, CHEN W, LI Z, et al. Distantly Supervised NER with Partial Annotation Learning and Reinforcement Learning[C].international conference on computational linguistics, 2018: 2159-2169.

[107] YANG Y, ZHANG M, CHEN W, et al. Adversarial Learning for Chinese NER from Crowd Annotations[J]. arXiv: Computation and Language, 2018.

[108] JR Q. Logic Definitions from Relations. Machine Learning, 1990, 5(3): 239-266.

[109] LUIS ANTONID G, CHRISTINA T, KATJA H, et. al. Association Rule Mining Under Incomplte Evidence in Ontological Knowledge Base. Proceedings of the 22nd International Conference on World Wide Web, 2013: 413-422.

[110] LUIS G, CHRISTINA T, KATJA H, et al. Fast Rule Mining in Ontological Knowledge Bases with Amie+. The VLDB Journal, 2015: 1-24.

[111] NI L, TOM M, WILLIAM W C. Random Walk Inference and Learning in A Large Scale Knowledge Base. Proceedings of the Conference on Empirical Methods in Natural Language Processing, 2011: 529-539.

[112] NI L, WILLIAM W C. Relational Retrieval Using a Combination of Path-Constrained Random Walks. Machining Learing, 2010,81(1): 53-67.

[113] ARVIND N, BENJAMIN R, ANDREW M. Compositional Vector Space Models for Knowledge Base Completion. Meeting of the association for computational linguistics, 2015.

[114] MATT G, TOM M. Efficient and Expressive Knowledge Base Completion Using Subgraph Feature Extraction.meeting of the association for computational linguistics, 2015.

[115] MATT G, PARTHA T, JAYANT K, et al. Incorporating Vector Space Similarity in Random Walk Inference over Knowledge Bases. Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing (EMNLP), 2014: 397-406.

[116] WANG Q, LIU J, LUO Y F, et al. Knowledge Base Completion via Coupled Path Ranking. Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics, 2016: 1308-1318.

[117] SAHISNU M, BING L. Context-aware Path Ranking for Knowledge Base Completion. Proceedings of the Twenty-Sixth International Joint Conference on Artificial Intelligence, 2017.

[118] BORDES A, USUNIER N, GARCIA-DURAN A, et al. Translating embeddings for modeling multi-relational data[C]. In: Proc. of the Advances in Neural Information Processing Systems. Red Hook: Curran Associates Inc., 2013: 2787-2795.

[119] MIKOLOY T, CHEN K, CORRADO G, et al. Efficient estimation of word representations in vector space[C]. ICLR Workshop, 2013.

[120] WANG Z, ZHANG J,FENG J, et al. Knowledge graph embedding by translating on hyperplanes[C]. In: Proc. of the 28th AAAI Conf.on Artificial Intelligence. Menlo Park: AAAI, 2014: 1112-1119.

[121] LIN Y, LIU Z, SUN M, et al. Learning entity and relation embeddings for knowledge graph completion. In: Proc. of the 29th AAAI Conf.on Artificial Intelligence. Menlo Park: AAAI, 2015: 2181-2187.

[122] JI G, HE S, XU L, et al. Knowledge graph embedding via dynamic mapping matrix[C]. In: Proc. of the 53rd Annual Meeting of the Association for Computational Linguistics, 2015: 687-696.

[123] JI G, LIU K, HE S, et al. Knowledge graph completion with adaptive sparse transfer matrix[C]. In: Proc. of the 30th AAAI Conf.on Artificial Intelligence. Menlo Park: AAAI, 2016:985-991.

[124] FAN M, ZHOU Q, CHANG E, et al. Transition-Based knowledge graph embedding with relational mapping properties[C]. In: Proc. of the 28th Pacific Asia Conf.on Language, Information and Computation.Stroudsburg: ACL, 2014: 328-337.

[125] JIA Y, WANG Y, LIN H, et al. Locally adaptive translation for knowledge graph embedding[C]. In: Proc. of the 30th AAAI Conf.on Artificial Intelligence. Menlo Park: AAAI, 2016:992-998.

[126] GUO S, WANG Q, WANG B, et al. Semantically smooth knowledge graph embedding[C]. In: Proc. of the 53rd Annual Meeting of the Association for Computational Linguistics, 2015: 84-94.

[127] WANG Z, LI J. Text-enhanced representation learning for knowledge graph[C]. International Joint Conference on Artificial Intelligence. AAAI Press, 2016.

[128] XIAO H, HUANG M, ZHU X.From one point to a manifold:Knowledge graph embedding for precise link prediction[C]. In: Proc. of the 25th Int'l Joint Conf.on Artificial Intelligence. AAAI, 2016: 1315-1321.

[129] HE S, LIU K, JI G, et al. Learning to represent knowledge graphs with gaussian embedding[C]. In: Proc. of the 24th ACM Int'l Conf.on Information and Knowledge Management. New York: ACM Press, 2015: 623-632.

[130] XIAO H, HUANG M, ZHU X. TransG: A generative model for knowledge graph embedding[C]. ACL, 2016.

[131] NICKEL M, TRESP V, KRIEGEL H P. A three-way model for collective learning on multi-relational data[C]. In: Proc. of the 28th Int'l Conf.on Machine Learning. New York: ACM Press, 2011:809-816.

[132] YANG B SH, YIH W, HE X D, et al. Embedding entities and relations for learning and inference in knowledge bases[C]. In International Conference on Learning Representations, 2015.

[133] NICKEL M, ROSASCO L, POGGIO T.Holographic embeddings of knowledge graphs[C]. Thirtieth Aaai conference on artificial intelligence, 2016.

[134] TROUILLON T, WELBL J, RIEDEL S, et al. Complex embeddings for simple link prediction[C]. In: Proc. of the 33rd Int'l Conf.on Machine Learning. New York: ACM Press, 2016: 2071-2080.

[135] YANG B SH, YIH W, HE X D, et al. Embedding Entities and Relations for Learning and Inference in Knowledge Bases. Proceedings of ICLR, 2015.

[136] ZHANG W, PAUDEL B, WANG L, et al. Iteratively learning embeddings and rules for knowledge graph reasoning. In The World Wide Web Conference, 2019: 2366-2377.

[137] BRUNA J, ZAREMBA W, SZLAM A, et al. Spectral networks and locally connected networks on graphs. In ICLR, 2014.

[138] DUVENAUD D K, MACLAURIN D,IPARRAGUIRRE J, et al. Convolutional networks on graphs for learning molecular fingerprints. In NIPS, 2015.

[139] DEFFERRARD M, BRESSON X,VANDERGHEYNST P. Convolutional neural networks on graphs with fast localized spectral filtering. In NIPS, 2016.

[140] KIPF T N, WELLING M.Semi-supervised classification with graph convolutional networks. In ICLR, 2017.

[141] YANG B, YIH W, HE X, et al. Embedding entities and relations for learning and inference in knowledge bases. arXiv preprint arXiv:1412.6575, 2014.

[142] ABU-EL-HAIJA S, KAPOOR A, PEROZZI B, et al. N-gcn: Multi-scale graph convolution for semi-supervised node classi-fication. In MLG KDD Workshop, 2018.

[143] RAJARSHI D, ARVIND N, DAVID B, et al. Chains of reasoning over entities, relations, and text using recurrent neural networks. EACL, 2017.

[144] KIPF W.Semi-Supervised Classification with Graph Convolutional Networks. ICIR, 2017.

[145] DEFFERRARD M, XAVIER B, PIERRE V. Convolutional Neural Networks on Graphs with Fast Localized Spectral Filtering. NIPS, 2016.

[146] MIKOLOV T, CHEN K, CORRADO G. Efficient estimation of word representations in vector space[J]. 2013: 1301.3781.

[147] BLEI D,NG A, JORDAN M. Latent Dirichlet Allocation[J].Journal of Machine Learning Research, 2003.

[148] YU X, XIANG R, SUN Y Z, et al. Personalized entity recommendation: A heterogeneous information network approach.[C]. International Conference on Web Search and Data Mining, 2014.

[149] ZHAO H, YAO Q M, LI J D, et al. Meta-graph based recommendation fusion over heterogeneous information networks.[C]. Proceedings of the 23rd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining, 2017.

[150] WANG Q, MAO Z D, WANG B, et al. Knowledge Graph Embedding: A Survey of Approaches and Applications.[J]. Transactions on Knowledge and Data Engineering, 2017.

[151] BORDES A, USUNIER N, WESTON J. Translating embeddings for modeling multirelational data.[C]. Advances in Neural Information Processing Systems, 2013.

[152] WANG Z, ZHANG J,FENG J, et al. Knowledge graph embedding by translating on hyperplanes[C]. the Association for the Advance of Artificial Intelligence, 2014.

[153] LIN Y, LIU Z, SUN M, et al. Learning entity and relation embeddings for knowledge graph completion[C]. the Association for the Advance of Artificial Intelligence, 2015.

[154] JI G, HE S, XU L, et al. Knowledge graph embedding via dynamic mapping matrix[C]. Proceed-ings of the 53rd Annual Meeting of the Association for Computational Linguistics and the 7th International Joint Conference on Natural Language Processing, 2015.

[155] WANG H W, ZHANG F Z, XIE X, et al. DKN: Deep Knowledge-Aware Network for News Recommendation[C]. Proceedings of the 18th World Wide Web Conference, 2018.

[156] WANG H W, ZHANG F Z, WANG J L, et al. RippleNet: Propagating User Preferences on the Knowledge Graph for Recommender Systems[C]. Proceedings of the 27th ACM International Conference on Information and Knowledge Management, 2018.

[157] WANG H W, ZHANG F Z, ZHAO M, et al. Multi-Task Feature Learning for Knowledge Graph Enhanced Recommendation[C]. Proceedings of the 19th World Wide Web Conference, 2019.

[158] ZHI S, LIU L Y, ZHANG Y, et al. Partially-Typed NER Datasets Integration: Connecting Practice to Theory, 2020. arXiv:2005.00502v1.