EnsembleLearning-机器学习基础(day1)

第一章 机器学习基础

机器学习的三大主要任务

1. 导论

什么是机器学习?机器学习的一个重要的目标就是利用数学模型来理解数据,发现数据中的规律,用作数据的分析和预测。数据通常由一组向量组成,这组向量中的每个向量都是一个样本,我们用 x i x_i xi来表示一个样本,其中 i = 1 , 2 , 3 , . . . , N i=1,2,3,...,N i=1,2,3,...,N,共N个样本,每个样本 x i = ( x i 1 , x i 2 , . . . , x i p , y i ) x_i=(x_{i1},x_{i2},...,x_{ip},y_i) xi=(xi1,xi2,...,xip,yi)共p+1个维度,前p个维度的每个维度我们称为一个特征,最后一个维度 y i y_i yi我们称为因变量(响应变量)。特征用来描述影响因变量的因素,如:我们要探寻身高是否会影响体重的关系的时候,身高就是一个特征,体重就是一个因变量。通常在一个数据表dataframe里面,一行表示一个样本 x i x_i xi,一列表示一个特征。

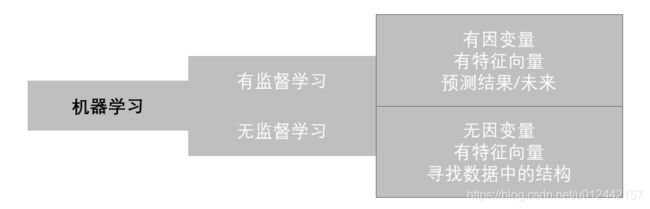

根据数据是否有因变量,机器学习的任务可分为:有监督学习和无监督学习。

机器学习是从数据中产生模型的算法,或者说用模型理解数据,发现数据中的规律。

- 有监督学习:给定某些特征去估计因变量,即因变量存在的时候,我们称这个机器学习任务为有监督学习。如:我们使用房间面积,房屋所在地区,环境等级等因素去预测某个地区的房价。

- 无监督学习:给定某些特征但不给定因变量,建模的目的是学习数据本身的结构和关系。如:我们给定某电商用户的基本信息和消费记录,通过观察数据中的哪些类型的用户彼此间的行为和属性类似,形成一个客群。注意,我们本身并不知道哪个用户属于哪个客群,即没有给定因变量。

因变量就是标签,有监督无监督就是看有没有标签,即 Y Y Y

进一步根据因变量的是否连续,有监督学习又分为回归和分类:

回归:因变量是连续型变量,如:房价,体重等。

分类:因变量是离散型变量,如:是否患癌症,西瓜是好瓜还是坏瓜等。

拓展:

西瓜书也提到半监督学习。

在迁移学习中,根据目标领域目标领域有无标签,迁移学习可以分为以下三个大类:

- 有监督学习 (Supervised Transfer Learning)

- 半监督学习 (Semi-Supervised Transfer Learning)

- 无监督学习 (Unsupervised Transfer Learning)

最近这个方向比较热门,在A类会议中比重逐渐增加。

为了更好地叙述后面的内容,我们对数据的形式作出如下约定:

第i个样本: x i = ( x i 1 , x i 2 , . . . , x i p , y i ) T , i = 1 , 2 , . . . , N x_i=(x_{i1},x_{i2},...,x_{ip},y_i)^T,i=1,2,...,N xi=(xi1,xi2,...,xip,yi)T,i=1,2,...,N

因变量 y = ( y 1 , y 2 , . . . , y N ) T y=(y_1,y_2,...,y_N)^T y=(y1,y2,...,yN)T

第k个特征: x ( k ) = ( x 1 k , x 2 k , . . . , x N k ) T x^{(k)}=(x_{1k},x_{2k},...,x_{Nk})^T x(k)=(x1k,x2k,...,xNk)T

特征矩阵 X = ( x 1 , x 2 , . . . , x N ) T X=(x_1,x_2,...,x_N)^T X=(x1,x2,...,xN)T

在学习机器学习中,我们经常使用scikit-learn简称sklearn工具库来探索机器学习项目,下面我们开始使用sklearn来演示这几个具体的概念:

# 引入相关科学计算包

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

%matplotlib inline

plt.style.use("ggplot")

import seaborn as sns

其他:

jupyter中的魔法函数,一直没有搞太懂

numpy pandas比较常用

sklearn其实用的不多

seaborn在特征选择时候画图是真的方便

(挖个坑,以后这些都整理一下,重要的api可以写写博客)

1.1 回归

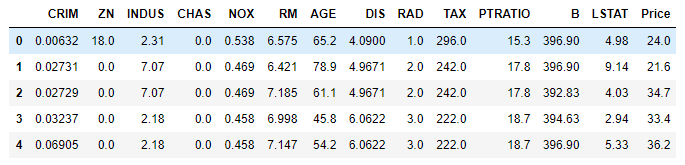

首先,我们先来看看有监督学习中回归的例子,我们使用sklearn内置数据集Boston房价数据集。sklearn中所有内置数据集都封装在datasets对象内:

返回的对象有:

- data:特征X的矩阵(ndarray)

- target:因变量的向量(ndarray)

- feature_names:特征名称(ndarray)

from sklearn import datasets

boston = datasets.load_boston() # 返回一个类似于字典的类

X = boston.data

y = boston.target

features = boston.feature_names

boston_data = pd.DataFrame(X,columns=features)

boston_data["Price"] = y

boston_data.head()

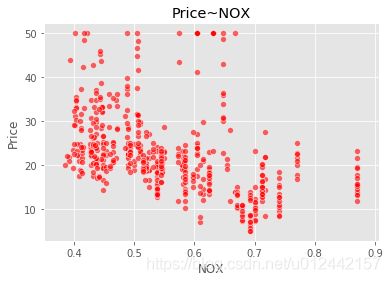

sns.scatterplot(boston_data['NOX'],boston_data['Price'],color="r",alpha=0.6)

plt.title("Price~NOX")

plt.show()

我们可以看到,数据给定任务所需要的因变量,因变量为波士顿房价Price是一个连续型变量,所以这是一个回归的例子。

各个特征的相关解释:

- CRIM:各城镇的人均犯罪率

- ZN:规划地段超过25,000平方英尺的住宅用地比例

- INDUS:城镇非零售商业用地比例

- CHAS:是否在查尔斯河边(=1是)

- NOX:一氧化氮浓度(/千万分之一)

- RM:每个住宅的平均房间数

- AGE:1940年以前建造的自住房屋的比例

- DIS:到波士顿五个就业中心的加权距离

- RAD:放射状公路的可达性指数

- TAX:全部价值的房产税率(每1万美元)

- PTRATIO:按城镇分配的学生与教师比例

- B:1000(Bk - 0.63)^2其中Bk是每个城镇的黑人比例

- LSTAT:较低地位人口

- Price:房价

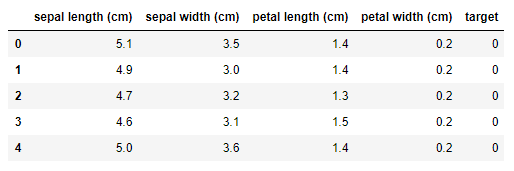

1.2 分类

iris数据集

from sklearn import datasets

iris = datasets.load_iris()

X = iris.data

y = iris.target

features = iris.feature_names

iris_data = pd.DataFrame(X,columns=features)

iris_data['target'] = y

iris_data.head()

reference

https://github.com/datawhalechina/team-learning-data-mining/tree/master/EnsembleLearning