Explaining Deepfake Detection by Analysing Image Matching 翻译

点击查看对应的代码

摘要

本文旨在解释深度伪造检测模型在仅由二进制标签做有监督时如何学习图像的伪迹特征。为此,从图像匹配的角度提出如下三个假设。1、深度伪造检测模型表明基于视觉概念的真/假图片既不与源图片相关也不与目标图片相关而是与伪迹图片相关。2、除了有监督的二进制标签,深度伪造检测模型通过训练集中的FST匹配(即匹配假、源、目标图像)隐式学习与伪迹相关的视觉概念。3、通过原始训练集中的FST匹配,隐式学习的伪迹视觉概念容易受到视频压缩的影响。在实验中,上述假设在各种DNN中得到了验证。进一步的,基于这种理解,我们提出了FST匹配深度伪造检测模型,以提高压缩视频的伪造检测性能。实验结果表明,我们的方法取得了很好的性能,尤其是在高度压缩(例如c40)视频上。

关键字: 深度伪造检测 图片匹配 可解释性。

1、引言

最近,深度伪造方法[14,27,25,44,43]在合成真实人脸方面表现出优异的性能。此类人脸伪造很容易被攻击者用于恶意目的,造成严重的社会问题和政治威胁。为此,大量研究[36,1]在检测各种操纵介质方面通过简单地将其视为二元分类任务,取得了巨大的成功。然而,仅使用有监督的二进制标签(真/假)理解这些模型如何学习图片的伪造特征对目前最好的算法来说仍然是一个挑战。

图 1. 源/目标相关的视觉概念和伪造相关的视觉概念之间的关系 在这里的视觉概念是图像区域,例如人类面部的眼睛、嘴巴和额头。在本文中,好的深度伪造检测训练模型从图像匹配的角度主要考虑和伪迹相关的视觉概念而不是源、目标相关的视觉概念。 在本文中,我们旨在从图像匹配的新视角来解释深度伪造检测模型的成功。我们考虑匹配图像如下。如图1所示,使用目标图像的表征来操纵源图像的面部,以生成相应的假图像。然后将上述伪图像、源图像和目标图像视为匹配图像,称为FST匹配。为此,我们设计了不同的度量来定量评估图像匹配的效果,并提出如下三个假设。

假设1 深度伪造检测模型是指真/假图片是基于视觉概念的而不是基于源相关或者目标相关,也就是说,将此类视觉概念视为与伪迹相关。在本文中,视觉概念代表着人脸的嘴、鼻子或眼睛等图像区域。直观地说,假图是从视觉概念生成的它要么来自源图像要么来自目标图像。然而,一些视觉概念可能不可避免地被深度伪造方法操纵,导致它们与源图像和目标图像都不同。经过良好训练的深度伪造检测模型应该基于与源无关且与目标无关的视觉概念来表示真/假图像。

假设2 除了有监督的二进制标签,深度伪造检测模型通过训练集中的FST匹配隐式地学习与伪迹相关的视觉概念。直观地说,二进制标签不足以完成deepfake检测任务。训练图像通常包含其他与伪迹无关的视觉概念,例如图像的身份。这种视觉概念可能共同出现在某些真/假的图像上,导致深度伪造检测模型学习有偏差的伪造表征。例如,如果真图像都是男性而假图像都是女性,则深度假检测模型可以基于图像的性别来推断结果。为此,FST匹配图像应该有助于深度伪迹检测模型丢弃与伪迹无关的视觉概念,并专注于与伪迹相关的视觉概念。因为它们共享与伪迹不相关的常见视觉概念,但使用相反的标签进行注解。

假设3 通过原始训练集中的FST匹配,隐式的学习具有伪迹的视觉概念容易受到视频压缩的影响。深度伪造检测模型当在原始图片上进行训练,在压缩图像上进行测试时,通常会出现显著的性能下降[28,54,36]。我们认为这是因为通过FST匹配伪迹视觉概念的隐式学习对于视频压缩来说是脆弱的。特别是,由于压缩,隐式学习的伪迹视觉概念在假图像上可能变得无法把带压缩的源视觉概念和目标视觉概念区分开来,从而导致深度伪造检测模型做出错误预测。

方法 为了验证所提出的假设,我们提出了一种基于Shapley值[39]的解释方法,来解释具有各种骨干的深度伪造检测模型的预测。Shapley值首先在博弈论[39]中提出,并在最近的研究[31,2]中广泛用于解释DNN内部的表征。具体来说,Shapley值无偏见地估计了每个玩家对游戏总奖励的贡献。它自然满足四个属性,即线性属性、虚拟属性、对称属性和效率属性[45],这确保了它的公平性和可信性。基于Shapley值,我们从图像匹配的新角度评估图像上的视觉概念,以验证所提出的假设。

此外,在验证假设的过程中,我们惊奇地发现,在压缩图像中学习的源/目标视觉概念比在图像上隐式学习的伪迹视觉概念更一致。结合对假设1的理解,我们设计了一个简单的模型,通过从源/目标视觉概念中分离与源/目标无关的表征来指示图像(称为FST匹配深度伪造检测模型),旨在提高对压缩视频的伪造检测性能。我们的实验结果表明,如此简单的架构实现了很好的性能,尤其是在高度压缩(例如c40)的视频上。

贡献: 我们的贡献可以总结如下。

1.我们提出了一种从图像匹配的新角度解释深度伪造检测模型成功的方法,即FST匹配。

2.从FST匹配的角度提出并验证了三个假设,这为深度伪造检测任务提供了新的见解。

3.我们进一步提出了FST匹配Deepfake检测模型,以提高在压缩视频上的性能。

2、相关工作

2.1、深度伪造检测

深度伪造检测的目标是将输入媒介分类为真或假。以前对深度假检测的研究主要集中在提高模型在各种数据集上的性能。些方法[1,4,11,34,35,36]将其视为二分类任务,并在大量收集的数据集上直接训练模型,如Celeb DF[29]、DFDC[12]、FF++[36]等。这些方法在自己的数据集内评估取得了优异的性能,即在已知学习的深度伪造方法操作的图像上测试模型。然而,这些方法往往无法用新提出的深度伪造方法检测不可见操作的数据集。为此,其他研究[55,53,58,24]旨在提高深度伪造检测模型的泛化行。这些方法通常认为假图像共享通常的人类感知的伪迹表征并将此引入到深度伪造方法的处理中。例如混合边界[28]、几何特征[41]和频率特征[30,32,26,18]。然而,这样的假设通常代表着人类对伪迹表示的理解,可能不适用于所有现实生活场景。正确理解真实图像和伪图像之间的关键差异,即探索图像上伪迹表征的本质,仍然是一个持续性的挑战。

据我们所知,专注于解释深度伪造检测模型的可学习表征的研究是很少。在本文中,我们旨在从图像匹配的新角度来解释深度伪造检测模型,来论证对深度伪造检测模型来说什么是伪迹表征,他们是如何学习伪迹表征的,以及如何在现实场景中进一步提高其性能。

2.2、DNNs的可解释性

以往关于DNN可解释性的研究大致可分为两类。一些研究[47,33,13,40,46,57]通过可视化学习的视觉概念来关注DNN的语义解释。Grad CAM[38]和Grad CAM++[7]探索了基于梯度信息的输入图像的属性图。Zhou等人[56]可视化了DNNs内不同单元的实际感受野。Fong等人[15]探索了在多个过滤器和可学习的语义视觉概念之间的关系。Zhang等人提出通过图模型[51]和决策树[52]探索DNN的可学习语义视觉概念之间的关系。然而,与一般的分类任务不同,deepfake检测模型旨在图像上学习与伪影相关的视觉概念。这种表征通常是人们难以察觉的,这使得很难评估从上述方法得出的解释结果的正确性。此外,其他研究提出从数学上解释DNNs的表示,以避免人类对语义表征的估计。为此,一些研究建议基于熵的方法来理解DNN[19,9]。一些研究从博弈论的角度探索了DNN的表征[49,48,50]。然而,尽管上述方法在理论上可以应用于各种类型的DNN,但进一步利用解释结果来指导特定任务的学习(如深度伪造检测)仍然是一个挑战。

在本文中,我们的目标是从图像匹配的新角度弥补一般解释结果与学习的更好的深度伪造检测模型之间的差距。为此,我们根据我们的解释结果设计了FST匹配Deepfake检测模型,并进一步提高了在压缩视频上的性能。

3、算法

在本节中,给定一个训练好的深度伪造检测模型,我们旨在从图像匹配的新角度解释其预测。为此,提出了三个假设。为了验证这些假设,我们提出了在图像上基于Shapley值的评估视觉概念的贡献的一种解释方法[39]。有关Shapley值的更多信息,请参阅补充材料。

3.1、深度伪造检测模型的伪迹表征

假设1 深度伪造检测模型是基于既不与源相关也不与目标相关的视觉概念的真/假图像,也就是说,这种视觉概念应认为与伪迹相关。

在本节中,给定训练好的深度伪造检测模型vd(·)(本文中也称为检测编码器),我们旨在从图像匹配的角度从输入图像上评估已学习的视觉概念。具体而言,我们旨在探索在输入图像上的哪些视觉概念被视为与源相关、目标相关和伪迹相关。然后,我们期望评估这些视觉概念之间的关系,以验证假设。

核心挑战是公平地决定哪些视觉概念与源、目标和伪迹表征相关。具体地说,我们不会在图像上手动标注这些视觉概念,因为它通常代表着人类对伪迹表征的理解,而不是模型中的伪迹表征。为此,我们训练源编码器vs(·)和目标编码器vt(·),以表示图像上的源/目标相关视觉概念。

直观地说,每个假图像与其对应的源图像和目标图像共享某些共同的视觉概念。我们认为,当源编码器vs(这里的vs不是对手PK的vs而是个名字)将每个假图像及其对应的源图像分类为同一类别时,vs将倾向于关注每个假图像上的与源相关的视觉概念。对于目标编码器vt也是如此。具体来说,为了方便起见,我们使用图像的额外属性标签1来训练vs和vt。为了训练源/目标编码器vs/vt,每个假图像被视为拥有与相应的源/目标图像相同的属性标签。每个真图像都被视为其原始属性标签。

我们使用Shapley值[39]来评估在图像上每个编码器预测的视觉概念的区域贡献。为了降低计算成本,我们将输入图像分成L×L个网格,并分别计算每个网格的贡献。设G= { g 11 , g 12 , … , g L L } \{ g_{11},g_{12},…,g_{LL}\} {g11,g12,…,gLL}表示所有网格的集合。 ϕ v d ∈ R L × L , ϕ v s ∈ R L × L , ϕ v t ∈ R L × L ϕ_{vd} ∈ R^{L×L}, ϕ_{vs} ∈ R^{L×L}, ϕ_{vt} ∈ R^{L×L} ϕvd∈RL×L,ϕvs∈RL×L,ϕvt∈RL×L分别表示检测编码器vd、源编码器vs和目标编码器vt的预测对所有网格的贡献。通过这种方式, ϕ v d 、 ϕ v s 和 ϕ v t ϕ_{vd}、ϕ_{vs}和ϕ_{vt} ϕvd、ϕvs和ϕvt分别表示在图像上的伪迹、源和目标视觉概念。更具体地说, ∀ g i j ∈ G ∀g_{ij} ∈ G ∀gij∈G如果 ϕ v d ( g i j ∣ G ) > 0 ϕ_{vd} (g_{ij} |G) > 0 ϕvd(gij∣G)>0则认为与伪迹相关;如果 ϕ v d ( g i j ∣ G ) ≤ 0 ϕ_{vd} (g_{ij} |G) \le 0 ϕvd(gij∣G)≤0则认为与伪迹无关。对于源编码器vs和目标编码器vt也是如此。

基于网格级贡献,我们提出了一种度量标准,来评估与伪迹相关的视觉概念、与源相关的视觉概念和与目标相关的视觉概念之间的关系。根据该假设,深度伪造检测模型应该考虑与伪迹相关的视觉概念既不与源相关,也不与目标相关。因此,与伪迹相关的视觉概念应该与源/目标相关的视觉理念几乎没有交集。为此,我们首先生成掩码 M τ = I ( m a x ( φ v s , φ v t ) > τ ) M_τ=I(max(φ_{vs},φ_{vt})>τ) Mτ=I(max(φvs,φvt)>τ),以表示最重要的与源/目标相关的视觉概念,其中I(·)是指示函数,τ是某个阈值。如果内部条件有效,I(·)返回1,否则I(·)返回0。然后,该度量用于评估这些视觉概念之间的交叉强度,如下所示。 Q τ = ( 1 − M τ ) ⋅ ϕ v d ∑ g i j ∈ G [ 1 − M τ ( g i j ) ] − M τ ⋅ ϕ v d ∑ g i j ∈ G M τ ( g i j ) ( 1 ) Q_{\tau } = \frac {(1 - M_{\tau }) \cdot \phi _{v_d}}{\sum _{g_{ij}\in G}{[1-M_{\tau }(g_{ij})]}} - \frac {M_{\tau }\cdot \phi _{v_d}}{\sum _{g_{ij}\in G}{M_{\tau }(g_{ij})}} \quad\quad\quad\quad(1) Qτ=∑gij∈G[1−Mτ(gij)](1−Mτ)⋅ϕvd−∑gij∈GMτ(gij)Mτ⋅ϕvd(1)其中·表示内积。第一项测量与源/目标无关的视觉概念和伪迹相关视觉概念之间的交叉点的平均强度。第二项测量与源/目标相关的视觉概念和伪迹相关视觉概念之间的交叉点的平均强度。Qτ>0表示与伪迹相关的视觉概念与源/目标无关的视觉概念比与源/目的相关的视觉概念更相关。Qτ<0表示与伪迹相关的视觉概念与源/目标无关的视觉概念的相关性小于源/目标相关的视觉概念。

3.2、学习伪迹表征

假设2 除了有监督的二进制标签,深度伪造检测模型还通过训练集中的FST匹配隐式学习与伪迹相关的视觉概念。

在本节中,为了验证假设,我们期望评估训练集中的FST匹配如何影响深度伪造检测模型的学习。具体而言,训练集中的FST匹配意味着真图像包含与假图像的相应的源图像和目标图像。为此,我们分别使用成对的训练集和不成对的训练集训练两个模型。在成对的训练集中,真图像仅是假图像的对应源图像和目标图像。在不成对的图像中,真图像与成对训练集中的真图像的数量相同,但不对应于任何假图像,然后我们在两个模型上比较ACC、视频级AUC和所提的度量Qτ,以评估FST匹配的有效性。

3.3 在压缩视频上伪迹表征的脆弱性

假设3 通过原始训练集中的FST匹配隐式学习的伪迹视觉概念容易受到视频压缩的影响。

在本节中,为了验证假设,我们旨在测量隐式学习的伪迹视觉概念对压缩视频的稳定性。注意,检测编码器vd首先在原始图像上训练,然后在压缩图像上测试。为此,我们设计了稳定性度量,以评估在不同压缩率(即c23、c40)条件下伪迹视觉概念之间的变化。稳定性度量设计如下。 δ v d = E c m p ∈ { c 23 , c 40 } [ c o s ( ϕ v d c m p , ϕ v d r a w ) ] ( 2 ) \delta _{v_d} = E_{cmp\in \{c23,c40\}}[cos(\phi _{v_d}^{cmp}, \phi _{v_d}^{raw})] \quad\quad\quad\quad(2) δvd=Ecmp∈{c23,c40}[cos(ϕvdcmp,ϕvdraw)](2)其中,表示当在压缩图像上测试时, ϕ v d c m p ϕ^{cmp}_{vd} ϕvdcmp表示网格对检测编码器vd的预测的贡献。 ϕ v d r a w ϕ^{raw}_{vd} ϕvdraw表示在原始图像上测试的网格的贡献。cos(·,·)表示计算余弦相似度的操作。 δ v d ∈ [ 1 , 1 ] δ_{vd} ∈ [ 1, 1] δvd∈[1,1]的值越小表明隐式学习的伪迹视觉概念越容易受到压缩的影响。此外,为了进行更多的比较我们还在压缩视频上评估了源/目标编码器 vs/vt的学习源/目标视觉概念的稳定性。

3.4 FST匹配深度伪造检测模型

基于从FST匹配的角度对深度伪检测模型的理解。我们提出了FST匹配深度伪检测模式,以进一步提高深度伪检测在压缩视频上的性能。在验证假设3的过程中,我们意外地发现,通过源编码器vs和目标编码器vt(即 ϕ v s 和 ϕ v t ϕ_{vs}和 ϕ_{vt} ϕvs和ϕvt)学习的源/目标视觉感念与在压缩图片上通过检测编码器vd学习的伪迹视觉感念(如图2的底部)相比更一致。受假设1的理解的启发,我们认为直接从源/目标视觉概念中理清与源/目标无关的表征表明图像可能提高在压缩视频上的模型性能。详细验证请参见补充说明。

图 2. FST匹配深度伪造检测模型 如图底部所示,我们惊讶的发现,对压缩视频来说 ϕ v s 和 ϕ v t ϕ_{vs} 和 ϕ_{vt} ϕvs和ϕvt比 ϕ v d ϕ_{vd} ϕvd更鲁棒。为此,我们使用源特征编码器和目标特征编码器来明确学习图像上的源和目标表征。特征分解模块进一步提取与源/目标无关的表征,以表示图像的真实性,即真或假。

FST匹配深度伪造检测模型的结构如图2所示,该模型根据假设1旨在为在图像上的基于与源/目标不相关的视觉概念的脸部伪迹分类。为此,我们首先使用源特征编码器和目标特征编码器来直接学习图像上的源特征 f s ∈ R B × C s f_s ∈ R^{B×C_s} fs∈RB×Cs和目标特征 f t ∈ R B × C t f_t ∈ R^{B×C_t} ft∈RB×Ct。B表示输入图像的数量。 C s 和 C t C_s和C_t Cs和Ct表示输出通道的数量。然后,我们设计了特征分离模块来自动在通道上分割与源/目标不相关的 f s i r , f t i r f^{ir}_s ,f^{ir}_t fsir,ftir和与源/目标相关的 f s r , f t r f^r_s, f^r_t fsr,ftr。类似于[23],我们使用智能的通道注意力向量 a s ∈ R B × C s 和 a t ∈ R B × C t a_s ∈ R^{B×C_s} 和 a_t ∈ R^{B×C_t} as∈RB×Cs和at∈RB×Ct来分离 f s 和 f t f_s和 f_t fs和ft其计算如下。 a s = σ ( M L P ( f s ) ) , a t = σ ( M L P ( f t ) ) ( 3 ) a_s = \sigma (MLP(f_s)), \ a_t = \sigma (MLP(f_t)) \quad\quad\quad\quad(3) as=σ(MLP(fs)), at=σ(MLP(ft))(3)其中,MLP表示多层感知机,σ表示sigmoid函数。通过这种方式,源和目标相关特征 f s r , f t r f^r_s, f^r_t fsr,ftr的计算公式分别为 f s r = a s ◦ f s 和 f t r = a t ◦ f t f^r_s = a_s ◦ f_s 和 f^r_t = a_t ◦ f_t fsr=as◦fs和ftr=at◦ft。源和目标不相关特征 f s i r , f t i r f^{ir}_s, f^{ir}_t fsir,ftir的计算公式分别为 f s i r = ( 1 − a s ) ◦ f s 和 f t i r = ( 1 − a t ) ◦ f t f^{ir}_s = (1-a_s) ◦ f_s 和 f^{ir}_t = (1-a_t) ◦ f_t fsir=(1−as)◦fs和ftir=(1−at)◦ft。这里◦表示智能通道的内积。

为了确保分离特征的有效性,我们使用"伪源对验证模块"将 f s r f^r_s fsr和源图像的标签归为同一分布。同理通过"假-目标对验证模块"将 f t r f^r_t ftr和目标图像的标签归为同一分布。 f s i r 和 f t i r f^{ir}_s 和 f^{ir}_t fsir和ftir然后被拼接在一起来预测最终的输入图片标签的真/假。设 y s 、 y t 、 y d y_s、y_t、y_d ys、yt、yd表示图像的源属性标签、目标属性标签和伪造检测标签。 y ^ s , y ^ t , y ^ d \hat y_s, \hat y_t, \hat y_d y^s,y^t,y^d分别表示预测的源属性,目标属性和伪造预测。FST匹配的深度伪造检测模型的分类损失设计如下。 L o s s c l s = − E [ y d l o g y ^ d ] − λ s E [ y s l o g y ^ s ] − λ t E [ y t l o g y ^ t ] ( 4 ) Loss_{cls} = - E[y_d log \hat {y}_d] - \lambda _s E[y_s log \hat {y}_s] - \lambda _t E[y_t log \hat {y}_t ] \quad\quad\quad\quad(4) Losscls=−E[ydlogy^d]−λsE[yslogy^s]−λtE[ytlogy^t](4)

而且,受 [49]的启发,为了最终的预测,我们设计了另一个损失函数来进一步的增强 f s i r 和 f t i r f^{ir}_s 和 f^{ir}_t fsir和ftir之间的相互作用。设h(·)为最终的预测模块。交互损失的目的是增加 [ f s i r , f t i r ] w . r . t [f^{ir}_s , f^{ir}_t ] w.r.t [fsir,ftir]w.r.t联合在一起时产生的额外奖励。并分别对 f s i r 和 f t i r f^{ir}_s 和 f^{ir}_t fsir和ftir对最终预测的奖励进行相加。交互损失的公式如下: L o s s i n t e r a c t i o n = − E [ h ( [ f s i r , f t i r ] ) − h ( [ 0 , f t i r ] ) − h ( [ f s i r , 0 ] ) + h ( [ 0 , 0 ] ) ] ( 5 ) Loss_{interaction} = - E [h([f_s^{ir},f_t^{ir}]) - h([\mathbf {0},f_t^{ir}]) - h([f_s^{ir}, \mathbf {0}]) + h([\mathbf {0}, \mathbf {0}])] \quad\quad\quad\quad(5) Lossinteraction=−E[h([fsir,ftir])−h([0,ftir])−h([fsir,0])+h([0,0])](5)其中, 0 \mathbf 0 0表示与 f s i r 和 f t i r f^{ir}_s 和 f^{ir}_t fsir和ftir大小相同的0向量 h ( [ 0 , 0 ] h([\mathbf 0, \mathbf 0] h([0,0] 表示当 f s i r 和 f t i r f^{ir}_s 和 f^{ir}_t fsir和ftir都没对最终预测起作用时的基础得分。总的损失公式如下: L o s s = L o s s c l s + λ i n t e r L o s s i n t e r a c t i o n ( 6 ) Loss = Loss_{cls} + \lambda _{inter} Loss_{interaction} \quad\quad\quad\quad(6) Loss=Losscls+λinterLossinteraction(6)

4、实验

4.1、实验细节

DNNs & 数据集: 为了验证所提出的假设,我们在不同的骨架上进行了各种实验。具体而言,我们使用ResNet-18/34[22]和EfficientNet-b3[42]作为检测编码器vd、vs和vt的骨干网络。此外,我们还使用[36]和[53]中发布的预训练模型用于检测编码器vd,以与目前最好的方法进行更多比较。

我们在广泛使用的FF++[36]数据集上训练并测试了我们的模型。F++[36]数据集包含5000个视频,包括1000个原始视频和4000个由不同伪造方法操纵的假视频,如Deepfake[14]、FaceSwap[25]、FaceShifter[27]、NeuralTextures[43]和Face2Face[44]。所有模型都在ImageNet[37]数据集上进行了预训练,并在FF++[36]上进行了微调。此外,为了方便,将输入图像的属性标签设置为图像的身份标识。具体地,对于假图像,源/目标编码器期望将图像分类为其对应的源/目标图像的身份标识。对于真实图像,源编码器和目标编码器都期望将图像分类为其自身的原始身份标识。

Shapley值的实现: Shapley值的精确计算在计算上是无法忍受的。为此,我们使用基于采样的方法[5]来近似计算所有视觉概念的贡献。在采样过程中,将未采样的图像网格设置为基线值,在本文中将其设置为零。此外,我们使用与图像的真值标签相对应的softmax层之前选定的标量作为所有编码器的输出分数。

4.2、Shapley值的公平性

图 3. Shapley值的不稳定性(左),假设1的验证(右) 左图显示,随着采样时间的增加,Shapley值变得稳定。右图可视化了源、目标和伪迹的视觉概念的,即 ϕ v s , ϕ v t 和 ϕ v d ϕ_{vs} , ϕ_{vt} 和 ϕ_{vd} ϕvs,ϕvt和ϕvd。结果显示,在各种操作算法中,与伪影相关的视觉概念与源/目标相关视觉概念几乎没有交集。这支持假设1。

Shapley值的精度: 为了确保近似Shapley值的稳定性,我们评估了采样次数T 随着Shapley值的变化所受的影响。具体而言,类似于[48],我们对相同的采样次数T中重复了两次采样过程[5],来分别获得 ϕ 1 和 ϕ 2 ϕ1 和 ϕ2 ϕ1和ϕ2。然后我们在所有测试集上通过不稳定度量 ∣ ∣ ϕ 1 − ϕ 2 ∣ ∣ 2 ∣ ∣ ϕ 1 + ϕ 2 ∣ ∣ 2 \frac{||ϕ_1 -ϕ_2||_2}{||ϕ_1+ϕ_2||_2} ∣∣ϕ1+ϕ2∣∣2∣∣ϕ1−ϕ2∣∣2测量 ϕ 1 和 ϕ 2 ϕ1 和 ϕ2 ϕ1和ϕ2随着采样时间T的改变而改变。如图三所示。我们计算基于 ResNet18 ϕ v d ϕ_{v_{d}} ϕvd的不同采样次数的不稳定性度量。结果表明当T ≥ 100时,我们得到了相对稳定的Shapley值,这确保了结果的公平性。

4.3、假设验证

假设1的验证: 假设1认为训练后表现好的深度伪检测模型是指基于既不与源相关也不与目标相关的视觉概念的图像,即认为它们与伪迹相关。在本节中,我们定性和定量地验证了假设。

对于定性分析,我们发现与伪迹相关的视觉概念与源/目标相关的视觉理念几乎没有交集。在图3中,我们展示了在FF++[36]中使用的不同操作算法的主要贡献的视觉概念之间的相互作用,以及对 ϕ v s , ϕ v t , ϕ v d ϕ_{vs} , ϕ_{vt} , ϕ_{vd} ϕvs,ϕvt,ϕvd的可视化结果。为了获得更好的可视化效果,我们将 ϕ v s , ϕ v t , ϕ v d ϕ_{vs} , ϕ_{vt} , ϕ_{vd} ϕvs,ϕvt,ϕvd归一化为单位向量。检测解码器 v d v_d vd的骨干网络是ResNet-18[22]。源和目标相关的视觉概念基于掩码Mτ表示。为了更清楚,在交集列中,我们只保留了顶部最高的30%的贡献网格。结果表明,deepfake检测模型主要考虑伪迹相关概念,既不与源相关,也不与目标相关。

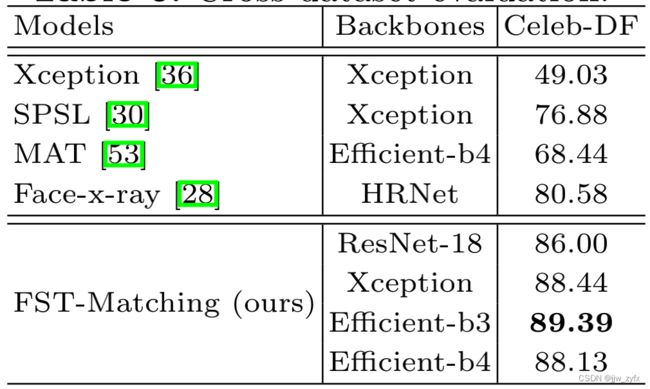

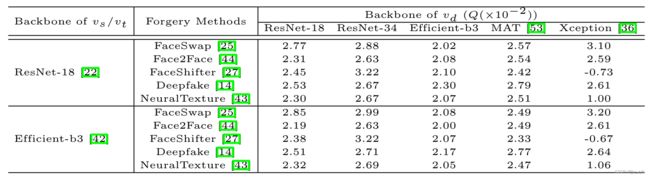

Table 1. 假设1的验证 对不同操纵算法中不同深度伪造检测模型所提出的度量Q ( × 1 0 2 ) (×10^2) (×102)的比较。结果表明,训练有素的深度伪检测模型具有更大的Q值,这表明这些模型将源/目标无关的视觉概念视为伪迹相关。

为了进行定量分析,我们评估了各种DNN和操纵算法中提出的度量Q。在表1中,为了进行公平的比较,我们计算了不同阈值τ之间的Q的平均值。具体而言,τ被设置为不同的值,来保证 { 0.60 L 2 , 0.65 L 2 , … , 0.85 L 2 , 0.9 L 2 , 0.95 L 2 } \{0.60L^2,0.65L^2,…,0.85L^2,0.9L^2,0.95L^2\} {0.60L2,0.65L2,…,0.85L2,0.9L2,0.95L2}网格分别在 M τ M_τ Mτ上。Q>0表示所学习的伪迹相关视觉概念与源/目标无关视觉概念更相关,而不是与源/目的相关视觉概念更相关。结果表明,各种类型的DNN主要考虑与伪迹相关的视觉概念,既不与源相关,也不与目标相关。此外,这些结果与vs和vt的主干选择基本无关,这进一步验证了假设的普遍性。注意,当对FaceShifter[27]操纵的图像进行测试时,Xception[36]的Q<0。这是因为[36]中最初发布的预训练模型Xception之前从未在FaceShifter[27]操作过的伪造图像上进行过训练,因此无法定位FaceShifter[27]上的与伪迹相关的视觉概念。

假设2的验证: 假设2假设训练的好的深度伪检测模型通过训练集中的FST匹配隐式的学习了伪迹相关的视觉概念。为了验证这一假设,我们分别在成对的训练集和未成对的训练集上训练了两个具有相同骨架的模型。在成对的训练中,真图像只有源图像,假图像对应目标图像。相反,未不成对训练集中的真图像与假图像不匹配,但与配对训练集中真图像的数量相同。成对训练集和未成对训练集都是从仅包含40个图像身份特征的FF++[36]数据集向下采样的,与FF++[36]数据集中的初始1000个身份特征相比,这是非常小的。在本节中,我们进行了大量实验,以证明FST匹配对于学习深度伪造检测模型是至关重要。

Table 2. 假设2的验证 在整个FF++[36]数据集(表示为基线)、成对训练集和不成对训练集上训练的模型之间的性能比较。在成对训练集中,真实图像是伪图像的对应源图像和目标图像,即满足FST匹配。结果表明,在成对训练集上训练的模型实现了与基线相似的性能。注意,成对训练集的大小要小得多。这些结果证明了FST匹配的有效性。

首先,我们比较了每个训练模型的ACC和视频级AUC。如表2所示,在成对训练集上训练的模型实现了与基线模型相似的性能,基线模型在整个FF++[36]数据集上训练。注意,成对训练集显著小于原始FF++[36]数据集,这证明了FST匹配在训练集中的重要性。相比之下,在未成对训练集上训练的模型,尽管与成对训练集大小相同,但显示出明显更差的结果。这些结果还表明,训练集中的FST匹配对于学习深度伪造检测模型来说具有重要价值。

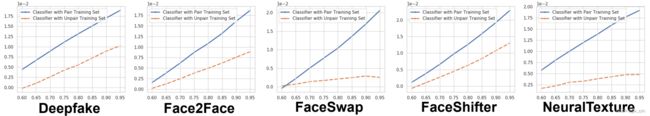

图 4. 假设2的验证 所提出的度量Qτ在成对训练集和不成对训练集上训练的模型之间比较。水平坐标表示设置不同阈值τ时掩模Mτ中保持网格的百分比。检测编码器的骨干是ResNet-18[22]。结果表明,在成对训练集上训练的模型具有更大的Qτ值,这表明FST匹配有助于模型定位与伪迹相关的视觉概念。

此外,我们还比较了每个训练模型之间提出的度量Qτ。为了进行公平的比较,我们计算了所有测试图像中不同τ的度量Qτ的值。如图4所示,在成对训练集上训练的模型具有更大的Qτ值,表明训练集中的FST匹配有效地帮助模型定位源/目标无关的视觉概念,并将其视为与伪迹相关。

假设3的验证: 假设3认为在原始训练集中通过FST匹配隐式学习伪影视觉概念容易受到视频压缩的影响。为了验证该假设,我们在压缩视频上测试了原始训练模型,并在所有测试图像中计算了所提出的度量 δ v d δ_{v_{d}} δvd。对于定性分析,如图2所示,原始训练模型表明与原始图像相比,压缩图像具有明显不同的视觉概念。对于定量分析,在表11中,计算的 δ v d δ_{v_{d}} δvd∈ [1,1]接近于0。这也表明在不同压缩率条件下, ϕ v d ϕ_{v_{d}} ϕvd的变化很大。

此外,我们还评估了源/目标视觉概念的稳定性。令人惊讶的是,如图2和表11所示,与隐式学习的伪迹视觉概念相比,这种学习的视觉概念在压缩视频上表现出了极大的一致性。这样的结果激励我们通过设计一个模型来提高压缩视频的模型性能,该模型明确地利用了训练集中的FST匹配。

4.4、FST匹配深度伪造检测模型

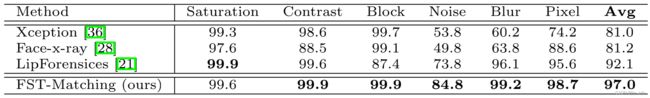

Table 4: 与目前最好的方法在视频压缩上的性能比较

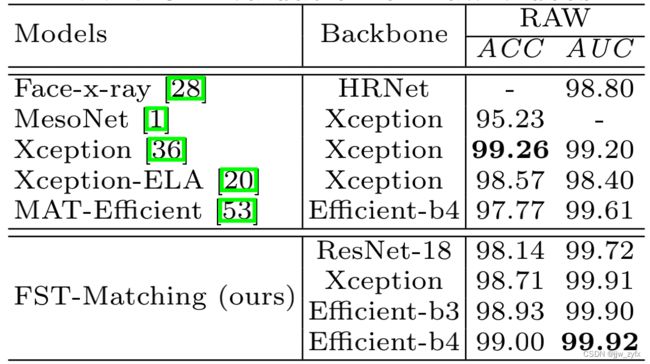

在压缩视频上的性能比较: 在本节中,我们将我们的模型与当前最好的模型的性能进行了比较。表4显示了在压缩视频上的性能。我们的模型在在压缩视频上尤其是 c40视频上,达到了很好的性能。具体来说,当与其他方法的相同骨干相一致时,我们的模型在压缩视频上取得了优异的性能,尤其是在高度压缩的(例如c40)视频上。这些结果也表明了我们方法的广泛适用性。同时,请注意,在表4中的c23上,与MAT[53]仍存在微弱的性能差距。与我们的方法不同,MAT[53]设计了特定的模块来学习图像的频率特征。这些特征被广泛证明可以有效地增强深度伪造检测模型在压缩视频上的性能[18,26,30,32]。为此,我们认为将这些特性集成到我们的模型中可能会填补这一性能空白。此外,由于我们的方法只是利用我们的创新解释结果的第一次尝试,我们相信在未来在我们的研究基础上,可以进一步激发更有效的方法。

Table 5:在原始视频上的评估

在原始视频上的性能比较: 为了进行更全面的分析,我们还对原始视频模型进行了评估。表5中的结果表明,我们的方法在原始图像上仍然表现良好。

泛化能力上的评估: 我们进行了另一个实验来评估我们方法的泛化能力。为此,我们和 SPSL [30]中采用了相同的交叉数据集实验设置。结果如表6所示,其中度量为AUC(%)。无论采用什么骨干[30],我们在FF++[36]上训练的模型在Celeb DF[29]上取得了优异的性能。

Table 7:在交叉数据集上的评估 在 FF++上就图片编辑的 AUC (%)的鲁棒性。

图片编辑操作的鲁棒性: 当图像编辑操作应用于图像时,我们进行了另一个实验来评估我们的方法。为此,我们遵循了与LipForensics[21]中相同的鲁棒性实验设置。结果如表7所示,其中度量为AUC(%)。我们的方法对列出的扰动也表现出了很强的鲁棒性。

5、结论

在本文中,我们从图像匹配的新角度解释了深度伪检测模型的成功。为此,在各种DNN中,提出并验证了三种假设即:1.深度伪造检测模型基于既不与源相关也不与目标相关的视觉概念来表示真/假图像,而是将此类视觉概念视为与伪迹相关。2.除了有监督的二进制标签,deepfake检测模型通过训练集中的FST匹配隐式学习与伪影相关的视觉概念。3.通过原始训练集中的FST匹配隐式学习的伪影视觉概念容易受到视频压缩的影响。在此基础上,我们进一步提出了FST匹配深度伪造检测模型,并在压缩视频上取得了良好的性能。这项研究为探索图像伪迹表征的本质提供了机会,并为深度伪造检测任务提供了新的思路。