Python:PyTorch 设置随机种子

为了保证基于 PyTorch 的模型的可再现性,需要设定随机种子

但问题关键还是在于,如果知道随机性来自哪里,设置对应的随机种子即可

比如使用了 numpy.random,则应设置 numpy.random.seed(seed)

在 PyTorch 中主要有以下几种随机种子设置规则:

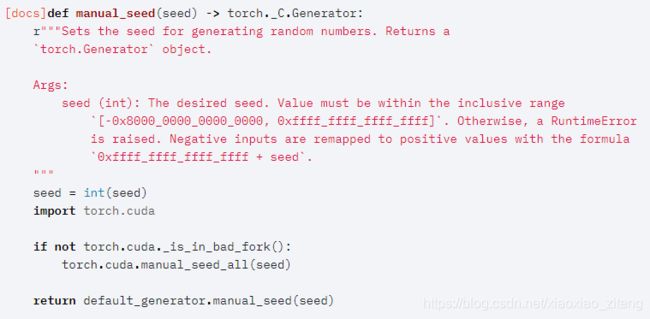

1、torch.manual_seed(seed)

设置用于生成随机数的种子,返回一个 torch.Generator 对象。

其内部还调用了将要提到的 torch.cuda.manual_seed_all(seed)

2、torch.cuda.manual_seed(seed)

设置当前GPU生成随机数的种子。

如果CUDA不可用,调用这个函数是安全的;在这种情况下,它会被默默地忽略。

如果使用了多个GPU,则应调用 torch.cuda.manual_seed_all(seed)。

3、torch.cuda.manual_seed_all(seed)

设置所有GPU上生成随机数的种子。

如果CUDA不可用,调用这个函数是安全的;在这种情况下,它会被默默地忽略。

以上函数 manual 的意义在于设为固定值,以保证可再现。

有些人提供了文件开头同时设置多项随机种子保证随机性,以求一劳永逸,可作参考。

个人认为,还是需要了解自己的程序的随机性产生在哪里,对症下药。

另外,在 torch 中包含了其他涉及随机数的函数,尽管实际未必会用到:

4、torch.seed()

将用于生成随机数的种子设置为不确定的随机数,返回64 bit的数字。

5、torch.initial_seed()

返回以 python 的 long 类型表示的用于生成随机数的初始种子。

6、torch.cuda.seed()

在当前GPU上将用于生成随机数的种子设置为随机数。

如果CUDA不可用,调用这个函数是安全的;在这种情况下,它会被默默地忽略。

如果使用了多个GPU,则应调用 torch.cuda.seed_all()。

7、torch.cuda.seed_all()

在所有GPU上将用于生成随机数的种子设置为随机数。

如果CUDA不可用,调用这个函数是安全的;在这种情况下,它会被默默地忽略。

8、torch.cuda.initial_seed()

返回当前GPU的当前随机种子,用于CUDA初始化。