- 安装Hadoop并运行WordCount程序

凹凸曼暴打小怪兽

hadooppythonlinux

(一)asdfghjklx在虚拟机上安装java来,我们先给虚拟机上安装javaJDK。注意,后面我们会按照如下步骤来操作有:1.把javaJDK文件上传到服务器上。2.解压文件。3.配置环境变量。来,分别操作如下:1.上传文件到虚拟机。用FinalShell传输工具将JDK导入到opt目录下面的software文件夹下面(opt/software文件夹是我们自己创建的)\2.解压文件。把刚才创建

- 安装Hadoop并运行WordCount程序

2401_84653595

hadooplinux大数据

(一)asdfghjklx在虚拟机上安装java来,我们先给虚拟机上安装javaJDK。注意,后面我们会按照如下步骤来操作有:1.把javaJDK文件上传到服务器上。2.解压文件。3.配置环境变量。来,分别操作如下:1.上传文件到虚拟机。用FinalShell传输工具将JDK导入到opt目录下面的software文件夹下面(opt/software文件夹是我们自己创建的)2.解压文件。把刚才创建的

- hadoop客户端该如何配置

huanbia

hadoop笔记hadoop客户端

Hadoop集群主要是由三部分组成的:主节点、从节点和客户端,即master、slave和client。我们在搭建hadoop集群的时候通常只考虑了主节点和从节点的搭建,却忽略了客户端。当我们搭建完成后,我们在其中的一台机器上运行wordcount或者计算π时,实际上我们已经默认将一台主节点或者一台从节点当做客户端来使用了,但是,如果我想把客户端独立,该如何单独配置客户端呢?答案其实很简单,只要在

- win10 spark scala 本地运行wordcount

疯琴

大数据java/scalaflink/spark

注意每次修改环境变量都要重启cmd本机运行需要hadoopcommon,可以从github下载zip,解包以后设置HADOOP_HOME环境变量指向它,然后在PATH里加上HADOOP_HOME\bin,特别注意,hadoopcommon的版本要和spark的hadoop版本匹配spark的scala和本机的scala大版本要匹配报错ExceptionwhiledeletingSparktempd

- 合肥工业大学2022大数据技术实验二

一头骇人鲸

大数据技术大数据hadoopjava

实验序号及名称:实验二在Hadoop平台上部署WordCount程序实验时间∶2022年5月14日预习内容一、实验目的和要求∶在Hadoop平台上部署WordCount程序。二、实验任务∶该项任务请同学作为作业自行完成,并提交实验报告。脱离ide环境运行wordcount三、实验准备方案,包括以下内容:(硬件类实验:实验原理、实验线路、设计方案等)(软件类实验:所采用的系统、组件、工具、核心方法、

- MapReduce和Yarn部署+入门

Y蓝田大海

大数据开发mapreduce大数据

看的黑马视频记的笔记目录1.入门知识点2.部署mapred-env.shmapred-site.xmlyarn-env.shyarn-site.xml分发到另外两个节点启动YARN启动WEBUI页面3.提交自带MapReduce示例程序到YARN运行wordcount求圆周率1.入门知识点明天2.部署在node1以hadoop用户做出以下改进:mapred-env.shexportJAVA_HOM

- Hadoop入门学习之二:一步一步运行WordCount

小_强

Hadoophadoopwordcount入门

WordCount是学习Hadoop的经典入门范例。下面通过一步步的操作,来编译、打包、运行WordCount程序。1、在Hadoop1.0.4的解压目录的如下位置可以找到WordCount.java的源文件src/examples/org/apache/hadoop/examples/WordCount.java2、新建一个dev的文件夹,将WordCount.java拷贝至dev/wordco

- Flink运行wordcount——读写hdfs

雷神乐乐

#Flink-Java版flinkhdfs大数据

packagecom.test;importorg.apache.flink.api.common.functions.FlatMapFunction;importorg.apache.flink.api.java.tuple.Tuple2;importorg.apache.flink.streaming.api.datastream.DataStream;importorg.apache.fli

- Hadoop学习笔记:运行wordcount对文件字符串进行统计案例

朱季谦

大数据hadoop学习笔记

文/朱季谦我最近使用四台Centos虚拟机搭建了一套分布式hadoop环境,简单模拟了线上上的hadoop真实分布式集群,主要用于业余学习大数据相关体系。其中,一台服务器作为NameNode,一台作为SecondaryNameNode,剩下两台当做DataNodes节点服务器,类似下面这样一个架构——NameNodeSecondaryNameNodeDataNodesmaster1(192.168

- MapReduce分布式编程实验报告

JackZhao666

MapReduce大数据

MapReduce分布式编程一、分布式编程的介绍二、什么是MapReduce三、运行wordcount程序WordCountMapper类WordCountReduce类WordCountDriver类导出jar包一、分布式编程的介绍可在分布计算机系统的几台计算机上同时协调执行的程序设计方法,分布式程序设计的主要特征是分布和通信。采用分布式程序设计方法设计程序时,一个程序由若干个可独立执行的程序模

- ubuntu部署flink集群 ,运行wordcount 例子

Sonder_s

flinkflinkjava大数据

说明:事先完成了以下的准备工作:ubuntu16安装了hadoop集群(完全分布式)hadoop集群有5个节点:hadoop1~hadoop6(没有hadoop2)每个节点都安装了flink-1.12.0(略),flink有六个节点运行的代码jar包获取方式: 在windows上的IntelliJIDEA上编写代码,打包成jar包提交到ubuntu上的集群上运行 运行flink自带的例子1、s

- 配置伪分布式hadoop集群(附常见配置问题)

ckqqqqq

大数据hadoop阿里云分布式

配置伪分布式hadoop并运行wordcount程序ps:本教程在虚拟机和阿里云服务器上都配置成功,建议使用虚拟机(容易成功)。本实验最后将运行hadoop自带的wordcount程序用以检验配置是否成功。实验目的安装单机伪分布式Hadoop并运行程序,熟悉hadoop集群的部署操作。目录见右边实验内容每人在自己本地电脑上正确安装和运行伪分布式Hadoop系统。安装完成后,自己寻找一组英文网页数据

- 海豚调度器初次使用 .......

黄瓜炖啤酒鸭

sparksparkbigdata海豚调度器dolphinScheduler

一,部署部分省略,官网有详细的教程,顺着步骤做就好了。二,先说说调用spark运行wordcount案例流程1,编写代码packagecom.sjb.exampleimportorg.apache.log4j.Loggerimportorg.apache.spark.rdd.RDDimportorg.apache.spark.{SparkConf,SparkContext}importorg.ap

- Flink基础系列8-Flink on yarn运行wordcount程序

只是甲

大数据和数据仓库#Flinkflinkflinkonyarnflink程序运行

文章目录环境介绍一.Maven配置二.Java代码编写三.Maven打包并上传四.运行jar文件五.运行其它的class文件参考环境介绍测试服务器CDH6.3.1版本安装Flink1.9版本。hello.txt文件hellowordhellohdfshellomapreducehelloyarnhellohivehellosparkhelloflink一.Maven配置Flink依赖的配置org.

- hadoop运行WordCount时,Input path does not exist错误原因

摆烂z

hadoop前端大数据

修改配置文件core-site.xml为如下所示vim/usr/local/hadoop/etc/hadoop/core-site.xmlxml文件改为如果将core-site.xml文件变动为原来的内容,则程序将不再去hdfs://localhost:9000下寻找input文件,而是在当前目录下寻找input文件,程序能够正常运行。

- 在Windows10上利用wsl安装docker、hadoop以及运行WordCount

mxy990811

大数据存储大数据docker

第一步以管理员打开WindowsPowerShell第二步安装wsl以及Ubuntuwsl--installwsl--install-dUbuntu第三步安装Docker官网网址https://docs.docker.com/desktop/install/windows-install/可以看到,官网说了安装dockerforwindows前需要有wsl2backend3.1证实docker可以

- 1.Flink源码编译

键盘上的艺术家w

#从0到1阅读Flink源码flink大数据

目录目录1.1软件安装1.1.1jdk1.1.2maven1.1.3nodejs1.2下载flink源码1.3编译源码1.4idea打开flink源码1.5运行wordcount1.1软件安装软件地址链接:https://pan.baidu.com/s/1ZxYydR8rBfpLCcIdaOzxVg提取码:12xq1.1.1jdk1.1.2maven1.1.3nodejsnode编译flink-r

- 实战:使用Docker部署Hadoop集群

小沈同学呀

hadoopdocker大数据dockerhadoop容器

文章目录Hadoop简介Hadoop优势Hadoop应用场景docker与docker-compose安装Hadoop集群搭建环境变量docker-compose环境文件树结构编排并运行容器运行wordcount例子写在最后Hadoop简介Hadoop是一个由Apache基金会所开发的分布式系统基础架构。用户可以在不了解分布式底层细节的情况下,开发分布式程序,充分利用集群进行高速运算和存储。Had

- ERROR:Error: Could not find or load main class org.apache.hadoop.mapreduce.v2.app.MRAppMaster

程光CS

踩坑日记hadoop

问题场景我在学习尚硅谷的Hadoop课程的群起集群(p31)这一节时,在配置好core-site.xml、hdfs-site.xml、yarn-site.xml、mapred-site.xml这四个文件后,启动集群并运行wordcount样例程序hadoopjarshare/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jarwordcount/

- 如何在docker内搭建hadoop集群

szper

数据挖掘

直接使用机器部署hadoop集群十分痛苦,还没到运行wordcount,就被各种nodemanager、datanode、namenode之中各种出问题搞得头昏脑胀。为了寻找更简单的hadoop集群配置,查阅了不少资料,我想到了docker,用docker搭建一个hadoop集群,此帖技术内容并非原创,仅分享给大家。项目参考了alvinhenrick/hadoop-mutinode项目,不过我做了

- Day50 Hadoop概述及其架构

Tian-Ys

笔记python

目录概述:启动Hadoop失败的情况:1、没有该Hadoop界面:2、Hadoop界面中没有子节点:上传文件运行wordcount参数解释:Hadoop基本命令详细启动脚本介绍1、全部启动集群所有进程2、单独启动hdfs(web端口50070)和yarn(web端口8088)的相关进程3、单独启动某一个进程hdfsshell常用操作:概述:Hadoop的三种运行模式:1.本地模式(学习)1.没有H

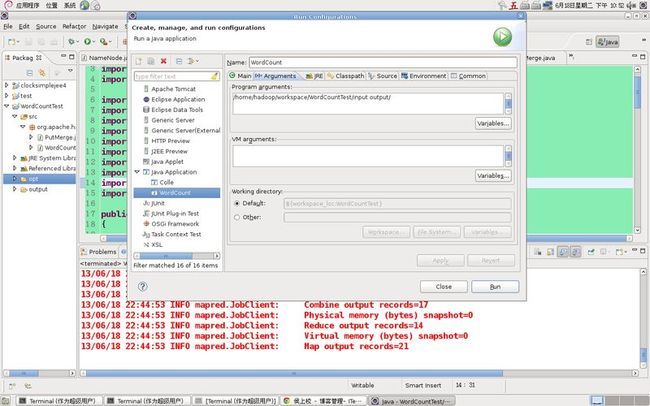

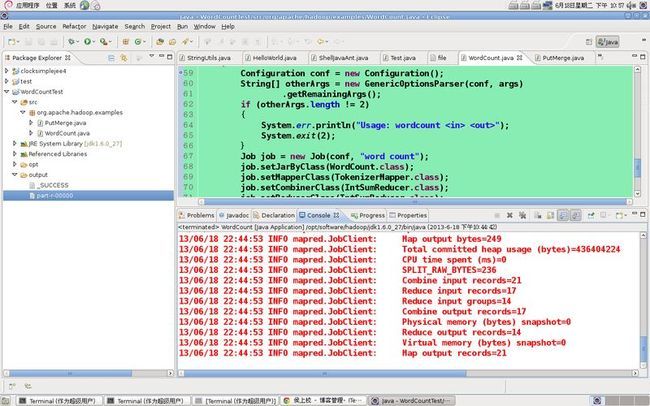

- Eclipse环境搭建并且运行wordcount程序

|旧市拾荒|

【1】Hadoopeclipsejavahadoop分布式

一、安装Hadoop插件1.所需环境hadoop2.0伪分布式环境平台正常运行所需压缩包:eclipse-jee-luna-SR2-linux-gtk-x86_64.tar.gz在Linux环境下运行的eclipse软件压缩包,解压后文件名为eclipsehadoop2x-eclipse-plugin-master.zip在eclipse中需要安装的Hadoop插件,解压后文件名为hadoop2x

- 安装部署Spark集群以及运行WordCount详细步骤

飘羽

hadoop大数据hdfs

1.在安装Spark之,确保Hadoop已经成功安装,并且Hadoop已经正常启动。Hadoop正常启动的验证过程如下:(1)使用下面的命令,看可否正常显示HDFS上的目录列表#hdfsdfs-ls/(2)使用浏览器查看相应界面输入网址:http://192.168.222.100:50070/输入网址:http://192.168.222.100:18088/该页面的结果跟Hadoop安装部分浏

- 在 YARN 上运行 mapreduce 的 jar 包

cdarling

想学习运行一个mapreduce程序试试,记录如下本地运行wordcount新建maven项目,添加hadoop-client,版本比如3.1.2官方的wordcount直接拿来用就可以需要把winutils.exe和hadoop.dll放到环境变量HADOOP_HOME中,这两个文件夹需要在bin子文件夹中,下载链接添加两个运行参数,一个输入文件名,一个输出文件名,直接就可以运行了单服务器配置(

- 云计算 - 4 - Spark的安装与应用

SYSU_Zhiyuan

Linuxspark云计算scala

云计算-4-Spark的安装与应用目标Spark的安装:1、下载配置Scala1.1下载Scala1.2配置Scala的路径1.3测试Scala是否安装完成2、下载配置Spark2.1下载Spark2.2配置Spark的路径2.3修改Spark的配置文件3、将文件复制到子节点4、启动Spark5、测试Spark5.1创建测试文件5.2运行WordCount程序,得到结果Spark的应用:1、计算p

- Hadoop伪分布式运行wordcount例子

Tiramicrystal

Hadoop大数据hadoopmapreduce

1.进入Hadoop目录,新建一个test.log文件,cat命令查看文件内容;2.启动yarn和dfs,,一种是全部启动start-all.sh,另外一种分别启动,如下图的提示;3.用命令jps查看下面这些是否都有了4.把新建的文件传到HDFS的data/input中,用ls命令查看是否传递成功;5.进入Mapreduce目录;6.ls命令查看Mapreduce里面的文件,运行jar包;7.查看

- 配置Hadoop伪分布模式并运行Wordcount示例

qbyjxg001

HADOOP

伪分布模式主要涉及一下的配置信息:修改Hadoop的核心配置文件core-site.xml,主要是配置HDFS的地址和端口号;修改Hadoop中HDFS的配置文件hdfs-site.xml,主要是配置replication;修改Hadoop的MapReduce的配置文件mapred-site.xml,主要是配置JobTracker的地址和端口;在具体操作前我们先在Hadoop目录下创建几个文件夹:

- hadoop-2.6.0伪分布运行WordCount

礼彬fly

Hadoop旅程

hadoop-2.6.0伪分布运行WordCount1、启动Hadoop:2、创建file文件夹:这个是建在本地硬盘上的:查看创建的file文件:进入该目录,创建两个txt文件:结果如下:3、在HDFS上创建输入文件夹目录input:把本地硬盘上创建的文件传进input里面:查看结果:4、Hadoop自带的运行wordcount例子的jar包:5、开始运行wordcount:过程:查看运行结果:附

- WordCount打包部署到Flink Standalone 集群模式的运行过程演示

若兰幽竹

Flinkflink

WordCount打包部署到FlinkStandalone集群模式的运行过程演示一、实验环境二、程序及打包三、代码上传及运行四、小结一、实验环境本次实验主要是向大家演示了在FlinkStandalone模式下运行WordCount程序的过程,其目的想让大家知道flink程序开发完成后,如何将其打包上传到服务器,并能通过查看webui界面查看flink相关的概念等。虚拟机VMWareworkStat

- Hadoop-集群运行

王智刚

目录步骤一、NameNode格式化步骤二、启动NameNode步骤三、启动SecondaryNameNode步骤四、slave启动DataNode步骤五、查看HDFS的报告步骤六、浏览器查看节点状态步骤七、配置免密登录步骤八、启动dfs和yarn步骤九、运行WordCount测试步骤十、停止Hadoop前提:需要在上节Hadoop文件参数配置的基础上完成步骤一、NameNode格式化第一次启动HD

- PHP,安卓,UI,java,linux视频教程合集

cocos2d-x小菜

javaUIlinuxPHPandroid

╔-----------------------------------╗┆

- zookeeper admin 笔记

braveCS

zookeeper

Required Software

1) JDK>=1.6

2)推荐使用ensemble的ZooKeeper(至少3台),并run on separate machines

3)在Yahoo!,zk配置在特定的RHEL boxes里,2个cpu,2G内存,80G硬盘

数据和日志目录

1)数据目录里的文件是zk节点的持久化备份,包括快照和事务日

- Spring配置多个连接池

easterfly

spring

项目中需要同时连接多个数据库的时候,如何才能在需要用到哪个数据库就连接哪个数据库呢?

Spring中有关于dataSource的配置:

<bean id="dataSource" class="com.mchange.v2.c3p0.ComboPooledDataSource"

&nb

- Mysql

171815164

mysql

例如,你想myuser使用mypassword从任何主机连接到mysql服务器的话。

GRANT ALL PRIVILEGES ON *.* TO 'myuser'@'%'IDENTIFIED BY 'mypassword' WI

TH GRANT OPTION;

如果你想允许用户myuser从ip为192.168.1.6的主机连接到mysql服务器,并使用mypassword作

- CommonDAO(公共/基础DAO)

g21121

DAO

好久没有更新博客了,最近一段时间工作比较忙,所以请见谅,无论你是爱看呢还是爱看呢还是爱看呢,总之或许对你有些帮助。

DAO(Data Access Object)是一个数据访问(顾名思义就是与数据库打交道)接口,DAO一般在业

- 直言有讳

永夜-极光

感悟随笔

1.转载地址:http://blog.csdn.net/jasonblog/article/details/10813313

精华:

“直言有讳”是阿里巴巴提倡的一种观念,而我在此之前并没有很深刻的认识。为什么呢?就好比是读书时候做阅读理解,我喜欢我自己的解读,并不喜欢老师给的意思。在这里也是。我自己坚持的原则是互相尊重,我觉得阿里巴巴很多价值观其实是基本的做人

- 安装CentOS 7 和Win 7后,Win7 引导丢失

随便小屋

centos

一般安装双系统的顺序是先装Win7,然后在安装CentOS,这样CentOS可以引导WIN 7启动。但安装CentOS7后,却找不到Win7 的引导,稍微修改一点东西即可。

一、首先具有root 的权限。

即进入Terminal后输入命令su,然后输入密码即可

二、利用vim编辑器打开/boot/grub2/grub.cfg文件进行修改

v

- Oracle备份与恢复案例

aijuans

oracle

Oracle备份与恢复案例

一. 理解什么是数据库恢复当我们使用一个数据库时,总希望数据库的内容是可靠的、正确的,但由于计算机系统的故障(硬件故障、软件故障、网络故障、进程故障和系统故障)影响数据库系统的操作,影响数据库中数据的正确性,甚至破坏数据库,使数据库中全部或部分数据丢失。因此当发生上述故障后,希望能重构这个完整的数据库,该处理称为数据库恢复。恢复过程大致可以分为复原(Restore)与

- JavaEE开源快速开发平台G4Studio v5.0发布

無為子

我非常高兴地宣布,今天我们最新的JavaEE开源快速开发平台G4Studio_V5.0版本已经正式发布。

访问G4Studio网站

http://www.g4it.org

2013-04-06 发布G4Studio_V5.0版本

功能新增

(1). 新增了调用Oracle存储过程返回游标,并将游标映射为Java List集合对象的标

- Oracle显示根据高考分数模拟录取

百合不是茶

PL/SQL编程oracle例子模拟高考录取学习交流

题目要求:

1,创建student表和result表

2,pl/sql对学生的成绩数据进行处理

3,处理的逻辑是根据每门专业课的最低分线和总分的最低分数线自动的将录取和落选

1,创建student表,和result表

学生信息表;

create table student(

student_id number primary key,--学生id

- 优秀的领导与差劲的领导

bijian1013

领导管理团队

责任

优秀的领导:优秀的领导总是对他所负责的项目担负起责任。如果项目不幸失败了,那么他知道该受责备的人是他自己,并且敢于承认错误。

差劲的领导:差劲的领导觉得这不是他的问题,因此他会想方设法证明是他的团队不行,或是将责任归咎于团队中他不喜欢的那几个成员身上。

努力工作

优秀的领导:团队领导应该是团队成员的榜样。至少,他应该与团队中的其他成员一样努力工作。这仅仅因为他

- js函数在浏览器下的兼容

Bill_chen

jquery浏览器IEDWRext

做前端开发的工程师,少不了要用FF进行测试,纯js函数在不同浏览器下,名称也可能不同。对于IE6和FF,取得下一结点的函数就不尽相同:

IE6:node.nextSibling,对于FF是不能识别的;

FF:node.nextElementSibling,对于IE是不能识别的;

兼容解决方式:var Div = node.nextSibl

- 【JVM四】老年代垃圾回收:吞吐量垃圾收集器(Throughput GC)

bit1129

垃圾回收

吞吐量与用户线程暂停时间

衡量垃圾回收算法优劣的指标有两个:

吞吐量越高,则算法越好

暂停时间越短,则算法越好

首先说明吞吐量和暂停时间的含义。

垃圾回收时,JVM会启动几个特定的GC线程来完成垃圾回收的任务,这些GC线程与应用的用户线程产生竞争关系,共同竞争处理器资源以及CPU的执行时间。GC线程不会对用户带来的任何价值,因此,好的GC应该占

- J2EE监听器和过滤器基础

白糖_

J2EE

Servlet程序由Servlet,Filter和Listener组成,其中监听器用来监听Servlet容器上下文。

监听器通常分三类:基于Servlet上下文的ServletContex监听,基于会话的HttpSession监听和基于请求的ServletRequest监听。

ServletContex监听器

ServletContex又叫application

- 博弈AngularJS讲义(16) - 提供者

boyitech

jsAngularJSapiAngularProvider

Angular框架提供了强大的依赖注入机制,这一切都是有注入器(injector)完成. 注入器会自动实例化服务组件和符合Angular API规则的特殊对象,例如控制器,指令,过滤器动画等。

那注入器怎么知道如何去创建这些特殊的对象呢? Angular提供了5种方式让注入器创建对象,其中最基础的方式就是提供者(provider), 其余四种方式(Value, Fac

- java-写一函数f(a,b),它带有两个字符串参数并返回一串字符,该字符串只包含在两个串中都有的并按照在a中的顺序。

bylijinnan

java

public class CommonSubSequence {

/**

* 题目:写一函数f(a,b),它带有两个字符串参数并返回一串字符,该字符串只包含在两个串中都有的并按照在a中的顺序。

* 写一个版本算法复杂度O(N^2)和一个O(N) 。

*

* O(N^2):对于a中的每个字符,遍历b中的每个字符,如果相同,则拷贝到新字符串中。

* O(

- sqlserver 2000 无法验证产品密钥

Chen.H

sqlwindowsSQL ServerMicrosoft

在 Service Pack 4 (SP 4), 是运行 Microsoft Windows Server 2003、 Microsoft Windows Storage Server 2003 或 Microsoft Windows 2000 服务器上您尝试安装 Microsoft SQL Server 2000 通过卷许可协议 (VLA) 媒体。 这样做, 收到以下错误信息CD KEY的 SQ

- [新概念武器]气象战争

comsci

气象战争的发动者必须是拥有发射深空航天器能力的国家或者组织....

原因如下:

地球上的气候变化和大气层中的云层涡旋场有密切的关系,而维持一个在大气层某个层次

- oracle 中 rollup、cube、grouping 使用详解

daizj

oraclegroupingrollupcube

oracle 中 rollup、cube、grouping 使用详解 -- 使用oracle 样例表演示 转自namesliu

-- 使用oracle 的样列库,演示 rollup, cube, grouping 的用法与使用场景

--- ROLLUP , 为了理解分组的成员数量,我增加了 分组的计数 COUNT(SAL)

- 技术资料汇总分享

Dead_knight

技术资料汇总 分享

本人汇总的技术资料,分享出来,希望对大家有用。

http://pan.baidu.com/s/1jGr56uE

资料主要包含:

Workflow->工作流相关理论、框架(OSWorkflow、JBPM、Activiti、fireflow...)

Security->java安全相关资料(SSL、SSO、SpringSecurity、Shiro、JAAS...)

Ser

- 初一下学期难记忆单词背诵第一课

dcj3sjt126com

englishword

could 能够

minute 分钟

Tuesday 星期二

February 二月

eighteenth 第十八

listen 听

careful 小心的,仔细的

short 短的

heavy 重的

empty 空的

certainly 当然

carry 携带;搬运

tape 磁带

basket 蓝子

bottle 瓶

juice 汁,果汁

head 头;头部

- 截取视图的图片, 然后分享出去

dcj3sjt126com

OSObjective-C

OS 7 has a new method that allows you to draw a view hierarchy into the current graphics context. This can be used to get an UIImage very fast.

I implemented a category method on UIView to get the vi

- MySql重置密码

fanxiaolong

MySql重置密码

方法一:

在my.ini的[mysqld]字段加入:

skip-grant-tables

重启mysql服务,这时的mysql不需要密码即可登录数据库

然后进入mysql

mysql>use mysql;

mysql>更新 user set password=password('新密码') WHERE User='root';

mysq

- Ehcache(03)——Ehcache中储存缓存的方式

234390216

ehcacheMemoryStoreDiskStore存储驱除策略

Ehcache中储存缓存的方式

目录

1 堆内存(MemoryStore)

1.1 指定可用内存

1.2 驱除策略

1.3 元素过期

2 &nbs

- spring mvc中的@propertysource

jackyrong

spring mvc

在spring mvc中,在配置文件中的东西,可以在java代码中通过注解进行读取了:

@PropertySource 在spring 3.1中开始引入

比如有配置文件

config.properties

mongodb.url=1.2.3.4

mongodb.db=hello

则代码中

@PropertySource(&

- 重学单例模式

lanqiu17

单例Singleton模式

最近在重新学习设计模式,感觉对模式理解更加深刻。觉得有必要记下来。

第一个学的就是单例模式,单例模式估计是最好理解的模式了。它的作用就是防止外部创建实例,保证只有一个实例。

单例模式的常用实现方式有两种,就人们熟知的饱汉式与饥汉式,具体就不多说了。这里说下其他的实现方式

静态内部类方式:

package test.pattern.singleton.statics;

publ

- .NET开源核心运行时,且行且珍惜

netcome

java.net开源

背景

2014年11月12日,ASP.NET之父、微软云计算与企业级产品工程部执行副总裁Scott Guthrie,在Connect全球开发者在线会议上宣布,微软将开源全部.NET核心运行时,并将.NET 扩展为可在 Linux 和 Mac OS 平台上运行。.NET核心运行时将基于MIT开源许可协议发布,其中将包括执行.NET代码所需的一切项目——CLR、JIT编译器、垃圾收集器(GC)和核心

- 使用oscahe缓存技术减少与数据库的频繁交互

Everyday都不同

Web高并发oscahe缓存

此前一直不知道缓存的具体实现,只知道是把数据存储在内存中,以便下次直接从内存中读取。对于缓存的使用也没有概念,觉得缓存技术是一个比较”神秘陌生“的领域。但最近要用到缓存技术,发现还是很有必要一探究竟的。

缓存技术使用背景:一般来说,对于web项目,如果我们要什么数据直接jdbc查库好了,但是在遇到高并发的情形下,不可能每一次都是去查数据库,因为这样在高并发的情形下显得不太合理——

- Spring+Mybatis 手动控制事务

toknowme

mybatis

@Override

public boolean testDelete(String jobCode) throws Exception {

boolean flag = false;

&nbs

- 菜鸟级的android程序员面试时候需要掌握的知识点

xp9802

android

熟悉Android开发架构和API调用

掌握APP适应不同型号手机屏幕开发技巧

熟悉Android下的数据存储

熟练Android Debug Bridge Tool

熟练Eclipse/ADT及相关工具

熟悉Android框架原理及Activity生命周期

熟练进行Android UI布局

熟练使用SQLite数据库;

熟悉Android下网络通信机制,S