半监督语义分割论文学习记录

Semi-Supervised Semantic Segmentation with Cross-Consistency Training

1.1 motivation

一致性训练的目的是在应用于输入的小扰动上增强模型预测的不变性。因此,学习的模型将对这样的小变化具有鲁棒性。一致性训练的有效性在很大程度上取决于数据分布的行为,即集群假设,其中类必须由低密度区域分隔。在语义分割中,在输入中,我们没有观察到低密度区域的存在,,而是在编码器的输出中,观察到了这种现象。基于这一观察,我们建议在应用于编码器输出的不同形式的扰动上加强一致性。

1.2 本文主要贡献

提出了一种用于半监督语义分割的交叉一致性训练(CCT)方法,其中预测的不变性在注入到编码器输出中的不同扰动上得到加强。

•作者建议并对各种类型的扰动进行详尽的研究。

•作者扩展了作者的方法,使用弱标记数据,并利用不同域的像素级标签来联合训练分割网络。

•作者通过广泛而详细的实验结果证明了作者方法的有效性,包括与最新技术的比较,以及通过详细的消融研究对作者方法的深入分析。

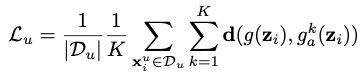

1.3 网络框架

整个网络大致分为上下两个分支,共包含一个encoder, 一个main decoder和 K 个辅助decoder。

有标签的(pixel-level labeled)数据由上分支处理,无标签的数据由上下两个分支共同处理。

对于有标签的数据,可以直接用交叉熵。

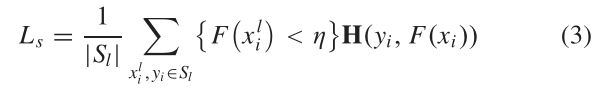

对于大量无标签的(unlabeled)数据,图片 xu 经过和上分支共享的encoder得到 z和main decoder,得到“参照”(main decoder的输出)。同时 z 分别经过K个扰动并进入对应的辅助decoder中,得到K个输出,这K个输出分别和main decoder的输出对比,并使用均方误差函数计算无监督损失 Lu。

Semi-Supervised Building Footprint Generation With Feature and Output Consistency Training

这篇文章的motivation以及一些观察非常nice~

2.1 introduction

最先进的基于一致性训练的方法利用了师生框架。具体而言,学生模型应用于未标记样本,而教师模型应用于同一样本的扰动版本。然后,在两个模型的输出之间施加一致性,以提高学生模型的性能。然而,当训练期间输出不完全正确时,这两种模型之间的性能仍存在一定差距。受特征图可以捕获更具歧视性的上下文信息的启发,作者通过提出一种新的一致性损失来进一步提高一致性训练的性能,该损失测量学生模型和教师模型的特征图和输出之间的差异。通过这样做,它可以提供一个强大的约束来规范网络的学习。

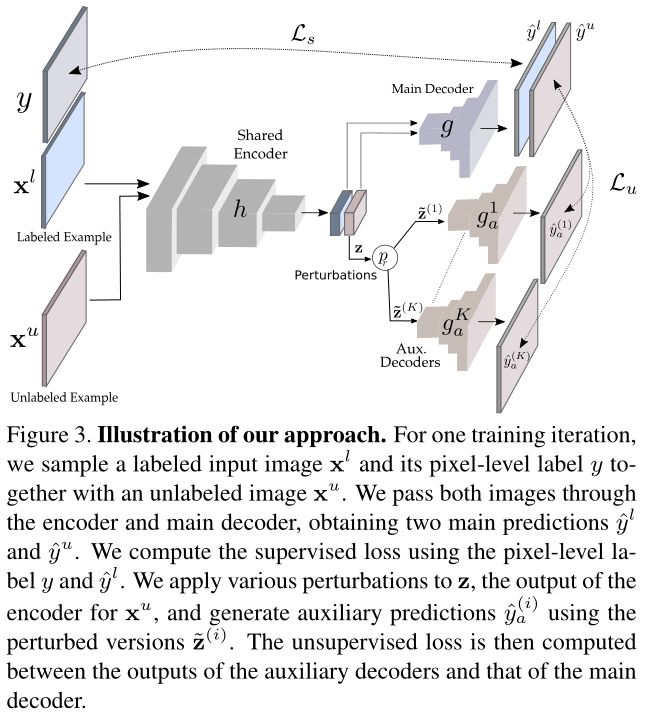

基于一致性训练的方法的有效性在很大程度上取决于数据分布的行为,即集群假设,其中类必须由低密度区域分隔。然而,分离类的低密度区域不在输入范围内,这解释了为什么半监督是语义分割的一个具有挑战性的问题,可以观察到,对于自然图像,在编码器的输出端存在分离类的低密度区域,因此建议在该位置分配扰动。然而,对于具有低空间分辨率的遥感图像,作者观察到分离类别的低密度区域的存在在编码器的中间特征表示中,而不是编码器的输入或输出中。(这个好棒!!从下图可以看出来,C作为编码器的输入,其实是不满足聚类假设的,d作为中间特征层可以看出满足聚类假设,e作为高级语义特征,也看不出满足聚类假设)受这一观察结果的启发,在这项工作中,作者建议在编码器内的某个深度对应用于特征表示的扰动进行一致性,其中该深度应与遥感图像的空间分辨率和研究区域内单个建筑物的平均尺寸一致。

这项工作有三方面的贡献。

1) 作者提出了一种用于建筑足迹生成的半监督网络,这在当前文献中尚未得到充分解决。当注释样本不足时,所提出的方法可以利用大量未标记的数据来提高模型的性能。

2) 作者提出的方法将特征和输出的一致性训练集成到统一的目标函数中,从而制定了一个有效的端到端训练框架。与其他竞争对手相比,作者的方法有了显著的改进。

3) 观察到分离类别的低密度区域位于编码器中的中间特征表示内,作者提出了一种指令,其中根据输入遥感图像的空间分辨率和研究区域中单个建筑物的平均大小,将扰动应用于编码器内某个深度处的特征表示。

2.2 网络架构

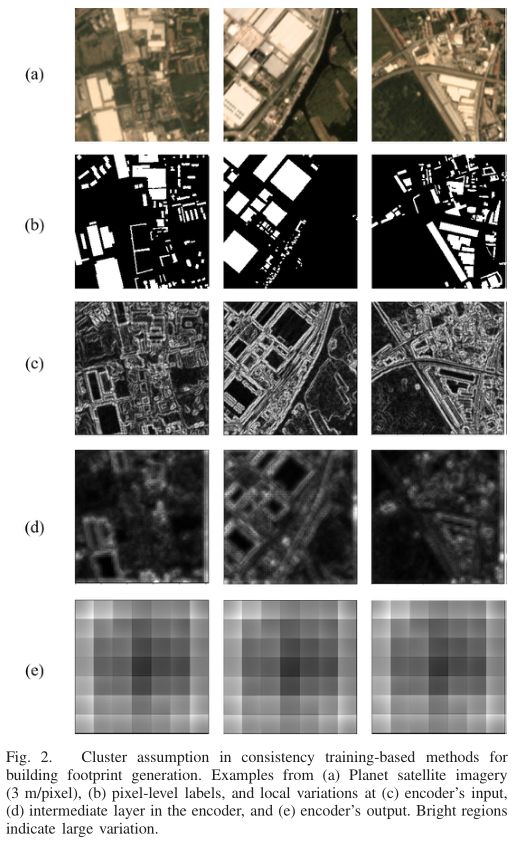

作者整体的网络架构还是很好理解的,首先是一个主分割网络,由encoder-decoder构成,对于有标签的数据,利用标签对其输出进行监督。这里用的是一个bootstrapped cross-entropy loss ,具体如下:

对于无标签影像,① 首先经过encoder生成![]() ,将

,将![]() 输入到主分割网络的decoder中,得到

输入到主分割网络的decoder中,得到![]() ,② 其次,如在introduction中提到的那样,对于遥感影像,其聚类假设体现在中间特征图中,因此,此处对中间特征图添加扰动得到

,② 其次,如在introduction中提到的那样,对于遥感影像,其聚类假设体现在中间特征图中,因此,此处对中间特征图添加扰动得到![]() (一般最多的是对输入扰动或者encoder的输出扰动,这里是对中间特征图扰动),将

(一般最多的是对输入扰动或者encoder的输出扰动,这里是对中间特征图扰动),将![]() 输入到encoder后续的网络中,最后得到encoder的输出

输入到encoder后续的网络中,最后得到encoder的输出![]() ,将这个

,将这个![]() 输入到辅助decoder中,得到预测结果

输入到辅助decoder中,得到预测结果![]() .

.

关于无标签的影像的损失设置分为两个部分,![]() 和

和![]() ,其中

,其中

3. Semi-supervised semantic segmentation needs strong, varied perturbations

这篇文章核心看了3.1小节,揭示了基于一致性的半监督方法应用于语义分割为什么效果不如在其他领域那么好。从前两篇论文可以看出来,其实数据扰动还是有很大讲究的,这篇文章解释了一下。

3.1 Why semi-supervised semantic segmentation is challenging

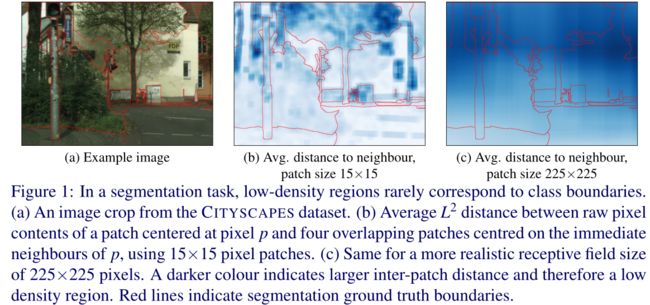

将语义分割视为滑动窗口patch分类,其目标是识别patch中心像素的类别。鉴于之前的工作将扰动应用到原始像素(输入)空间,作者对数据分布的分析集中在图像patch的原始像素内容上,而不是来自网络内部的更高级别的特征。

作者将一致性正则化在自然图像语义分割问题中的罕见成功归因于输入数据中的低密度区域与类边界没有很好地对齐。这种低密度区域的存在将表现为局部大于位于类边界两侧的相邻像素点中心的patch之间的平均L2距离(关于这句话的理解:定义中心像素为A,理论上来说,根据平滑假设,在A周围的这些点应该跟A属于同一类别,他们之间的L2距离应该是要小的,所谓决策边界,是分割两个类别的区域,理论上来说,对于决策边界两边的点,他们的L2距离应该是更大的,但是作者发现真实分割中好像不是这样的,这是我理解的所谓的局部大于类边界两侧的距离,不知道对不对)。在图1中,我们可视化了相邻补丁之间的L2距离。当使用如图1 (c)所示的合理接受域时,我们可以看到聚类假设明显违反:一个像素的感受野的原始像素内容与邻近像素的感受野的内容有多大不同,与斑块的中心像素是否属于同一类几乎没有相关性(关于这句话,我的通俗理解:下图(c)是一个特征图,将特征图上的一个点A映射回原图,对应的有一个感受野R1,令一个点B映射回原图,对应的有一个感受野R2,A和B是否属于同一类别和他们的感受野内容有多大不同几乎没有什么关系,比如R1和R2可能很不相同,但A和B却是同一类,如果理解不对欢迎指出,读这两句话的时候反复读了好几遍)。

从信号处理的角度来看,patchwise距离缺乏变化是很容易解释的。对于大小为H×W的patch ,以所有水平相邻像素对为中心的重叠patch的像素内容之间L2距离的距离图为![]() ,其中*表示卷积,

,其中*表示卷积,![]() 是输入图像I的水平梯度。因此,元素平方梯度图像通过H ×W框滤波器进行低通滤波,该滤波器抑制了图像高频成分中的精细细节,从而平滑地改变整个图像的样本密度。

是输入图像I的水平梯度。因此,元素平方梯度图像通过H ×W框滤波器进行低通滤波,该滤波器抑制了图像高频成分中的精细细节,从而平滑地改变整个图像的样本密度。

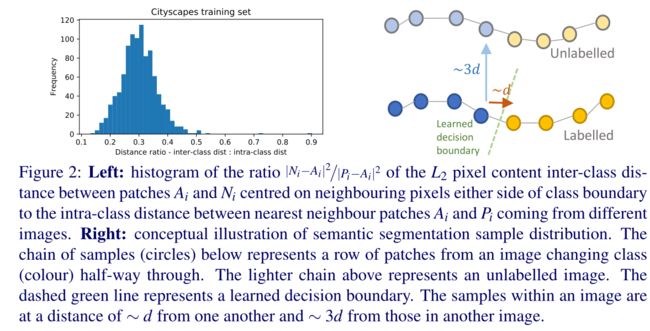

作者对CITYSCAPES数据集的分析量化了在两个应该属于不同类别的相邻像素之间设置决策边界所涉及的挑战,同时推广到其他图像。发现,以类别边界两侧像素为中心的patch之间的L2距离约为在不同图像中发现的同一类别的最近补丁距离的1/3(见图2)。这表明决策边界的精确定位和方向对于良好的性能至关重要。(这个的意思是,对于不同类别(也就是决策边界两侧的像素)之间的距离是同类别距离的1/3)

3.2 补充说明

3.2.1 推导信号处理的解释

为了分析图像上斑块分布的平滑性,我们需要计算以相邻像素为中心的斑块之间的L2像素内容距离。让我们从两个补丁A和B开始,图4(a,b)是从图像I中提取的(Fig1(a),方便观看,我把fig1(a)重新截图过来,注意,A和B都是一个patch,a和b是他们的中心点,这两个点在原图上相邻),以水平相邻像素为中心,A在B的左边一个像素。L2距离为|B−A|。L2距离的平方是B - A的元素平方之和;假设B−A中的每个像素都是水平相邻像素之间的差值,因此B−A是从水平梯度图像![]() 中提取的patch(见图4(c))。距离的平方是B - A的元素平方之和;它是从

中提取的patch(见图4(c))。距离的平方是B - A的元素平方之和;它是从![]() 中提取的patch中元素的和。在

中提取的patch中元素的和。在![]() 上以滑动窗口方式计算大小为H×W的所有patch的和相当于将其与

上以滑动窗口方式计算大小为H×W的所有patch的和相当于将其与![]() 的核进行卷积,因此所有水平相邻补丁之间的距离可以使用

的核进行卷积,因此所有水平相邻补丁之间的距离可以使用![]() 计算。A box filte——或与之密切相关的均匀滤波器是一种低通滤波器,它将抑制高频细节,从而产生平滑输出。

计算。A box filte——或与之密切相关的均匀滤波器是一种低通滤波器,它将抑制高频细节,从而产生平滑输出。

Fig1

3.2.2 Cityspace中patch to patch的距离分析

我们对CITYSCAPES的分析表明,语义分割问题表现出较高的类内差异和较低的类间差异。我们选择了1000个图像patch三元组,每个三元组由一个锚点patch ![]() 和正样本

和正样本![]() 和负样本

和负样本![]() patch组成,分别和

patch组成,分别和![]() 具有相同真值(同一类)和不同的真值(不同类别)。我们使用类内距离

具有相同真值(同一类)和不同的真值(不同类别)。我们使用类内距离![]() 和类间距离

和类间距离![]() 作为方差的代理。考虑到分割模型必须在图像中不同类别的相邻像素之间放置决策边界,我们选择

作为方差的代理。考虑到分割模型必须在图像中不同类别的相邻像素之间放置决策边界,我们选择![]() 和

和![]() 作为类别边界两侧的直接邻居。由于模型还必须从有标签的图像推广到无标签的图像,我们搜索了除包含

作为类别边界两侧的直接邻居。由于模型还必须从有标签的图像推广到无标签的图像,我们搜索了除包含![]() 的

的![]() 属于最小化

属于最小化![]() 的同一类的所有图像。最小化距离选择模型必须泛化的类内距离的最佳情况。图2(在上面)左侧的类间与类内距离比值直方图是右图的基础,其中蓝色类内距离约为黄色类间距离的3倍。该模型必须学会在以相邻像素为中心的斑块之间放置决策边界,同时充分准确地定位它,使其与其他图像相交于正确的点。

的同一类的所有图像。最小化距离选择模型必须泛化的类内距离的最佳情况。图2(在上面)左侧的类间与类内距离比值直方图是右图的基础,其中蓝色类内距离约为黄色类间距离的3倍。该模型必须学会在以相邻像素为中心的斑块之间放置决策边界,同时充分准确地定位它,使其与其他图像相交于正确的点。

4. Semi-Supervised Semantic Segmentation Using Unreliable Pseudo-Labels

看了一个篇的比较好的,一起学习:参考

4.1 Self-training: 样本筛选导致训练不充分

半监督学习的核心问题在于有效利用无标注样本,作为有标签样本的补充,以提升模型性能。

经典的 self-training 方法大多遵循着 supervised learning → pseudo labeling → re-training 的基本流程,但学生网络会从不正确的伪标签中学习到错误的信息,因而存在 performance degradation 的问题。

常规作法是通过样本筛选的方式只留下高置信度预测结果,但这会将大量的无标签数据排除在训练过程外,导致模型训练不充分。此外,如果模型不能较好地预测某些 hard class,那么就很难为该类别的无标签像素分配准确的伪标签,从而 hard class 的结果无法获得提升,形成「马太效应」。

我们认为「 Every Pixel Matters」,即使是低质量伪标签也应当被合理利用,过往的方法并没有充分挖掘它们的价值。

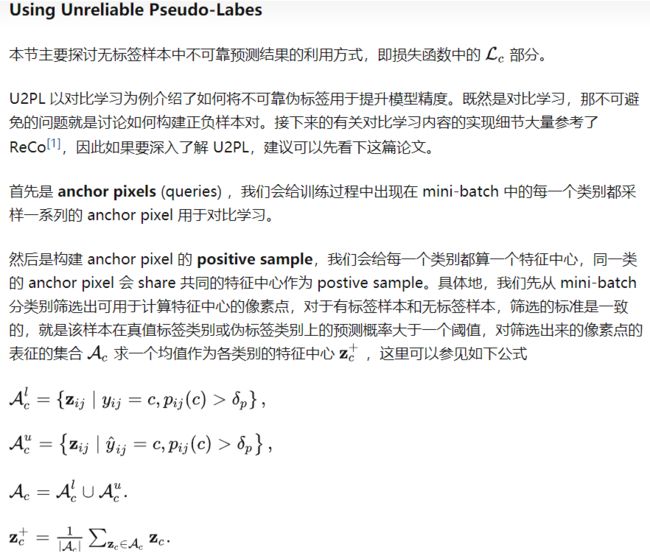

4.2 Motivation: Every Pixel Matters

具体来说,预测结果的可靠与否,我们可以通过熵 (per-pixel entropy) 来衡量,低熵表示预测结果可靠,高熵表示预测结果不可靠。我们通过 Figure 2 来观察一个具体的例子,Figure 2(a) 是一张蒙有 entropy map 的无标签图片,高熵的不可靠像素很难被打上一个确定的伪标签,因此不参与到 re-training 过程,在 FIgure 2(b) 中我们以白色表示。

我们分别选择了一个可靠的和不可靠的预测结果,在 Figure 2(c) 和 Figure 2(d) 中将它们的 category-wise probability 以柱状图的形式画出。黄色十字叉所表示的像素在 person 类上的预测概率接近于 1,对于这个预测结果模型非常确信,低熵的该像素点是典型的 reliable prediction。而白色十字叉所表示的像素点在 motorbike 和 person 两个类别上都具有不低的预测概率且在数值上较为接近,模型无法给出一个确定的预测结果,符合我们定义的 unralibale prediction。对于白色十字叉所表示的像素点,虽然模型并不确信它具体属于哪一个类别,但模型在 car 和 train 这两个类别上表现出极低的预测概率,显然很确信不属于这些类别。

因而,我们想到即使是不可靠的预测结果,虽然无法打上确定的伪标签,但仍可以作为部分类别的负样本,从而参与到模型的训练,从而让所有的无标签样本都能在训练过程中发挥作用。

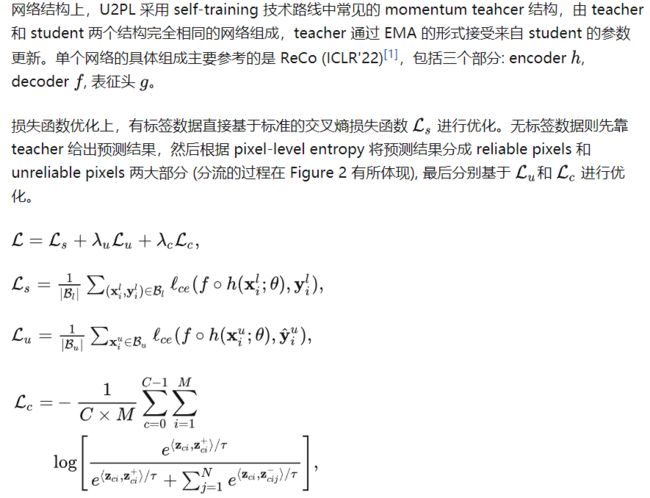

4.3 方法

如上三个部分构成了 U2PL 全部的损失函数,熟悉 self-training 的话就只需要关注对比学习 Lc部分,是经典的 InfoNCE Loss[2],细节会在后续具体讨论。

最后是构建 anchor pixel 的 negative sampe,同样的也需要分成有标签样本和无标签样本两个部分去讨论。对于有标签样本,我们明确知道其所属的类别,因此除真值标签外的所有类别都可以作为该像素的负样本类别;而对于无标签样本,由于伪标签可能存在错误,因此我们并不完全却行确信标签的正确性,因而我们需要将预测概率最高的几个类别过滤掉,将该像素认作为剩下几个类别的负样本。这部分对应的是论文中公式 13-16,但说实话这一段内容用公式去描述还是比较晦涩的

由于数据集中存在长尾问题,如果只使用一个 batch 的样本作为对比学习的负样本可能会非常受限,因此我们采用 MemoryBank 来维护一个类别相关的负样本库,存入的是由 teacher 生成的断梯度特征,以先进先出的队列结构维护。

5. Perturbed and Strict Mean Teachers for Semi-supervised Semantic Segmentation

5.1 Introduction(motivation)

目前最先进的(SOTA)半监督语义分割模型是基于一致性学习的,它强制未标记图像的不同视图的输出之间的一致性[9,14,34,44]。这些不同的视图可以通过对输入图像进行数据增强[44]或对特征空间进行噪声注入[34]来获得。获得不同视图的另一种方法是使用网络扰动,它鼓励从不同初始化训练的多个模型之间进行相似的预测,并且已被证明比输入图像和特征扰动能够实现更好的一致性正则化[9,21]。一致性学习的一个潜在弱点是,它假设对未标记的图像进行准确的预测,这样扰动就不会将图像特征推到真实(隐藏)分类决策边界的错误一侧。不幸的是,在实践中,SOTA方法并不总是满足这个假设,使得一致性学习方法的训练信号可能是不正确的。对于基于网络扰动的一致性学习,这个问题会加剧,因为来自一个模型的不正确预测会恶化对另一个模型的训练,反之亦然。这些不准确预测的另一个后果是,依赖于“严格”交叉熵(CE)损失的一致性学习方法很容易过度拟合预测错误,从而导致确认偏差。

本文的主要贡献:

新的基于一致性的半监督语义分割MT模型,旨在提高无标记训练图像的分割精度,使用新的辅助教师,用更严格的置信加权CE损失(ConfCE)取代MT的MSE损失,允许更强的收敛性和整体更好的训练精度;

一个新的具有挑战性的输入数据,特征和网络扰动的组合,以改善模型泛化;

一种新型的特征扰动,称为T-VAT,基于从MT模型的两位老师那里学习到的对抗噪声,并应用于学生模型,这导致了具有挑战性的噪声的产生,以促进学生模型的有效训练。

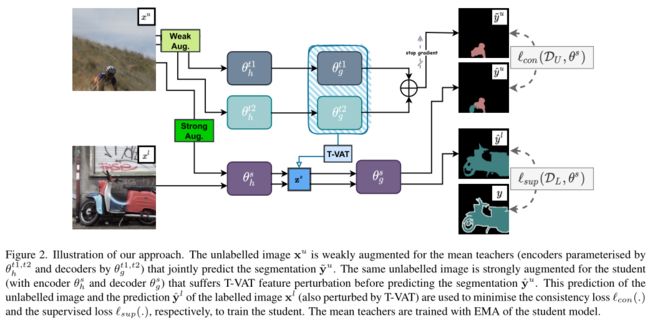

5.2 Network

解释:可以看出,网络整体有两个老师模型和一个学生模型,网络的主要思想是,有标签的图像在学生模型进行训练,利用其标签对其进行监督,无标签数据,对其进行弱增强(旋转缩放等)和强增强(颜色抖动、随机灰度),将弱增强的图像输入两个教师模型。强增强的图像输入到学生模型,学生模型有反向传播,每次参数自动更新,老师模型的参数是通过学生模型更新的,更新方法是EMA方法,因为有两个老师模型,一样的更新就没有意义了,因此每一次只对其中一个模型进行更新,这次更新第一个下次更新第二个。

5.3 多重扰动训练和严格置信加权CE损失

本节接下来介绍使用置信加权CE损失的新MT模型的训练过程,该模型通过对网络、特征表示和输入图像的扰动进行优化。

5.3.1 Training

学生模型的全部训练损失为

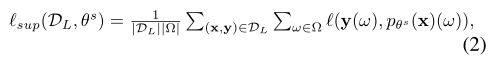

其中第一个损失是监督分割损失,定义为

上面公式看着唬人,其实本质上就是一个交叉熵损失,逐像素计算损失,所有加起来之后再求个平均。其中Ω为大小为H ×W的图像格,ℓ(.)表示在像素地址![]() 处标签y与来自分割预测pθs(x)之间的CE损失。

处标签y与来自分割预测pθs(x)之间的CE损失。

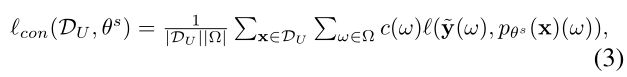

(1)中的第二项是一致性损失,用置信度加权CE损失(Conf-CE)表示,β∈R加权其贡献,定义如下:

5.3.2 网络扰动

网络扰动由平均教师模型和学生模型的预测得到。平均教师集合生成的软分割图估计为(上面网络图中两个教师模型的融合也就是那个加号代表的):

其中σ(.)表示softmax函数。公式(3)中的![]() 是通过将

是通过将![]() 进行计算one-hot得到的,(我的通俗理解就是

进行计算one-hot得到的,(我的通俗理解就是![]() 其实就是预测概率,属于[0,1],而

其实就是预测概率,属于[0,1],而![]() 就是非0就是1,将分类结果弄成one-hot图)。最重要的是公式(3)中的

就是非0就是1,将分类结果弄成one-hot图)。最重要的是公式(3)中的![]() 才是所谓的置信度,它是这样计算的:

才是所谓的置信度,它是这样计算的:

其中I(.)表示指示函数,τ是使c(ω)的值大于零的最小置信度。

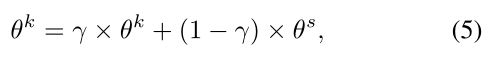

遵循MT框架,学生模型通过随机梯度下降(SGD)训练以最小化(3)中的成本函数,而教师模型则使用学生模型的指数移动平均(EMA)和批量范数(BN)参数进行训练,其中:

其中k∈{t1, t2}, γ∈(0,1)控制各epoch之间的传递权值。对于教师模型的训练,我们在每个训练阶段只更新两个教师中的一个的参数。

5.3.3 特征图扰动(重点)

特征扰动由挑战性的对抗性特征扰动组成,其设计目的是通过将从模型编码器计算的图像特征推向特征空间中的分类边界,从而违反聚类或低密度假设(关于特征扰动是为了违反两个基本假设,查到了一个比较靠谱的说法:特征扰动的一个目标是违反低密度分离假设和聚类假设。这两个假设是半监督学习中的基本假设,它们描述了数据的分布情况和类别之间的关系。低密度分离假设(Low-Density Separation Hypothesis)认为,具有相似特征的样本往往属于相同的类别。也就是说,样本在特征空间中被类别之间的低密度区域分隔开。然而,在实际应用中,这个假设并不总是成立,因为数据可能存在噪声、重叠或者不完全标记的情况。特征扰动通过修改未标记数据的特征,破坏原始数据的低密度分离性,使得模型能够更好地学习到这种不完全分离的数据分布。聚类假设(Cluster Assumption)认为,具有相似特征的样本往往属于相同的类别,并且类别之间存在较大的距离。这个假设认为样本在特征空间中形成了紧密的聚类结构。然而,在半监督学习中,未标记数据可能位于不同的聚类之间,这会给模型带来挑战。通过特征扰动,可以破坏原始数据的聚类结构,使得模型在学习时不再过分依赖于这种聚类假设,从而提高模型的泛化能力和鲁棒性。因此,特征扰动可以帮助模型适应不完全分离和聚类之间存在重叠的数据分布,违反低密度分离假设和聚类假设,提高模型对未标记数据的分类性能。这种方法能够更好地利用未标记数据,增加训练样本的多样性,提高模型的鲁棒性和泛化能力)。

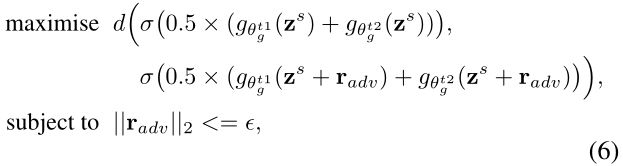

产生这种对抗性特征噪声的一种有效方法是使用虚拟对抗性训练(VAT),它优化扰动向量,以最大化正确分类和对抗性分类之间的分歧。目前的方法估计对抗噪声使用相同的单一网络,其中一致性损失将应用。然而,就我们所知,使用VAT来干扰半监督语义分割中的MT训练是新的。在MT模型中,特征扰动可以应用于学生模型,但考虑到它的预测精度低于教师模型,这种方法可能不利于有效的训练。因此,我们建议使用更准确的教师估计对抗噪声,然后将估计的噪声应用于学生模型的特征-我们称之为扰动T-VAT。在公式(3)的损失中使用的学生输出为:

其中,对抗特征摄动![]() 由教师模型集合的响应估计,具有:

由教师模型集合的响应估计,具有:

其中![]() , d(.)是原始像素预测和摄动像素预测之间的像素级Kullback-Leibler (KL)散度之和。

, d(.)是原始像素预测和摄动像素预测之间的像素级Kullback-Leibler (KL)散度之和。

5.3.4 输入图像的扰动

输入图像扰动基于弱增强对[24],其中对教师模型处理的图像进行弱增强(图像翻转、裁剪和缩放),除弱增强外,对输入学生模型的图像进行强增强[9,21](如颜色抖动、随机灰度和模糊),以提高整体泛化能力。(后面还有一些更具体的,自己看论文吧)