- K8S 常用命令全解析:高效管理容器化集群

恩爸编程

dockerkubernetes容器k8s常用命令k8s有哪些常用命令k8s命令有哪些K8S常用命令有哪些

K8S常用命令全解析:高效管理容器化集群一、引言Kubernetes(K8S)作为强大的容器编排平台,其丰富的命令行工具(kubectl)为用户提供了便捷的方式来管理集群中的各种资源。熟练掌握K8S常用命令对于开发人员和运维人员至关重要,能够有效提高容器化应用的部署、监控与维护效率。本文将详细介绍一些K8S常用命令及其使用案例。二、基础资源操作命令(一)kubectlcreate功能:用于创建K8

- Serverless架构下Spring Function的创新实践

tmjpz04412

serverless架构spring

引言:Serverless与Spring生态的交汇背景介绍:云计算与Serverless架构的兴起Spring生态的演进与云原生适配性核心问题:传统Spring应用如何融入Serverless范式Serverless架构的核心特征与挑战事件驱动、弹性伸缩与按需计费冷启动问题与性能优化需求Spring应用在Serverless环境中的典型瓶颈(如依赖注入、上下文初始化)SpringFunction的

- Spring Boot与云原生:微服务架构的创新实践

tmjpz04412

springkubernetes云原生javagraphql

引言:Spring生态的演进与现状Spring框架的发展历程与核心设计理念当前Spring生态的核心组件(SpringBoot、SpringCloud、SpringData等)行业对Spring生态的依赖与创新需求SpringBoot的创新实践1.自动化配置与启动优化条件装配(@Conditional)的深度定制案例启动类加载机制与类路径扫描优化示例:通过自定义Starter实现快速集成第三方服务

- 深入了解 Kubernetes(k8s):从概念到实践

目录一、k8s核心概念二、k8s的优势三、k8s架构组件控制平面组件节点组件四、k8s+docker运行前后端分离项目的例子1.准备前端项目2.准备后端项目3.创建k8s部署配置文件4.部署应用到k8s集群在当今云计算和容器化技术飞速发展的时代,Kubernetes(简称k8s)已成为容器编排领域的事实标准。无论是互联网巨头、传统企业还是初创公司,都在广泛采用k8s来管理和部署容器化应用。本文将带

- Coze Studio 架构拆解:AI Agent 开发平台项目结构全分析

代码简单说

2025开发必备(限时特惠)架构人工智能CozeStudio架构AIAgent开发平台全栈AI工程化图解架构

CozeStudio架构拆解:AIAgent开发平台项目结构全分析标签:CozeStudio项目架构、领域驱动设计DDD、全栈开发规范、Hertz框架、前后端协作、云原生容器、前端测试、IDL接口设计、微服务解耦、AI开发平台源码分析在最近研究AIAgent开发平台的过程中,我深入分析了刚刚开源的CozeStudio项目。这套系统是国内少有的开源全栈AI工程化项目,代码整洁、架构先进,特别是它基于

- Consul 与 Hive:云原生数据仓库集成

AI云原生与云计算技术学院

AI云原生与云计算数据仓库consulhiveai

Consul与Hive:云原生数据仓库集成关键词:Consul、Hive、云原生、数据仓库集成、服务发现摘要:本文深入探讨了Consul与Hive在云原生环境下的数据仓库集成。首先介绍了集成的背景和相关概念,包括Consul的服务发现机制和Hive作为数据仓库的特点。接着详细阐述了核心概念及联系,通过文本示意图和Mermaid流程图展示其架构。对集成所涉及的核心算法原理进行了讲解,并给出Pytho

- Coze开源实战指南:构建企业级AI应用的全链路技术解析(含Kubernetes+服务网格深度实践)

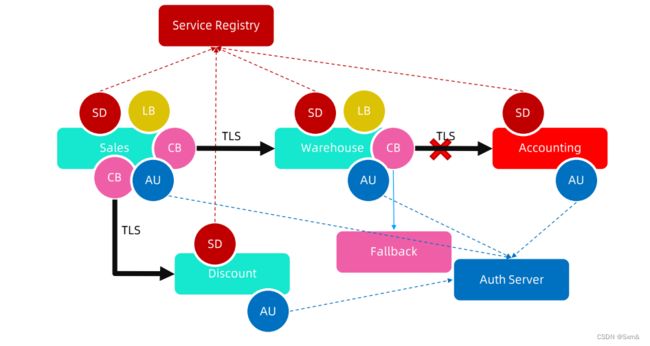

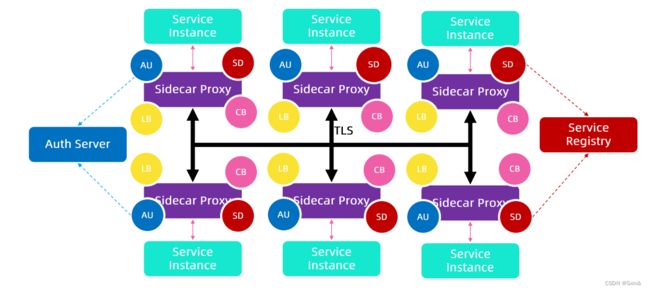

一、Coze技术架构深度解析1.1核心组件与五层异构架构Coze采用五层异构架构(感知层→执行层→决策层→监控层→进化层),实现亚毫秒级实时响应与动态弹性扩展。其核心模块包括:架构亮点支持横向扩展的微服务集群基于Kubernetes的自动扩缩容机制服务网格(Istio)实现流量治理核心组件对比表组件功能特性典型性能指标CozeStudio30+节点类型/多模式编排响应速度提升300%CozeLoo

- Azure-in-bullet-points项目解析:深入理解Azure Service Fabric架构与技术实践

萧桔格Wilbur

Azure-in-bullet-points项目解析:深入理解AzureServiceFabric架构与技术实践一、AzureServiceFabric概述AzureServiceFabric是微软提供的分布式系统平台,专为构建和管理可扩展、可靠的微服务而设计。作为云原生应用开发的核心技术,它解决了现代分布式系统开发中的诸多挑战。核心特性集群管理能力:基于共享机器池(集群)构建,实现资源的高效利用

- kubeadm部署安装K8S集群及核心概念-02

Kubernetes组件介绍KubernetesCluster由Master和Node组成,节点上运行着若干Kubernetes服务。Master节点Master是KubernetesCluster的大脑,运行着如下Daemon服务:kube-apiserver、kube-scheduler、kube-controller-manager、etcd和Pod网络(例如flannel)。APIServ

- Kubeadm 快速搭建 k8s 集群&&安装可视化管理界面

头发莫的了呀

Kuberneteskubernetesdocker运维

文章目录1.实验准备2.安装docker3.配置阿里云K8Srepo源(三个节点)4.安装kubeadm,kubelet,kubectl(三个节点)5.部署kubernetesMaster节点(master节点上执行)6.k8s-node节点加入master节点(两个node执行)7.安装Pod网络插件(CNI插件,master节点)8.master节点安装可视化管理界面dashboard1.实验

- 初始化 K8s 主节点时 报错failed to pull image registry.aliyuncs.com/google_containers/kube-apiserver:v1.23.17

Ashmcracker

kubernetes容器云原生

运行r如下命令初始化kubernetes的master节点2025年3月12日更新:阿里云的镜像仓库目前只给它自己云上的服务器使用了,建议更换华为云的镜像加速器https://support.huaweicloud.com/usermanual-swr/swr_01_0045.htmlkubeadminit\--kubernetes-version=v1.23.17\--image-reposit

- 零信任架构落地:Java + SPIFFE 微服务身份联邦体系

司铭鸿

架构java微服务机器学习线性代数开发语言算法

“信任是最昂贵的漏洞。”——2017年Equifax数据泄露后安全专家总结开篇:当城堡护城河干涸时2019年,某跨国金融集团遭遇“服务间信任链断裂”攻击。攻击者利用Kubernetes服务账户令牌泄露,伪装成合法服务横向渗透,窃取核心交易数据。其传统边界防火墙与VPN如同中世纪的护城河,对内部流量毫无防御能力。这场灾难性事件点燃了他们落地零信任架构(ZeroTrustArchitecture,ZT

- 在阿里云服务器上搭建单节点Kubernetes集群的完整指南与故障排除

老牛十八岁SYZ

Kubernetes阿里云服务器kubernetes

在阿里云服务器上搭建单节点Kubernetes集群的完整指南与故障排除在云计算和容器化技术日益普及的今天,Kubernetes(简称K8s)已成为容器编排的事实标准。本文将以阿里云服务器(AlibabaCloudLinux)为例,详细介绍如何搭建单节点Kubernetes集群,并针对实际操作中可能遇到的典型问题提供系统性解决方案。【阿里云限时特惠】云产品低至38元/年起!各位技术伙伴,阿里云爆款钜

- 2024年12月20日 Go生态洞察:Go开发者调查2024 H2结果深度解析

猫头虎

#Go生态洞察golang开发语言后端gogo1.19beegoAI编程

2024年12月20日Go生态洞察:Go开发者调查2024H2结果深度解析摘要我是猫头虎,本篇文章将深入剖析Go团队于2024年9月9日至23日期间开展的GoDeveloperSurvey2024H2调查结果,从满意度、开发环境、云部署、AI辅助、团队挑战、SIMD支持等多维度展开,带你全面了解当前Go生态的热点趋势与痛点。关键词:Go生态、开发者满意度、AI辅助、云原生、性能优化引言背景与意义G

- 【tower】Rust tower库原理详解以及axum限流实战

景天科技苑

Rust语言通关之路rust开发语言后端towerrusttoweraxum限流

✨✨欢迎大家来到景天科技苑✨✨养成好习惯,先赞后看哦~作者简介:景天科技苑《头衔》:大厂架构师,华为云开发者社区专家博主,阿里云开发者社区专家博主,CSDN全栈领域优质创作者,掘金优秀博主,51CTO博客专家等。《博客》:Rust开发,Python全栈,Golang开发,云原生开发,PyQt5和Tkinter桌面开发,小程序开发,人工智能,js逆向,App逆向,网络系统安全,数据分析,Django

- k8s 的基本原理、架构图、使用步骤和注意事项

Kubernetes(k8s)是一个开源的容器编排平台,用于自动化部署、扩展和管理容器化应用。以下是其基本原理、使用步骤和注意事项的总结:一、k8s基本原理核心架构Master节点:控制集群的核心组件,包括:APIServer:所有操作的入口,提供RESTfulAPI。Scheduler:将Pod分配到合适的Node。ControllerManager:维护集群状态(如副本数、故障检测)。etcd

- 1、kubernetes 1.5.2原理以及集群HA部署

yongbang_yan

运维容器

Kubernetes是什么?1.是一个全新的基于容器技术的分布式架构,是谷歌的Borg技术的一个开源版本Borg是谷歌的一个久负盛名的内部使用的大规模集群管理系统,基于容器技术,目的是实现资源管理的自动化,垮多个数据中心的资源利用率的最大化2.Kubernetes是一个开放的平台。不局限于任何一种语言,没有限定任何编程接口。3.Kubernetes是一个完备的分布式系统支持平台。Kubernete

- 28、深入了解Kubernetes对象与EKS集群部署

week9

AWS微服务实战:从理论到实践KubernetesEKSIngress

深入了解Kubernetes对象与EKS集群部署1.Kubernetes对象概述Kubernetes中有多种重要对象,它们在集群的运行和管理中发挥着关键作用。-Ingress:Ingress是一个KubernetesAPI对象,用于管理集群中服务的外部HTTP/HTTPS流量。它通过Ingress配置中定义的规则,将集群外部的流量路由暴露给服务。Deployment用于创建Pod,ReplicaS

- 2、Kubernetes:架构、优势与部署方案解析

coffee

Kubernetes架构优势

Kubernetes:架构、优势与部署方案解析1.Kubernetes基础概念工作负载平面(WorkloadPlane)有时也被称为数据平面(DataPlane),但这种说法容易让人混淆,因为该平面承载的是应用程序而非数据。这里的“平面”可以理解为应用程序运行的“表面”。非生产集群可以使用单个主节点,而高可用集群则至少需要三个物理主节点来承载控制平面(ControlPlane)。工作节点的数量取决

- K8s 集群成本优化实战:基于 Spot 实例与模型量化的

女码农的重启

java开发语言pythonJAVA人工智能kubernetes

在Kubernetes集群运维中,成本控制与服务稳定性往往存在博弈——根据CNCF2024年报告,超过67%的企业K8s集群资源利用率低于50%,年浪费成本平均达12万美元。对于中小团队而言,通过技术手段降低运行成本更是生存刚需。本文聚焦两类核心优化手段:Spot实例的弹性调度与模型量化的资源压缩,结合生产环境实测数据,提供可落地的K8s成本优化方案,包含完整的配置模板与量化指标对比。一、Spot

- Kubernetes 核心组件解析

算法小生Đ

精选实践kubernetes容器云原生

Kubernetes(K8S)的组件组成可以分为控制平面组件(ControlPlaneComponents)和节点组件(NodeComponents),以及一些附加组件。以下是详细的组成说明:1.控制平面组件(ControlPlaneComponents)控制平面负责管理集群的状态,通常运行在主节点(MasterNode)上,包含以下核心组件:APIServer(kube-apiserver)集群

- 阿里云MaxCompute SQL与Apache Hive区别面面观

大模型大数据攻城狮

阿里云odpssql物化maxcomputeudf开发sql语法

目录1.引爆开场:MaxCompute和Hive,谁才是大数据SQL的王者?2.架构大比拼:从Hadoop到Serverless的进化之路Hive的架构:老派但经典MaxCompute的架构:云原生新贵3.SQL语法的微妙差异:90%相似,10%决定胜负建表语句分区与分桶函数与UDF4.执行引擎的较量:MapReducevs飞天引擎Hive的MapReduce执行流程MaxCompute的飞天引擎

- .NET 9 技术革新,新特性概览

小码编匠

C#.NET.netc#开发语言新语法

目录简介正文新特性1、序列化2、LINQ3、加密总结.NET9下载地址最后简介.NET9作为微软推出的最新框架版本,无疑为开发者带来了一系列的新特性,继.NET8之后.NET9在云原生应用程序得到了增强和性能得到提升。它是STS版本,将获得为期18个月的标准支持服务。这些新特性究竟有多新颖?它们将如何影响我们的开发实践?本文将探讨.NET9的几个关键新特性,可以到官网下载.NET9。正文.NET9

- PHP 8.0 云原生与前沿技术深度整合(1)

jishujiaoliu1682

php开发语言

PHP8.0云原生与前沿技术深度整合目录云原生PHP架构ServerlessPHP实践AI/ML集成方案区块链与PHP物联网(IoT)开发边缘计算部署未来技术展望云原生PHP架构KubernetesOperator设计phpclassPhpAppOperator{private$k8sClient;publicfunction__construct(K8sClient$client){$this-

- python笔记

1.基础阶段1.1课程定位(1)从行业角度来说:开发、网安、云原生、都会用到编程相关的技术(2)从校招角度来说:所有IT岗位都会对学生编程能力进行考查(3)Python相对而言比较简单,容易入手,比较好学1.2学习方法(1)逢山开路,遇水架桥:学习编程的核心并不是仅局限于语法,而是在于如何利用语法去解决实际的计算机问题(2)观千剑而识器,操千曲而晓声:学习编程没有捷径,只有不停地多敲,多练,多解决

- 【学习路线】C#企业级开发之路:从基础语法到云原生应用

一、C#基础入门(1-2个月)(一)开发环境搭建VisualStudio安装配置VisualStudioCommunity:免费版本,功能完整VisualStudioCode:轻量级,跨平台支持JetBrainsRider:专业IDE,强大功能.NETSDK:运行时和开发工具包NuGet包管理器:第三方库管理.NET生态系统了解.NETFramework:Windows平台传统框架.NETCore

- istio-proxy用哪个端口代理http流量的?

小诸葛的博客

istiohttp云原生

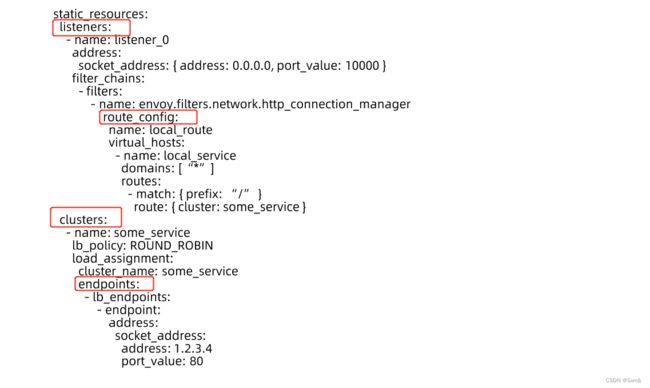

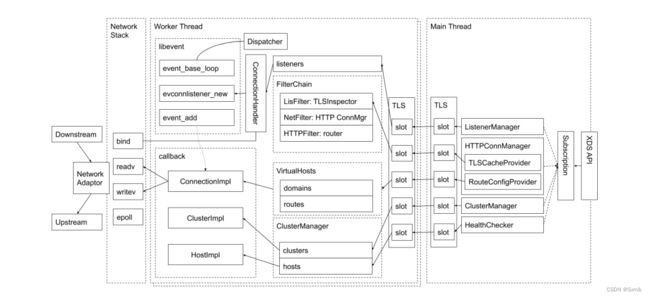

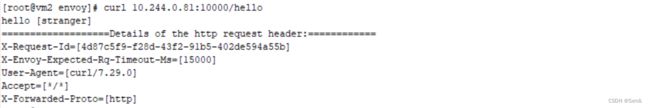

在Istio中,istio-proxy(基于Envoy)代理HTTP流量的端口取决于具体配置和服务类型。以下是以Markdown格式整理的详细说明,涵盖istio-proxy如何处理HTTP流量以及相关端口信息:istio-proxy代理HTTP流量的端口1.默认端口istio-proxy使用iptables规则或直接配置来拦截和代理应用的流量。HTTP流量的代理端口通常包括以下几种情况:出站流量

- 关于cgroup 学习

序冢--磊

cc++学习linux运维

一、前言cgroup在K8S中有重要应用,K8S参考书籍:kubernetes权威指南第5版公司一个项目用linux的cgroup技术来限制进场cpu和内存使用,具有非常好的学习意义,所以业余写下笔记,来记录一下cgroup的使用cgroup可以绑定一组进程集合,他的内核接口暴露是通过linux伪文件系统来实现的,我们可以通过linux上一些特定的文件来限制进场cpu和内存的使用二、cgroup学

- Linux 内核中 cgroup(控制组) 作用是什么?

cgroup(ControlGroups)是Linux内核提供的一种机制,用于对进程(或线程)组进行资源限制、优先级分配、统计监控和任务控制。通过将进程分组管理,可以实现对CPU、内存、磁盘I/O、网络等系统资源的精细化分配和隔离。它是现代容器技术(如Docker、Kubernetes)的底层核心组件之一。1.cgroup的核心目标资源限制:限制进程组使用的资源量(如CPU最大使用率、内存上限)。

- 498. 【kubernetes】好用的 kubectl 命令

七镜

将Pod的端口号映射到宿主机(通常用于测试)命令格式:kubectlport-forwardPOD[LOCAL_PORT:]REMOTE_PORT[...[LOCAL_PORT_N:]REMOTE_PORT_N][flags]将Pod的80端口映射到宿主机的8888端口,客户端即可通过http://:8888访问容器服务:[root@k8s0workspace_test]#kubectlport-

- java线程的无限循环和退出

3213213333332132

java

最近想写一个游戏,然后碰到有关线程的问题,网上查了好多资料都没满足。

突然想起了前段时间看的有关线程的视频,于是信手拈来写了一个线程的代码片段。

希望帮助刚学java线程的童鞋

package thread;

import java.text.SimpleDateFormat;

import java.util.Calendar;

import java.util.Date

- tomcat 容器

BlueSkator

tomcatWebservlet

Tomcat的组成部分 1、server

A Server element represents the entire Catalina servlet container. (Singleton) 2、service

service包括多个connector以及一个engine,其职责为处理由connector获得的客户请求。

3、connector

一个connector

- php递归,静态变量,匿名函数使用

dcj3sjt126com

PHP递归函数匿名函数静态变量引用传参

<!doctype html>

<html lang="en">

<head>

<meta charset="utf-8">

<title>Current To-Do List</title>

</head>

<body>

- 属性颜色字体变化

周华华

JavaScript

function changSize(className){

var diva=byId("fot")

diva.className=className;

}

</script>

<style type="text/css">

.max{

background: #900;

color:#039;

- 将properties内容放置到map中

g21121

properties

代码比较简单:

private static Map<Object, Object> map;

private static Properties p;

static {

//读取properties文件

InputStream is = XXX.class.getClassLoader().getResourceAsStream("xxx.properti

- [简单]拼接字符串

53873039oycg

字符串

工作中遇到需要从Map里面取值拼接字符串的情况,自己写了个,不是很好,欢迎提出更优雅的写法,代码如下:

import java.util.HashMap;

import java.uti

- Struts2学习

云端月影

最近开始关注struts2的新特性,从这个版本开始,Struts开始使用convention-plugin代替codebehind-plugin来实现struts的零配置。

配置文件精简了,的确是简便了开发过程,但是,我们熟悉的配置突然disappear了,真是一下很不适应。跟着潮流走吧,看看该怎样来搞定convention-plugin。

使用Convention插件,你需要将其JAR文件放

- Java新手入门的30个基本概念二

aijuans

java新手java 入门

基本概念: 1.OOP中唯一关系的是对象的接口是什么,就像计算机的销售商她不管电源内部结构是怎样的,他只关系能否给你提供电就行了,也就是只要知道can or not而不是how and why.所有的程序是由一定的属性和行为对象组成的,不同的对象的访问通过函数调用来完成,对象间所有的交流都是通过方法调用,通过对封装对象数据,很大限度上提高复用率。 2.OOP中最重要的思想是类,类是模板是蓝图,

- jedis 简单使用

antlove

javarediscachecommandjedis

jedis.RedisOperationCollection.java

package jedis;

import org.apache.log4j.Logger;

import redis.clients.jedis.Jedis;

import java.util.List;

import java.util.Map;

import java.util.Set;

pub

- PL/SQL的函数和包体的基础

百合不是茶

PL/SQL编程函数包体显示包的具体数据包

由于明天举要上课,所以刚刚将代码敲了一遍PL/SQL的函数和包体的实现(单例模式过几天好好的总结下再发出来);以便明天能更好的学习PL/SQL的循环,今天太累了,所以早点睡觉,明天继续PL/SQL总有一天我会将你永远的记载在心里,,,

函数;

函数:PL/SQL中的函数相当于java中的方法;函数有返回值

定义函数的

--输入姓名找到该姓名的年薪

create or re

- Mockito(二)--实例篇

bijian1013

持续集成mockito单元测试

学习了基本知识后,就可以实战了,Mockito的实际使用还是比较麻烦的。因为在实际使用中,最常遇到的就是需要模拟第三方类库的行为。

比如现在有一个类FTPFileTransfer,实现了向FTP传输文件的功能。这个类中使用了a

- 精通Oracle10编程SQL(7)编写控制结构

bijian1013

oracle数据库plsql

/*

*编写控制结构

*/

--条件分支语句

--简单条件判断

DECLARE

v_sal NUMBER(6,2);

BEGIN

select sal into v_sal from emp

where lower(ename)=lower('&name');

if v_sal<2000 then

update emp set

- 【Log4j二】Log4j属性文件配置详解

bit1129

log4j

如下是一个log4j.properties的配置

log4j.rootCategory=INFO, stdout , R

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appe

- java集合排序笔记

白糖_

java

public class CollectionDemo implements Serializable,Comparable<CollectionDemo>{

private static final long serialVersionUID = -2958090810811192128L;

private int id;

private String nam

- java导致linux负载过高的定位方法

ronin47

定位java进程ID

可以使用top或ps -ef |grep java

![图片描述][1]

根据进程ID找到最消耗资源的java pid

比如第一步找到的进程ID为5431

执行

top -p 5431 -H

![图片描述][2]

打印java栈信息

$ jstack -l 5431 > 5431.log

在栈信息中定位具体问题

将消耗资源的Java PID转

- 给定能随机生成整数1到5的函数,写出能随机生成整数1到7的函数

bylijinnan

函数

import java.util.ArrayList;

import java.util.List;

import java.util.Random;

public class RandNFromRand5 {

/**

题目:给定能随机生成整数1到5的函数,写出能随机生成整数1到7的函数。

解法1:

f(k) = (x0-1)*5^0+(x1-

- PL/SQL Developer保存布局

Kai_Ge

近日由于项目需要,数据库从DB2迁移到ORCAL,因此数据库连接客户端选择了PL/SQL Developer。由于软件运用不熟悉,造成了很多麻烦,最主要的就是进入后,左边列表有很多选项,自己删除了一些选项卡,布局很满意了,下次进入后又恢复了以前的布局,很是苦恼。在众多PL/SQL Developer使用技巧中找到如下这段:

&n

- [未来战士计划]超能查派[剧透,慎入]

comsci

计划

非常好看,超能查派,这部电影......为我们这些热爱人工智能的工程技术人员提供一些参考意见和思想........

虽然电影里面的人物形象不是非常的可爱....但是非常的贴近现实生活....

&nbs

- Google Map API V2

dai_lm

google map

以后如果要开发包含google map的程序就更麻烦咯

http://www.cnblogs.com/mengdd/archive/2013/01/01/2841390.html

找到篇不错的文章,大家可以参考一下

http://blog.sina.com.cn/s/blog_c2839d410101jahv.html

1. 创建Android工程

由于v2的key需要G

- java数据计算层的几种解决方法2

datamachine

javasql集算器

2、SQL

SQL/SP/JDBC在这里属于一类,这是老牌的数据计算层,性能和灵活性是它的优势。但随着新情况的不断出现,单纯用SQL已经难以满足需求,比如: JAVA开发规模的扩大,数据量的剧增,复杂计算问题的涌现。虽然SQL得高分的指标不多,但都是权重最高的。

成熟度:5星。最成熟的。

- Linux下Telnet的安装与运行

dcj3sjt126com

linuxtelnet

Linux下Telnet的安装与运行 linux默认是使用SSH服务的 而不安装telnet服务 如果要使用telnet 就必须先安装相应的软件包 即使安装了软件包 默认的设置telnet 服务也是不运行的 需要手工进行设置 如果是redhat9,则在第三张光盘中找到 telnet-server-0.17-25.i386.rpm

- PHP中钩子函数的实现与认识

dcj3sjt126com

PHP

假如有这么一段程序:

function fun(){

fun1();

fun2();

}

首先程序执行完fun1()之后执行fun2()然后fun()结束。

但是,假如我们想对函数做一些变化。比如说,fun是一个解析函数,我们希望后期可以提供丰富的解析函数,而究竟用哪个函数解析,我们希望在配置文件中配置。这个时候就可以发挥钩子的力量了。

我们可以在fu

- EOS中的WorkSpace密码修改

蕃薯耀

修改WorkSpace密码

EOS中BPS的WorkSpace密码修改

>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>

蕃薯耀 201

- SpringMVC4零配置--SpringSecurity相关配置【SpringSecurityConfig】

hanqunfeng

SpringSecurity

SpringSecurity的配置相对来说有些复杂,如果是完整的bean配置,则需要配置大量的bean,所以xml配置时使用了命名空间来简化配置,同样,spring为我们提供了一个抽象类WebSecurityConfigurerAdapter和一个注解@EnableWebMvcSecurity,达到同样减少bean配置的目的,如下:

applicationContex

- ie 9 kendo ui中ajax跨域的问题

jackyrong

AJAX跨域

这两天遇到个问题,kendo ui的datagrid,根据json去读取数据,然后前端通过kendo ui的datagrid去渲染,但很奇怪的是,在ie 10,ie 11,chrome,firefox等浏览器中,同样的程序,

浏览起来是没问题的,但把应用放到公网上的一台服务器,

却发现如下情况:

1) ie 9下,不能出现任何数据,但用IE 9浏览器浏览本机的应用,却没任何问题

- 不要让别人笑你不能成为程序员

lampcy

编程程序员

在经历六个月的编程集训之后,我刚刚完成了我的第一次一对一的编码评估。但是事情并没有如我所想的那般顺利。

说实话,我感觉我的脑细胞像被轰炸过一样。

手慢慢地离开键盘,心里很压抑。不禁默默祈祷:一切都会进展顺利的,对吧?至少有些地方我的回答应该是没有遗漏的,是不是?

难道我选择编程真的是一个巨大的错误吗——我真的永远也成不了程序员吗?

我需要一点点安慰。在自我怀疑,不安全感和脆弱等等像龙卷风一

- 马皇后的贤德

nannan408

马皇后不怕朱元璋的坏脾气,并敢理直气壮地吹耳边风。众所周知,朱元璋不喜欢女人干政,他认为“后妃虽母仪天下,然不可使干政事”,因为“宠之太过,则骄恣犯分,上下失序”,因此还特地命人纂述《女诫》,以示警诫。但马皇后是个例外。

有一次,马皇后问朱元璋道:“如今天下老百姓安居乐业了吗?”朱元璋不高兴地回答:“这不是你应该问的。”马皇后振振有词地回敬道:“陛下是天下之父,

- 选择某个属性值最大的那条记录(不仅仅包含指定属性,而是想要什么属性都可以)

Rainbow702

sqlgroup by最大值max最大的那条记录

好久好久不写SQL了,技能退化严重啊!!!

直入主题:

比如我有一张表,file_info,

它有两个属性(但实际不只,我这里只是作说明用):

file_code, file_version

同一个code可能对应多个version

现在,我想针对每一个code,取得它相关的记录中,version 值 最大的那条记录,

SQL如下:

select

*

- VBScript脚本语言

tntxia

VBScript

VBScript 是基于VB的脚本语言。主要用于Asp和Excel的编程。

VB家族语言简介

Visual Basic 6.0

源于BASIC语言。

由微软公司开发的包含协助开发环境的事

- java中枚举类型的使用

xiao1zhao2

javaenum枚举1.5新特性

枚举类型是j2se在1.5引入的新的类型,通过关键字enum来定义,常用来存储一些常量.

1.定义一个简单的枚举类型

public enum Sex {

MAN,

WOMAN

}

枚举类型本质是类,编译此段代码会生成.class文件.通过Sex.MAN来访问Sex中的成员,其返回值是Sex类型.

2.常用方法

静态的values()方