kerberos+kafka(2.13)认证(单节点ubuntu)

一:搭建kerberos。

1. 运行安装命令

apt-get install krb5-admin-server krb5-kdc krb5-user krb5-config

2. 检查服务是否启动。

systemctl status krb5-admin-server

systemctl status krb5-kdc

systemctl start krb5-admin-server

systemctl startkrb5-kdc

3. 修改配置

default_realm = CECGW.CN

# The following krb5.conf variables are only for MIT Kerberos.

kdc_timesync = 1

ccache_type = 4

forwardable = true

proxiable = true

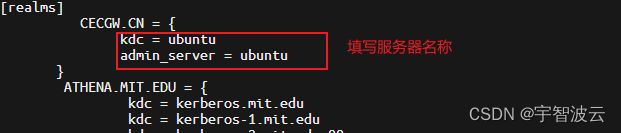

[realms]

CECGW.CN = {

kdc = ubuntu

admin_server = ubuntu

}

4. 创建数据库和principal,使用kdb5_util创建数据库,存放principal相关的信息。

创建数据库

cd /etc/krb5kdc

kdb5_util create -r CECGW.CN -s

输入俩次数据库密码

创建用户principal

kadmin.local

add_principal oneandonly/[email protected]

输入俩次密码 oneandonly/[email protected]

导出文件

xst -k oneandonly.keytab -norandkey oneandonly/[email protected]

验证登录,使用密钥登录.

root@ubuntu:/opt/kafka/kafka_2.13-3.6.1# kinit -kt oneandonly.keytab oneandonly/kerberos

root@ubuntu:/opt/kafka/kafka_2.13-3.6.1# klist

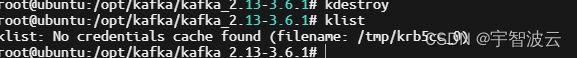

root@ubuntu:/opt/kafka/kafka_2.13-3.6.1# kdestroy

root@ubuntu:/opt/kafka/kafka_2.13-3.6.1# klist

二:配置kafka认证

1. 注册用户principal,导出密钥文件。

kadmin.local

kadmin.local: add_principal -randkey kafka-server/[email protected]

kadmin.local: add_principal -randkey [email protected]

kadmin.local: xst -k /root/kafka-server.keytab kafka-server/[email protected]

kadmin.local: xst -k /root/kafka-client.keytab [email protected]

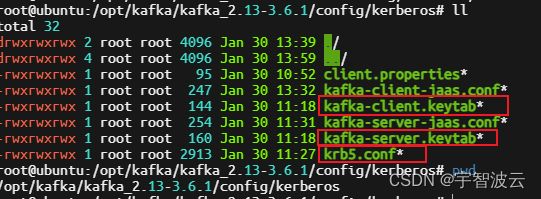

2. Kerberos 相关配置

2.1.拷贝 krb5.conf 及 keytab 文件到所有安装 Kafka 的机器,把文件都放到 Kafka 的 config/kerberos 目录下(kerberos 目录需新建)。

3. kafka服务端配置。

3.1 复制 config/server.properties(复制动作能帮助我们在 认证/非认证 模式自由切换)重命名为 config/server-sasl.properties,增加如下配置:

listeners=SASL_PLAINTEXT://ubuntu:9092

advertised.listeners=SASL_PLAINTEXT://ubuntu:9092

security.inter.broker.protocol=SASL_PLAINTEXT

sasl.mechanism.inter.broker.protocol=GSSAPI

sasl.enabled.mechanisms=GSSAPI

sasl.kerberos.service.name=kafka-server

3.2新建 kafka-server-jaas.conf 文件,该文件也放到 Kafka 的 config/kerberos 目录下:

KafkaServer {

com.sun.security.auth.module.Krb5LoginModule required

useKeyTab=true

keyTab="/opt/kafka/kafka_2.13-3.6.1/config/kerberos/kafka-server.keytab"

storeKey=true

useTicketCache=false

principal="kafka-server/[email protected]";

};

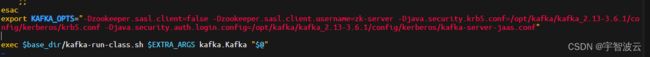

3.3 修改启动命令。

复制 bin/kafka-server-start.sh 脚本重命名为 bin/kafka-server-start-sasl.sh,倒数第二行增加如下配置

export KAFKA_OPTS="-Dzookeeper.sasl.client=false -Dzookeeper.sasl.client.username=zk-server -Djava.security.krb5.conf=/opt/kafka/kafka_2.13-3.6.1/config/kerberos/krb5.conf -Djava.security.auth.login.config=/opt/kafka/kafka_2.13-3.6.1/config/kerberos/kafka-server-jaas.conf"

4.Kafka 客户端配置

.新建 kafka-client-jaas.conf 文件,该文件也放到 Kafka 的 config/kerberos 目录下。

4.1 新建 client.properties 文件,该文件也放到 Kafka 的 config/kerberos 目录下。

security.protocol=SASL_PLAINTEXT

sasl.mechanism=GSSAPI

sasl.kerberos.service.name=kafka-server

4.2 新建 kafka-client-jaas.conf 文件,该文件也放到 Kafka 的 config/kerberos 目录下

KafkaClient {

com.sun.security.auth.module.Krb5LoginModule required

useKeyTab=true

keyTab="/opt/kafka/kafka_2.13-3.6.1/config/kerberos/kafka-client.keytab"

storeKey=true

useTicketCache=false

principal="[email protected]";

};

4.3 复制 bin/kafka-topics.sh、kafka-console-producer.sh、bin/kafka-console-consumer.sh 脚本,分别重命名为 bin/kafka-topics-sasl.sh、kafka-console-producer-sasl.sh、bin/kafka-console-consumer-sasl.sh,倒数第二行增加如下配置

export KAFKA_OPTS="-Djava.security.krb5.conf=/opt/kafka/kafka_2.13-3.6.1/config/kerberos/krb5.conf -Djava.security.auth.login.config=/opt/kafka/kafka_2.13-3.6.1/config/kerberos/kafka-client-jaas.conf"

三:启动测试

1. 启动zk

cd /opt/kafka/kafka_2.13-3.6.1

nohup bin/zookeeper-server-start.sh config/zookeeper.properties > /dev/null 2>&1 &

2. 运行 bin/kafka-server-start-sasl.s 启动 Kafka 集群:

./bin/kafka-server-start-sasl.sh -daemon config/server-sasl.properties

3. 运行 bin/kafka-topics-sasl.sh 查看 topic 列表信息:

./bin/kafka-topics-sasl.sh --list --bootstrap-server ubuntu:9092 --command-config config/kerberos/client.pr

operties

4. 创建topic

bin/kafka-topics-sasl.sh --create --bootstrap-server ubuntu:9092 --replication-factor 1 --partitions 1 --topic your_topic_name --command-config config/kerberos/client.properties

5. 运行 kafka-console-producer-sasl.sh 生产消息:

./bin/kafka-console-producer-sasl.sh --broker-list ubuntu:9092 --topic your_topic_name --producer.config config/kerberos/client.properties

6. 运行 bin/kafka-console-consumer-sasl.sh 消费消息:

./bin/kafka-console-consumer-sasl.sh --bootstrap-server ubuntu:9092 --topic your_topic_name --from-beginning --consumer.config config/kerberos/client.properties