- (二)SAP Group Reporting (GR) 核心子模块功能及数据流向架构解析

数据如何从子公司流转到合并报表的全过程,即数据采集→合并引擎→报表输出,特别是HANA内存计算如何优化传统ETL瓶颈。SAPGroupReporting(GR)核心模块功能及数据流向的架构解析,涵盖核心组件、数据处理流程和关键集成点,适用于S/4HANA1809+版本:一、核心功能模块概览模块功能关键事务码/FioriApp数据采集(DataCollection)整合子公司财务数据(SAP/非SA

- centos7安装配置 Anaconda3

Anaconda是一个用于科学计算的Python发行版,Anaconda于Python,相当于centos于linux。下载[root@testsrc]#mwgethttps://mirrors.tuna.tsinghua.edu.cn/anaconda/archive/Anaconda3-5.2.0-Linux-x86_64.shBegintodownload:Anaconda3-5.2.0-L

- Ubuntu安装LAMP

L_h1

测试ubuntulinux

在安装vim时遇到了一个问题:E:无法获得锁/var/lib/dpkg/lock-frontend-open(11:资源暂时不可用)E:无法获取dpkg前端锁(/var/lib/dpkg/lock-frontend),是否有其他进程正占用它?解决办法:强制解锁sudorm/var/lib/dpkg/lock-frontendsudorm/var/cache/apt/archives/locksud

- Python 网络科学(三)

绝不原创的飞龙

默认分类默认分类

原文:annas-archive.org/md5/3df7c5feb0bf40d7b9d88197a04b0b37译者:飞龙协议:CCBY-NC-SA4.0第八章:自我中心网络分析前一章内容非常丰富,我们学习了如何可视化和分析整个网络。相比之下,本章应该会感觉更简单,内容也会少得多。在之前的章节中,我们学习了如何获取和创建网络数据,如何从网络数据构建图形,如何清理图形数据,以及如何做一些有趣的事情

- 精通 Tableau 2023(四)

绝不原创的飞龙

默认分类默认分类

原文:annas-archive.org/md5/dd6efaef313fee7252226d3af4a0b9fd译者:飞龙协议:CCBY-NC-SA4.0第十三章:提升性能一旦人们熟悉了Tableau的功能,他们很快就会遇到另一种类型的问题:性能。你们可能都曾经在屏幕上盯着加载数据或执行查询的字样发呆。但别担心,我们有办法!如果设计得当,Tableau仪表盘即使处理大量数据也能表现得非常好。本章

- Hive使用必知必会系列

王知无(import_bigdata)

Hive系统性学习专栏hivebigdatahdfs

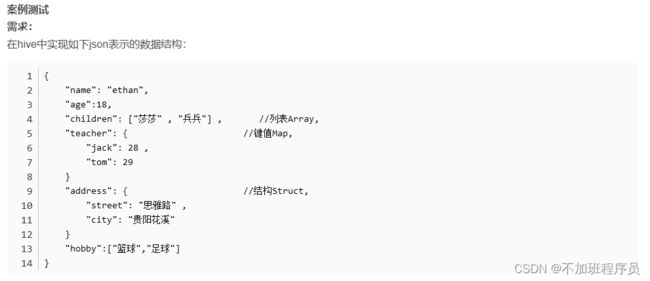

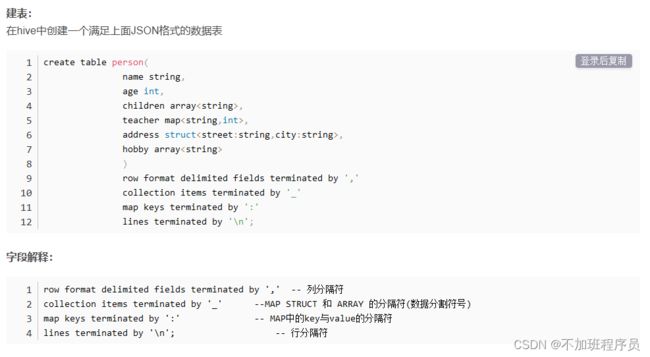

一、Hive的几种数据模型内部表(Table将数据保存到Hive自己的数据仓库目录中:/usr/hive/warehouse)外部表(ExternalTable相对于内部表,数据不在自己的数据仓库中,只保存数据的元信息)分区表(PartitionTable将数据按照设定的条件分开存储,提高查询效率,分区----->目录)桶表(BucketTable本质上也是一种分区表,类似hash分区桶---->

- Consul 与 Hive:云原生数据仓库集成

AI云原生与云计算技术学院

AI云原生与云计算数据仓库consulhiveai

Consul与Hive:云原生数据仓库集成关键词:Consul、Hive、云原生、数据仓库集成、服务发现摘要:本文深入探讨了Consul与Hive在云原生环境下的数据仓库集成。首先介绍了集成的背景和相关概念,包括Consul的服务发现机制和Hive作为数据仓库的特点。接着详细阐述了核心概念及联系,通过文本示意图和Mermaid流程图展示其架构。对集成所涉及的核心算法原理进行了讲解,并给出Pytho

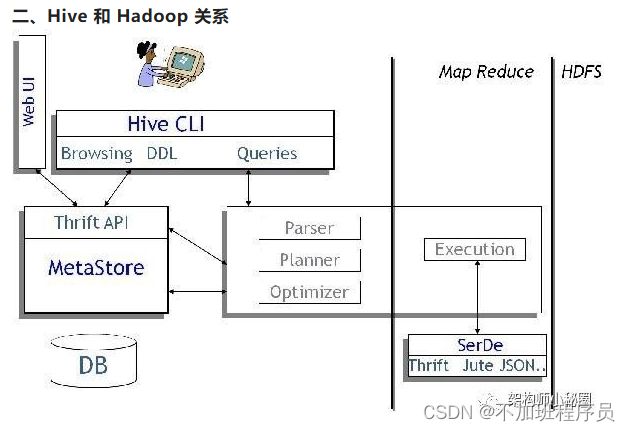

- Hive详解

一:Hive的历史价值1,Hive是Hadoop上的KillerApplication,Hive是Hadoop上的数据仓库,Hive同时兼具有数据仓库中的存储引擎和查询引擎的作用;而SparkSQL是一个更加出色和高级的查询引擎,所以在现在企业级应用中SparkSQL+Hive成为了业界使用大数据最为高效和流行的趋势。2,Hive是Facebook的推出,主要是为了让不动Java代码编程的人员也能

- Hive与Hudi集成:增量大数据处理方案

AI大数据智能洞察

大数据与AI人工智能大数据AI应用hivehadoop数据仓库ai

Hive与Hudi集成:增量大数据处理方案关键词:Hive、Hudi、增量大数据处理、数据集成、数据湖摘要:本文主要探讨了Hive与Hudi集成的增量大数据处理方案。我们将深入了解Hive和Hudi的核心概念,剖析它们之间的关系,详细阐述集成的算法原理与操作步骤,通过实际项目案例展示如何进行开发环境搭建、代码实现与解读。同时,会介绍该集成方案的实际应用场景、相关工具和资源,探讨未来发展趋势与挑战。

- 【自动化运维神器Ansible】Ansible常用模块之archive模块详解

IT成长日记

Ansible自动化运维指南自动化运维技术探索运维自动化ansiblearchive常用模块

目录1Ansiblearchive模块概述1.1archive模块的核心功能1.2为什么需要archive模块2archive模块工作原理3archive模块参数详解3.1必需参数:path3.2常用可选参数3.2.1dest3.2.2format3.2.3exclude3.3高级参数3.3.1remove3.3.2owner/group/mode4archive模块使用场景与示例4.1基础使用场

- Hive建表时开启事务机制导致insert失败: This command is not allowed on an ACID table.. with a non-ACID transaction

智海观潮

大数据Hivehive大数据

建表语句:createtableA(table_codestring,data_dtstring,update_dtstring)clusteredby(table_code)into1bucketsrowformatdelimitedfieldsterminatedby'\033'storedasorc--orc格式tablproperties('transactional'='true');执

- 面向现代数据湖仓的开放表格式对比分析:Iceberg、Hudi、Delta Lake与Paimon

piekill

大数据平台大数据sparkflinkbigdata数据仓库

文章目录第一章数据湖的演进:从存储到事务型平台1.1前湖仓时代:ApacheHive的局限性1.2湖仓一体的范式转移第二章架构深度剖析2.1ApacheIceberg:以元数据为中心的设计2.2ApacheHudi:流式优先、时间轴驱动的架构2.3DeltaLake:以事务日志为唯一真相源2.4ApachePaimon:面向实时湖仓的LSM树架构第三章核心能力对比分析3.1事务性与并发控制3.2数

- 【自动化运维神器Ansible】Ansible常用模块之unarchive模块详解

目录1unarchive模块概述1.1unarchive模块的核心价值2unarchive模块工作原理3unarchive模块参数详解3.1源文件相关参数3.1.1src3.1.2remote_src3.2目标路径参数3.2.1dest3.2.2extra_opts3.3高级控制参数3.3.1keep_newer3.3.2validate_certs4unarchive模块使用场景与示例4.1基础

- SAP BW数据仓库总览

weixin_42559081

[分享]SAPBW数据仓库简介本文从一个简单的业务场景-销售分析入手,介绍SAPBW(BusinessInfomationWarehouse)实现多维分析的基本方案与实现技术;结合销售分析的实际需求,给出了销售分析管理数据仓库在SAPBW(业务信息仓库)模块中的实现过程描述。1、数据仓库的基本理论1.1数据仓库数据仓库是对数据进行提炼、加工和集成含有一定量商务信息和意义的信息。数据仓库不是为了存储

- zookeeper和hadoop

zookeeper操作连接zkCli.sh-server服务名称查看客户端指令helpZooKeeper-serverhost:portcmdargs statpath[watch] setpathdata[version] lspath[watch] delquota[-n|-b]path ls2path[watch] setAclpathacl setquot

- Hadoop 之 ZooKeeper (一)

devalone

HadoopHadoopZooKeeperHbaseChubbyznode

Hadoop之ZooKeeper本文介绍使用Hadoop的分布式协调服务构建通用的分布式应用——ZooKeeper。ZooKeeper是Hadoop分布式协调服务。写分布式应用是比较难的,主要是因为部分失败(partialfailure).当一条消息通过网络在两个节点间发送时,如果发生网络错误,发送者无法知道接受者是否接收到了这条消息。接收者可能在发生网络错误之前已经收到了这条消息,也可能没有收到

- ZooKeeper在Hadoop中的协同应用:从NameNode选主到分布式锁实现

码字的字节

hadoop布道师分布式zookeeperhadoop分布式锁

Hadoop与ZooKeeper概述Hadoop与ZooKeeper在大数据生态系统中的核心位置和交互关系Hadoop的架构与核心组件作为大数据处理的基石,Hadoop生态系统由多个关键组件构成。其核心架构主要包含HDFS(HadoopDistributedFileSystem)和YARN(YetAnotherResourceNegotiator)两大模块。HDFS采用主从架构设计,由NameNo

- Java中给List<String>去重的4种方式

Java&Develop

Java开发javalistwindows

Java中给List去重的4种方式Listlist=newArrayListlist1=list.stream().distinct().collect(Collectors.toList());System.out.println("方式1:"+list1);//方式2:使用Set去重Setset=newHashSetlist2=newArrayListlinkedHashSet=newLink

- RK3568笔记九十一:QT环境搭建

殷忆枫

RK3568学习笔记笔记

若该文为原创文章,转载请注明原文出处。记录按照正点原子给的手册搭建QT环境参考《09【正点原子】ATK-DLRK3568_Qt开发环境搭建V1.2.pdf》一、安装1、下载https://mirrors.sau.edu.cn/qt/archive/online_installers/4.6/qt-unified-linux-x64-4.6.0-online.run2、赋予可执行权限chmod+xq

- 数据江湖的“三国演义”:数据仓库、数据湖与湖仓一体的全景对比

大模型大数据攻城狮

数据仓库数据湖湖仓一体IceberghudiSnowflake流式计算

目录1.数据仓库:秩序井然的“中央档案馆”核心特点:一切为了分析优势:稳定如山,分析无敌短板:灵活性欠佳实战案例:零售巨头的销售分析2.数据湖:自由奔放的“原始丛林”核心特点:包容一切优势:灵活到飞起短板:自由的代价实战案例:流媒体平台的用户行为分析3.湖仓一体:兼得鱼与熊掌的“新物种”核心特点:两全其美优势:全能选手短板:尚在成长实战案例:金融科技的实时风控4.技术选型的“天平”:如何选择适合你

- VisualStudio 制作Dynamic Link Library动态链接库文件

CDamogu

visualstudioc++windows

DynamicLinkLibrary动态链接库文件目录工具集如何生成__declspec(dllexport)extern"C"如何使用声明调用ExampleLoadLibraryExampleGetProcAddressExampleFreeLibraryExampleFAQSQuestion1:GetLastError获取错误代码127参考案例工具集借助工具可以获得Dll库函数的访问地址,以下

- 在python中安装geohash库

pip安装使用镜像网站安装pipinstall-iGeohashhttp://mirrors.aliyun.com/pypi/simple报错:CannotdeterminearchiveformatofC:\Users\Zz\AppData\Local\Temp\pip-req-build-t35bzb_f解决办法:重新安装,添加信任pipinstall-ihttps://pypi.tuna.t

- 交换两个数组使两个数组和的差最小

橙姜

https://www.cnblogs.com/nanduo/archive/2009/06/29/1513035.html

- Java Lock使用

lijiabin417

java开发语言

在编写代码时,使用Lock接口可以帮助你更好地控制多线程环境下的同步问题。Java提供了多种Lock实现,先介绍ReentrantLock//锁容器privateMapbackMap=newConcurrentHashMap<>();intcount=0;/***获取锁*@paramkey*@return*/privateLockgetLock(Stringkey){//根据key获取对应的锁,如

- Hive-3.1.2安装部署

ggnff

Hive-3.1.2安装部署一Hive-3.1.2网盘下载:链接:https://pan.baidu.com/s/1c8L3ygVae2kSN-ue8RZNtQ提取码:chjs1.下载完成后,上传到Linux的/opt/module下2.解压并重命名为hivecd/opt/moduletar-zxvfapache-hive-3.1.2-bin.tar.gzmvapache-hive-3.1.2-b

- 大数据开发系列(六)----Hive3.0.0安装配置以及Mysql5.7安装配置

Xiaoyeforever

hivemysqlhivehadoop数据库

一、Hive3.0.0安装配置:(Hive3.1.2有BUG)hadoop3.1.2Hive各个版本下载地址:http://archive.apache.org/dist/hive/,这里我们下载hive3.0.01、解压:tar-xzvfapache-hive-3.0.0-bin.tar.gz-C/usr/lib/JDK_2021cd/usr/lib/JDK_20212.改名称.将解压以后的文件

- 数据写入因为汉字引发的异常

qq_40841339

sparkhadoophivehivehadoop数据仓库

spark数据写hive表,发生查询分区异常问题异常:251071241926.49ERRORHive:MelaException(message.Exceptionthrownwhenexeculingquey.SELECTDISTINCT‘orgapache.hadop.hivemelastore.modelMpartionAs"NUCLEUSTYPE,AONCREATETIME,AO.LAS

- 大数据编程基础

芝麻开门-新的起点

大数据大数据

3.1Java基础(重点)内容讲解Java是大数据领域最重要的编程语言之一。Hadoop、HBase、Elasticsearch等众多核心框架都是用Java开发的。因此,扎实的Java基础对于深入理解这些框架的底层原理和进行二次开发至关重要。为什么Java在大数据领域如此重要?生态系统:Hadoop生态系统原生就是Java构建的,使用Java进行开发可以无缝集成。跨平台性:Java的“一次编译,到

- 编译过程中遇到的一些问题

nora_mhy

错误一解决:unsetLD_LIBRARY_PATH执行env命令看当前目录是否真在LD_LIBRARY_PATH中,如果在里则是环境的问题,找出原因修正好。否则是buildroot脚本问题,搜一下错误描述是哪里输出的,反向在buildroot脚本中加日志跟踪设置LD_LIBRARY_PATH的过程,找到问题根源错误二解决:

- 深入解析HBase如何保证强一致性:WAL日志与MVCC机制

码字的字节

hadoop布道师hadoopHBaseWALMVCC

HBase强一致性的重要性在分布式数据库系统中,强一致性是确保数据可靠性和系统可信度的核心支柱。作为Hadoop生态系统中关键的列式存储数据库,HBase需要处理金融交易、实时风控等高敏感场景下的海量数据操作,这使得强一致性成为其设计架构中不可妥协的基础特性。分布式环境下的数据一致性挑战在典型的HBase部署环境中,数据被分散存储在多个RegionServer节点上,同时面临以下核心挑战:1.跨节

- ASM系列六 利用TreeApi 添加和移除类成员

lijingyao8206

jvm动态代理ASM字节码技术TreeAPI

同生成的做法一样,添加和移除类成员只要去修改fields和methods中的元素即可。这里我们拿一个简单的类做例子,下面这个Task类,我们来移除isNeedRemove方法,并且添加一个int 类型的addedField属性。

package asm.core;

/**

* Created by yunshen.ljy on 2015/6/

- Springmvc-权限设计

bee1314

springWebjsp

万丈高楼平地起。

权限管理对于管理系统而言已经是标配中的标配了吧,对于我等俗人更是不能免俗。同时就目前的项目状况而言,我们还不需要那么高大上的开源的解决方案,如Spring Security,Shiro。小伙伴一致决定我们还是从基本的功能迭代起来吧。

目标:

1.实现权限的管理(CRUD)

2.实现部门管理 (CRUD)

3.实现人员的管理 (CRUD)

4.实现部门和权限

- 算法竞赛入门经典(第二版)第2章习题

CrazyMizzz

c算法

2.4.1 输出技巧

#include <stdio.h>

int

main()

{

int i, n;

scanf("%d", &n);

for (i = 1; i <= n; i++)

printf("%d\n", i);

return 0;

}

习题2-2 水仙花数(daffodil

- struts2中jsp自动跳转到Action

麦田的设计者

jspwebxmlstruts2自动跳转

1、在struts2的开发中,经常需要用户点击网页后就直接跳转到一个Action,执行Action里面的方法,利用mvc分层思想执行相应操作在界面上得到动态数据。毕竟用户不可能在地址栏里输入一个Action(不是专业人士)

2、<jsp:forward page="xxx.action" /> ,这个标签可以实现跳转,page的路径是相对地址,不同与jsp和j

- php 操作webservice实例

IT独行者

PHPwebservice

首先大家要简单了解了何谓webservice,接下来就做两个非常简单的例子,webservice还是逃不开server端与client端。我测试的环境为:apache2.2.11 php5.2.10做这个测试之前,要确认你的php配置文件中已经将soap扩展打开,即extension=php_soap.dll;

OK 现在我们来体验webservice

//server端 serve

- Windows下使用Vagrant安装linux系统

_wy_

windowsvagrant

准备工作:

下载安装 VirtualBox :https://www.virtualbox.org/

下载安装 Vagrant :http://www.vagrantup.com/

下载需要使用的 box :

官方提供的范例:http://files.vagrantup.com/precise32.box

还可以在 http://www.vagrantbox.es/

- 更改linux的文件拥有者及用户组(chown和chgrp)

无量

clinuxchgrpchown

本文(转)

http://blog.163.com/yanenshun@126/blog/static/128388169201203011157308/

http://ydlmlh.iteye.com/blog/1435157

一、基本使用:

使用chown命令可以修改文件或目录所属的用户:

命令

- linux下抓包工具

矮蛋蛋

linux

原文地址:

http://blog.chinaunix.net/uid-23670869-id-2610683.html

tcpdump -nn -vv -X udp port 8888

上面命令是抓取udp包、端口为8888

netstat -tln 命令是用来查看linux的端口使用情况

13 . 列出所有的网络连接

lsof -i

14. 列出所有tcp 网络连接信息

l

- 我觉得mybatis是垃圾!:“每一个用mybatis的男纸,你伤不起”

alafqq

mybatis

最近看了

每一个用mybatis的男纸,你伤不起

原文地址 :http://www.iteye.com/topic/1073938

发表一下个人看法。欢迎大神拍砖;

个人一直使用的是Ibatis框架,公司对其进行过小小的改良;

最近换了公司,要使用新的框架。听说mybatis不错;就对其进行了部分的研究;

发现多了一个mapper层;个人感觉就是个dao;

- 解决java数据交换之谜

百合不是茶

数据交换

交换两个数字的方法有以下三种 ,其中第一种最常用

/*

输出最小的一个数

*/

public class jiaohuan1 {

public static void main(String[] args) {

int a =4;

int b = 3;

if(a<b){

// 第一种交换方式

int tmep =

- 渐变显示

bijian1013

JavaScript

<style type="text/css">

#wxf {

FILTER: progid:DXImageTransform.Microsoft.Gradient(GradientType=0, StartColorStr=#ffffff, EndColorStr=#97FF98);

height: 25px;

}

</style>

- 探索JUnit4扩展:断言语法assertThat

bijian1013

java单元测试assertThat

一.概述

JUnit 设计的目的就是有效地抓住编程人员写代码的意图,然后快速检查他们的代码是否与他们的意图相匹配。 JUnit 发展至今,版本不停的翻新,但是所有版本都一致致力于解决一个问题,那就是如何发现编程人员的代码意图,并且如何使得编程人员更加容易地表达他们的代码意图。JUnit 4.4 也是为了如何能够

- 【Gson三】Gson解析{"data":{"IM":["MSN","QQ","Gtalk"]}}

bit1129

gson

如何把如下简单的JSON字符串反序列化为Java的POJO对象?

{"data":{"IM":["MSN","QQ","Gtalk"]}}

下面的POJO类Model无法完成正确的解析:

import com.google.gson.Gson;

- 【Kafka九】Kafka High Level API vs. Low Level API

bit1129

kafka

1. Kafka提供了两种Consumer API

High Level Consumer API

Low Level Consumer API(Kafka诡异的称之为Simple Consumer API,实际上非常复杂)

在选用哪种Consumer API时,首先要弄清楚这两种API的工作原理,能做什么不能做什么,能做的话怎么做的以及用的时候,有哪些可能的问题

- 在nginx中集成lua脚本:添加自定义Http头,封IP等

ronin47

nginx lua

Lua是一个可以嵌入到Nginx配置文件中的动态脚本语言,从而可以在Nginx请求处理的任何阶段执行各种Lua代码。刚开始我们只是用Lua 把请求路由到后端服务器,但是它对我们架构的作用超出了我们的预期。下面就讲讲我们所做的工作。 强制搜索引擎只索引mixlr.com

Google把子域名当作完全独立的网站,我们不希望爬虫抓取子域名的页面,降低我们的Page rank。

location /{

- java-归并排序

bylijinnan

java

import java.util.Arrays;

public class MergeSort {

public static void main(String[] args) {

int[] a={20,1,3,8,5,9,4,25};

mergeSort(a,0,a.length-1);

System.out.println(Arrays.to

- Netty源码学习-CompositeChannelBuffer

bylijinnan

javanetty

CompositeChannelBuffer体现了Netty的“Transparent Zero Copy”

查看API(

http://docs.jboss.org/netty/3.2/api/org/jboss/netty/buffer/package-summary.html#package_description)

可以看到,所谓“Transparent Zero Copy”是通

- Android中给Activity添加返回键

hotsunshine

Activity

// this need android:minSdkVersion="11"

getActionBar().setDisplayHomeAsUpEnabled(true);

@Override

public boolean onOptionsItemSelected(MenuItem item) {

- 静态页面传参

ctrain

静态

$(document).ready(function () {

var request = {

QueryString :

function (val) {

var uri = window.location.search;

var re = new RegExp("" + val + "=([^&?]*)", &

- Windows中查找某个目录下的所有文件中包含某个字符串的命令

daizj

windows查找某个目录下的所有文件包含某个字符串

findstr可以完成这个工作。

[html]

view plain

copy

>findstr /s /i "string" *.*

上面的命令表示,当前目录以及当前目录的所有子目录下的所有文件中查找"string&qu

- 改善程序代码质量的一些技巧

dcj3sjt126com

编程PHP重构

有很多理由都能说明为什么我们应该写出清晰、可读性好的程序。最重要的一点,程序你只写一次,但以后会无数次的阅读。当你第二天回头来看你的代码 时,你就要开始阅读它了。当你把代码拿给其他人看时,他必须阅读你的代码。因此,在编写时多花一点时间,你会在阅读它时节省大量的时间。让我们看一些基本的编程技巧: 尽量保持方法简短 尽管很多人都遵

- SharedPreferences对数据的存储

dcj3sjt126com

SharedPreferences简介: &nbs

- linux复习笔记之bash shell (2) bash基础

eksliang

bashbash shell

转载请出自出处:

http://eksliang.iteye.com/blog/2104329

1.影响显示结果的语系变量(locale)

1.1locale这个命令就是查看当前系统支持多少种语系,命令使用如下:

[root@localhost shell]# locale

LANG=en_US.UTF-8

LC_CTYPE="en_US.UTF-8"

- Android零碎知识总结

gqdy365

android

1、CopyOnWriteArrayList add(E) 和remove(int index)都是对新的数组进行修改和新增。所以在多线程操作时不会出现java.util.ConcurrentModificationException错误。

所以最后得出结论:CopyOnWriteArrayList适合使用在读操作远远大于写操作的场景里,比如缓存。发生修改时候做copy,新老版本分离,保证读的高

- HoverTree.Model.ArticleSelect类的作用

hvt

Web.netC#hovertreeasp.net

ArticleSelect类在命名空间HoverTree.Model中可以认为是文章查询条件类,用于存放查询文章时的条件,例如HvtId就是文章的id。HvtIsShow就是文章的显示属性,当为-1是,该条件不产生作用,当为0时,查询不公开显示的文章,当为1时查询公开显示的文章。HvtIsHome则为是否在首页显示。HoverTree系统源码完全开放,开发环境为Visual Studio 2013

- PHP 判断是否使用代理 PHP Proxy Detector

天梯梦

proxy

1. php 类

I found this class looking for something else actually but I remembered I needed some while ago something similar and I never found one. I'm sure it will help a lot of developers who try to

- apache的math库中的回归——regression(翻译)

lvdccyb

Mathapache

这个Math库,虽然不向weka那样专业的ML库,但是用户友好,易用。

多元线性回归,协方差和相关性(皮尔逊和斯皮尔曼),分布测试(假设检验,t,卡方,G),统计。

数学库中还包含,Cholesky,LU,SVD,QR,特征根分解,真不错。

基本覆盖了:线代,统计,矩阵,

最优化理论

曲线拟合

常微分方程

遗传算法(GA),

还有3维的运算。。。

- 基础数据结构和算法十三:Undirected Graphs (2)

sunwinner

Algorithm

Design pattern for graph processing.

Since we consider a large number of graph-processing algorithms, our initial design goal is to decouple our implementations from the graph representation

- 云计算平台最重要的五项技术

sumapp

云计算云平台智城云

云计算平台最重要的五项技术

1、云服务器

云服务器提供简单高效,处理能力可弹性伸缩的计算服务,支持国内领先的云计算技术和大规模分布存储技术,使您的系统更稳定、数据更安全、传输更快速、部署更灵活。

特性

机型丰富

通过高性能服务器虚拟化为云服务器,提供丰富配置类型虚拟机,极大简化数据存储、数据库搭建、web服务器搭建等工作;

仅需要几分钟,根据CP

- 《京东技术解密》有奖试读获奖名单公布

ITeye管理员

活动

ITeye携手博文视点举办的12月技术图书有奖试读活动已圆满结束,非常感谢广大用户对本次活动的关注与参与。

12月试读活动回顾:

http://webmaster.iteye.com/blog/2164754

本次技术图书试读活动获奖名单及相应作品如下:

一等奖(两名)

Microhardest:http://microhardest.ite