【pytorch】pytorch学习笔记

(实践)p5:线性回归问题中损失函数为什么要使用均方误差?

均方误差:即误差的平方和的平均数。

p8:1.pytorch不是一个完备的语言库,而是一个对于数据的gpu加速库,所以其没有对string的内键支持,即pytorch的基本类型中不包含string。

2.pytorch表示string的方法:

(1)one hot encoding

问题:1)两个单词之间的相关性并没有在one hot编码中得到体现;

2)当编码结果为上百维时,是一个稀疏矩阵。

(2)nlp中的embedding layer:为解决1)两个单词之间的相关性并没有在one hot编码中得到体现

有:word2vec,glove。

综上,pytorch中string是没有内键支持的,要支持的话我们必须使用编码的方式。

3.数据类型:

cpu上:torch.FloatTensor torch.IntTensor torch.ByteTnesor

gpu上:torch.cuda.FloatTensor torch.cuda.IntTensor torch.cuda.ByteTnesor

所以,数据一样,放置的位置不一样,类型也不一样。

torch.randn(2,3):随机创建一个两行三列的tensor。

tensor.type():返回tensor的类型。

isinstance(tensor,tensor的类型a):用来检验tensor类型的合法化,即tensor是否是a类型的。

data=data.cuda():把cpu上的数据data搬运到gpu上。

torch.tensor(1.):生成标量,维度为0。该类型(即标量)常用于loss的结果(即:均方误差的结果)。

torch.shape:是实例的一个成员,所以没有括号。

torch.size():是实例的一个成员函数,所以有括号。

len(tensor.shape):返回tensor的维度,是一个数字。

tensor.dim:同上。

torch.tensor([1,2,...,n]):生成一个n维的张量。

pytorch中,0维的叫标量,1维,2维,。。。,都叫张量。

(实践)torch.FloatTensor(2):随机初始化一个2维的张量。也可以用numpy实现。

4.1维的张量多用于bias,即神经单元中的参数b,偏值。

5.注意区分dim,size/shape,tensor:

dim(2)是size/shape([2,2])的长度,size/shape是tensor([1,2][3,4],两行两列的一个矩阵)的形状。

p9:1.torch.FloatTensor(2,3):生成一个两行三列的矩阵。

二维的tensor常用于批量线性输入(Linear input batch)

2.torch.randn():使用随机的正态分布;torch.rand():使用随机的均匀分布。

3.三维的适用于RNN

4.四维的适合表达图片,因此适用于CNN。

5.tensor.nume():返回tensor所占内存大小。若tensor是2*3*28*28的,则返回2*3*28*28=4704。

p10:1.torch.tensor():括号里放的是具体的数据(列表形式)或是np;torch.Tensor()与torch.FloatTensor()类似,括号里放的是数据的维度(shape),不过也可以放现有数据,即列表。建议:少用Tensor()括号里放列表的情况。

2.未初始化的tensor并不是没有数据,而是有数据的,只不过数据都是随机的,可能会特别大或者特别小。所以以后如果出现nan或者inf报错的话,可能是把未初始化的tensor喂给了神经网络。

3.Tensor()生成的类型是默认的类型,即把默认的类型设置成什么类型,Tensor()生成的就是什么类型的tensor,通常会把默认的类型由float改为double,因为double类型的精度是64位,会更精确一些。

4.随机初始化函数:

(1)rand(2,3):随机均匀生成[0,1]区间内的数组成的两行三列的矩阵。

(2)rand_like(tensor):随机生成类似于tensor的tensor,会先读出tensor的shape,然后再把shape喂给rand,生成相似的tensor。

(3)randint(min,max,shape):生成[min,max)区间内的数组成的tensor,shape是列表形式。

(4)randn(3,3):正态分布

(5)normal(mean,std):指定均值和方差的正态分布。使用起来有些别扭。

(6)full(shape:list,element):全部赋值为一个元素。

(7)arange(start,end,step=1):生成一个从start到end(不包含end)的等差(step)数列。range()函数在pytorch中不建议使用。

(8)linspace(start,end,steps):等分切割从start到end(包含end),共且分出steps个数。

(9)logspace(start,end,steps):等分切割从start到end(包含end),共且分出steps个数。并将这steps个数作为10的指数,将求得的指数结果返回。

(10)ones(shape:list):生成形状为shape的全1矩阵。

(11)zeros(shape:list):生成形状为shape的全0矩阵。

(12)eye(shape:list):生成形状为shape的对角线元素全为1,其余元素全为0的矩阵。若shape的行和列不相等,则取行列中的较小值为方阵的维数。当行列相等时,shape可以只是一个数。该函数的参数只能是1个或者是2个,不接受更高维的参数。

(13)ones_like(a):生成形状与a相同的全1矩阵。

(14)randperm(num):生成[0,num)的索引,并随机打散。

p14:1.view/reshape:保持tensor整个大小(size)不变的情况下可以将一个shape转变成另一个任意的shape。这个两个操作几乎一样,完全可以通用。

view进行维度的合并必须有真实的物理意义。但是根据变换后的矩阵无法恢复成原来的存储方式,会造成数据的污染。

2.squeeze/unsqueeze:挤压与增加维度的操作。删减维度/增加维度。

(1)unsqueeze(num):num的范围是[-a.dim()-1,a.dim()+1),超出建议使用[0,a.dim()],这个区间足以覆盖我们的需求。当num=0时,表示在原来的第0个维度的前面插入一个维度;当num=a.dim()时,表示在原来的最后一个维度的后面插入一个维度。当num是非负数时,是在以num为索引的数之前插入一个维度,而当num为负数时,是在以num为索引的数之后插入一个维度。该函数实现了新插入一个自定义的维度,这个维度不会改变数据本身,不会增加数据也不会减少数据,只是给数据新增加了一个自定义的组别,它改变的其实是理解方式。在后面插入一个维度,就是在当前维度内增加一个维度;在前面插入一个维度,就是在当前维度外面再包一个维度。

(2)squeeze(idx):idx为要删减的那个维度的参数,如果不给idx的话,会把所有能删减的(即:dim.size为1的维度)都删减掉。idx可以是正索引,也可以是负索引。如果当前索引上的shape不是1的话,它就不会变,如果是1的话,就会把这个维度减少掉。

3.transpose/t/permute:矩阵的转置。有多维的单次操作/多次操作。

(1).t():矩阵的转置。注意:该方法只适用于2维的,即只适用于矩阵。否则会报错。

(理解)(2)transpose(num1,num2):交换num1维度和num2维度。会使得内存顺序变得不连续,所以需要使用.contiguous来使得内存顺序变得连续。

要把维度的变换信息跟踪住。

(3)permute():括号里放的是多次变换后最终的维度顺序,标识维度的索引还是最一开始的索引。会使得内存顺序变得不连续,所以需要使用.contiguous来使得内存顺序变得连续。

4.expand/repeat:维度的扩展,可以将维度很小的转换成一个高维度的变量。扩展/重复。

(1)expand:扩展,只是改变了我们的理解方式,并没有增加数据。(推荐)

(2)repeat:重复,确实增加了数据。

(3)这两种操作在最终的效果上是一致的。只不过expand不会主动复制数据,只有在必要时才会复制数据。而且expand执行速度快,节约内存。

(4)expand():括号里的参数表示新的shape。扩展前后维度数目必须相等,而且它只能实现从1到n的扩展,而从2(或者其他大于1的数)到m的扩展是不能实现的。如果在括号里出现了-1,则表示该维度保持不变。有一个bug:就是如果括号里写了-4,那扩展之后的相应位置的维度也会变成-4.

(5)repeat():括号里的数字表示的是每一个dim需要拷贝的次数。

5.使用eq(a,b)来比较a和b的内容是否一致。

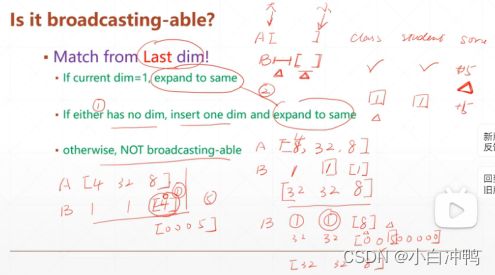

p18:broadcasting:自动扩展。它的操作和expand一样,但是它是自动的,也不需要复制数据。

实现的关键步骤:(1)从右边开始比较当前tensor和目标tensor的维度信息,若当前tensor最左边的维度确实,则在前面增加一个维度,为1;(2)自动调用expand函数将1扩展为n(需要扩展的(就是当前tensor和目标tensor不一样的维度)都扩展),使得当前tensor和目标tensor的维度信息一致。

在一个列表表示的维度里,最右边的认为是最小的维度,最左边的认为是最大的维度。

broadcasting=unsqueeze+expand

p19:

(问题:怎么手动完成?)

对于没有给到维度,我们认为给了的维度在没有给的维度都是适用的。

默认从最小维度开始匹配。

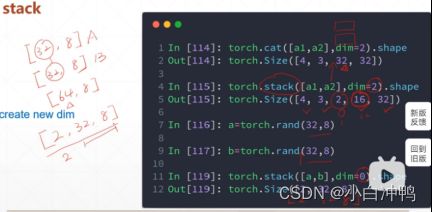

p20:1.拼接:

(1)cat(list:包含所有需要的tensor,如[a,b],dim=0:表示在第0个维度上进行拼接):

进行cat的两个tensor的除需要拼接的维度以外的其他维度必须都相同,要拼接的维度可相同也可不相同。

(2)stack(list:如[a,b],dim=0:表示在第0个维度前添加一个新的维度):与cat不同的是,stack会创建一个新的维度。

进行stack的tensor的相应位置的维度必须相同。

2.拆分:

(1)split(len,dim=0:表示对第0个维度进行拆分):按长度进行拆分。

len:如果采用固定长度(固定长度必须小于该维度上的数字,否则会报错)进行拆分,那么令len=固定长度即可;若不是采用固定长度拆分,则令len=[a,b,...],a/b/...表示拆分后的第一块的长度,第二块的长度,...。要求使得列表中的所有元素相加的和等于拆分前该维度上的数字。

(2)chunk(num,dim=0:表示要进行拆分的维度):按数量进行拆分。

(未完,待续~)