- 实时数据流计算引擎Flink和Spark剖析

程小舰

flinkspark数据库kafkahadoop

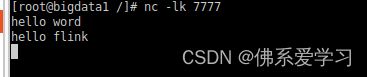

在过去几年,业界的主流流计算引擎大多采用SparkStreaming,随着近两年Flink的快速发展,Flink的使用也越来越广泛。与此同时,Spark针对SparkStreaming的不足,也继而推出了新的流计算组件。本文旨在深入分析不同的流计算引擎的内在机制和功能特点,为流处理场景的选型提供参考。(DLab数据实验室w.x.公众号出品)一.SparkStreamingSparkStreamin

- Deepseek技术深化:驱动大数据时代颠覆性变革的未来引擎

荣华富贵8

springboot搜索引擎后端缓存redis

在大数据时代,信息爆炸和数据驱动的决策逐渐重塑各行各业。作为一项前沿技术,Deepseek正在引领新一轮技术革新,颠覆传统数据处理与分析方式。本文将从理论原理、应用场景和前沿代码实践三个层面,深入剖析Deepseek技术如何为大数据时代提供颠覆性变革的解决方案。一、技术背景与核心思想1.1大数据挑战与机遇在数据量呈指数级增长的背景下,传统数据处理方法面临数据存储、计算效率和信息提取精度的诸多挑战。

- 大数据之路:阿里巴巴大数据实践——大数据领域建模综述

为什么需要数据建模核心痛点数据冗余:不同业务重复存储相同数据(如用户基础信息),导致存储成本激增。计算资源浪费:未经聚合的明细数据直接参与计算(如全表扫描),消耗大量CPU/内存资源。数据一致性缺失:同一指标在不同业务线的口径差异(如“活跃用户”定义不同),引发决策冲突。开发效率低下:每次分析需重新编写复杂逻辑,无法复用已有模型。数据建模核心价值性能提升:分层设计(ODS→DWD→DWS→ADS)

- 大数据技术笔记—spring入门

卿卿老祖

篇一spring介绍spring.io官网快速开始Aop面向切面编程,可以任何位置,并且可以细致到方法上连接框架与框架Spring就是IOCAOP思想有效的组织中间层对象一般都是切入service层spring组成前后端分离已学方式,前后台未分离:Spring的远程通信:明日更新创建第一个spring项目来源:科多大数据

- 大数据精准获客并实现高转化的核心思路和实现方法

2401_88470328

大数据精准获客数据分析数据挖掘大数据需求分析bigdata

大数据精准获客并实现高转化的核心思路和实现方法大数据精准获客并实现高转化的核心思路和实现方法在当今信息爆炸的时代,企业如何通过海量的数据精准获取潜在客户,并提高转化率,已经成为营销策略中的关键环节。大数据精准获客的核心思路在于数据驱动、多渠道触达以及优化转化路径,从而实现高效的市场推广和客户转化。数据驱动原理和机制数据驱动的核心在于通过分析用户行为数据,挖掘潜在客户的需求和喜好,从而制定更加精准的

- 一地鸡毛—一个中年男人的日常2021241

随止心语所自欲律

2021年8月31日,星期二,阴有小雨。早起5:30,跑步10公里。空气清新,烟雨朦胧,远山如黛,烟雾缭绕,宛若仙境。空气中湿气很大,朦胧细雨拍打在脸上,甚是舒服,跑步的人明显减少。早上开会,领导说起逐年大幅度下滑的工作业绩,越说越激动,说得脸红脖子粗。开完会又讨论了一下会议精神,心情也有波动,学习热情不高。心里还有一个大事,是今日大数据分析第1次考试,因自己前期没学,而且计算机编程方面没有任何基

- Hive详解

一:Hive的历史价值1,Hive是Hadoop上的KillerApplication,Hive是Hadoop上的数据仓库,Hive同时兼具有数据仓库中的存储引擎和查询引擎的作用;而SparkSQL是一个更加出色和高级的查询引擎,所以在现在企业级应用中SparkSQL+Hive成为了业界使用大数据最为高效和流行的趋势。2,Hive是Facebook的推出,主要是为了让不动Java代码编程的人员也能

- 智慧施工:AI技术赋能建筑安全监测新纪元

开发AI智能应用,就下载InsCodeAIIDE,一键接入DeepSeek-R1满血版大模型!智慧施工:AI技术赋能建筑安全监测新纪元在现代建筑行业中,施工安全始终是核心关注点之一。随着科技的飞速发展,人工智能(AI)和大数据分析逐渐成为提升施工安全的重要工具。本文将探讨如何利用智能化软件和大模型API来构建高效的施工安全监测系统,并介绍一款强大的开发工具——InsCodeAIIDE的应用场景及其

- 智慧工地系统:建筑行业数字化变革的引领者

青云智慧园区

java

在建筑行业积极迈向数字化转型的浪潮中,智慧工地系统凭借“数据驱动、智能管控、协同增效”的核心优势,深度融合物联网、大数据、人工智能等前沿技术,构建起覆盖工程项目全生命周期的精细化管理体系。以下将从系统架构、核心功能模块、应用价值以及未来展望等方面,全方位剖析智慧工地系统如何实现施工全过程的智能化、高效化管理。一、系统架构:打造一体化协同管理平台智慧工地系统采用先进的分层架构设计,以底层的数据采集层

- Hive与Hudi集成:增量大数据处理方案

AI大数据智能洞察

大数据与AI人工智能大数据AI应用hivehadoop数据仓库ai

Hive与Hudi集成:增量大数据处理方案关键词:Hive、Hudi、增量大数据处理、数据集成、数据湖摘要:本文主要探讨了Hive与Hudi集成的增量大数据处理方案。我们将深入了解Hive和Hudi的核心概念,剖析它们之间的关系,详细阐述集成的算法原理与操作步骤,通过实际项目案例展示如何进行开发环境搭建、代码实现与解读。同时,会介绍该集成方案的实际应用场景、相关工具和资源,探讨未来发展趋势与挑战。

- 获取三网实时访客---无忧获客大数据

无牛_abc3

很多传统行业的公司与企业对于运营商大数据的理解还是很基础的,大多数都是在买资源程度的认识。一些敢于尝试运营商大数据获客的传统企业自然会受益颇多。运营商大数据所提供的获客服务也非常简单,就是将自身的用户数据资源、针对不同的企业去制定有个性化需求的获客标准,运营商大数据根据不同的企业,和行业去进行精准客户的部署和分配,让相关合作的企业通过运营商提供的CRM平台进行一个有效的触达。运营商大数据已经在全国

- DeepSeek在大数据领域正掀起一场深刻的变革

智海观潮

AI大数据deepseekAI

随着人工智能技术的飞速发展,DeepSeek作为一款行业领先的开源大模型,正在大数据领域掀起一场深刻的变革。其强大的数据处理和分析能力,为各行业带来了新的机遇和变革,推动数据与业务的深度融合。以下是DeepSeek在大数据领域的一些典型的潜在应用:1.加速数据处理与分析流程在传统的大数据应用中,数据收集、预处理和分析往往是一个繁琐且耗时的工程。DeepSeek凭借其高效的算法和强大的计算能力,极大

- IoTDB智能分析节点AINode:时序数据分析的新引擎

时序数据说

iotdb数据分析数据挖掘时序数据库数据库大数据ai

在大数据与物联网的驱动下,时序数据处理需求激增,如何高效存储、管理并实时分析海量时序数据成为技术挑战。作为专为时序数据设计的数据库,IoTDB通过引入智能分析节点(AINode),将机器学习能力原生集成到数据库中,实现了“数据存储-分析-决策”的一体化闭环。本文将深入解析AINode的核心功能、技术优势及实际应用场景。AINode:IoTDB的智能分析引擎AINode是IoTDB推出的第三种内生节

- Python爬虫【五十八章】Python数据清洗与分析全攻略:从Pandas到深度学习的异常检测进阶

程序员_CLUB

Python入门到进阶python爬虫pandas

目录背景与需求分析第一章:结构化数据清洗实战(Pandas核心技法)1.1数据去重策略矩阵1.2智能缺失值处理体系第二章:深度学习异常检测进阶2.1自动编码器异常检测(时序数据)2.2图神经网络异常检测(关系型数据)第三章:综合案例实战案例1:金融交易反欺诈系统案例2:工业传感器异常检测第四章:性能优化与工程实践4.1大数据处理加速技巧4.2模型部署方案第五章:方法论总结与展望5.1方法论框架5.

- 《剑指offer》-算法篇-排序

小新学习屋

数据结构与算法算法leetcode职场和发展数据结构与算法

题目最小的K个数数组中的逆序对代码实现最小的K个数题目描述:输入n个整数,找出其中最小的K个数。例如输入4,5,1,6,2,7,3,8这8个数字,则最小的4个数字是1,2,3,4,。思路:按照各种排序算法,找到排序结果的前K个数。思路1:最简单的方案,对数组进行排序,取最小的k个思路2:借鉴快速排序的思想,找partition的基准点povit,比较povit和k值的大小思路3:大数据处理的思想,

- ZooKeeper在Hadoop中的协同应用:从NameNode选主到分布式锁实现

码字的字节

hadoop布道师分布式zookeeperhadoop分布式锁

Hadoop与ZooKeeper概述Hadoop与ZooKeeper在大数据生态系统中的核心位置和交互关系Hadoop的架构与核心组件作为大数据处理的基石,Hadoop生态系统由多个关键组件构成。其核心架构主要包含HDFS(HadoopDistributedFileSystem)和YARN(YetAnotherResourceNegotiator)两大模块。HDFS采用主从架构设计,由NameNo

- 优查查PROB版本使用介绍,优查查官网查询入口

无忧达人

优查查最新版本PROB版本上线,优查查PROB版本的查询报告更全面,同时价格还是以前的价格,优查查大数据信用查询一次的价格是30,当然这个价格只限本文介绍的渠道,渠道我会放在文末,大家自行获取即可。优查查使用起来非常的流程,可以快速查询出来我们自身有没有信用稳定,优查查官网查询入口,每个人都可以使用优查查一键查询自己的信用,只能查询自己的信用,别人的信用是查询不了的。优查查使用入口放在文末了,划到

- 贝融助手要交68块钱查询是合理吗?其实是很多人搞错查询渠道了

无忧达人

我们都知道查询信用的平台都是需要收费,具体的收费每个平台都是不一样的,目前行业中收费基本上都是在30-100,其中大平台的收费会低一些,因为体量大可以降低自身的营业成本,这个原理和其它行业一样。贝融助手查询大数据信用收费是30(本文介绍的渠道),这个价格得益于贝融助手平台的体量,已经把价格做的非常低了,像信用行业大平台的价格基本上都是趋于行业的平均值,太高了太低了都不是正常值。贝融助手查询入口放在

- 深度评测:拼多多官方返利APP vs 其他返利平台,谁更胜一筹?

日常购物技巧呀

购物新宠儿!拼多多官方返利APP,引领智能返利新时代。随着科技的不断发展智能化已经成为了各个领域的发展趋势。在返利领域也不例外拼多多官方返利app凭借其强大的智能技术和创新能力正引领着智能返利新时代。这款app通过大数据分析用户行为习惯精准推送符合用户需求的商品和优惠信息。让你在享受智能化服务的同时也能获得更加精准的返利回报。在繁多的返利app中,高省app凭借其独特的优势脱颖而出,成为众多用户的

- Flink Checkpoint 状态后端详解:类型、特性对比及场景化选型指南

ApacheFlink提供了多种状态后端以支持Checkpoint机制下的状态持久化,确保在故障发生时能够快速恢复状态并实现Exactly-Once处理语义。以下是几种常见状态后端的详细介绍及其对比情况,以及不同场景下的选型建议:1.MemoryStateBackend(内存状态后端)描述:MemoryStateBackend将状态数据存储在TaskManager的JVM堆内存中,并在Checkp

- Flink 自定义类加载器和子优先类加载策略

lifallen

Flink数据库数据结构大数据flinkjava分布式

子类优先加载Flink默认采用了子优先(Child-First)的类加载策略来加载用户代码,以解决潜在的依赖冲突问题。我们可以通过源码来证明这一点。ChildFirstClassLoader的实现Flink中负责实现“子优先”加载逻辑的核心类是ChildFirstClassLoader。其关键的loadClassWithoutExceptionHandling方法定义了类加载的顺序。//...ex

- Flink window 源码分析4:WindowState

北_鱼

Flinkflink大数据bigdata

Flinkwindow源码分析1:窗口整体执行流程Flinkwindow源码分析2:Window的主要组件Flinkwindow源码分析3:WindowOperatorFlinkwindow源码分析4:WindowState本文分析的源码为flink1.18.0_scala2.12版本。reduce、aggregate等函数中怎么使用WindowState?主要考虑reduce、aggregate

- 链表也能整容?聊聊‘重排链表’的那些小技巧与深层逻辑

Echo_Wish

LeetCode极客营链表数据结构

“链表也能整容?聊聊‘重排链表’的那些小技巧与深层逻辑”今天我们不聊大数据,不聊AI,咱回归算法的“原点”——链表。别看它简单,里面的很多技巧在面试、在工程开发里都能救你一命。今天我就带你聊聊重排链表(ReorderList),以及它背后的思路和一些值得深挖的细节。1.先说说“重排链表”到底是啥?简单来说:给你一个单链表,比如:1->2->3->4->5要求你把它重新排列成:1->5->2->4-

- 朋友圈点赞也能造假?社交媒体数据欺诈识别的那些事

“朋友圈点赞也能造假?社交媒体数据欺诈识别的那些事”咱们先聊个现实点的:你刷朋友圈、微博、抖音的时候,有没有发现一些账号的点赞数、评论数特别整齐划一?要么都是那种无意义的“支持”“666”,要么一夜之间视频播放量暴涨,看着就不太对劲。其实,这背后很可能就是数据欺诈,而且这种现象在社交媒体上特别常见。作为一个做大数据分析的人,我最直观的感受就是:社交媒体上的数据从来不是完全干净的,里面水分多得很。如

- 好用的酒店预订软件有哪些?酒店预订哪个软件便宜

好项目高省

哪个酒店预订App更省钱?想要预订酒店却担心价格过高?试试这些超值的酒店预订App吧!【美团】:专注于三四线城市,性价比超高!经济型酒店最受欢迎,但用户忠诚度稍低。【飞猪】:阿里旗下平台,依托强大系统和大数据。受年轻人喜爱,但产品同质化较突出,需注意商家管控和用户纠纷解决。要领取优惠券,我们需要使用APP或者登录官方网站。在进入APP后,我们可以通过以下几种途径来获取内部优惠券。一、直返直返的口号

- 大数据量查询计算引发数据库CPU告警问题复盘

懒虫虫~

业务解决方案大表治理

大数据量查询计算引发数据库CPU告警问题复盘一、背景二、根因分析三、解决方案方案1:多线程+缓存方案2:利用中间表+缓存四、总结一、背景2025年7月份某天,CDP系统每天不定时推送我们的Portal服务,生产环境运营看板会展示统计数据,发现接口响应缓慢,随之而来数据库监控告警,发现数据库CPU达到了80%。由于表数据量大,计算统计复杂,多线程使用不当,导致数据库服务器爆表。其中A表数据量达到1亿

- Elasticsearch-索引原理

ouyang+

最近在参与一个基于Elasticsearch作为底层数据框架提供大数据量(亿级)的实时统计查询的方案设计工作,花了些时间学习Elasticsearch的基础理论知识,整理了一下,希望能对Elasticsearch感兴趣/想了解的同学有所帮助。同时也希望有发现内容不正确或者有疑问的地方,望指明,一起探讨,学习,进步。介绍Elasticsearch是一个分布式可扩展的实时搜索和分析引擎,一个建立在全文

- 结婚纪念日是婚礼当天还是领证那天??

壹刻所闻

领证日子和结婚日子大部分都是分开的,所以很多新人弄清楚结婚纪念日是需要过领证那天还是举办婚礼那天。两个日子都会有人过,不过根据大数据显示,大部分的人选择的是举办婚礼的日子。一、结婚纪念日按领证还是婚礼1、领证结婚证纪念日是按领结婚证的那一天算的。只有领了结婚证,两人才是合法夫妻关系,才能受法律保护。而举办婚礼只不过是告诉双方的亲友两人结婚了,邀请双方的亲友一起吃了顿饭罢了,不具备法律效应。如果只是

- Flink实战(七十):监控(二)搭建flink可视化监控 Pushgateway+ Prometheus + Grafana (windows )

王知无(import_bigdata)

Flink系统性学习专栏flink大数据

1Flink的配置:在flink配置⽂件flink-conf.yaml中添加:metrics.reporter.promgateway.class:org.apache.flink.metrics.prometheus.PrometheusPushGatewayReportermetrics.reporter.promgateway.host:localhost#promgateway主要是Pus

- JDBC时间类型与Java类型、Flink SQL时间类型与Java类型的对应关系

哈哈很哈哈

javaflinksql

一、JDBC时间类型与Java类型的对应关系JDBC类型Java类型说明TIMESTAMPjava.sql.Timestamp表示日期和时间(含毫秒)DATEjava.sql.Date仅表示日期(不含时间)TIMEjava.sql.Time仅表示时间(不含日期)说明:java.sql.Timestamp继承自java.util.Date,可精确到纳秒(实际常用毫秒)。java.sql.Date和j

- Spring中@Value注解,需要注意的地方

无量

springbean@Valuexml

Spring 3以后,支持@Value注解的方式获取properties文件中的配置值,简化了读取配置文件的复杂操作

1、在applicationContext.xml文件(或引用文件中)中配置properties文件

<bean id="appProperty"

class="org.springframework.beans.fac

- mongoDB 分片

开窍的石头

mongodb

mongoDB的分片。要mongos查询数据时候 先查询configsvr看数据在那台shard上,configsvr上边放的是metar信息,指的是那条数据在那个片上。由此可以看出mongo在做分片的时候咱们至少要有一个configsvr,和两个以上的shard(片)信息。

第一步启动两台以上的mongo服务

&nb

- OVER(PARTITION BY)函数用法

0624chenhong

oracle

这篇写得很好,引自

http://www.cnblogs.com/lanzi/archive/2010/10/26/1861338.html

OVER(PARTITION BY)函数用法

2010年10月26日

OVER(PARTITION BY)函数介绍

开窗函数 &nb

- Android开发中,ADB server didn't ACK 解决方法

一炮送你回车库

Android开发

首先通知:凡是安装360、豌豆荚、腾讯管家的全部卸载,然后再尝试。

一直没搞明白这个问题咋出现的,但今天看到一个方法,搞定了!原来是豌豆荚占用了 5037 端口导致。

参见原文章:一个豌豆荚引发的血案——关于ADB server didn't ACK的问题

简单来讲,首先将Windows任务进程中的豌豆荚干掉,如果还是不行,再继续按下列步骤排查。

&nb

- canvas中的像素绘制问题

换个号韩国红果果

JavaScriptcanvas

pixl的绘制,1.如果绘制点正处于相邻像素交叉线,绘制x像素的线宽,则从交叉线分别向前向后绘制x/2个像素,如果x/2是整数,则刚好填满x个像素,如果是小数,则先把整数格填满,再去绘制剩下的小数部分,绘制时,是将小数部分的颜色用来除以一个像素的宽度,颜色会变淡。所以要用整数坐标来画的话(即绘制点正处于相邻像素交叉线时),线宽必须是2的整数倍。否则会出现不饱满的像素。

2.如果绘制点为一个像素的

- 编码乱码问题

灵静志远

javajvmjsp编码

1、JVM中单个字符占用的字节长度跟编码方式有关,而默认编码方式又跟平台是一一对应的或说平台决定了默认字符编码方式;2、对于单个字符:ISO-8859-1单字节编码,GBK双字节编码,UTF-8三字节编码;因此中文平台(中文平台默认字符集编码GBK)下一个中文字符占2个字节,而英文平台(英文平台默认字符集编码Cp1252(类似于ISO-8859-1))。

3、getBytes()、getByte

- java 求几个月后的日期

darkranger

calendargetinstance

Date plandate = planDate.toDate();

SimpleDateFormat df = new SimpleDateFormat("yyyy-MM-dd");

Calendar cal = Calendar.getInstance();

cal.setTime(plandate);

// 取得三个月后时间

cal.add(Calendar.M

- 数据库设计的三大范式(通俗易懂)

aijuans

数据库复习

关系数据库中的关系必须满足一定的要求。满足不同程度要求的为不同范式。数据库的设计范式是数据库设计所需要满足的规范。只有理解数据库的设计范式,才能设计出高效率、优雅的数据库,否则可能会设计出错误的数据库.

目前,主要有六种范式:第一范式、第二范式、第三范式、BC范式、第四范式和第五范式。满足最低要求的叫第一范式,简称1NF。在第一范式基础上进一步满足一些要求的为第二范式,简称2NF。其余依此类推。

- 想学工作流怎么入手

atongyeye

jbpm

工作流在工作中变得越来越重要,很多朋友想学工作流却不知如何入手。 很多朋友习惯性的这看一点,那了解一点,既不系统,也容易半途而废。好比学武功,最好的办法是有一本武功秘籍。研究明白,则犹如打通任督二脉。

系统学习工作流,很重要的一本书《JBPM工作流开发指南》。

本人苦苦学习两个月,基本上可以解决大部分流程问题。整理一下学习思路,有兴趣的朋友可以参考下。

1 首先要

- Context和SQLiteOpenHelper创建数据库

百合不是茶

androidContext创建数据库

一直以为安卓数据库的创建就是使用SQLiteOpenHelper创建,但是最近在android的一本书上看到了Context也可以创建数据库,下面我们一起分析这两种方式创建数据库的方式和区别,重点在SQLiteOpenHelper

一:SQLiteOpenHelper创建数据库:

1,SQLi

- 浅谈group by和distinct

bijian1013

oracle数据库group bydistinct

group by和distinct只了去重意义一样,但是group by应用范围更广泛些,如分组汇总或者从聚合函数里筛选数据等。

譬如:统计每id数并且只显示数大于3

select id ,count(id) from ta

- vi opertion

征客丶

macoprationvi

进入 command mode (命令行模式)

按 esc 键

再按 shift + 冒号

注:以下命令中 带 $ 【在命令行模式下进行】,不带 $ 【在非命令行模式下进行】

一、文件操作

1.1、强制退出不保存

$ q!

1.2、保存

$ w

1.3、保存并退出

$ wq

1.4、刷新或重新加载已打开的文件

$ e

二、光标移动

2.1、跳到指定行

数字

- 【Spark十四】深入Spark RDD第三部分RDD基本API

bit1129

spark

对于K/V类型的RDD,如下操作是什么含义?

val rdd = sc.parallelize(List(("A",3),("C",6),("A",1),("B",5))

rdd.reduceByKey(_+_).collect

reduceByKey在这里的操作,是把

- java类加载机制

BlueSkator

java虚拟机

java类加载机制

1.java类加载器的树状结构

引导类加载器

^

|

扩展类加载器

^

|

系统类加载器

java使用代理模式来完成类加载,java的类加载器也有类似于继承的关系,引导类是最顶层的加载器,它是所有类的根加载器,它负责加载java核心库。当一个类加载器接到装载类到虚拟机的请求时,通常会代理给父类加载器,若已经是根加载器了,就自己完成加载。

虚拟机区分一个Cla

- 动态添加文本框

BreakingBad

文本框

<script> var num=1; function AddInput() { var str=""; str+="<input

- 读《研磨设计模式》-代码笔记-单例模式

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

public class Singleton {

}

/*

* 懒汉模式。注意,getInstance如果在多线程环境中调用,需要加上synchronized,否则存在线程不安全问题

*/

class LazySingleton

- iOS应用打包发布常见问题

chenhbc

iosiOS发布iOS上传iOS打包

这个月公司安排我一个人做iOS客户端开发,由于急着用,我先发布一个版本,由于第一次发布iOS应用,期间出了不少问题,记录于此。

1、使用Application Loader 发布时报错:Communication error.please use diagnostic mode to check connectivity.you need to have outbound acc

- 工作流复杂拓扑结构处理新思路

comsci

设计模式工作算法企业应用OO

我们走的设计路线和国外的产品不太一样,不一样在哪里呢? 国外的流程的设计思路是通过事先定义一整套规则(类似XPDL)来约束和控制流程图的复杂度(我对国外的产品了解不够多,仅仅是在有限的了解程度上面提出这样的看法),从而避免在流程引擎中处理这些复杂的图的问题,而我们却没有通过事先定义这样的复杂的规则来约束和降低用户自定义流程图的灵活性,这样一来,在引擎和流程流转控制这一个层面就会遇到很

- oracle 11g新特性Flashback data archive

daizj

oracle

1. 什么是flashback data archive

Flashback data archive是oracle 11g中引入的一个新特性。Flashback archive是一个新的数据库对象,用于存储一个或多表的历史数据。Flashback archive是一个逻辑对象,概念上类似于表空间。实际上flashback archive可以看作是存储一个或多个表的所有事务变化的逻辑空间。

- 多叉树:2-3-4树

dieslrae

树

平衡树多叉树,每个节点最多有4个子节点和3个数据项,2,3,4的含义是指一个节点可能含有的子节点的个数,效率比红黑树稍差.一般不允许出现重复关键字值.2-3-4树有以下特征:

1、有一个数据项的节点总是有2个子节点(称为2-节点)

2、有两个数据项的节点总是有3个子节点(称为3-节

- C语言学习七动态分配 malloc的使用

dcj3sjt126com

clanguagemalloc

/*

2013年3月15日15:16:24

malloc 就memory(内存) allocate(分配)的缩写

本程序没有实际含义,只是理解使用

*/

# include <stdio.h>

# include <malloc.h>

int main(void)

{

int i = 5; //分配了4个字节 静态分配

int * p

- Objective-C编码规范[译]

dcj3sjt126com

代码规范

原文链接 : The official raywenderlich.com Objective-C style guide

原文作者 : raywenderlich.com Team

译文出自 : raywenderlich.com Objective-C编码规范

译者 : Sam Lau

- 0.性能优化-目录

frank1234

性能优化

从今天开始笔者陆续发表一些性能测试相关的文章,主要是对自己前段时间学习的总结,由于水平有限,性能测试领域很深,本人理解的也比较浅,欢迎各位大咖批评指正。

主要内容包括:

一、性能测试指标

吞吐量、TPS、响应时间、负载、可扩展性、PV、思考时间

http://frank1234.iteye.com/blog/2180305

二、性能测试策略

生产环境相同 基准测试 预热等

htt

- Java父类取得子类传递的泛型参数Class类型

happyqing

java泛型父类子类Class

import java.lang.reflect.ParameterizedType;

import java.lang.reflect.Type;

import org.junit.Test;

abstract class BaseDao<T> {

public void getType() {

//Class<E> clazz =

- 跟我学SpringMVC目录汇总贴、PDF下载、源码下载

jinnianshilongnian

springMVC

----广告--------------------------------------------------------------

网站核心商详页开发

掌握Java技术,掌握并发/异步工具使用,熟悉spring、ibatis框架;

掌握数据库技术,表设计和索引优化,分库分表/读写分离;

了解缓存技术,熟练使用如Redis/Memcached等主流技术;

了解Ngin

- the HTTP rewrite module requires the PCRE library

流浪鱼

rewrite

./configure: error: the HTTP rewrite module requires the PCRE library.

模块依赖性Nginx需要依赖下面3个包

1. gzip 模块需要 zlib 库 ( 下载: http://www.zlib.net/ )

2. rewrite 模块需要 pcre 库 ( 下载: http://www.pcre.org/ )

3. s

- 第12章 Ajax(中)

onestopweb

Ajax

index.html

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd">

<html xmlns="http://www.w3.org/

- Optimize query with Query Stripping in Web Intelligence

blueoxygen

BO

http://wiki.sdn.sap.com/wiki/display/BOBJ/Optimize+query+with+Query+Stripping+in+Web+Intelligence

and a very straightfoward video

http://www.sdn.sap.com/irj/scn/events?rid=/library/uuid/40ec3a0c-936

- Java开发者写SQL时常犯的10个错误

tomcat_oracle

javasql

1、不用PreparedStatements 有意思的是,在JDBC出现了许多年后的今天,这个错误依然出现在博客、论坛和邮件列表中,即便要记住和理解它是一件很简单的事。开发者不使用PreparedStatements的原因可能有如下几个: 他们对PreparedStatements不了解 他们认为使用PreparedStatements太慢了 他们认为写Prepar

- 世纪互联与结盟有感

阿尔萨斯

10月10日,世纪互联与(Foxcon)签约成立合资公司,有感。

全球电子制造业巨头(全球500强企业)与世纪互联共同看好IDC、云计算等业务在中国的增长空间,双方迅速果断出手,在资本层面上达成合作,此举体现了全球电子制造业巨头对世纪互联IDC业务的欣赏与信任,另一方面反映出世纪互联目前良好的运营状况与广阔的发展前景。

众所周知,精于电子产品制造(世界第一),对于世纪互联而言,能够与结盟