HBase集群部署

前提条件

安装hbse的前提条件是jdk已经搭建完成,虚拟机具有Hadoop伪分布式或完全分布式的集群搭建,以及zookeeper环境搭建完成。

HBase安装

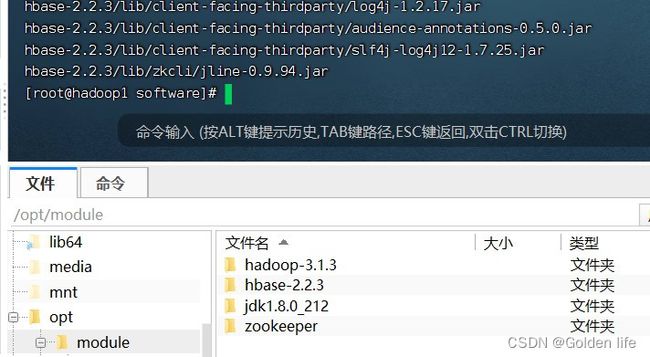

在虚拟机上上传已经下载好的HBase安装包(官网下载需要的版本,我这里是2.2.3),使用finalshell上传至虚拟机的目录下,我这里是/opt/software文件夹下

使用tar命令 参数:-xvzf 解压时注意压缩包的名字 及指定目录自己要记清楚,

[root@hadoop1 software]# tar -xvzf hbase-2.2.3-bin.tar.gz -C /opt/module

module里出现hbse文件夹即代表解压成功

修改配置文件

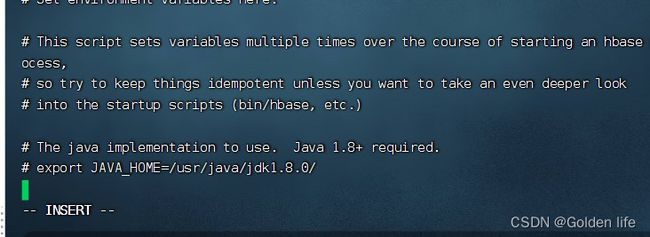

2.1 hbse-env.sh文件

为方便起见我们可以为hbse-2.2.3修改名字

[root@hadoop1 module]# mv hbase-2.2.3/ hbase首先cd到相应目录下,方便于命令的输入,减少错误;也可以直接写路径。

[root@hadoop1 module]# cd /opt/module/hbase/conf

[root@hadoop1 conf]# vi hbase-env.sh

末行添加代码,注意你的jdk的版号及路径和你的对应起来

export JAVA_HOME=/opt/module/jdk1.8.0_212/

export HBASE_MANAGES_ZK=false

2.2 hbase-site.xml文件

[root@hadoop1 conf]#vi hbase-site.xml添加下配置,添加时不要盲目CtrlC CtrlV,根据自身情况修改

hbase.rootdir

hdfs://hadoop1:8020/hbase

hbase.cluster.distributed

true

hbase.zookeeper.quorum

hadoop1,hadoop2,hadoop3

hbase.zookeeper.property.dataDir

/opt/module/zookeeper/data

hbase.unsafe.stream.capability.enforce

false

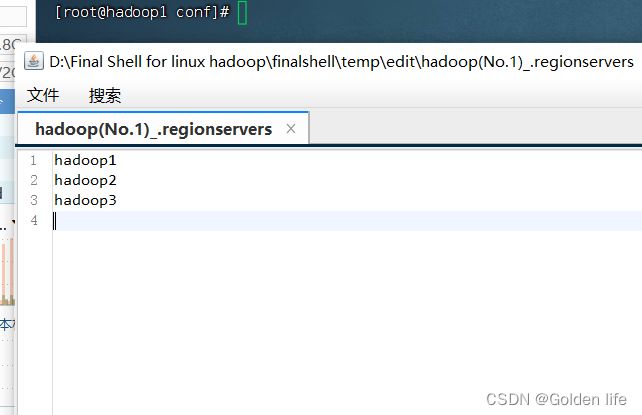

2.3 修改regionserver文件

[root@hadoop1 conf]#vi regionserver 添加三台机器主机名:

2.4配置环境变量

[root@hadoop1 /]# vim /etc/profile.d/my-env.sh添加如下内容

export HBASE_HOME=/opt/module/hbase

#你的hbase解压后存放的路径

export PATH=$PATH:${HBASE_HOME}/bin:${HBASE_HOME}/sbinin

分发环境变量配置文件,可当其他两台机器中查看是否成功

[root@hadoop1 /]#scp -r /etc/profile.d/my-env.sh hadoop2:/etc

[root@hadoop1 /]#scp -r /etc/profile.d/my-env.sh hadoop3:/etc

使环境变量生效

[root@hadoop1 /]# source /etc/profile

2.5复制jar包至lib

[root@hadoop1 /]# cd /opt/module/hbase/lib

[root@hadoop1 lib]# cp client-facing-thirdparty/htrace-core4-4.2.0-incubating.jar /opt/module/hbase/lib/

2.6分发安装包与配置文件

cd /opt/module

[root@hadoop1 module]# scp -r hbase/ hadoop2:/opt/module

[root@hadoop1 module]# scp -r hbase/ hadoop3:/opt/module

分发完成

在其他两台机器上配置加载环境变量

[root@hadoop2 /]# source /etc/profile

[root@hadoop3 /]# source /etc/profile启动HBase

[root@hadoop1 hbase]# start-hbase.sh

在相应目录下依次启动

# 启动ZK zookeeper目录下

bin/start-zkServer.sh

# 启动hadoop

sbin/start-dfs.sh

# 启动hbase hbse目录下

bin/start-hbase.sh