论文笔记(二十)VisuoTactile 6D Pose Estimation of an In-Hand Object using Vision and Tactile Sensor Data

VisuoTactile 6D Pose Estimation of an In-Hand Object using Vision and Tactile Sensor Data

- 文章概括

- 摘要

- 1. 介绍

- 2. 背景

- 3. 网络结构

-

- A. 视觉触觉传感器融合

- B. 姿势估计器

- C. 损失函数

- 4. 数据集的生成

-

- A. 触觉传感器不变的姿态估计

- B. 数据收集设置

- C. 数据集特征

- 5. 实验

-

- A. 网络训练设置

- B. 硬件部署

- 6. 结果

-

- A. 量化评估

- B. 定性评价

- C. 消融研究

- D. 与最新技术水平的比较

- 7. 结论和未来工作

文章概括

作者:Snehal Dikhale,Karankumar Patel,Daksh Dhingra,Itoshi Naramura,Akinobu Hayashi,Soshi Iba and Nawid Jamali

来源:IEEE ROBOTICS AND AUTOMATION LETTERS. PREPRINT VERSION. ACCEPTED JANUARY, 2022

原文:https://ieeexplore.ieee.org/abstract/document/9682507

代码、数据和视频:

系列文章目录:

上一篇:

论文笔记(十九)RGB-D Object Tracking: A Particle Filter Approach on GPU

下一篇:

摘要

对一个物体的6D姿势的了解可以使手部物体的操作受益。现有的6D姿势估计方法使用视觉数据。由于机器人抓手产生的严重遮挡,手部6D物体姿势估计具有挑战性,这对仅依赖视觉数据的方法会产生不利影响。许多机器人的指尖都配备了触觉传感器,可以用来补充视觉数据。在本文中,我们提出了一种方法,使用触觉和视觉数据来估计机器人手中抓取的物体的姿势。 这项研究的主要挑战包括:1)缺乏触觉传感器数据的标准表示;2)融合来自异质来源的传感器数据–视觉和触觉;3)需要大量的训练数据集。为了应对这些挑战,首先,我们建议使用点云来表示与触觉传感器接触的物体表面。 第二,我们提出了一个基于像素级密集融合的网络架构,以融合视觉和触觉数据来估计物体的6D姿势。第三,我们扩展了英伟达的深度学习数据集合成器,为虚幻引擎4中的YCB物体和模型集的11个物体产生了合成的照片般真实的视觉数据和相应的触觉点云。

我们提出了模拟实验的结果,表明除了视觉数据外,使用触觉数据可以提高对在手物体的6D姿势估计。我们还提出了一些定性的实验结果,在这些实验中,我们将我们的网络部署在真实的物理机器人上,显示了在合成数据上训练的网络成功地转移到了真实的系统上。

索引词-抓取和操纵的感知,抓取和操纵的深度学习,力和触觉感知

1. 介绍

准确估计物体的6D位置–3D旋转和3D平移–可用于操纵和抓取、规划等任务,以及虚拟现实应用中。 姿势估计的最新研究将深度学习应用于彩色和深度图像,以估计物体的6D姿势[1], [2], [3]。 彩色图像可以很好地捕捉纹理[3],而深度数据带有几何信息,在不同的照明条件下可以提高预测的准确性[1]。

大部分关于6D姿势估计的研究都集中在被其他物体部分遮挡的场景中[3], [2], [1]。 然而,在手物体的6D姿势很少受到关注[4]。手中物体姿势估计的挑战包括由机器人的抓手和环境中的其他物体造成的严重遮挡。在这种情况下,机器人可以利用其触觉传感器的优势来改善其估计。此外,触觉数据可以捕捉到被物体本身遮挡的表面几何形状[5]。在本文中,我们提出了一种融合触觉数据和视觉数据的方法,以估计机器人手中抓取的物体的6D姿势。我们假设,同时使用触觉和视觉数据将比单独使用视觉数据更有优势。

图1是对所提方法的说明。我们模型的输入是来自摄像头的彩色和深度图像,以及点云形式的触觉接触点。我们使用Wang等人[1]提出的像素级密集融合来结合传感器数据。为了使视觉和触觉等异质传感器数据进行有意义的融合,网络被分为两个通道:视觉通道和触觉通道。在视觉通道中,来自彩色图像的特征和来自深度图像的点云在像素级被融合。在触觉通道中,来自深度图像的点云特征和来自触觉传感器的物体表面点云特征在点水平上被融合。这种融合背后的直觉是,颜色和深度图像是相关的。同样地,来自触觉传感器的物体表面点云和来自深度图像的点云也是相关的。因此,来自深度图像的点云连接了彩色图像和触觉传感器的数据,说明了被机器人的抓手遮挡的部分。

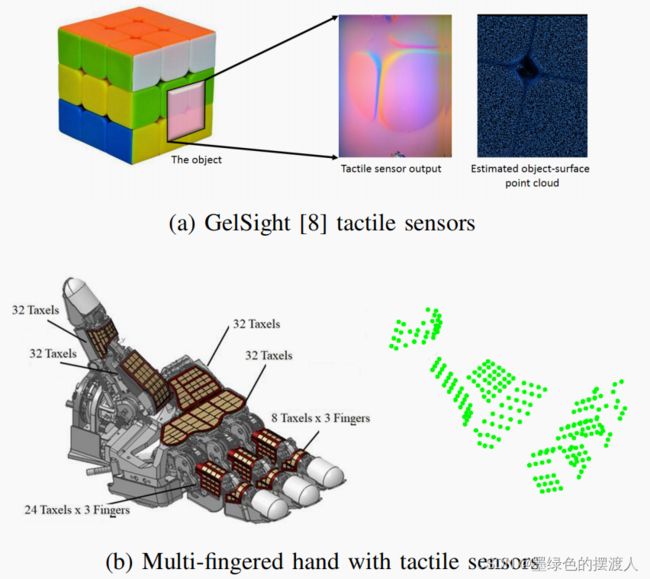

由于机器人的磨损,收集机器人操作的训练数据很耗时,而且成本过高。一种方法是使用合成数据来训练一个模型。来自视觉传感器的合成数据已经成功地应用于抓取问题[6]和6D姿势估计[2]。然而,对包括触觉数据在内的操纵的合成数据生成的探索较少。与视觉传感器不同,触觉传感器的开发程度较低[7]。 对于触觉数据没有标准的表示格式。表示方法取决于底层的转导方法,例如,基于光学的触觉传感器输出RBG图像[8],而其他传感器可能有随机分布[9]。因此,在本文中,我们提出了一种适合于生成合成触觉传感器数据的6D姿势估计的表示格式。我们将触觉数据表示为手指与物体接触位置的物体-表面点云。 我们扩展了英伟达的深度学习数据集合成器(NDDS)[10],以生成合成的照片般真实的视觉数据、手指与物体接触位置的相应物体表面点云,以及来自YCB物体和模型集[11]的11个物体的地面真实6D姿势。我们的数据集包含每个物体的20000个例子。本文的贡献包括。1)用触觉传感器的不变表示来捕捉手指与物体的接触面;2)用网络结构来融合视觉和触觉数据,以估计严重遮挡下的在手物体的6D姿势;3)产生适合在手物体6D姿势估计的合成视觉触觉数据集的方法。

我们提出的实验结果表明,我们的模型在拟议的合成视觉触觉数据集上训练后,优于只使用同一数据集的颜色和深度图像训练的基线模型。我们还提出了定性的实验结果,在这些实验中,我们的网络和在合成数据集上训练的基线网络被部署在真实的物理机器人上,并表明该网络可以推广到不同的物理设置。

2. 背景

现有的6D姿势估计文献可以分为三大类:几何匹配[4]、概率方法[12]、[13]、[14]和机器学习方法[15]、[5]。几何方法使用触觉-几何-形状一致性描述符来估计一个物体的姿势[4]。这些技术存在运行时间慢的问题。概率方法使用粒子过滤器[12]、SLAM[13]和蒙特卡洛方法来估计物体的姿势。这些都是成熟的方法,但是,它们可能需要与物体进行多次接触,也可能存在运行时间慢的问题[16]。

最近,用于6D姿势估计的深度学习方法已经显示出有希望的结果。不同方法之间的一个区别因素是网络的输入。Xiang等人[3]提出了一个新的网络,PoseCNN,来估计物体的6D姿势。PoseCNN使用RGB图像来获得6D姿势的初始估计。之后,深度传感器数据被用来使用迭代最接近点(ICP)算法来改进物体姿势的初始估计。

与PoseCNN类似,Tremblay等人[2]使用一个在RGB图像上训练的CNN来获得物体的6D姿势估计。作者使用合成数据集来训练他们的网络。为了弥补模拟与现实之间的差距,作者开发了一种独特的方法,使用领域随机图像和照片真实数据的组合来训练CNN。作者提出的结果表明,在合成数据集上训练的网络可以在YCB-视频数据集上泛化到优于最先进的水平。

Wang等人[1]提出了一种同时使用RGB图像和深度数据来估计物体的6D姿势的方法。作者提出了一种新的方法来融合RGB和深度数据。这些数据不是全局水平的,而是使用像素级的融合。使用像素级融合的好处是,它允许对物体的可见部分进行网络训练,将遮挡的影响降到最低。

大多数关于6D姿势估计的文献,都没有使用触觉数据。最近,Bauza等人[17]提出了一种使用触觉传感器的姿势估计方法。与Bimbo等人[18]类似,作者使用触觉数据来估计接触点上物体的局部形状。然后,对局部形状的估计与一组模拟接触进行排序,找到产生接触面的可能物体姿势的概率分布。

Watkins等人[5]提出了一个框架来确定未知物体的几何形状。在这个框架中,深度和触觉数据被用作CNN的输入以估计物体的形状。作者证明了增加触觉数据可以提高估计形状的准确性。

文献在形状和姿态估计方面取得了重大进展。Watkins等人[5]的研究表明,使用触觉数据可以显著提高闭塞物体的形状估计精度,但是,他们没有考虑对物体的姿势进行估计。大多数最先进的6D姿势估计算法要么使用RGB数据,要么同时使用RGB和深度数据,但都没有利用触觉数据,这使得它们不适合于机器人的抓手存在严重自我遮挡的手部物体操作。本文提出的工作旨在解决手部物体操纵的6D姿势估计问题。

3. 网络结构

在这一节中,我们提出了一种方法来估计机器人所抓取的已知物体的6D姿势。我们模型的输入是来自摄像机的彩色和深度图像,以及物体表面点云形式的触觉接触点。我们网络的输出是物体在摄像机坐标框架中的6维姿势。

A. 视觉触觉传感器融合

图2说明了我们网络的整体结构。如第一节所述,颜色、深度和触觉输入是以保持特征之间的对应关系的方式融合的。传感器的融合被分为两个通道:视觉通道和触觉通道。

- 视觉通道:视觉通道的输入包括来自摄像机的彩色和深度图像。首先,对彩色图像进行语义物体分割,以分割感兴趣的物体。在语义分割中,每个像素都与一个物体类别相关。在我们的实验中,我们采用了Xian等人[3]提出的方法,该方法使用编码器-解码器结构。

深度图像使用物体的语义分割进行屏蔽,并转换为摄像机坐标中的三维点云。也就是说,对于彩色图像中可见的每个物体像素,我们都会在摄像机的坐标框架中关联到该物体的相应三维位置。

在下一步,彩色图像被语义分割的边界盒裁剪。然后将裁剪后的图像送入卷积神经网络(CNN),该网络处理彩色图像并将裁剪后的图像中的每个像素映射到颜色特征嵌入。由于颜色嵌入是针对整个剪裁后的图像,来自语义分割的掩码被用来只保留 n n n个随机嵌入和它们相应的3D点。这确保了后续网络只考虑物体上的点。在我们的实验中, n n n被设定为1000。

颜色嵌入和深度嵌入,各经过一个两阶段的CNN。色彩嵌入CNN和深度嵌入CNN的输出通过像素密集融合进行融合。

- 触觉通道:触觉通道的输入包括来自摄像机深度图像的点云和来自触觉传感器的物体表面点云。来自所有手指的触觉数据被作为一个单一的三维点云呈现给网络。这种选择使我们能够使网络不受机器人可能有的手指数量的影响,也就是说,使它不受抓手的影响。与视觉通道类似,我们只保留 n n n个随机点。然后,触觉数据通过一个两阶段的CNN来产生触觉嵌入。触觉嵌入和深度嵌入使用逐点的密集融合进行融合。

3)全局特征:为了给网络提供一个全局背景,我们还通过融合颜色、深度和触觉嵌入来生成一个全局特征,然后是一个CNN和一个平均汇集层。

B. 姿势估计器

上一节中融合的传感器数据被输入到姿势估计器,即来自视觉通道的RGB深度特征、来自触觉通道的触觉深度特征和全局特征。图3显示了姿势估计器的网络结构。该网络为视觉通道和触觉通道的每个特征估计一个平移向量、一个旋转向量和一个置信度,分别用蓝色和绿色表示。为了估计平移矢量,将RGB深度特征、触觉深度特征和全局特征输入视觉通道CNN(蓝色)和触觉通道CNN(绿色)。为了估计旋转矢量,将触觉深度特征与全局特征结合起来送入触觉通道CNN,而将RGB深度特征与全局特征结合起来送入视觉通道CNN的连体网络结构,其中两个网络共享权重。通过触觉通道CNN将触觉深度特征与全局特征相结合来估计置信度,而将RGB深度特征与全局特征相结合则输入视觉通道CNN。在我们的实验中,视觉和触觉通道分别输出1000个姿势估计值和相关的信心水平。由于这些点是随机选择的,根据位置和RGB颜色的不同,它们的姿势估计的准确性也不同。通过学习置信度,网络根据信息量最大的特征点来选择姿势估计。因此,具有最大置信度的6D姿势被选中。

C. 损失函数

我们使用(3)中的损失函数来训练我们的网络。如上一节所述,对于输入 N N N中的每个点 i i i,网络估计了一个翻译矢量 T ^ i \hat{T}_i T^i、一个旋转矢量 R ^ i \hat{R}_i R^i和一个置信度 C i C_i Ci。考虑到有 M M M个点的物体模型,通过用估计的姿势 p ^ = [ R ^ i , T ^ i ] \hat{p} = [ \hat{R}_i, \hat{T}_i] p^=[R^i,T^i]来转换模型点,并与在(1)中定义的用地面真实姿势 p = [ R , T ] p = [R, T] p=[R,T]转换的相同模型点进行比较,来计算逐点的损失, L i p L^p_i Lip。

从逐点的置信度损失, L i c L^c_i Lic,是估计的置信度 C ^ i \hat{C}_i C^i和预期的置信度 C i e C_i^e Cie之间的差值,还有一个正则化项 w l o g ( C i ) wlog(C_i) wlog(Ci),定义在(2)。正则化项对具有高置信度的点进行惩罚。预期置信度是像素损失的指数函数, C i e = 0. 5 L i p C_i^e = 0.5^{L^p_i} Cie=0.5Lip。网络损失, L L L,定义在(3)中,其中点的损失和置信度损失的总和被添加到所有的点上并取其平均值。

L i p = 1 M ∑ j ∈ M ∣ ∣ ( R x j + t ) − ( R ^ i x j + t ^ i ) ∣ ∣ (1) L^p_i=\frac{1}{M}\sum_{j ∈M}||(Rx_j + t)-(\hat{R}_ix_j+\hat{t}_i)|| \tag{1} Lip=M1j∈M∑∣∣(Rxj+t)−(R^ixj+t^i)∣∣(1)

L i c = ( C ^ i − C i e − ω l o g ( C i ) ) (2) L_i^c=(\hat{C}_i-C^e_i-\omega log(C_i)) \tag{2} Lic=(C^i−Cie−ωlog(Ci))(2)

L = 1 N ∑ i ∈ N ( L i p + L i c ) (3) L=\frac{1}{N}\sum_{i∈N}(L^p_i+L^c_i) \tag{3} L=N1i∈N∑(Lip+Lic)(3)

4. 数据集的生成

在这一节中,我们将解释我们如何产生触觉数据,然后是数据集的收集设置和特征。

A. 触觉传感器不变的姿态估计

如前所述,触觉传感器的空间分辨率在不同的触觉传感器之间会有很大差异。为了使姿势估计算法不受触觉传感器类型的影响,我们建议将触觉数据以物体-表面点云的形式提交给算法。也就是说,当触觉传感器与物体接触时,我们从触觉传感器数据中估计出与触觉传感器接触的物体表面。前向运动学可以用来获得每个分类单元与物体接触的三维位置。图4显示了对于一个基于光学的触觉传感器和一个基于压力的触觉传感器是如何实现的。除了传感器外,这种表示方法还使网络对所使用的抓手类型不发生变化。

B. 数据收集设置

我们采用了Tremblay等人[10]提出的方法,该方法使用虚幻引擎4来产生照片般真实的模拟数据。我们扩展了作者开发的插件,以生成触觉点云以及颜色和深度数据。

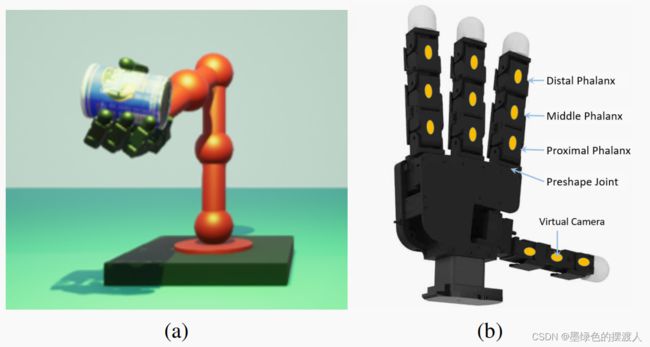

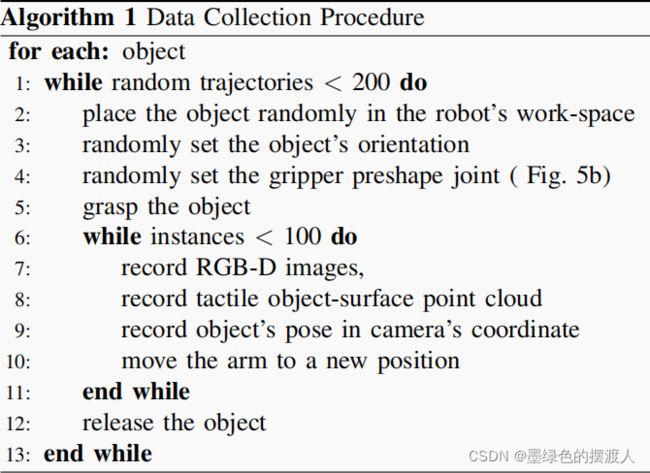

仿真环境包括一个主摄像头,以及一个带有四指抓手(Allegro Hand)的6DoF机械臂,并配备了触觉传感器。如图5b所示,我们在抓手的每个指骨上安装了一个虚拟摄像机。每个虚拟摄像机的原点都在各自指骨的表面,Z轴指向手指外面。当抓手与物体接触时,这些虚拟摄像机捕捉物体的表面点云。主摄像头被放置在机器人的前面,它生成彩色和深度图像。数据集是由算法1中描述的程序生成的。

C. 数据集特征

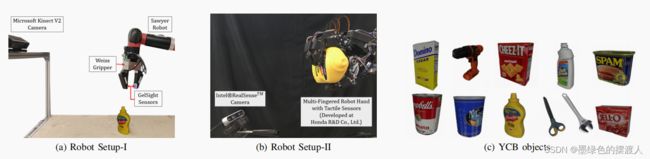

我们根据可抓取性和3D模型的质量,选择了图6c所示的11个YCB物体[11]。该数据集由每个物体的20000个样本组成,每个样本由放置在机器人抓手每个指骨上的12个虚拟触觉相机(图5b)的深度图像和主相机的RGB-D图像组成。放在手指上的相机的高度与深度分辨率为32x32,与触觉传感器的形状成正比。主摄像头捕捉到整个场景的640x480的图像。

为了给我们的数据集提供足够的变化以提高网络泛化,收集的数据集包括领域随机化的样本。20%的数据集由没有应用域随机化的样本组成。剩下的80%由领域随机化的样本组成。我们使用英伟达深度学习数据集合成器的虚幻引擎4的领域随机化插件来随机化背景、地板表面,添加一个位置随机化的聚光灯和一个颜色,如图5a所示。

5. 实验

该网络在第四节所述的数据集上进行训练。

A. 网络训练设置

数据集被分成4:1的比例,训练集由16000个样本组成,测试集由每个对象的4000个样本组成。网络被训练了1500个epochs,批次大小为16。网络的学习率, l r lr lr,被设定为0.0002。(2)中的超参数 w w w被设置为0.015。该网络使用PyTorch的Adam优化器进行训练。

B. 硬件部署

我们在两个不同的设置上部署了我们的网络,使用不同的抓手和触觉传感器。第一个设置(Setup-I)包括一个Weiss机械手和两个连接在Sawyer机器人上的Gelsight触觉传感器。一个Kinect2 RGB-D摄像头安装在距离机器人底座4米的地方,以45度角面向工作空间(见图6a)。工作空间里安装了OptiTrack运动捕捉系统,以记录感兴趣的物体的地面真实6D姿态。

第二个设置(设置-II),如图6b所示,包括一个Intel®RealSenseTM摄像头和一个由本田研发有限公司开发的多指机器人手,如图4b所示。如图4b所示。它有4个手指,16个关节(11个被驱动)。它还配备了224个税号的触觉传感器套件。

该网络被部署在一台装有NVIDIA Quadro RTX 6000的工作站上。仅仅我们的网络的推理时间是10.1毫秒,而且,整个管道,包括语义分割网络和ROS的开销,需要109.5毫秒。

6. 结果

为了验证我们的假设,即同时使用触觉和视觉数据可以改善物体的6维姿势,我们提出了实验结果,将我们的方法与单独使用视觉数据来估计物体6维姿势的基线方法进行比较。基线方法是通过修改我们的网络来构建的,我们删除了触觉通道,只保留视觉通道。然后我们用同一数据集的彩色和深度图像来训练这个只有视觉的网络。在下一节中,我们将对我们的方法在合成数据集上的表现进行定量分析,然后是对部署在物理机器人上的网络进行定性分析。所有报告的误差,除非另有说明,都是标准误差。

A. 量化评估

为了评估拟议方法的性能,我们使用了两个指标:位置误差和角度误差。位置误差是估计位置 T ^ \hat{T} T^与地面真实位置 T T T之间的欧几里得距离。我们用两个单位四元数之间的角度来表示角度误差[19],如(4)。

θ = cos − 1 ( 2 ⟨ q ^ , q ⟩ 2 − 1 ) (4) \theta = \cos^{-1}(2 \langle \hat{q},q \rangle ^2-1) \tag{4} θ=cos−1(2⟨q^,q⟩2−1)(4)

其中, θ \theta θ是角度误差, q ^ \hat{q} q^是来自网络的估计四元数, q q q是地面真相四元数, ⟨ q ^ , q ⟩ \langle \hat{q},q \rangle ⟨q^,q⟩是两个四元数的内积。

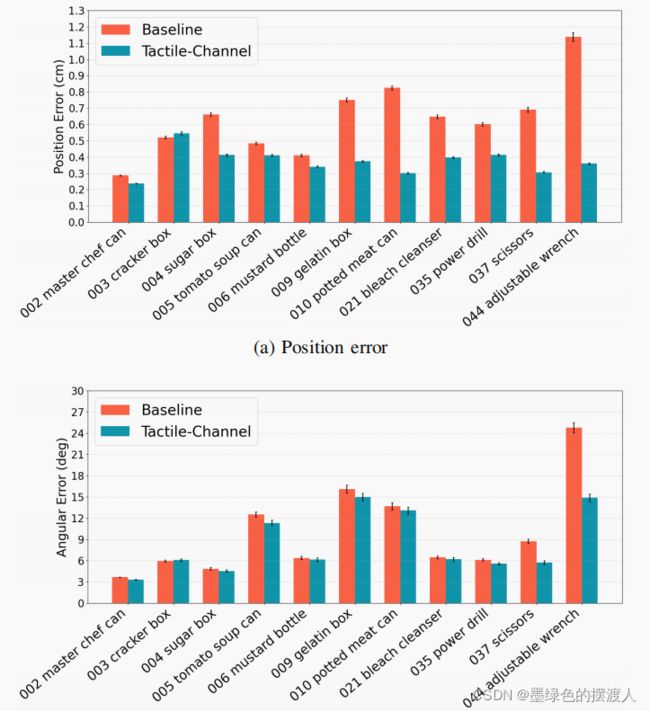

1)位置和角度指标的性能: 图7显示了我们数据集中每个物体的位置误差和角度误差。结果显示,对于所有的物体,除了饼干盒,我们的网络都比基线方法更有统计意义。在一些物体中,例如可调式扳手,我们的方法的位置误差为0.36厘米,而基线方法的位置误差为1.14厘米。与基线相比,其他表现出明显改善的对象包括剪刀、罐头肉和明胶盒。在分析角度数据的结果时,我们注意到可调节扳手和剪刀有明显的改进。我们还注意到,对于角度估计,基线和我们的方法之间的差距并不像位置估计那样明显。这些结果表明,该网络依靠从摄像机图像中获得的颜色特征来推断物体的方向。这可能会导致视觉上密集的物体,如饼干盒,获得高置信度,导致方向估计类似于基线,而位置估计相对不太准确。

2)闭塞程度对性能的影响: 为了分析闭塞程度对网络性能的影响,我们进行了分析,将网络的性能分为三个闭塞程度:80%以下,80%到85%之间,85%以上。给出物体的三维模型作为点云,以及从主摄像机的深度图像中获得的点云,闭塞等级被计算为物体模型中对主摄像机可见的点的百分比。首先,我们将地面实况转换应用于模型,然后,如果使用 K 近邻算法在主相机点云中存在阈值 ϵ \epsilon ϵ内的点,则模型点云中的每个点都被标记为可见。遮蔽程度是指在模型中被标记为不可见的点的百分比。

图8显示了这一分析的结果。我们看到,随着闭塞程度的增加,基线网络的性能明显下降。在严重闭塞的情况下,我们网络的平均位置误差(0.4±0.003厘米)几乎是基线(0.78±0.008厘米)的一半。我们还看到角度误差减少了2.3度,我们的网络和基线的角度误差分别为11.5 ± 0.22度和13.8 ± 0.24度。我们注意到,与我们的网络保持性能的位置误差相比,严重遮挡下的角度误差尽管优于基线,但却遭受了很大的退化。这表明物体的纹理对推断物体的方向很重要。这是预料之中的,例如,在没有任何视觉线索的情况下,推断像芥末瓶这样的物体的背面还是正面是很困难的。事实上,看一下每个物体的角度误差(图7b),我们注意到当触觉数据包括在内时,表现出较大角度性能增益的物体是那些纹理较少的物体,例如,可调节扳手具有均匀的纹理。区分物体的一边和另一边在很大程度上取决于点云数据所捕获的物体的形状。

3)触觉点的数量对性能的影响: 我们进一步分析,研究触觉接触点的数量对性能的影响。我们修改了提议的网络,以接受4、12、36、60、240个触觉接触点。图9显示了这个实验对我们数据集中所有物体的结果。我们还绘制了基线网络的性能作为参考。正如预期的那样,触觉接触点数量的减少会增加位置和角度的误差。结果表明,即使触觉接触点的数量减少,纳入触觉数据也比仅有视觉的基线有改进。

B. 定性评价

在这一节中,我们介绍了在第五节B中描述的硬件设置上同时实时部署我们的网络和基线网络的定性分析。请注意,这些网络只在合成数据集上训练。在部署过程中,我们的网络和基线都得到了相同的输入。随附的视频是本节介绍的结果的可视化。视频中展示的机器人设置-I(图6a)的数据,我们的网络的平均位置和角度误差分别为36.88±1.27度和2.69±0.13厘米,而基线的误差为64.57±1.40度和4.76±0.32厘米。

1)位置和角度指标的性能: 在部署过程中,与基线网络相比,我们的网络表现出稳定的逐帧输出。图10显示了一些例子,在这些例子中,基线(蓝色)网络的估计值与地面实况(白色)姿势有很大偏差,而我们的网络(绿色)能够保持合理的估计。这表明该网络能够使用触觉信息,特别是来自物体背面的手指的信息,以获得对物体6D姿势的更好估计。

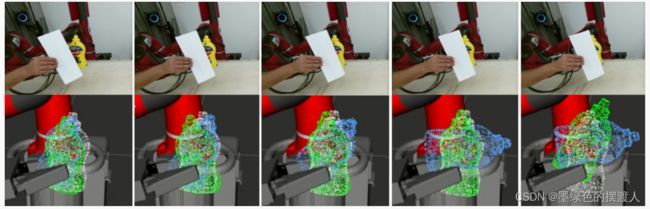

2)遮挡程度对性能的影响: 我们还在真实的硬件设置上做了一个实验,通过用一张纸挡住主摄像头的视线,逐渐增加遮挡程度。图11显示了这个实验的结果,表明与基线网络(蓝色)相比,我们的网络(绿色)可以处理更高层次的遮挡。地面真实姿态显示为白色。结果表明,在严重的闭塞情况下,同时使用触觉和视觉数据的网络比只使用视觉的网络要好。

C. 消融研究

为了评估我们的设计选择对网络性能的影响,我们进行了三项消减研究,以量化来自以下方面的增益:1)连体网络;2)全局特征;3)视觉特征,即通过去除视觉通道并只在触觉数据上进行训练的纯触觉网络。表一显示了所有11个物体的平均网络性能。结果表明,使用连体网络的结果是在位置上增加了0.006厘米,在角度上增加了0.2度的准确性。全局特征带来了0.57厘米的位置增益和3.31度的角度精度增益。视觉数据在位置精度上贡献了1.55厘米的增益,在角度精度上贡献了51.19度的增益,这与我们的观察相一致,即对物体方向的推断取决于RGB图像的颜色特征。

D. 与最新技术水平的比较

为了评估我们的数据集的难度,我们在数据集上训练了PoseCNN[3],一个基于视觉的最先进的6D姿态估计算法。表二显示了这一分析的结果,我们注意到位置估计的性能明显下降,这对于一个只使用RGB图像的方法来说是意料之中的,因为机器人的抓手有严重的遮挡现象。我们还注意到,与我们的方法相比,角度误差增加了4.78度。这些结果表明,我们的数据集提出了一个具有挑战性的姿势估计问题。

7. 结论和未来工作

我们提出了一种新的方法来解决估计在手物体的6D姿势的问题。手部姿势估计的一个挑战是如何补偿物体大部分被遮挡部分的几何信息。在提议的方法中,我们利用了机器人手指上的触觉传感数据,这些数据遮挡了物体。我们提出了一种与传感器无关的表示方法,其中触觉数据由手指-物体接触-表面点云表示。我们引入了一个视觉-触觉网络结构,其中来自视觉和触觉传感器的数据以一种有意义的方式被融合。为了有效地训练我们的模型,我们提出了一个合成数据收集程序,以产生一个适合手部6D姿势估计的大规模视觉触觉数据集。我们提出了实验结果,在实验中我们将我们的方法与仅有的视觉基线进行了比较。我们在合成数据上的结果表明,我们的网络在统计意义上优于仅有视觉的基线,特别是在严重遮挡的情况下。我们还介绍了一项研究的结果,在这项研究中,我们将触觉输入的数量在4到240之间变化。我们的结果表明,虽然估计的准确性有所下降,但即使触觉输入的数量减少到4个,我们的方法也优于基线。此外,我们提出了定性的结果,我们在具有不同硬件设置的真实物理机器人上部署了我们的网络。我们的定性结果表明,仅在合成数据上训练的网络可以成功地转移到现实世界的环境中。

我们的结果表明,虽然估计的准确性有所下降,但即使触觉输入的数量减少到4个,我们的方法也优于基线。此外,我们提出了定性的结果,我们在具有不同硬件设置的真实物理机器人上部署了我们的网络。我们的定性结果表明,仅在合成数据上训练的网络可以成功地转移到现实世界的环境中。一种方法是使用长短期记忆网络等方法,利用时间上的一致性来过滤掉错误的估计。另一个有趣的方向是利用抓手的几何形状和手指的位置来帮助网络过滤掉物理上不可信的姿势估计。我们数据集中的大多数物体至少在一个轴上是对称的。在未来,我们希望扩展我们的数据集,包括3D打印的不对称物体,以评估我们的方法在这类物体上的功效。我们还注意到,我们的方法对环境遮挡的影响是稳健的。在未来,我们希望进行一项研究来测试我们的方法对不同程度的环境遮挡的影响。