深度卷积神经网络

目录

1.AlexNet

2. 代码实现

1.AlexNet

(1)特征提取

(2)选择核函数来计算相关性:怎么判断在高维空间里面两个点是如何相关的,如果是线性模型就是做内积。

(3)凸优化问题

(4)漂亮的定理

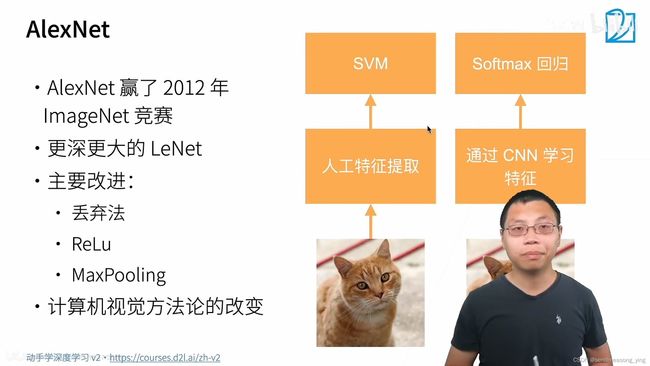

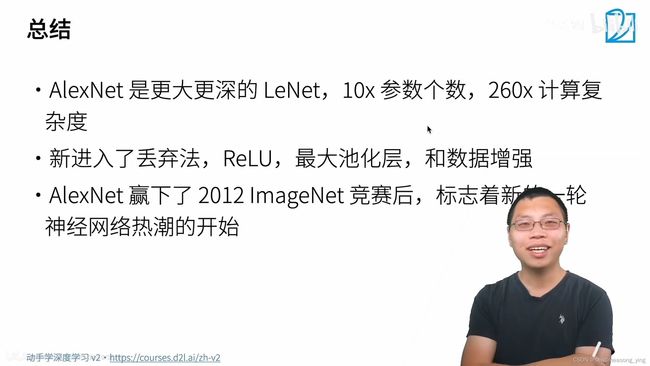

丢弃法的作用就是因为模型太大了,使用它来对模型做正则。Relu相比于sigmoid梯度确实更大,Maxpooling使用的是最大值,因此输出的值比较大,梯度就比较大,训练就更加容易。

输入是224*224,因为是rgb图片所以有3个通道。第二张图LeNet不应该还pad2,因为已经是32了。AlexNet用了更大的核窗口11*11,因为此时的输入尺寸很大了,5*5的窗口看到的就太小了。需要更大的核去看更多的方块。通道数变成了96,因为想在第一个卷积层就识别出更多的模式所以就用了更多的通道数。受限于当时的硬件,必须有一个较大的步幅不然后边的计算就会变得很难所以选择4,2*2的池化层和3*3的主要的区别就是,2*2的允许像素往一边移一点,如果是3*3就表示往左移往右移一步都可以。stride=2把输入的高和宽全都减半。

pad=2(输出:加入输入等于10,10-5+4+1=10),所以此处pad=2的作用就是让输出和输入有同样的大小。256个卷积核就是输出通道有256个,因为想在这一层识别更多的模式,就需要更多的通道。池化层3*3的窗口,步幅等于2,把输入的高和宽减半。接下来新增了3个卷积层,pad=1输入和输出还是一样(假设输入是10,10-3+2+1=10)。最后经过池化层。

以上是全连接层,因为要做关于1000个输出的分类,所以前面的隐藏层要大一点。

ReLu会减缓梯度消失是因为梯度总是比较大,正向梯度总是为1的,而且在零点处一阶导数等于1,所以数值稳定。

flop是计算数

2. 代码实现

import torch

from torch import nn

from d2l import torch as d2l

"""容量控制和预处理"""

net=nn.Sequential(

# 这里使用一个11*11的更大窗口来捕捉对象。

# 同时,步幅为4,以减少输出的高度和宽度。

# 另外,输出通道的数目远大于LeNet

nn.Conv2d(1,96,kernel_size=11,stride=4,padding=2),nn.ReLU(),

#输入通道数1,输出通道数96,因为现在用的数据集是fashion_mnist所以通道数是1,在原来的

#Imagenet上应该通道数等于3。

nn.MaxPool2d(kernel_size=3,stride=2),

# 减小卷积窗口,使用填充为2来使得输入与输出的高和宽一致,且增大输出通道数

nn.Conv2d(96,256,kernel_size=5,padding=2),nn.ReLU(),

nn.MaxPool2d(kernel_size=3,stride=2),

# 使用三个连续的卷积层和较小的卷积窗口。

# 除了最后的卷积层,输出通道的数量进一步增加。

# 在前两个卷积层之后,汇聚层不用于减少输入的高度和宽度

nn.Conv2d(256,384,kernel_size=3,padding=1),nn.ReLU(),

#padding=1使得输入和输出图片的大小不变

nn.Conv2d(384,384,kernel_size=3,padding=1),nn.ReLU(),

nn.Conv2d(384,256,kernel_size=3,padding=1),nn.ReLU(),

nn.MaxPool2d(kernel_size=3,stride=2),

nn.Flatten(),

# 这里,全连接层的输出数量是LeNet中的好几倍。使用dropout层来减轻过拟合

nn.Linear(6400,4096),nn.ReLU(),

nn.dropout(p=0.5),

nn.Linear(4096,4096),nn.ReLU(),

nn.Dropout(p=0.5),

# 最后是输出层。由于这里使用Fashion-MNIST,所以用类别数为10,而非论文中的1000

nn.Linear(4096,10))

#构造一个高度和宽度都为224的单通道数据,来观察每一层输出的形状。

X=torch.randn(1,1,224,224)

for layer in net:

X=layer(X)

print(layer.__class__.__name__,'output shape\t',X.shape)

#直接对类或者对象使用xxx.__class__.__name__ ,首先取到xxx的父类,然后返回他的名字

"""结果输出:

Conv2d output shape: torch.Size([1, 96, 54, 54])

ReLU output shape: torch.Size([1, 96, 54, 54])

MaxPool2d output shape: torch.Size([1, 96, 26, 26])

Conv2d output shape: torch.Size([1, 256, 26, 26])

ReLU output shape: torch.Size([1, 256, 26, 26])

MaxPool2d output shape: torch.Size([1, 256, 12, 12])

Conv2d output shape: torch.Size([1, 384, 12, 12])

ReLU output shape: torch.Size([1, 384, 12, 12])

Conv2d output shape: torch.Size([1, 384, 12, 12])

ReLU output shape: torch.Size([1, 384, 12, 12])

Conv2d output shape: torch.Size([1, 256, 12, 12])

ReLU output shape: torch.Size([1, 256, 12, 12])

MaxPool2d output shape: torch.Size([1, 256, 5, 5])

Flatten output shape: torch.Size([1, 6400])

Linear output shape: torch.Size([1, 4096])

ReLU output shape: torch.Size([1, 4096])

Dropout output shape: torch.Size([1, 4096])

Linear output shape: torch.Size([1, 4096])

ReLU output shape: torch.Size([1, 4096])

Dropout output shape: torch.Size([1, 4096])

Linear output shape: torch.Size([1, 10])"""

"""读取数据集"""

# 将AlexNet直接应用于Fashion-MNIST的一个问题是,Fashion-MNIST图像的分辨率28*28(像素)

#低于ImageNet图像。 为了解决这个问题,我们将它们增加到224*224(通常来讲这不是一个明智的做法,

#但在这里这样做是为了有效使用AlexNet架构)。 这里需要使用d2l.load_data_fashion_mnist

#函数中的resize参数执行此调整。

batch_size=128

train_iter,test_iter=d2l.load_data_fashion_mnist(batch_size,resize=224)

#用于获取和读取Fashion-MNIST数据集。 这个函数返回训练集和验证集的数据迭代器。 此外,

#这个函数还接受一个可选参数resize,用来将图像大小调整为另一种形状。

"""训练AlexNet"""

lr,num_epochs=0.01,10

d2l.train_ch6(net,train_iter,test_iter,num_epochs,lr,d2l.try_gpu())

"""结果输出:

loss 0.331, train acc 0.878, test acc 0.883

3941.8 examples/sec on cuda:0"""

#精度有提升,训练速度慢了20倍,

参考:

python的__name__、__class__、__dict__、__module__、__qualname__,以及dir的含义与使用场景_python __qualname__-CSDN博客