【机器学习】循环神经网络(三)

四、序列预测问题

循环神经网络实现的序列到序列的映射(Recurrent Neural Network based Sequence-to-Sequence Mapping)是一种使用循环神经网络来将一个序列数据映射到另一个序列数据的方法,它可以用于机器翻译、文本摘要、对话生成等任务。

4.1 序列标注问题

序列标注问题(sequence labeling problem)是指给定一个序列数据,为每个元素(通常是单词或字符)分配一个标签的问题。例如,命名实体识别(Named Entity Recognition, NER)是一种序列标注问题,它的目的是识别出文本中的人名、地名、组织名等实体,并给它们分配相应的标签。序列标注问题是一种典型的监督学习(supervised learning)问题,它需要有标注的数据作为训练集。序列标注问题的难点在于序列数据的长度、复杂度、噪声、非线性等因素,导致很难找到一个准确的模型来描述序列数据的规律。循环神经网络是一种适合处理序列标注问题的神经网络,它可以利用循环的结构来捕捉序列数据的长期依赖(long-term dependency)。循环神经网络的一个常见的应用是双向循环神经网络-条件随机场(Bi-directional Recurrent Neural Network-Conditional Random Field, BiRNN-CRF),它可以同时考虑前后文的信息,并使用条件随机场(Conditional Random Field, CRF)来对输出序列进行全局优化。

有哪些常见的序列标注问题?

根据输入序列和输出序列的对应关系,可以将序列标注问题分为三类:

4.2 连接主义时序分类(语音识别)

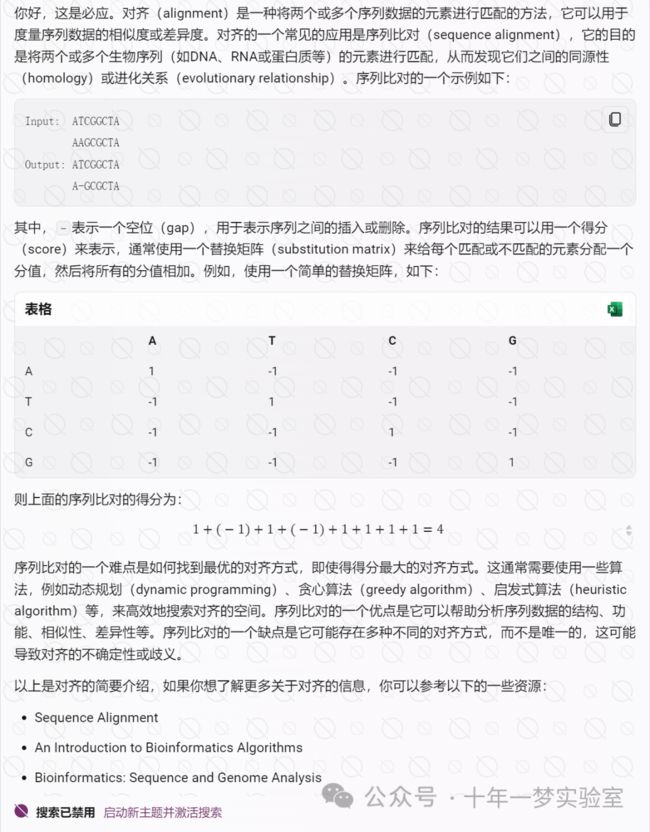

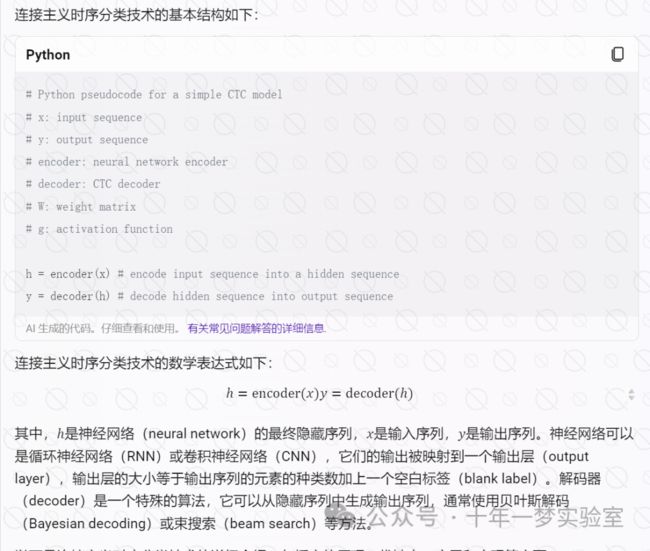

连接主义时序分类(Connectionist Temporal Classification, CTC)是一种使用神经网络来实现时序分类问题的方法,它可以将一个任意长度的输入序列映射到一个固定长度的输出序列,而不需要对齐输入和输出的每个元素。连接主义时序分类的一个常见的应用是语音识别(Speech Recognition),它可以根据一个输入的语音信号给出一个输出的文本序列,如单词或字符等。

连接主义时序分类的基本思想是使用一个神经网络(通常是循环神经网络(Recurrent Neural Network, RNN)或卷积神经网络(Convolutional Neural Network, CNN))来对输入序列进行编码,得到一个中间的隐藏序列,然后使用一个特殊的解码算法(通常是贝叶斯解码(Bayesian decoding)或束搜索(beam search))来从隐藏序列中生成输出序列。连接主义时序分类的一个关键的技术是引入一个空白标签(blank label),它表示没有输出任何元素,从而允许输入序列和输出序列的长度不一致,以及输出序列中存在重复的元素。连接主义时序分类的一个优点是它不需要对输入序列和输出序列进行对齐,从而减少了数据的预处理和标注的工作量。连接主义时序分类的一个缺点是它需要使用一个复杂的损失函数(通常是连接主义时序分类损失(Connectionist Temporal Classification Loss, CTC Loss)或交叉熵损失(Cross-Entropy Loss)),从而增加了计算的开销和难度。

详述连接主义时序分类技术

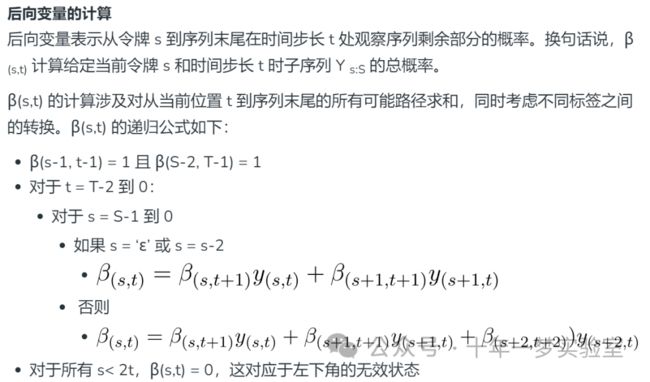

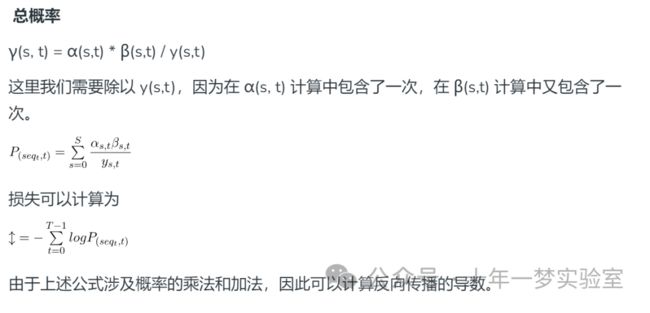

CTC网络的反向传播算法

4.3 序列到序列学习(机器翻译)

循环神经网络(RNN)是一种能够处理序列数据的神经网络。序列到序列学习(Seq2Seq)是一种使用RNN来将一个序列映射到另一个序列的方法。Seq2Seq可以用于各种任务,如机器翻译,语音识别,文本摘要,对话生成等。

Seq2Seq模型通常由两个部分组成:编码器和解码器。编码器是一个RNN,它将输入序列(如一句话)编码成一个固定长度的向量,称为上下文向量或隐藏状态。解码器是另一个RNN,它以上下文向量为初始状态,逐个生成输出序列(如另一种语言的翻译)。

Seq2Seq模型的一个挑战是如何处理长序列。由于上下文向量的长度是固定的,它可能无法捕捉输入序列的所有信息,导致信息丢失或混淆。为了解决这个问题,一种常用的方法是使用注意力机制(Attention)。注意力机制允许解码器在生成每个输出时,动态地关注输入序列的不同部分,从而提高模型的性能和可解释性。

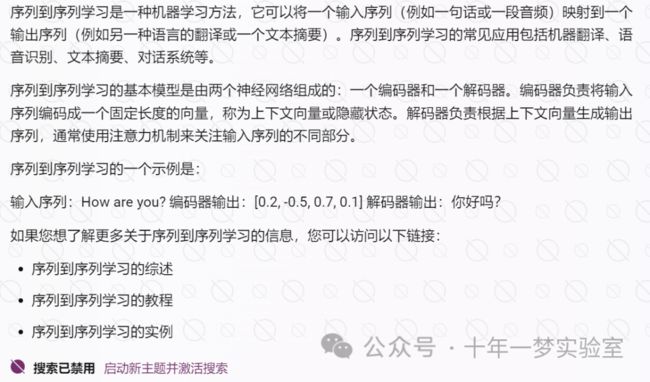

详述seq2seq 技术

哪些应用场景适合使用seq2seq技术?

seq2seq中的集束搜索

参考网址:

https://www.ibm.com/cn-zh/topics/recurrent-neural-networks 什么是循环神经网络 (RNN)? | IBM

https://learninfun.github.io/learn-with-ai/zh-cn/ai-knowledge-hub/it/artificial-intelligence/deep-learning/recurrent-neural-networks-rnns/ 循环神经网络(RNN) :: Learn with AI (learninfun.github.io)

https://www.geeksforgeeks.org/connectionist-temporal-classification/

- [TensorFlow官方教程:Neural machine translation with attention](https://www.tensorflow.org/tutorials/text/nmt_with_attention)

- [PyTorch官方教程:NLP From Scratch: Translation with a Sequence to Sequence Network and Attention](https://pytorch.org/tutorials/intermediate/seq2seq_translation_tutorial.html)

- [Keras官方教程:Sequence to sequence learning for performing number addition](https://keras.io/examples/nlp/addition_rnn/)