海塞矩阵(Hessian matrix)全解

目录

海塞矩阵

哪些优化算法会运用到海塞矩阵?

数值解求海塞矩阵

有限差分来估计海塞矩阵

自动微分技术来估计海塞矩阵

原理

代码实现

详细版

一行代码

海塞矩阵

海塞矩阵(Hessian matrix)是一个包含二阶偏导数信息的方阵,通常在数学和计算机科学中具有多种应用场景,其中包括:

-

优化问题:在优化算法中,海塞矩阵被用于确定函数的局部极小值点。特别是在牛顿法和共轭梯度法等优化算法中,海塞矩阵被用于计算搜索方向和步长,以加速收敛速度。

-

物理学:在物理学中,海塞矩阵被用于描述势能曲面的性质,以便研究分子动力学、量子力学和其他物理现象。

-

机器学习:在机器学习领域,海塞矩阵被用于训练参数化模型,例如在牛顿法和拟牛顿法中用于更新模型参数。

-

数值方法:在数值分析中,海塞矩阵被用于求解微分方程、最小二乘问题和其他数值计算问题。

-

金融学:在金融学中,海塞矩阵被用于衡量风险和波动性,以及在期权定价和投资组合优化中的应用。

总的来说,海塞矩阵在许多领域都有重要的应用,特别是在优化、物理学、机器学习和数值方法等方面。

哪些优化算法会运用到海塞矩阵?

海塞矩阵在优化算法中通常用于二阶优化方法,这些方法利用函数的二阶导数信息来加速收敛并提高优化的效率。一些常见的优化算法会运用到海塞矩阵,包括:

-

牛顿法(Newton’s Method):牛顿法是一种经典的二阶优化方法,它使用海塞矩阵来进行迭代更新,通过求解海塞矩阵的逆矩阵来直接找到函数的最优解。牛顿法通常能够更快地收敛到局部最优解,尤其在目标函数是凸函数或者接近凸函数的情况下效果显著,

-

拟牛顿法(Quasi-Newton Methods):拟牛顿法是一类基于牛顿法思想的优化算法,但是避免了计算海塞矩阵的逆矩阵。它们通过近似海塞矩阵来更新搜索方向,从而在计算效率和收敛性之间取得平衡。

这些优化算法在实际应用中会根据问题的性质和规模选择合适的方法。海塞矩阵提供了函数的二阶导数信息,能够帮助优化算法更准确地找到最优解,但也需要更多的计算资源和存储空间。因此,在实际应用中需要综合考虑问题的特点来选择合适的优化算法和方法。

数值解求海塞矩阵

一般来说,实际项目里一般是没有解析解可求海塞矩阵,所以往往通过数值解进行计算。

一种常见的方法是使用数值微分来估计海塞矩阵的元素:

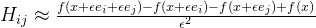

- 一种简单的数值方法是使用有限差分来估计海塞矩阵的元素。对于一个函数 f(x) ,可以使用以下公式来估计海塞矩阵的元素:

其中, (

其中, (  ) 和 (

) 和 (  ) 是单位向量, (

) 是单位向量, ( ) 是一个很小的数,通常取非常小的值,例如 (

) 是一个很小的数,通常取非常小的值,例如 (  ) 。通过计算这些差分来估计每个元素,就可以得到近似的海塞矩阵。

) 。通过计算这些差分来估计每个元素,就可以得到近似的海塞矩阵。 - 另一种方法是使用自动微分技术,这是一种计算机程序自动生成导数的技术。通过使用自动微分库,可以方便地计算函数的一阶和二阶导数,从而得到海塞矩阵的近似值。

这些数值方法可以在没有解析解的情况下,通过计算机程序来求解海塞矩阵,从而在优化、机器学习和其他领域中得到应用。

有限差分来估计海塞矩阵

考虑函数 ( f(x, y) = x^2 + 2xy + y^2 ),求它的海塞矩阵

设![]() =0.001

=0.001

![]()

![]()

![]()

![]()

通过计算上述差分,我们可以得到估计的海塞矩阵元素。

自动微分技术来估计海塞矩阵

原理

以一个简单的函数为例:f(x, y) = x^2 * y + y,来说明自动微分是如何工作的。

首先,我们可以将函数f(x, y)表示为计算图,其中每个节点表示一个计算步骤,每条边表示数据的流动。对于这个函数,计算图可以表示为:

(x) ----\

\

(*) ----\

(x) ----/ \

(+) ---- (f)

(y) ------------/

其中,(*) 表示乘法操作,(+) 表示加法操作,(x) 和 (y) 分别表示输入的变量 x 和 y,(f) 表示函数的输出。

接下来,自动微分会利用链式法则来计算函数 f 对于输入变量 x 和 y 的导数。链式法则告诉我们,对于复合函数 g(f(x)),其导数可以表示为 g’(f(x)) * f’(x)。在我们的例子中,我们可以使用链式法则来计算 f 对于 x 和 y 的导数:

对于 x 的导数:

f’(x) = 2x * y

对于 y 的导数:

f’(y) = x^2 + 1

通过计算图和链式法则,自动微分可以高效地计算出函数 f 对于输入变量 x 和 y 的导数,同理基于f’(x)和f’(y),求二阶导数,而无需手动推导导数表达式。这种自动计算导数的方法可以应用于更复杂的函数和计算图结构,使得求解导数变得更加高效和准确。

代码实现

详细版

下面是使用Python的Autograd库来实现上述算法流程的示例代码:

import autograd.numpy as np

from autograd import elementwise_grad, jacobian, hessian

# Step 1: 定义变量和函数

def f(x, y):

return x**2 + 2*x*y + y**2

# Step 2: 计算一阶导数

df_dx = elementwise_grad(f, 0) # 对x的一阶导数

df_dy = elementwise_grad(f, 1) # 对y的一阶导数

# Step 3: 计算二阶导数

d2f_dx2 = elementwise_grad(df_dx, 0) # 对x的二阶导数

d2f_dy2 = elementwise_grad(df_dy, 1) # 对y的二阶导数

d2f_dxdy = elementwise_grad(df_dx, 1) # 对x和y的混合二阶导数

# Step 4: 构建海塞矩阵

H = np.array([[d2f_dx2(1.0, 2.0), d2f_dxdy(1.0, 2.0)],

[d2f_dxdy(1.0, 2.0), d2f_dy2(1.0, 2.0)]])

在这个示例中,我们使用Autograd库来计算函数 ( f(x, y) = x^2 + 2xy + y^2 ) 的一阶导数和二阶导数,并将其组合成海塞矩阵。

一行代码

但是我们也可以一步到位

import autograd.numpy as np

from autograd import elementwise_grad, jacobian, hessian

# elementwise_grad, jacobian也可以类似得到

def f(x, y):

return x**2 + 2*x*y + y**2

然后,我们可以使用自动微分库Autograd来计算海塞矩阵:

H = hessian(f)

这将给出函数 ( f(x, y) ) 在某一点的海塞矩阵。Autograd库会自动计算函数的一阶和二阶导数,并返回相应的海塞矩阵。