LVS+Keepalived集群的介绍和搭建

目录

LVS+Keepalived集群的介绍

Keepalived及其工作原理

Keepalived体系主要模块及其作用

一个合格的集群应该具备的特性

健康检查(探针)的方式

实验:搭建LVS+Keepalived集群

实验准备

实验步骤

LVS 部署

配置节点服务器

实验验证

实验体会

脑裂故障

脚本

LVS+Keepalived集群的介绍

Keepalived及其工作原理

Keepalived 是一个基于VRRP协议来实现的LVS服务高可用方案,可以解决静态路由出现的单点故障问题。

在一个LVS服务集群中通常有主服务器(MASTER)和备份服务器(BACKUP)两种角色的服务器,但是对外表现为一个虚拟IP(VIP),主服务器会发送VRRP通告信息给备份服务器,当备份服务器收不到VRRP消息的时候,即主服务器异常的时候,备份服务器就会接管虚拟IP,继续提供服务,从而保证了高可用性。

Keepalived体系主要模块及其作用

keepalived体系架构中主要有三个模块,分别是core、check和vrrp。

- core模块:为keepalived的核心,负责主进程的启动、维护及全局配置文件的加载和解析。

- vrrp模块:是来实现VRRP协议的。(调度器之间的健康检查和主备切换)

- check模块:负责健康检查,常见的方式有端口检查及URL检查。(节点服务器的健康检查)

一个合格的集群应该具备的特性

- 负载均衡(LVS Nginx HAProxy F5)

- 健康检查(探针)(for调度器/节点服务器 keepalived Heartbeat)

- 故障转移(通过VIP漂移实现主备切换)

健康检查(探针)的方式

- 发送心跳消息 ping/pong

- tcp端口检查向目标主机的IP:PORT发送TCP连接,如果TCP连接成功(三次握手成功)则认为健康检查探测成功,否则失败

- HTTP URL检查,向目标主机的http://IP:PORT/URL路径,发送HTTP GET请求,如果响应返回的状态码2xx,3xx,则认为操作成功,如果是4xx,5xx,则认为探测失败

实验:搭建LVS+Keepalived集群

实验准备

主DR 服务器:192.168.75.30

备DR 服务器:192.168.75.10

Web 服务器1:192.168.75.50

Web 服务器2:192.168.75.60vip:192.168.75.111

客户端(本机):192.168.75.1

实验步骤

LVS 部署

配置负载调度器(主、备相同)

关闭防火墙,安全机制

systemctl stop firewalld.service

setenforce 0

下载ipvsadm keepalived

yum -y install ipvsadm keepalived

modprobe ip_vs

cat /proc/net/ip_vscd /etc/keepalived/

cp keepalived.conf keepalived.conf.bak

vim keepalived.conf

......

global_defs { #定义全局参数

--10行--修改,邮件服务指向本地

smtp_server 127.0.0.1

--12行--修改,指定服务器(路由器)的名称,主备服务器名称须不同,主为LVS_01,备为LVS_02

router_id LVS_01

--14行--注释掉,取消严格遵守VRRP协议功能,否则VIP无法被连接

#vrrp_strict

}

vrrp_instance VI_1 { #定义VRRP热备实例参数

--20行--修改,指定热备状态,主为MASTER,备为BACKUP

state MASTER

--21行--修改,指定承载vip地址的物理接口

interface ens33

--22行--修改,指定虚拟路由器的ID号,每个热备组保持一致

virtual_router_id 10

#nopreempt #如果设置非抢占模式,两个节点state必须为BACKUP,并加上配置 nopreempt

--23行--修改,指定优先级,数值越大优先级越高,这里设置主为100,备为90

priority 100

advert_int 1 #通告间隔秒数(心跳频率)

authentication { #定义认证信息,每个热备组保持一致

auth_type PASS #认证类型

--27行--修改,指定验证密码,主备服务器保持一致

auth_pass abc123

}

virtual_ipaddress { #指定群集vip地址

192.168.75.111

}

}

--36行--修改,指定虚拟服务器地址(VIP)、端口,定义虚拟服务器和Web服务器池参数

virtual_server 192.168.75.111 80 {

delay_loop 6 #健康检查的间隔时间(秒)

lb_algo rr #指定调度算法,轮询(rr)

--39行--修改,指定群集工作模式,直接路由(DR)

lb_kind DR

persistence_timeout 0 #连接保持时间(秒)

protocol TCP #应用服务采用的是 TCP协议

--43行--修改,指定第一个Web节点的地址、端口

real_server 192.168.75.50 80 {

weight 1 #节点的权重

--45行--删除,添加以下健康检查方式

TCP_CHECK {

connect_port 80 #添加检查的目标端口

connect_timeout 3 #添加连接超时(秒)

nb_get_retry 3 #添加重试次数

delay_before_retry 3 #添加重试间隔

}

}

real_server 192.168.75.60 80 { #添加第二个 Web节点的地址、端口

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 3

nb_get_retry 3

delay_before_retry 3

}

}

##删除后面多余的配置##

}主DR服务器的配置

副DR服务器的配置

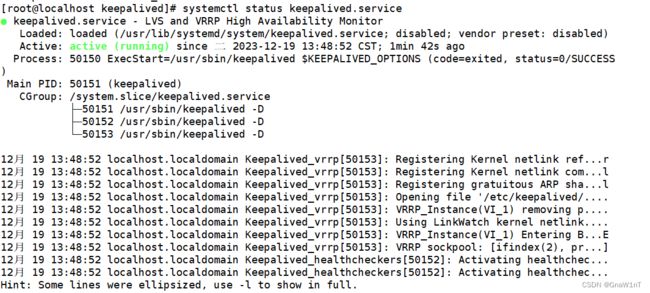

systemctl start keepalived

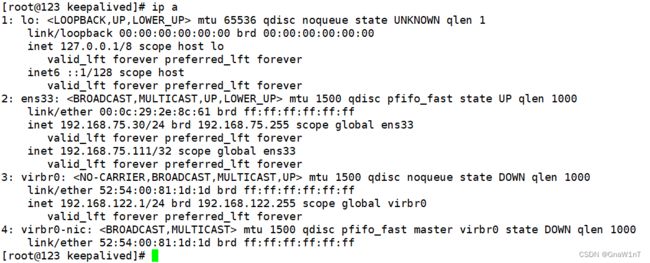

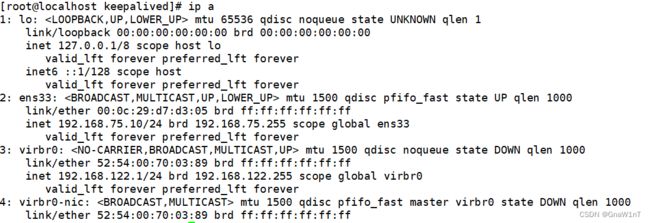

ip addr #查看虚拟网卡vip

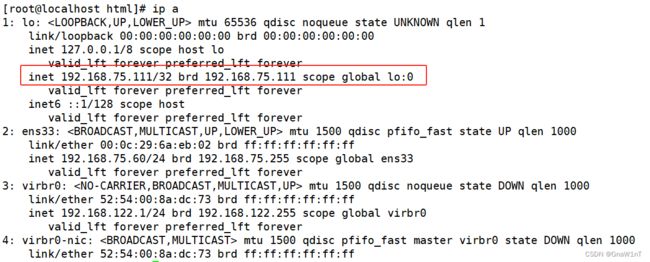

主服务器:

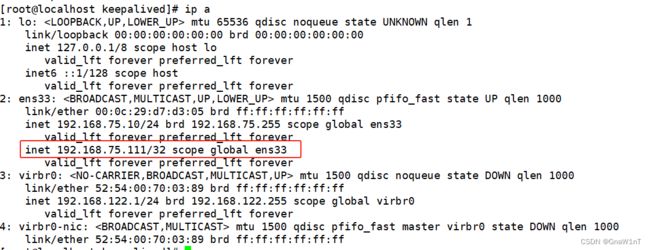

副服务器:

启动 ipvsadm 服务(两台服务器一样)

ipvsadm-save > /etc/sysconfig/ipvsadm

systemctl start ipvsadm

ipvsadm -ln

#如没有VIP 的分发策略,则重启 keepalived 服务,systemctl restart keepalived

调整 proc 响应参数,关闭Linux 内核的重定向参数响应(两台一样)

vim /etc/sysctl.conf

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.ens33.send_redirects = 0

查看

sysctl -p配置节点服务器

下载http服务

关闭安全机制

systemctl stop firewalld

setenforce 0

下载开启httpd

yum -y install httpd

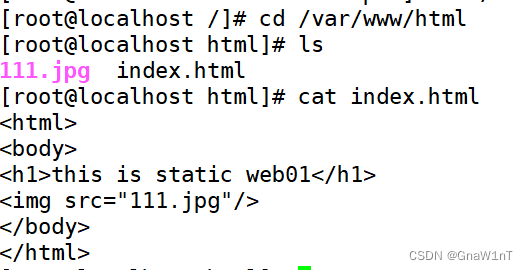

systemctl start httpd在两台web服务器的/var/www/html路径下分别添加网页配置文件

第一台(192.168.75.50)

第二台(192.168.75.60)

给两台web服务器添加vip (两台一样)

vim /etc/sysconfig/network-scripts/ifcfg-lo:0

DEVICE=lo:0

ONBOOT=yes

IPADDR=192.168.75.111

NETMASK=255.255.255.255

service network restart 或 systemctl restart network

ifup lo:0

ifconfig lo:0

route add -host 192.168.75.111 dev lo:0

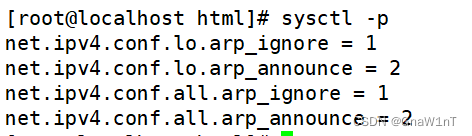

配置内核文件(两台一样)

vim /etc/sysctl.conf

net.ipv4.conf.lo.arp_ignore = 1

net.ipv4.conf.lo.arp_announce = 2

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.all.arp_announce = 2

sysctl -p

实验验证

在客户端访问 http://192.168.75.111/

再在主服务器关闭 keepalived 服务后再测试, systemctl stop keepalived

关闭主服务器的keepalived服务

第一台主(192.168.75.30)

第二台备(192.168.75.10)

实现vip漂移

实验体会

脑裂故障

现象:主服务器和备服务器同时拥有VIP

原因:因为主服务器和备服务器之间的通信链路中断,导致备服务器无法收到主服务器发送的VRRP通告消息,备服务器误认为主服务器故障了并通过IP命令生成VIP

解决:关闭主服务器或备服务器其中一个的keepalived服务

预防:

- 主服务器和备服务器之间添加双链路通信

- 在主服务器上添加脚本进行判断与备服务器通信链路是否中断,如果确实是链路中断则自行关闭keepalived服务

- 利用第三方应用或监控系统检测是否发送脑裂故障,如果发送脑裂故障则通过第三方应用或监控系统来关闭主服务器或备服务器上的keepalived服务

脚本

在主服务器上添加脚本进行判断与备服务器通信链路是否中断,如果确实是链路中断则自行关闭keepalived服务

ping -c 4 -i 0.5 -w 2 192.168.75.10 #ping备服务器看是否联通

if [ $? -ne 0 ];then #如果不成功,则

ssh 192.168.80.13 ping -c 4 -i 0.5 -w 2 -I 192.168.80.13 192.168.80.30

#远程连接到节点服务器 ping备服务器,看是否联通

if [ $? -eq 0 ];then #如果成功成功

systemctl stop keepalived #则关闭主服务器的keepalived的服务

else #否则,退出

exit

fi

fi