- 互信息:理论框架、跨学科应用与前沿进展

大千AI助手

人工智能Python#OTHER人工智能深度学习算法互信息香农通信随机变量

1.起源与核心定义互信息(MutualInformation,MI)由克劳德·香农(ClaudeShannon)在1948年开创性论文《AMathematicalTheoryofCommunication》中首次提出,该论文奠定了现代信息论的基础。互信息用于量化两个随机变量之间的统计依赖关系,定义为:若已知一个随机变量的取值,能为另一个随机变量提供的信息量。数学上,对于离散随机变量XXX和YYY,

- 2023-01-26

胡喜平

我觉得《可见的学习》一书确实从底层逻辑说清楚了,教学的本质。可是太多术语和概念,一时间难以消化啊。而且知道和懂得有距离,运用就更不行了,需要高手和专家的指导。我需要多听听新课标的讲座了,来反复印证。读论文也有了一点点灵感,明天修改我的论文。

- 为了在未来的人工智能世界中取得成功,学生们必须学习人类写作的优点

睿邸管家

澳大利亚各地的学生在新学年开始使用铅笔、钢笔和键盘学习写字。在工作场所,机器也在学习写作,如此有效,几年之内,它们可能会写得比人类更好。有时它们已经做到了,就像Grammarly这样的应用程序所展示的那样。当然,人类现在的日常写作可能很快就会由具有人工智能(AI)的机器来完成。手机和电子邮件软件常用的预测文本是无数人每天都在使用的一种人工智能写作形式。据AI行业研究机构称,到2022年,人工智能及

- 人工智能应用研究快讯 2021-11-30

峰谷皆平

[HTML]ArtificialIntelligenceforSkinCancerDetection:ScopingReviewATakiddin,JSchneider,YYang,AAbd-Alrazaq...JournalofMedicalInternet...,2021ABSTACT:Background:Skincanceristhemostcommoncancertypeaffectin

- 从振动信号到精准预警:AI 如何重塑工业设备健康管理?

缘华工业智维

人工智能计算机视觉边缘计算信息与通信

在智能制造浪潮席卷全球的当下,工业生产正经历着从传统模式向智能化、数字化转型的深刻变革。在这场变革中,AI驱动的振动分析技术犹如一颗璀璨新星,成为工业设备可靠运行的“健康卫士”。它通过在设备关键部位部署振动传感器,如同医生为患者听诊般实时采集设备运行时的振动信号,再借助强大的人工智能算法对这些“工业脉搏”进行深度解析,从而实现对工业设备从故障预警到寿命预测的全周期精准守护。一、AI振动分析:设备状

- AI 生成虚拟宠物:24 小时陪你聊天解闷

大力出奇迹985

人工智能宠物

本文围绕AI生成虚拟宠物展开,介绍这类依托人工智能技术诞生的虚拟伙伴,能实现24小时不间断陪伴聊天,为人们解闷。文中详细阐述其技术基础,包括自然语言处理、机器学习等;分析多样功能,如个性化互动、情绪回应等;探讨在独居人群、压力大者等不同群体中的应用场景,最后总结其为人们生活带来的积极影响及未来发展潜力,展现AI虚拟宠物在陪伴领域的独特价值。一、AI生成虚拟宠物的诞生背景与技术基石在快节奏的现代社会

- GPT-4 在 AIGC 中的微调技巧:让模型更懂你的需求

AIGC应用创新大全

AI人工智能与大数据应用开发MCP&Agent云算力网络AIGCai

GPT-4在AIGC中的微调技巧:让模型更懂你的需求关键词:GPT-4、AIGC、模型微调、监督学习、指令优化、过拟合预防、个性化生成摘要:AIGC(人工智能生成内容)正在重塑内容创作行业,但通用的GPT-4模型可能无法精准匹配你的垂直需求——比如写电商爆款文案时总“跑题”,或生成技术文档时专业术语不够。本文将用“教小朋友学画画”的通俗类比,从微调的底层逻辑讲到实战技巧,带你掌握让GPT-4“更懂

- AIGC内容生成实战:如何用ChatGPT+DALL·E打造高转化内容

AI大模型应用工坊

AI大模型开发实战AIGCchatgptai

AIGC内容生成实战:如何用ChatGPT+DALL·E打造高转化内容关键词:AIGC、ChatGPT、DALL·E、内容生成、高转化营销、多模态协同、提示词工程摘要:随着AIGC(人工智能生成内容)技术的爆发式发展,ChatGPT(文本生成)与DALL·E(图像生成)的组合已成为内容创作领域的“黄金搭档”。本文将深度解析二者的协同原理,结合实战案例演示从需求分析到内容落地的全流程,并揭示提升内容

- 数据分析领域中AI人工智能的发展前景展望

AI大模型应用工坊

AI大模型开发实战数据分析人工智能数据挖掘ai

数据分析领域中AI人工智能的发展前景展望关键词:数据分析、人工智能、机器学习、深度学习、数据挖掘、预测分析、自动化摘要:本文深入探讨了人工智能在数据分析领域的发展现状和未来趋势。我们将从核心技术原理出发,分析AI如何改变传统数据分析范式,详细讲解机器学习算法在数据分析中的应用,并通过实际案例展示AI驱动的数据分析解决方案。文章还将探讨行业应用场景、工具生态以及未来发展面临的挑战和机遇,为数据分析师

- AI人工智能中的数据挖掘:提升智能决策能力

AI人工智能中的数据挖掘:提升智能决策能力关键词:数据挖掘、人工智能、机器学习、智能决策、数据分析、特征工程、模型优化摘要:本文深入探讨了数据挖掘在人工智能领域中的核心作用,重点分析了如何通过数据挖掘技术提升智能决策能力。文章从基础概念出发,详细介绍了数据挖掘的关键算法、数学模型和实际应用场景,并通过Python代码示例展示了数据挖掘的全流程。最后,文章展望了数据挖掘技术的未来发展趋势和面临的挑战

- 【三桥君】MCP中台,究竟如何实现多模型、多渠道、多环境的统一管控?如何以MCP为核心设计AI应用架构?

三桥君

《三桥君MCP落地方法论》《三桥君AI大模型落地方法论》#《三桥君AI产品方法论》人工智能AI产品经理MCPAPI三桥君系统架构llama

你好,我是✨三桥君✨本文介绍>>一、引言随着人工智能技术的快速发展,越来越多的企业开始引入大语言模型(LLM)以提升用户体验和运营效率。然而,如何高效、稳定地将这些AI能力落地到生产环境呢?传统的系统架构往往难以应对AI应用的高并发、低延迟和灵活扩展需求,因此,从整体架构角度设计AI应用架构显得尤为重要。本文三桥君将深入探讨以MCP为核心的AI应用架构,并分析多种部署方式的优劣势,为企业在AI落地

- 深入理解卷积神经网络(CNN)与循环神经网络(RNN)

CodeJourney.

cnnrnn人工智能

在当今的人工智能领域,神经网络无疑是最为璀璨的明珠之一。而卷积神经网络(ConvolutionalNeuralNetworks,CNN)和循环神经网络(RecurrentNeuralNetworks,RNN)作为神经网络家族中的重要成员,各自有着独特的架构和强大的功能,广泛应用于众多领域。本文将深入探讨这两种神经网络的原理、特点以及应用场景,为对深度学习感兴趣的读者提供全面的知识讲解。一、卷积神经

- 今年校招竞争真激烈

12_05

程序员满大街,都要找不到工作了。即使人工智能满大街,我也后悔当初没学机器学习,后悔当初没学Java。C++真难找工作。难道毕了业就失业吗?好担心!

- 时序预测 | MATLAB实现贝叶斯优化CNN-GRU时间序列预测(股票价格预测)

Matlab机器学习之心

matlabcnngru

✅作者简介:热爱数据处理、数学建模、仿真设计、论文复现、算法创新的Matlab仿真开发者。更多Matlab代码及仿真咨询内容点击主页:Matlab科研工作室个人信条:格物致知,期刊达人。内容介绍股票价格预测一直是金融领域一个极具挑战性的课题。其内在的非线性、随机性和复杂性使得传统的预测方法难以取得令人满意的效果。近年来,深度学习技术,特别是卷积神经网络(CNN)和门控循环单元(GRU)的结合,为时

- 如何运用深度学习打造高效AI人工智能系统

AI智能探索者

AIAgent智能体开发实战人工智能深度学习ai

如何运用深度学习打造高效AI人工智能系统关键词:深度学习、AI系统、神经网络、模型优化、实战开发摘要:本文将从深度学习的核心概念出发,结合生活实例和代码实战,系统讲解如何构建高效AI系统。我们会拆解数据准备、模型设计、训练优化、部署落地的全流程,揭秘“数据-模型-训练-推理”的协同机制,并通过具体案例演示从0到1开发AI系统的关键技巧,帮助开发者掌握打造高效AI系统的底层逻辑。背景介绍目的和范围在

- 非欧空间计算加速:图神经网络与微分几何计算的GPU优化(流形数据的内存布局优化策略)

九章云极AladdinEdu

空间计算神经网络人工智能gpu算力算法java开发语言

一、非欧空间计算的革命性意义与核心挑战在三维形状分析、社交网络建模、分子动力学模拟等领域,非欧几里得空间数据(流形数据)的处理正推动人工智能技术向更复杂的几何结构迈进。传统欧式空间优化方法在处理流形数据时面临根本性局限:黎曼度量导致距离计算失效、局部坐标系动态变化引发内存访问模式混乱、曲率变化影响并行计算效率。本文提出基于分块流形存储(BlockedManifoldStorage,BMS)与层次化

- ChatGPT还不能写小说吗?

刘若愚

最近,ChatGPT大热,据说可以写论文,编故事,好像无所不能。于是,我给它出了个题目:写一篇5万字的科幻小说。人物:刘若愚,化学家;刘子琪,大律师;仔仔,刘子琪的宠物猫;周金凝,医生;刘泽余,大侦探;赵政淇,程序猿;杰夫(Jeff)机器人它给我的回答是:我很抱歉,我是一个AI语言模型,无法写出如此长篇的小说。但我可以为您提供一些写作灵感和指导:确定故事背景和时间线:在科幻小说中,背景和时间线非常

- 响应式编程实践:Spring Boot WebFlux构建高性能非阻塞服务

fanxbl957

Webspringboot后端java

博主介绍:Java、Python、js全栈开发“多面手”,精通多种编程语言和技术,痴迷于人工智能领域。秉持着对技术的热爱与执着,持续探索创新,愿在此分享交流和学习,与大家共进步。全栈开发环境搭建运行攻略:多语言一站式指南(环境搭建+运行+调试+发布+保姆级详解)感兴趣的可以先收藏起来,希望帮助更多的人响应式编程实践:SpringBootWebFlux构建高性能非阻塞服务一、引言在当今数字化时代,互

- 论文阅读:《针对多目标优化和应用的 NSGA-II 综述》一些关于优化算法的简介

行然梦实

优化算法论文阅读算法数学建模

前言提醒:文章内容为方便作者自己后日复习与查阅而进行的书写与发布,其中引用内容都会使用链接表明出处(如有侵权问题,请及时联系)。其中内容多为一次书写,缺少检查与订正,如有问题或其他拓展及意见建议,欢迎评论区讨论交流。内容由AI辅助生成,仅经笔者审核整理,请甄别食用。文章目录前言一些关于优化算法的缩写优化算法Ma,Haiping&Zhang,Yajing&Sun,Shengyi&Liu,Ting&S

- 企业级RAG的数据方案选择 - 向量数据库、图数据库和知识图谱

南七小僧

AI技术产品经理网站开发人工智能数据库知识图谱人工智能

如何为企业RAG选择合适的数据存储方式摘要:本文讨论了矢量数据库、图数据库和知识图谱在解决信息检索挑战方面的重要性,特别是针对企业规模的检索增强生成(RAG)。看看海外人工智能企业Writer是如何利用知识图谱增强企业级RAG。要点概要:矢量数据库高效存储数据,但缺乏上下文和关联信息。图数据库优先考虑数据点之间的关系,受益于关系结构。知识图谱在语义存储方面表现出色,由于其能够编码丰富的上下文信息,

- 【人工智能入门必看的最全Python编程实战(1)】

DFCED

人工智能python开发语言深度学习找工作就业

--------------------------------------------------------------------------------------------------------------------1.AIGC未来发展前景未完持续…1.1人工智能相关科研重要性拥有一篇人工智能科研论文及专利软著竞赛是保研考研留学深造以及找工作的关键门票!!!拥有一篇人工智能科研论文

- 2025毫米波雷达技术白皮书:智能汽车与物联网的感知核心

随着人工智能、物联网(IoT)和智能汽车产业的迅猛发展,毫米波雷达技术正成为感知领域的核心驱动力。毫米波雷达凭借其高精度、全天候和强抗干扰能力,广泛应用于智能汽车的自动驾驶、物联网的环境感知以及工业自动化。2025年,毫米波雷达技术在性能、应用场景和市场规模上都达到了一个全新的高度。本白皮书将深入探讨毫米波雷达技术的核心优势、发展趋势及其在智能汽车与物联网中的应用前景,同时推荐各大品牌的领先产品方

- 从零开始构建深度学习环境:基于Pytorch、CUDA与cuDNN的虚拟环境搭建与实践(适合初学者)

荣华富贵8

程序员的知识储备2程序员的知识储备3深度学习pytorch人工智能

摘要:深度学习正在引领人工智能技术的革新,而对于初学者来说,正确搭建深度学习环境是迈向AI研究与应用的第一步。本文将为读者提供一套详尽的教程,指导如何在本地环境中搭建Pytorch、CUDA与cuDNN,以及如何利用Anaconda和PyCharm进行高效开发。内容涵盖从环境配置、常见错误修正,到基础的深度学习模型构建及训练。我们旨在为深度学习零基础的入门者提供一个全面且易于理解的“保姆级”教程,

- [0524]基于JAVA的农业科普宣传智慧管理系统的设计与实现

阿鑫学长【毕设工场】

java开发语言毕业设计课程设计

毕业设计(论文)开题报告表姓名学院专业班级题目基于JAVA的农业科普宣传智慧管理系统的设计与实现指导老师(一)选题的背景和意义开题报告背景与意义:随着我国农业现代化进程的不断推进,以及信息技术在各领域的广泛应用,构建基于Java的农业科普宣传智慧管理系统具有极其重要的理论价值和现实意义。当前,我国农业正面临转型升级的关键阶段,信息不对称、管理效率低下、科普宣传不足等问题制约了农业产业的健康发展。尤

- 人工智能概念之九:深度学习概述

文章目录相关文章一、深度学习的定位:AI时代的基石技术1.1技术生态全景图1.2技术革命的催化剂二、深度学习的双面性:性能优势与技术挑战2.1技术优势全景扫描2.2技术挑战深度剖析三、技术演进时间轴:70年的厚积薄发四、主流框架生态对比五、未来演进方向相关文章人工智能概念之二:人工智能核心概念:网页链接一、深度学习的定位:AI时代的基石技术1.1技术生态全景图深度学习处于人工智能(AI)技术金字塔

- H800核心技术突破与行业应用实战

智能计算研究中心

其他

内容概要在人工智能技术持续迭代的背景下,H800芯片凭借自主架构优化与算力跃升,成为推动行业场景化落地的关键驱动力。本文将从技术路径、性能突破与行业应用三个维度,系统解析H800如何在高并发计算与低延时响应领域实现底层架构创新。首先聚焦其自主架构优化的核心技术路径,包括动态资源调度算法与异构计算单元的深度协同设计,揭示其在能效比与计算密度上的突破逻辑;进一步结合算力跃升的具体表现,探讨该芯片如何通

- 智慧建筑:科技引领房地产与建筑业的未来

RedPhoenix45

最新接入DeepSeek-V3模型,点击下载最新版本InsCodeAIIDE智慧建筑:科技引领房地产与建筑业的未来随着科技的飞速发展,人工智能(AI)和智能化工具正以前所未有的速度改变着各行各业。在房地产与建筑领域,这种变革尤为显著。从建筑设计到施工管理,再到物业管理,智能化技术正在重塑行业的每一个环节。本文将探讨如何利用先进的智能化工具提升房地产与建筑行业的效率,并介绍一款革命性的开发工具——它

- 智慧施工:AI技术赋能建筑安全监测新纪元

开发AI智能应用,就下载InsCodeAIIDE,一键接入DeepSeek-R1满血版大模型!智慧施工:AI技术赋能建筑安全监测新纪元在现代建筑行业中,施工安全始终是核心关注点之一。随着科技的飞速发展,人工智能(AI)和大数据分析逐渐成为提升施工安全的重要工具。本文将探讨如何利用智能化软件和大模型API来构建高效的施工安全监测系统,并介绍一款强大的开发工具——InsCodeAIIDE的应用场景及其

- 智慧工地系统:建筑行业数字化变革的引领者

青云智慧园区

java

在建筑行业积极迈向数字化转型的浪潮中,智慧工地系统凭借“数据驱动、智能管控、协同增效”的核心优势,深度融合物联网、大数据、人工智能等前沿技术,构建起覆盖工程项目全生命周期的精细化管理体系。以下将从系统架构、核心功能模块、应用价值以及未来展望等方面,全方位剖析智慧工地系统如何实现施工全过程的智能化、高效化管理。一、系统架构:打造一体化协同管理平台智慧工地系统采用先进的分层架构设计,以底层的数据采集层

- 周一 2021-05-17 06:29 - 22:00 雨 08h20m

么得感情的日更机器

一时间记录二概述早上醒来,看小说,洗漱,吃饭上午论文,吃饭下午小说,午休,总结,打疫苗,吃饭晚上日常任务,小说,洗漱,睡觉三总结(Summary)今天是论文和打疫苗的一天,总体感觉良好,学习感觉没咋学四反思今天收获了什么?哪里做的不好?做得不好的原因是什么?以后怎样避免或改进?4.1今日收获论文4.2今日不足编程学习醒了因为实验室没开门,就不愿意去,这可怎么办

- 关于旗正规则引擎下载页面需要弹窗保存到本地目录的问题

何必如此

jsp超链接文件下载窗口

生成下载页面是需要选择“录入提交页面”,生成之后默认的下载页面<a>标签超链接为:<a href="<%=root_stimage%>stimage/image.jsp?filename=<%=strfile234%>&attachname=<%=java.net.URLEncoder.encode(file234filesourc

- 【Spark九十八】Standalone Cluster Mode下的资源调度源代码分析

bit1129

cluster

在分析源代码之前,首先对Standalone Cluster Mode的资源调度有一个基本的认识:

首先,运行一个Application需要Driver进程和一组Executor进程。在Standalone Cluster Mode下,Driver和Executor都是在Master的监护下给Worker发消息创建(Driver进程和Executor进程都需要分配内存和CPU,这就需要Maste

- linux上独立安装部署spark

daizj

linux安装spark1.4部署

下面讲一下linux上安装spark,以 Standalone Mode 安装

1)首先安装JDK

下载JDK:jdk-7u79-linux-x64.tar.gz ,版本是1.7以上都行,解压 tar -zxvf jdk-7u79-linux-x64.tar.gz

然后配置 ~/.bashrc&nb

- Java 字节码之解析一

周凡杨

java字节码javap

一: Java 字节代码的组织形式

类文件 {

OxCAFEBABE ,小版本号,大版本号,常量池大小,常量池数组,访问控制标记,当前类信息,父类信息,实现的接口个数,实现的接口信息数组,域个数,域信息数组,方法个数,方法信息数组,属性个数,属性信息数组

}

&nbs

- java各种小工具代码

g21121

java

1.数组转换成List

import java.util.Arrays;

Arrays.asList(Object[] obj); 2.判断一个String型是否有值

import org.springframework.util.StringUtils;

if (StringUtils.hasText(str)) 3.判断一个List是否有值

import org.spring

- 加快FineReport报表设计的几个心得体会

老A不折腾

finereport

一、从远程服务器大批量取数进行表样设计时,最好按“列顺序”取一个“空的SQL语句”,这样可提高设计速度。否则每次设计时模板均要从远程读取数据,速度相当慢!!

二、找一个富文本编辑软件(如NOTEPAD+)编辑SQL语句,这样会很好地检查语法。有时候带参数较多检查语法复杂时,结合FineReport中生成的日志,再找一个第三方数据库访问软件(如PL/SQL)进行数据检索,可以很快定位语法错误。

- mysql linux启动与停止

墙头上一根草

如何启动/停止/重启MySQL一、启动方式1、使用 service 启动:service mysqld start2、使用 mysqld 脚本启动:/etc/inint.d/mysqld start3、使用 safe_mysqld 启动:safe_mysqld&二、停止1、使用 service 启动:service mysqld stop2、使用 mysqld 脚本启动:/etc/inin

- Spring中事务管理浅谈

aijuans

spring事务管理

Spring中事务管理浅谈

By Tony Jiang@2012-1-20 Spring中对事务的声明式管理

拿一个XML举例

[html]

view plain

copy

print

?

<?xml version="1.0" encoding="UTF-8"?>&nb

- php中隐形字符65279(utf-8的BOM头)问题

alxw4616

php中隐形字符65279(utf-8的BOM头)问题

今天遇到一个问题. php输出JSON 前端在解析时发生问题:parsererror.

调试:

1.仔细对比字符串发现字符串拼写正确.怀疑是 非打印字符的问题.

2.逐一将字符串还原为unicode编码. 发现在字符串头的位置出现了一个 65279的非打印字符.

- 调用对象是否需要传递对象(初学者一定要注意这个问题)

百合不是茶

对象的传递与调用技巧

类和对象的简单的复习,在做项目的过程中有时候不知道怎样来调用类创建的对象,简单的几个类可以看清楚,一般在项目中创建十几个类往往就不知道怎么来看

为了以后能够看清楚,现在来回顾一下类和对象的创建,对象的调用和传递(前面写过一篇)

类和对象的基础概念:

JAVA中万事万物都是类 类有字段(属性),方法,嵌套类和嵌套接

- JDK1.5 AtomicLong实例

bijian1013

javathreadjava多线程AtomicLong

JDK1.5 AtomicLong实例

类 AtomicLong

可以用原子方式更新的 long 值。有关原子变量属性的描述,请参阅 java.util.concurrent.atomic 包规范。AtomicLong 可用在应用程序中(如以原子方式增加的序列号),并且不能用于替换 Long。但是,此类确实扩展了 Number,允许那些处理基于数字类的工具和实用工具进行统一访问。

- 自定义的RPC的Java实现

bijian1013

javarpc

网上看到纯java实现的RPC,很不错。

RPC的全名Remote Process Call,即远程过程调用。使用RPC,可以像使用本地的程序一样使用远程服务器上的程序。下面是一个简单的RPC 调用实例,从中可以看到RPC如何

- 【RPC框架Hessian一】Hessian RPC Hello World

bit1129

Hello world

什么是Hessian

The Hessian binary web service protocol makes web services usable without requiring a large framework, and without learning yet another alphabet soup of protocols. Because it is a binary p

- 【Spark九十五】Spark Shell操作Spark SQL

bit1129

shell

在Spark Shell上,通过创建HiveContext可以直接进行Hive操作

1. 操作Hive中已存在的表

[hadoop@hadoop bin]$ ./spark-shell

Spark assembly has been built with Hive, including Datanucleus jars on classpath

Welcom

- F5 往header加入客户端的ip

ronin47

when HTTP_RESPONSE {if {[HTTP::is_redirect]}{ HTTP::header replace Location [string map {:port/ /} [HTTP::header value Location]]HTTP::header replace Lo

- java-61-在数组中,数字减去它右边(注意是右边)的数字得到一个数对之差. 求所有数对之差的最大值。例如在数组{2, 4, 1, 16, 7, 5,

bylijinnan

java

思路来自:

http://zhedahht.blog.163.com/blog/static/2541117420116135376632/

写了个java版的

public class GreatestLeftRightDiff {

/**

* Q61.在数组中,数字减去它右边(注意是右边)的数字得到一个数对之差。

* 求所有数对之差的最大值。例如在数组

- mongoDB 索引

开窍的石头

mongoDB索引

在这一节中我们讲讲在mongo中如何创建索引

得到当前查询的索引信息

db.user.find(_id:12).explain();

cursor: basicCoursor 指的是没有索引

&

- [硬件和系统]迎峰度夏

comsci

系统

从这几天的气温来看,今年夏天的高温天气可能会维持在一个比较长的时间内

所以,从现在开始准备渡过炎热的夏天。。。。

每间房屋要有一个落地电风扇,一个空调(空调的功率和房间的面积有密切的关系)

坐的,躺的地方要有凉垫,床上要有凉席

电脑的机箱

- 基于ThinkPHP开发的公司官网

cuiyadll

行业系统

后端基于ThinkPHP,前端基于jQuery和BootstrapCo.MZ 企业系统

轻量级企业网站管理系统

运行环境:PHP5.3+, MySQL5.0

系统预览

系统下载:http://www.tecmz.com

预览地址:http://co.tecmz.com

各种设备自适应

响应式的网站设计能够对用户产生友好度,并且对于

- Transaction and redelivery in JMS (JMS的事务和失败消息重发机制)

darrenzhu

jms事务承认MQacknowledge

JMS Message Delivery Reliability and Acknowledgement Patterns

http://wso2.com/library/articles/2013/01/jms-message-delivery-reliability-acknowledgement-patterns/

Transaction and redelivery in

- Centos添加硬盘完全教程

dcj3sjt126com

linuxcentoshardware

Linux的硬盘识别:

sda 表示第1块SCSI硬盘

hda 表示第1块IDE硬盘

scd0 表示第1个USB光驱

一般使用“fdisk -l”命

- yii2 restful web服务路由

dcj3sjt126com

PHPyii2

路由

随着资源和控制器类准备,您可以使用URL如 http://localhost/index.php?r=user/create访问资源,类似于你可以用正常的Web应用程序做法。

在实践中,你通常要用美观的URL并采取有优势的HTTP动词。 例如,请求POST /users意味着访问user/create动作。 这可以很容易地通过配置urlManager应用程序组件来完成 如下所示

- MongoDB查询(4)——游标和分页[八]

eksliang

mongodbMongoDB游标MongoDB深分页

转载请出自出处:http://eksliang.iteye.com/blog/2177567 一、游标

数据库使用游标返回find的执行结果。客户端对游标的实现通常能够对最终结果进行有效控制,从shell中定义一个游标非常简单,就是将查询结果分配给一个变量(用var声明的变量就是局部变量),便创建了一个游标,如下所示:

> var

- Activity的四种启动模式和onNewIntent()

gundumw100

android

Android中Activity启动模式详解

在Android中每个界面都是一个Activity,切换界面操作其实是多个不同Activity之间的实例化操作。在Android中Activity的启动模式决定了Activity的启动运行方式。

Android总Activity的启动模式分为四种:

Activity启动模式设置:

<acti

- 攻城狮送女友的CSS3生日蛋糕

ini

htmlWebhtml5csscss3

在线预览:http://keleyi.com/keleyi/phtml/html5/29.htm

代码如下:

<!DOCTYPE html>

<html>

<head>

<meta charset="UTF-8">

<title>攻城狮送女友的CSS3生日蛋糕-柯乐义<

- 读源码学Servlet(1)GenericServlet 源码分析

jzinfo

tomcatWebservlet网络应用网络协议

Servlet API的核心就是javax.servlet.Servlet接口,所有的Servlet 类(抽象的或者自己写的)都必须实现这个接口。在Servlet接口中定义了5个方法,其中有3个方法是由Servlet 容器在Servlet的生命周期的不同阶段来调用的特定方法。

先看javax.servlet.servlet接口源码:

package

- JAVA进阶:VO(DTO)与PO(DAO)之间的转换

snoopy7713

javaVOHibernatepo

PO即 Persistence Object VO即 Value Object

VO和PO的主要区别在于: VO是独立的Java Object。 PO是由Hibernate纳入其实体容器(Entity Map)的对象,它代表了与数据库中某条记录对应的Hibernate实体,PO的变化在事务提交时将反应到实际数据库中。

实际上,这个VO被用作Data Transfer

- mongodb group by date 聚合查询日期 统计每天数据(信息量)

qiaolevip

每天进步一点点学习永无止境mongodb纵观千象

/* 1 */

{

"_id" : ObjectId("557ac1e2153c43c320393d9d"),

"msgType" : "text",

"sendTime" : ISODate("2015-06-12T11:26:26.000Z")

- java之18天 常用的类(一)

Luob.

MathDateSystemRuntimeRundom

System类

import java.util.Properties;

/**

* System:

* out:标准输出,默认是控制台

* in:标准输入,默认是键盘

*

* 描述系统的一些信息

* 获取系统的属性信息:Properties getProperties();

*

*

*

*/

public class Sy

- maven

wuai

maven

1、安装maven:解压缩、添加M2_HOME、添加环境变量path

2、创建maven_home文件夹,创建项目mvn_ch01,在其下面建立src、pom.xml,在src下面简历main、test、main下面建立java文件夹

3、编写类,在java文件夹下面依照类的包逐层创建文件夹,将此类放入最后一级文件夹

4、进入mvn_ch01

4.1、mvn compile ,执行后会在

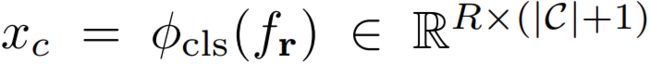

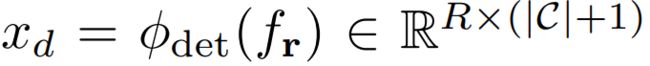

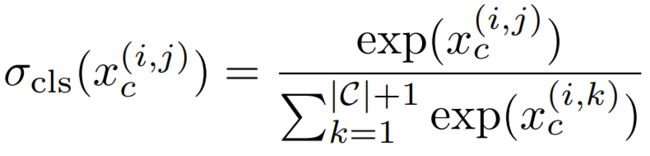

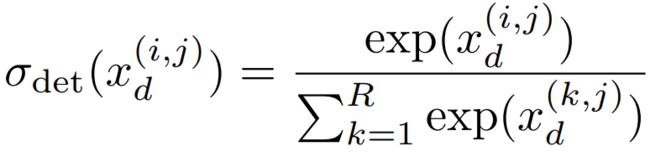

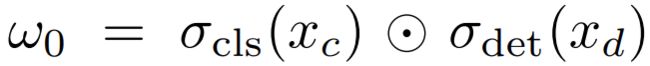

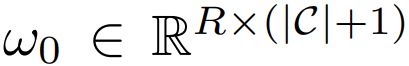

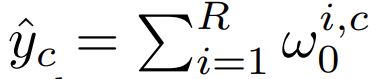

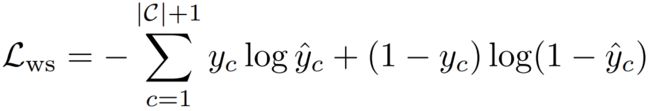

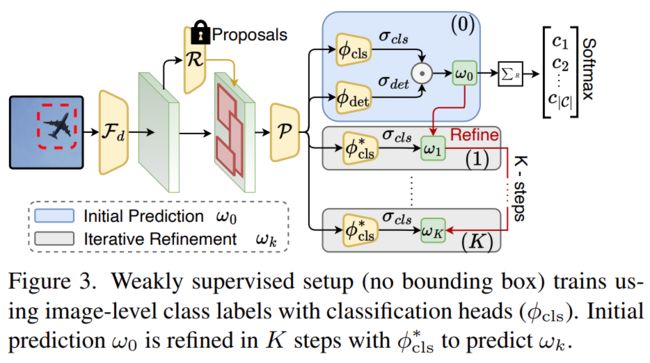

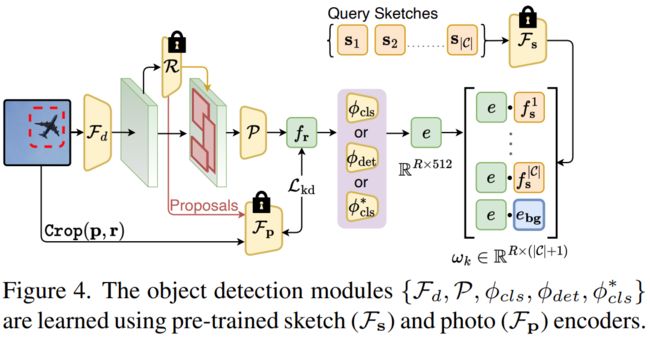

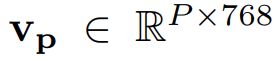

对每个ROI预测一个精细的类别分数,标签从第k-1步迭代获得:

对每个ROI预测一个精细的类别分数,标签从第k-1步迭代获得: ,

,