PyTorch学习笔记(8)--神经网络:非线性激活

PyTorch学习笔记(8)–神经网络:非线性激活

本博文是PyTorch的学习笔记,第8次内容记录,主要介绍神经网络非线性激活函数的基本使用。

目录

- PyTorch学习笔记(8)--神经网络:非线性激活

- 1.非线性激活

-

- 1.1什么是非线性激活

- 1.2常见的非线性激活函数

- 2.非线性激活

-

- 2.1非线性激活函数相关参数

- 2.2非线性激活函数应用实例1--ReLU处理矩阵

- 2.3非线性激活函数应用实例2--Sigmoid处理图片

- 3.学习小结

1.非线性激活

1.1什么是非线性激活

如果神经元的输出是输入的线性函数,而线性函数之间的嵌套任然会得到线性函数。如果不加非线性函数处理,那么最终得到的仍然是线性函数。所以需要在神经网络中引入非线性激活函数。

1.2常见的非线性激活函数

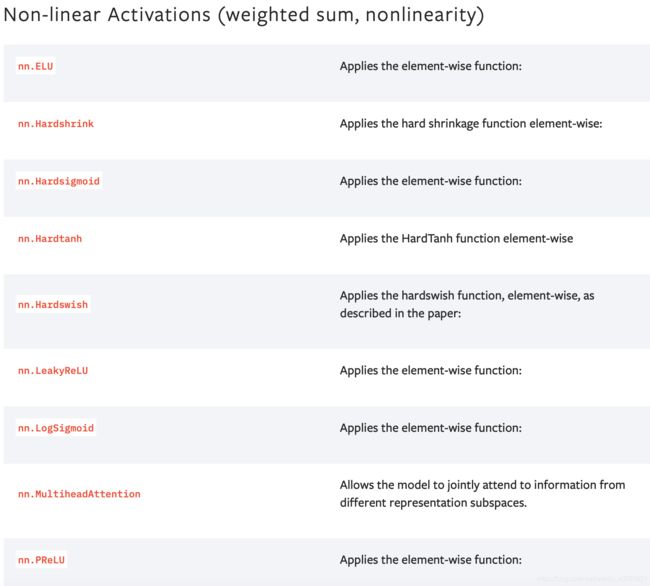

常见的非线性激活函数主要包括Sigmoid函数、tanh函数、ReLU函数、Leaky ReLU函数,这几种非线性激活函数的介绍在博客神经网络中重要的概念(超参数、激活函数、损失函数、学习率等)中有详细说明。在PyTorch官网中有关于非线性激活函数的说明,入下所示:

2.非线性激活

2.1非线性激活函数相关参数

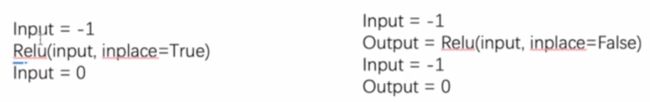

在PyTorch官网中,详细介绍了常见的非线性激活函数,以ReLU函数为例,有一个参数inplace,该参数作用在于是否将输入数据进行替换,inplace的取值是True或者False,当inplace=True时,将输入数据进行替换,当inplace=False时,输入数据不进行替换。如下图所示:

2.2非线性激活函数应用实例1–ReLU处理矩阵

现以ReLU函数处理矩阵内容为例,介绍非线性激活函数的使用方法。

ReLU函数的表达式如下所示: f ( x ) = { 0 x < = 0 x x > 0 f(x)=\left\{\begin{matrix} 0 & x<=0\\ x & x>0 \end{matrix}\right. f(x)={0xx<=0x>0。

用ReLU函数对矩阵执行非线性操作代码如下:

# coding :UTF-8

# 文件功能: 代码实现非线性激活功能

# 开发人员: dpp

# 开发时间: 2021/8/17 8:41 下午

# 文件名称: nn_ReLu.py

# 开发工具: PyCharm

import torch

from torch import nn

from torch.nn import ReLU

input = torch.tensor([[1, -0.5],

[-1, 3]])

input = torch.reshape(input, (-1, 1, 2, 2))

print(input.shape)

class Test(nn.Module):

def __init__(self):

super(Test, self).__init__()

self.relu1 = ReLU()

def forward(self, input):

output = self.relu1(input)

return output

test = Test()

output = test(input)

print(output)

上述代码中处理了2×2的矩阵,原始矩阵为:[[1, -0.5],[-1, 3]],得到的输出结果为:

torch.Size([1, 1, 2, 2])

tensor([[[[1., 0.],

[0., 3.]]]])

2.3非线性激活函数应用实例2–Sigmoid处理图片

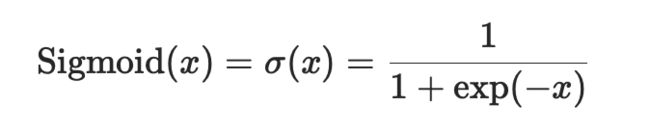

Sigmoid函数的表达式为:

以最大池化操作处理二维照片为例,数据集仍选择CIFAR10,代码如下:

# coding :UTF-8

# 文件功能: 代码实现非线性激活功能

# 开发人员: dpp

# 开发时间: 2021/8/17 8:41 下午

# 文件名称: nn_ReLu.py

# 开发工具: PyCharm

import torch

import torchvision

from torch import nn

from torch.nn import ReLU, Sigmoid

from torch.utils.data import DataLoader

from torch.utils.tensorboard import SummaryWriter

dataset = torchvision.datasets.CIFAR10("CIFAR10", train=False, download=True,

transform=torchvision.transforms.ToTensor())

dataloader = DataLoader(dataset, batch_size=64)

class Test(nn.Module):

def __init__(self):

super(Test, self).__init__()

self.sigmoid1 = Sigmoid()

def forward(self, input):

output = self.sigmoid1(input)

return output

test = Test()

writer = SummaryWriter("logs")

step = 0

for data in dataloader:

imgs, targets = data

writer.add_images("input", imgs, global_step=step)

output = test(imgs)

writer.add_images("output", output, step)

step = step + 1

writer.close()

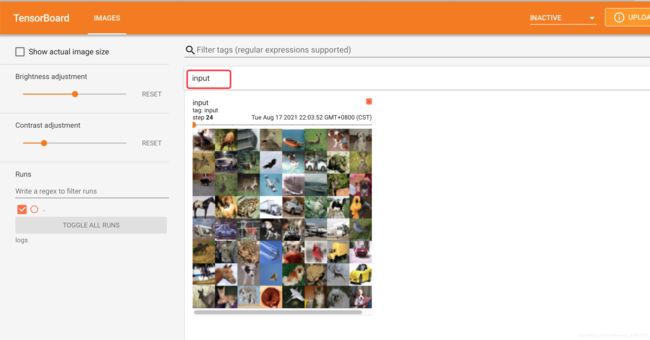

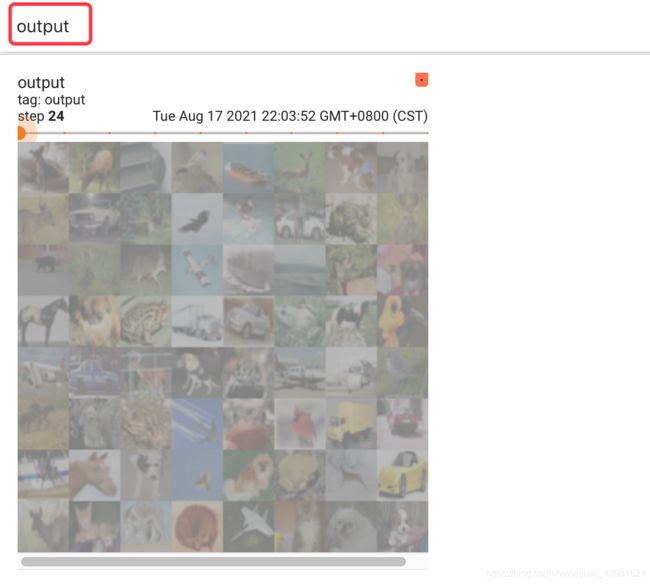

借助tensorboard观察输出结果如下:

通过对比非线性操作前后的图像,发现经过非线性激活函数处理之后的图像中的主要内容更突出了。

ReLU函数处理自然语言效果更佳,Sigmoid函数处理图像效果更佳。

3.学习小结

在本文中总结了神经网络的非线性激活函数的基本使用方法,并通过构建一个类Test分别介绍了ReLU()函数和Sigmoid()函数的使用方法,在下一篇博文,将开始介绍神经网络的线性层及其他层。