Hadoop伪分布式搭建Linux版 超详细(喂饭教程 强烈推荐)

Hadoop是大数据处理主流框架,如果要学习大数据处理与存储,hadoop是必须掌握的一种框架技术。动手安装是最基础的实践,下面介绍一下伪分布式和完全分布式安装与配置、测试过程,推荐hadoop2.7.7 .供有需要的参考。

目前已探索完成伪分布式搭建部署,完全分布式还未建立,后续更新.开始:

java jdk下载:https://www.oracle.com/java/technologies/javase-downloads.html

hadoop下载准备:

全网最低积分下载:传送门

历史下载版本:http://archive.apache.org/dist/hadoop/core/hadoop-2.7.7/

一. 修改主机名j建立映射

1.查看机器IP ifconfig

2. 查看主机名 vim /etc/hostname

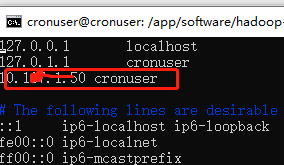

3. sudo vim /etc/hosts填写 ip hostname

二. 免登陆设置

生产密钥 ssh-keygen -t rsa

将密钥发送给需要登陆本机的机器,这里是本机 ssh-copy-id root@cronuser

测试ssh ssh root@cronuser

三. 搭建JAVA环境

1.JDK配置 这里选用JDK8 tar -zxvf jdk-8u144-linux-x64.tar.gz -C /home/java

2.配置环境变量

# 加入配置 加入位置如下图所示

export JAVA_HOME=/home/java/jdk1.8.0_144

export PATH=$PATH:$JAVA_HOME/bin

# 保存后刷新环境变量

[root@localhost jdk1.8.0_144]# source /etc/profile

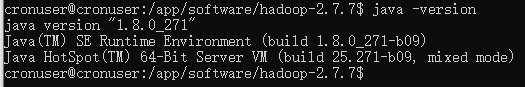

3.验证java 是否安装成功 java -version

四. HADOOP伪分布式配置

1.附上下载链接:hadoop历史版本下载

2.解压文件 tar -zxvf hadoop-2.7.7.tar.gz -C /app/software/

3.修改配置文件 cd /opt/install/hadoop-2.9.2/etc/hadoop

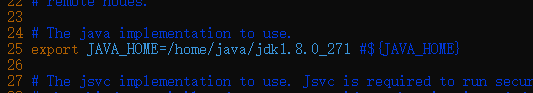

(1) vim hadoop-env.sh

export JAVA_HOME=/home/java/jdk1.8.0_144

注:hadoop中的四个核心模块对应四个默认配置文件,指定默认的文件系统为HDFS,文件系统的访问入口,namenode所在的机器9000端口是早期Hadoop 1.x使用的,现在Hadoop 2.x使用的是8020,端口号用于节点直接内部通信,使用RPC通信机制。

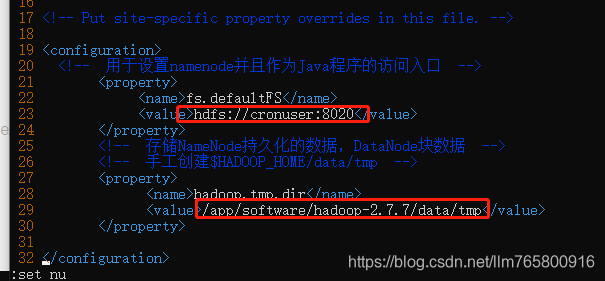

(2) vim core-site.xml

/tmp表示临时存储目录,系统每次重启会按照脚本预先设置好的删除里面的文件,重新自定义系统生成的文件路径,/tmp会被清空,无法保证数据文件安全性。

<property>

<name>fs.defaultFSname>

<value>hdfs://cronuser:8020value>

property>

<property>

<name>hadoop.tmp.dirname>

<value>/app/software/hadoop-2.7.7/data/tmpvalue>

property>

(3) vim hdfs-site.xmll指定HDFS文件存储的副本数个数,默认是3个,这个数字要小于datanode的节点数

<property>

<name>dfs.replicationname>

<value>3value>

property>

<property>

<name>dfs.permissions.enabledname>

<value>falsevalue>

property>

<property>

<name>dfs.namenode.http.addressname>

<value>cronuser:50070value>

property>

(4)

cp mapred-site.xml.template mapred-site.xml

vim mapred-site.xml

<property>

<name>mapreduce.framework.namename>

<value>yarnvalue>

property>

(5) vim yarn-site.xml

<property>

<name>yarn.nodemanager.aux-servicesname>

<value>mapreduce_shufflevalue>

property>

(6)vim slaves

cronuser

五.配置HADOOP 环境变量

1.配置环境变量

[root@localhost hadoop-2.7.7]# vim /etc/profile

# 加入

export HADOOP_HOME=/app/software/hadoop-2.7.7

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

2.激活环境变量

# 刷新环境变量

[root@localhost hadoop-2.7.7]# source /etc/profile

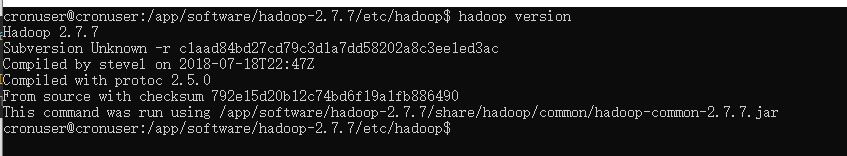

3.验证

[root@localhost hadoop-2.9.2]# hadoop version

六.格式化NameNode

目的作用:格式化hdfs系统,并且生成存储数据块的目录

[root@localhost hadoop-2.7.7]# hadoop namenode -format

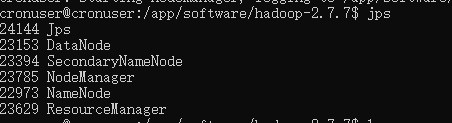

启动所有进程 start-all.sh

终止所有进程 stop-all.sh

2.查看进程 jps

3.查看WebUI界面

http://10.168.1.50:50070 访问 hdfs

http://10.168.1.50:8088 访问 yarn