PyTorch深度学习入门笔记(十二)神经网络-非线性激活

课程学习笔记,课程链接

学习笔记同步发布在我的个人网站上,欢迎来访查看。

文章目录

- 一、非线性激活常用函数介绍

-

- 1.1 ReLU

- 1.2 Sigmoid

一、非线性激活常用函数介绍

非线性激活的目的是为了给我们的神经网络引入一些非线性的特质。

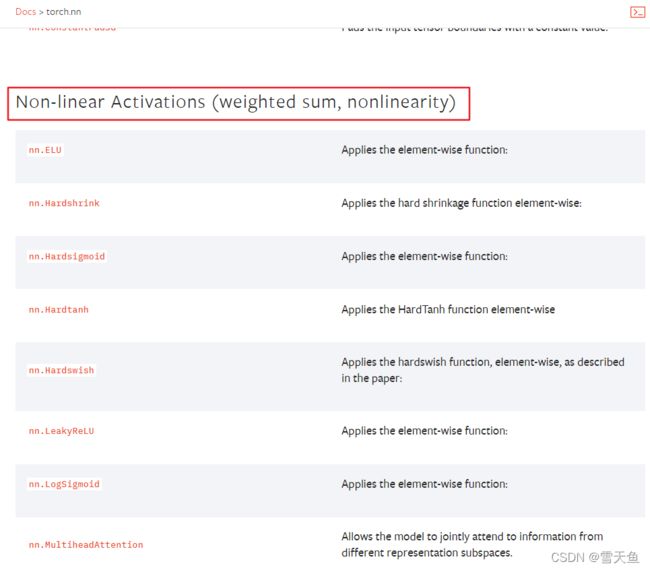

依然是打开官方文档:

比较常用的函数是 nn.ReLu:

1.1 ReLU

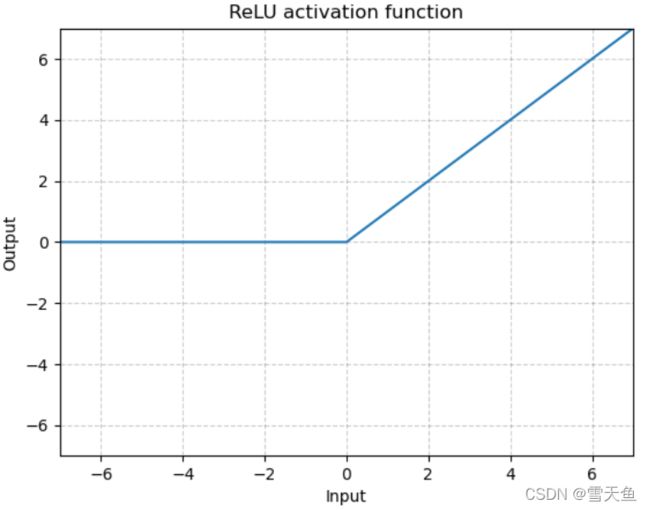

对应的函数图是:

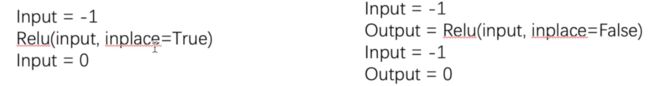

参数:inplace=True时,会修改 input 为非线性激活后的结果;inplace=False时,则不会修改 input ,input仍然为原值。

示例代码:

import torch

from torch import nn

from torch.nn import ReLU

input = torch.tensor([[1, -0.5],

[-1, 3]])

output = torch.reshape(input, (-1, 1, 2, 2))

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.relu1 = ReLU()

def forward(self, input):

output = self.relu1(input)

return output

net1 = Net()

output = net1(input)

print(output)

输出:

可以看到输入为 输出为

[[1, -0.5], [[1, 0],

[-1, 3]], [0, 3]]

输入传给了 ReLU函数,进行了截断,-0.5和-1均小于0,所以对应的输出结果为0。

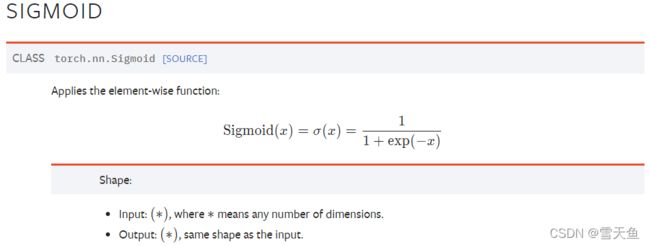

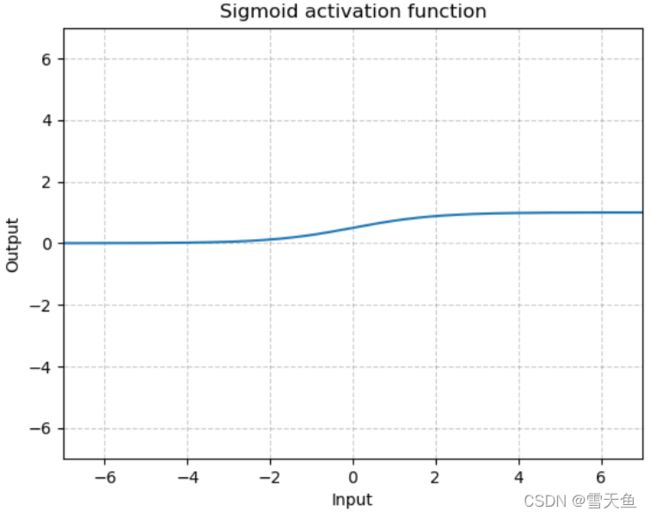

1.2 Sigmoid

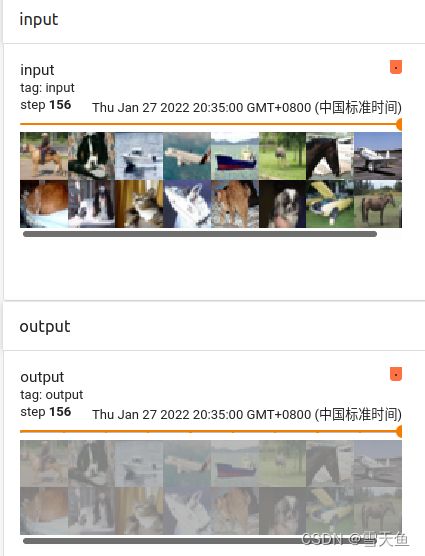

import torch

import torchvision

from torch import nn

from torch.nn import ReLU, Sigmoid

from torch.utils.data import DataLoader

from torch.utils.tensorboard import SummaryWriter

dataset = torchvision.datasets.CIFAR10("./dataset", train=False, download=True,

transform=torchvision.transforms.ToTensor())

dataloader = DataLoader(dataset, batch_size=64)

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.Sigm = Sigmoid()

def forward(self, input):

output = self.Sigm(input)

return output

net1 = Net()

writer = SummaryWriter("logs")

step = 0

for data in dataloader:

imgs, targets = data

writer.add_images("input", imgs, global_step=step)

output = net1(imgs)

writer.add_images("output", output, step)

step += 1

writer.close()

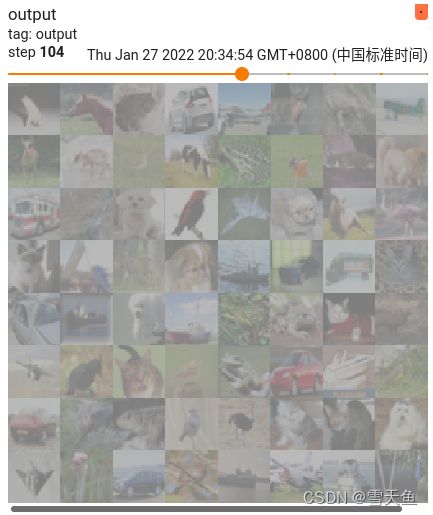

可以看到非线性激活主要目的就是给网络增加非线性特征,以便训练出符合要求的泛化模型。