基于jetson nano和yolov5 的车行人检测(二)

接着上篇~~

3:准备使用tensorrt加速模型,onnx-tensortrt

将yolov5生成 pt文件先转成onnx文件,这个直接使用 yolov5源码里的 model/export.py转就成不难。

下面使用jetson nano搭建 onnx-tensorrt踩坑记录。

原本是想用ubuntu直接转成trt到时候再直接调用...

但ubuntu的环境搭建也挺麻烦的,不如直接就在jetson nano上转了。

jetson nano jetpack4.4 自带 tensorrt7.1 opencv4.1 cuda10.2 cudnn7.5 。

自己做是不可能的...参考文章如下:

jetson nano onnx-tensorrt 7.1,链接:https://blog.csdn.net/walletiger/article/details/109783232

TensorRT7 + Onnx_TensorRT 安装过程记录,链接:https://blog.csdn.net/weixin_44638957/article/details/103704661

出错记录:

(1) CMAKE error project files invalid ; does not contain cmakelists.txt

(2)jetson nano cmake版本过低

(3)Makefile:94:recipr for target 'install-***failed'

cmake更新没啥好说的。

protobuf安装 不必要非要安装3.8的,可以更高。安装时 将 make install 改成sudo make install 就可以避免(3)问题。 至于

apt remove libprotobuf-dev

pip3 uninstall protobuf

pip install protobuf==3.8.0

没用上。

比较坑的就是onnx-tensorrt的安装:

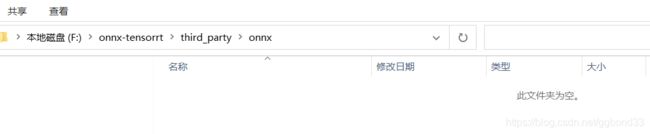

下载下来的onnx-tensorrt文件包内onnx是空的,但是github上的源文件有,需要跳转....,单独将onnx文件下载到指定文件夹就好了

然后还有一个就是比较难受的问题是官网 要的哪个path_to_trt文件夹是哪个。

jetson nano 的位置是这样:cmake -DTENSORRT_ROOT=/usr/src/tensorrt

还有各种编译的时候 都是使用make -1j 怕出问题用 make -4j啥的可能会出问题。

其实还有好多坑....但做完回头一看好像也就这样。不做记录

最后成功转成trt文件。

接下来的工作 是用tensorrt加速模型运行和调用摄像头。

过段时间再做。就这样~