Possibly insufficient driver version: 410.48.0

NVIDIA driver版本是410.48的,说这个原因是为啥子?接上一篇

github issue在此:https://github.com/tensorflow/tensorflow/issues/34214

我搜索了这个问题,发现很少。NVIDIA官网给出的匹配兼容性

我的如下:

nvcc: NVIDIA (R) Cuda compiler driver

Copyright (c) 2005-2018 NVIDIA Corporation

Built on Sat_Aug_25_21:08:01_CDT_2018

Cuda compilation tools, release 10.0, V10.0.130

完全是兼容的,这就见鬼了。卧槽。

群里大佬说是cudnn的问题,这个版本咋获取啊?有没有快捷命令,which和find都找不到啊。

我也安装了cudnn了,怎么安装的?不知道对不对,也没个验证的方法和步骤,这不是扯淡吗?

dpkg -i libcudnn7_7.6.5.32-1+cuda10.0_amd64.deb人生艰难啊!

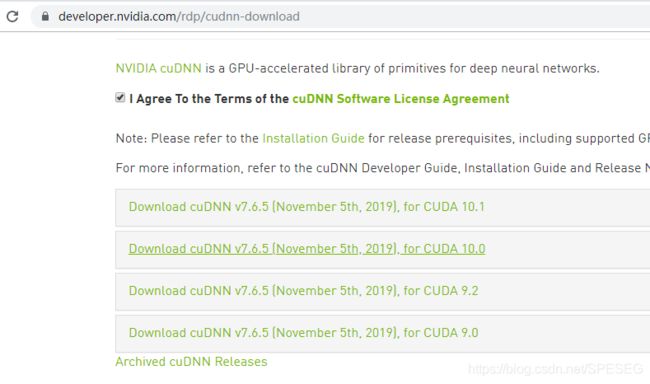

附录:下载cudnn官网地址:https://developer.nvidia.com/rdp/cudnn-download

要先注册才可以似乎。

按照这个博文的做法,测试下安装是否成功。

首先设置export,具体看自己的路径,别照抄。

export PATH=/usr/local/cuda-10.0/bin:/usr/local/cuda-10.0/NsightCompute-1.0${PATH:+:${PATH}}

export LD_LIBRARY_PATH=/usr/local/cuda-10.0/lib64${LD_LIBRARY_PATH:+:${LD_LIBRARY_PATH}}然后

cd /usr/local/cuda-10.0/samples/1_Utilities/deviceQuery

sudo make说到这我就来气,作为阿里对面资深搬砖工,本大佬连sudo权限都没有。。。。。。。。。服了

我复制到其他有权限的目录下make,务必复制samples/1_Utilities/deviceQuery 中的samples文件。大文件。

Compute Mode:

< Default (multiple host threads can use ::cudaSetDevice() with device simultaneously) >

> Peer access from Tesla V100-PCIE-16GB (GPU0) -> GeForce RTX 2080 Ti (GPU1) : No

> Peer access from Tesla V100-PCIE-16GB (GPU0) -> GeForce RTX 2080 Ti (GPU2) : No

> Peer access from GeForce RTX 2080 Ti (GPU1) -> Tesla V100-PCIE-16GB (GPU0) : No

> Peer access from GeForce RTX 2080 Ti (GPU1) -> GeForce RTX 2080 Ti (GPU2) : Yes

> Peer access from GeForce RTX 2080 Ti (GPU2) -> Tesla V100-PCIE-16GB (GPU0) : No

> Peer access from GeForce RTX 2080 Ti (GPU2) -> GeForce RTX 2080 Ti (GPU1) : Yes

deviceQuery, CUDA Driver = CUDART, CUDA Driver Version = 10.0, CUDA Runtime Version = 10.0, NumDevs = 3

Result = PASS

但是实际我跑代码还是不行。卧槽。

采用另外的方法,将deb文件解压,将其文件cp到相应的cuda-10.0下面。作为资深搬砖工,我竟然没有权限。。。。!!!!!

卧槽,没法玩。那句话说得好:

工欲善其事必先利其器GPU都没有,为啥没有?不好装,为啥不好装?没权限,给你权限能不能搞定??这。。不一定。但我想试试。

你这个月啥都没做出来?就玩这个GPU了???

我。。。。。。。。。。。。。。。。。。。

群里大佬给我提了个方法,tf官网的,如下:

gpus = tf.config.experimental.list_physical_devices('GPU')

if gpus:

try:

for gpu in gpus:

tf.config.experimental.set_memory_growth(gpu, True)

logical_gpus = tf.config.experimental.list_logical_devices('GPU')

print(len(gpus), "Physical GPUs,", len(logical_gpus), "Logical GPUs")

except RuntimeError as e:

print(e)很遗憾,仍不能解决问题。从代码上看,这个只是查看有多少GPU,但能不能用未知啊。

在此感谢所有给予帮助的热心大佬。

另外有相关问题可以加入QQ群讨论,不设微信群

QQ群:868373192

语音深度学习群